リソース

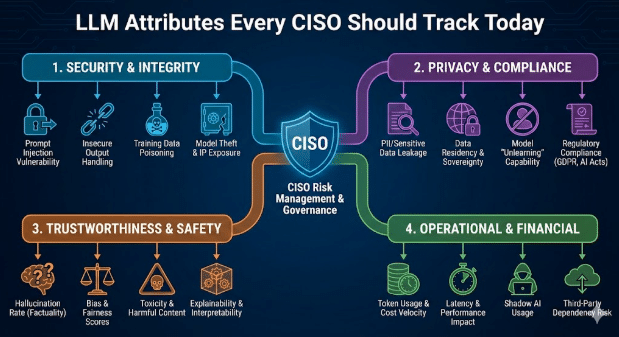

CISOが今日追跡すべきLLM属性

By Sarang Warudkar - Sr. Technical PMM (CASB & AI)

2026年2月18日 5 分読み

AIツールは現在、文書作成、分析、会議自動化、ソフトウェア開発など、日常業務のあらゆる分野に影響を与えている。この急速な普及は生産性の大幅な向上をもたらす一方で、大規模言語モデル(LLM)の挙動によって新たなセキュリティリスクをもたらす。従来のSaaSチェックではもはや不十分である。CISOは今や、アプリケーションとそれを支えるモデルを同等の注意を払って評価している。

このブログでは、企業のリスクを形作るLLMの特性を概説し、セキュリティリーダーがそれらを管理するために活用できる実践的な手順を提示します。

LLMの属性が重要な理由

ほとんどのAI SaaS製品はサードパーティのLLMを組み込んでいます。これにより二重の依存関係が生じます。アプリ自体があらゆるセキュリティチェックを通過しても、基盤となるモデルがデータを晒したり、安全でないコードを生成したり、機密ワークフローを漏洩させたりする可能性があります。LLMレイヤーを明確に把握することでこのギャップを埋め、AIガバナンスを現代の脅威に対応させることが可能になります。

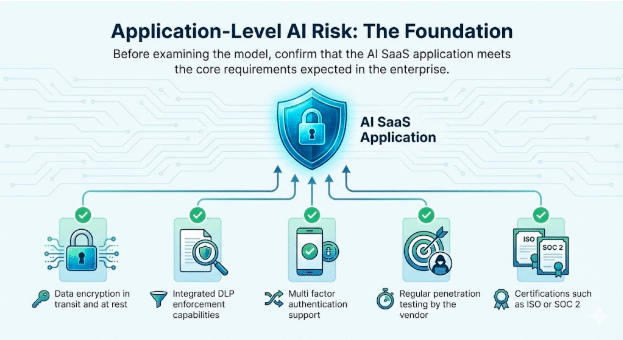

1. アプリケーションレベルAIリスク:基盤

モデルを検証する前に、AI SaaSアプリケーションが企業で期待される中核要件を満たしていることを確認してください。

検証対象のベースライン属性

- 転送中および保存時のデータ暗号化

- 統合DLP施行機能

- 多要素認証のサポート

- ベンダーによる定期的なペネトレーションテスト

- ISOやSOC 2などの認証

これらの検証は依然として不可欠である。それらはサービス自体への信頼を確立し、安全なAI導入の基盤を築く。

2. LLMの挙動:新たなリスク領域の源泉

LLMの属性は、アプリケーションが実際のユーザーや敵対的プロンプトにどのように応答するかに直接影響します。CISOは現在、すべての組み込みモデルにおいて以下の挙動を追跡しています。

ジェネレーティブAIと大規模言語モデルの統合

正確なモデル、ホスティング地域、更新パターンを特定し、ベンダーが顧客データを用いて微調整しているかどうかを確認する。

脱獄の暴露

脱獄行為は、ユーザーがプロンプトを操作してLLMの安全制御を回避する際に発生します。一般的な手法には、ロールプレイ、多層的な指示、架空の設定、間接的または暗号化された言語が含まれます。これらのやり取りは通常の使用に似ているため、基本的な制御を回避することがよくあります。脱獄の試みを追跡することで、セキュリティチームは悪用を早期に検知し、ガードレールを強化し、監査時に積極的なガバナンスを実証できます。

例

- 攻撃者はチャットボットを騙し、顧客アカウントの多要素認証(MFA)を無効化する方法を説明させる。これにより機密データへの直接的な経路が開かれ、正当に見えるワークフロー内でアイデンティティガバナンスが破られる。

マルウェアおよび有害コード生成

大規模言語モデル(LLM)は、隠された実行パスや情報漏洩ルーチンを埋め込んだコードを生成することがある。

例

- エンジニアがAIが提案したコードを内部サービスに貼り付ける。そのコードには隠されたデータ漏洩が含まれている。このコードのロジックは一見有効に見えるため、検出されない侵害を引き起こす。

毒性、バイアス及びCBRN出力リスク

モデルは、機密性のあるプロンプトや敵対的プロンプトを与えられた場合、安全でないテキストを生成する可能性があります。 安全、コンプライアンス、または物理的リスクが対象範囲となる事業部門において、これらの挙動を追跡してください。

例

- 有害性:内部サポートチャットボットが敵意あるプロンプトを与えられた後、エスカレートした顧客クレームに対して暴言や脅迫的な言葉で応答し、その記録が保存または共有された際に人事リスクやブランドリスクを生じさせる。

- バイアス:採用チームがLLMを用いて候補者をランク付けしたところ、性別やカーストを示す指標を含むプロフィールが一貫して評価を下げられ、組織が差別や監査指摘のリスクに晒される事態が発生した。

- CBRN出力リスク:研究開発ユーザーが化学プロセスの改善についてLLMに質問すると、モデルは段階的なガイダンスを返却し、これが規制対象の化学合成と一致することで、規制上のリスクと物理的安全性の曝露を生じさせる。

NISTおよびOWASP LLMガイダンスとの整合性

NISTは生成AIプロファイルを公開し、これは責任あるAIリスク管理の基準として急速に定着しつつある。セキュリティおよびコンプライアンスチームは現在、すべてのLLMベースのアプリケーションがこれらの要件に明確に対応することを求めている。

企業は直接的な質問をしている

- AIの使用方法とその結果について、誰が責任を負うのか

- どのLLMユースケースが明示的に許可または禁止されているか

- トレーニングおよび微調整データが透明性をもって宣言されているかどうか

- 即時注入、幻覚、不正なデータアクセスといったリスクがどのように扱われるか

これらの疑問に明確な答えがない場合、監査リスクは急激に高まります。医療や金融サービスなどの規制対象分野では、NISTガイダンスとの不整合がデータ漏洩、規制上の罰則、監査不合格の可能性を高めます。

並行して、OWASP Top 10 for LLM Applicationsは、従来のアプリケーションセキュリティ上の懸念を超えた新たな種類の脆弱性を文書化している。これにはプロンプト注入、不適切な出力処理、トレーニングデータへの不正操作、安全でない統合などが含まれる。

実際の事例は既にこうしたリスクを反映している。あるケースでは、SaaSアプリケーションがユーザーにAI処理用の文書アップロードを許可していた。攻撃者がファイル内に隠された指示を埋め込み、モデルがそれを実行した結果、企業の機密データが漏洩した。こうしたシナリオは稼働中の本番環境で発生しており、積極的に追跡・軽減策を講じない組織は重大なセキュリティリスクに直面する。

例

- 出力検証のないモデルは、プロンプトインジェクションの試行中に管理者キーを漏洩する。 これにより、アプリレベルでの強力な制御にもかかわらず、システム全体が侵害される。

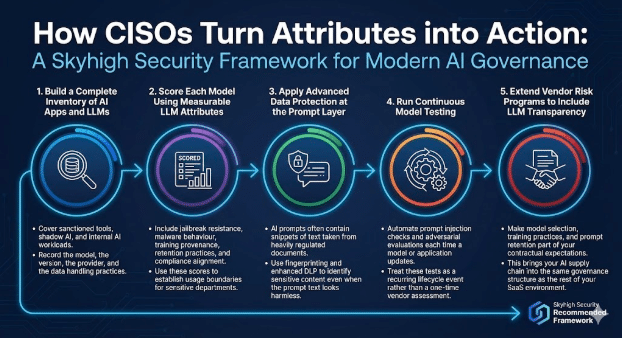

CISOがこれらの特性をどのように行動に移すか

現代的なAIガバナンスプログラムは、アプリケーションチェックとモデルを意識した制御を融合させます。

Skyhigh Security 次のフレームワークをSkyhigh Security 。

1. AIアプリと大規模言語モデル(LLM)の完全なインベントリを構築する

認可されたツール、シャドーAI、および内部AIワークロードをカバーする。

モデル、バージョン、プロバイダー、およびデータ処理慣行を記録する。

2. 測定可能なLLM属性を用いて各モデルを評価する

脱獄対策、マルウェアの挙動、トレーニングの由来、保持慣行、コンプライアンスへの整合性を含める。 これらのスコアを用いて、機密部門の使用制限を設定する。

3. プロンプト層での高度なデータ保護の適用

AIプロンプトには、厳格に規制された文書から引用されたテキストの断片が含まれることがよくあります。 指紋認証と強化されたDLPを活用し、プロンプトテキストが無害に見える場合でも機密コンテンツを特定します。

4. 継続的モデルテストの実行

モデルやアプリケーションの更新時には毎回、プロンプト注入チェックと敵対的評価を自動化してください。 これらのテストを、単発のベンダー評価ではなく、ライフサイクルにおける定期的なイベントとして扱う。

5. ベンダーリスク管理プログラムを拡張し、LLMの透明性を含める

モデル選択、トレーニング手法、プロンプト保持を契約上の要件に組み込むこと。 これにより、AIサプライチェーンをSaaS環境全体のガバナンス構造に統合できます。

前途

大規模言語モデル(LLM)は、企業がAIを活用する方法を再構築し、最高情報セキュリティ責任者(CISO)がリスクを評価する方法も再構築する。

従来のアプリケーションガバナンスでは、セキュリティチームは二つの課題を分離して扱います。アプリケーションは、アクセス制御、データ保護、ログ記録、コンプライアンスに関する企業基準を満たさなければなりません。これとは独立して、基盤となるプラットフォームは信頼性、セキュリティ、運用上の期待値を満たす必要があります。

LLMは同じ二層の責任構造を導入するが、より高いリスクを伴う。

- アプリケーション層において、組織はAI機能がユーザーにどのように公開されるかを管理しなければならない。これには、機能へのアクセス権限、送信可能なデータの種類、出力の共有方法、監査および調査のための活動ログの記録方法などが含まれる。これらの制御は、AI駆動型ワークフローに拡張された、よく知られたアプリケーションセキュリティの実践手法を反映している。

- モデル層において、CISOはLLMが実環境下でどのように振る舞うかを評価しなければならない。これには、モデルが機密性の高いプロンプトをどのように処理するか、安全でない出力や偏った出力を生成しないか、データを保持または再利用する方法、プロンプト注入やデータポイズニングといった悪用に対する耐性などが含まれる。これらの挙動は従来のアプリケーションテストの範囲外であり、明示的なガバナンスが必要である。

データ使用量、安全動作、ガードレールの適用範囲、障害パターンといったLLMの属性を追跡することで、セキュリティ責任者は成熟したアプリケーションプログラムから期待するのと同じ確信を得られます。この可視性により、CISOは企業全体でセキュリティ、プライバシー、規制遵守の約束を維持しつつ、より広範なAI導入を支援できます。

著者について

サラン・ワルドカール

シニア・テクニカルプロダクトマーケティングマネージャー

Sarang Warudkarは、サイバーセキュリティ分野で10年以上の経験を持つベテランのプロダクトマーケティングマネージャーで、技術革新と市場ニーズの整合に長けています。CASB、DLP、AIによる脅威検知などのソリューションに深い専門知識を持ち、インパクトのある市場参入戦略と顧客エンゲージメントを推進している。IIMバンガロールでMBA、プネ大学で工学の学位を取得し、技術的・戦略的な見識を兼ね備えている。