Risorse

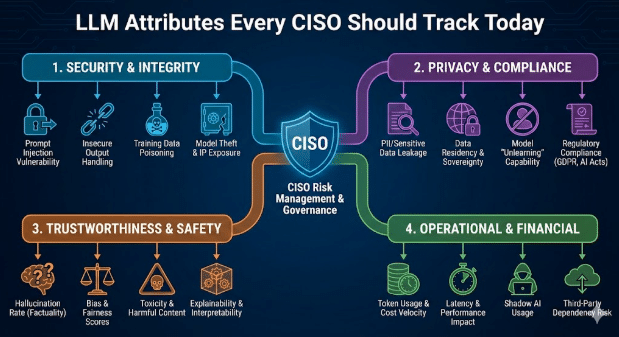

Attributi LLM che ogni CISO dovrebbe monitorare oggi

Di Sarang Warudkar - Sr. Technical PMM (CASB & AI)

18 febbraio 2026 5 Minuti di lettura

Gli strumenti di intelligenza artificiale influenzano ormai il lavoro quotidiano in ambiti quali la scrittura, l'analisi, l'automazione delle riunioni e lo sviluppo di software. La loro rapida adozione comporta notevoli aumenti di produttività, ma introduce anche una nuova superficie di sicurezza determinata dal comportamento dei modelli linguistici di grandi dimensioni (LLM). I tradizionali controlli SaaS non sono più sufficienti. I CISO valutano ora con la stessa attenzione sia l'applicazione che il modello su cui si basa.

Questo blog descrive le caratteristiche dell'LLM che influenzano il rischio aziendale e le misure pratiche che i responsabili della sicurezza possono adottare per gestirlo.

Perché gli attributi LLM sono importanti

La maggior parte dei prodotti SaaS di IA integra LLM di terze parti. Ciò crea una doppia dipendenza. L'applicazione può superare tutti i controlli di sicurezza, ma il modello sottostante può comunque esporre i dati, produrre codice non sicuro o divulgare flussi di lavoro sensibili. Una visione chiara del livello LLM colma questa lacuna e allinea la governance dell'IA alle minacce moderne.

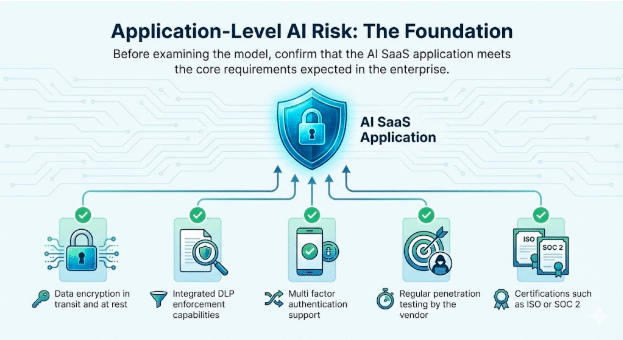

1. Rischio AI a livello di applicazione: le basi

Prima di esaminare il modello, è opportuno verificare che l'applicazione AI SaaS soddisfi i requisiti fondamentali previsti dall'azienda.

Attributi di base da verificare

- Crittografia dei dati in transito e inattivi

- Funzionalità integrate di applicazione DLP

- Supporto dell'autenticazione multifattoriale

- Test di penetrazione regolari da parte del fornitore

- Certificazioni quali ISO o SOC 2

Questi controlli rimangono essenziali. Essi instaurano fiducia nel servizio stesso e creano le basi per un'implementazione sicura dell'IA.

2. Comportamento LLM: la fonte della nuova superficie di rischio

Gli attributi LLM influenzano direttamente il modo in cui l'applicazione risponde agli utenti reali e ai prompt avversari. I CISO ora monitorano i seguenti comportamenti in ogni modello incorporato.

Integrazione tra GenAI e LLM

Identificare il modello esatto, la regione di hosting, il modello di aggiornamento e se il fornitore lo ottimizza utilizzando i dati dei clienti.

Esposizione al jailbreak

I jailbreak si verificano quando gli utenti manipolano i prompt per aggirare i controlli di sicurezza LLM. Le tecniche più comuni includono il role playing, le istruzioni stratificate, la creazione di contesti fittizi e l'uso di un linguaggio indiretto o codificato. Poiché queste interazioni assomigliano all'uso normale, spesso eludono i controlli di base. Monitorare i tentativi di jailbreak aiuta i team di sicurezza a individuare tempestivamente gli abusi, rafforzare le misure di protezione e dimostrare una governance proattiva durante gli audit.

Esempio

- Un malintenzionato convince un chatbot a spiegare come disabilitare l'autenticazione a più fattori (MFA) su un account cliente. Ciò consente di accedere direttamente a dati sensibili e compromette la governance delle identità all'interno di un flusso di lavoro che appare legittimo.

Generazione di malware e codice dannoso

Gli LLM talvolta generano codice che incorpora percorsi di esecuzione nascosti o routine di exfiltrazione.

Esempio

- Un ingegnere inserisce il codice suggerito dall'intelligenza artificiale in un servizio interno. Il codice contiene una fuga di dati nascosta. Ciò provoca una violazione non rilevata perché la logica appare valida.

Tossicità, pregiudizi e rischi derivanti dall'output CBRN

I modelli possono generare testi non sicuri quando vengono presentati con prompt sensibili o controversi. Si raccomanda di monitorare tali comportamenti per le unità aziendali in cui la sicurezza, la conformità o il rischio fisico sono rilevanti.

Esempi

- Tossicità: un chatbot di supporto interno risponde a un reclamo escalato da parte di un cliente con un linguaggio offensivo o minaccioso dopo aver ricevuto prompt ostili, creando rischi per le risorse umane e il marchio quando la trascrizione viene registrata o condivisa.

- Pregiudizio: un team di selezione utilizza un modello LLM per classificare i candidati, e il modello declassa sistematicamente i profili che contengono indicatori di genere o casta, esponendo l'organizzazione a discriminazioni e risultati di audit.

- Rischi CBRN: un utente R&S consulta un LLM in merito al miglioramento di un processo chimico e il modello fornisce indicazioni dettagliate che sono in linea con la sintesi chimica soggetta a restrizioni, creando un'esposizione normativa e fisica.

Allineamento con le linee guida NIST e OWASP LLM

Il NIST ha pubblicato un profilo generativo dell'IA che sta rapidamente diventando il punto di riferimento per una gestione responsabile dei rischi legati all'IA. I team addetti alla sicurezza e alla conformità si aspettano ora che ogni applicazione basata su LLM rispecchi chiaramente queste aspettative.

Le imprese stanno ponendo domande dirette.

- Chi è responsabile dell'utilizzo dell'IA e dei suoi risultati?

- Quali casi d'uso dell'LLM sono esplicitamente consentiti o vietati?

- Se i dati di addestramento e messa a punto sono dichiarati in modo trasparente

- Come vengono gestiti rischi quali iniezioni immediate, allucinazioni e accesso non autorizzato ai dati

Quando queste domande non trovano risposte chiare, il rischio di audit aumenta notevolmente. In settori regolamentati come quello sanitario e dei servizi finanziari, il mancato allineamento alle linee guida NIST aumenta la probabilità di fughe di dati, sanzioni normative e audit falliti.

Parallelamente, la classifica OWASP Top 10 per le applicazioni LLM documenta una nuova classe di vulnerabilità che va oltre le tradizionali preoccupazioni relative alla sicurezza delle applicazioni. Queste includono l'iniezione di prompt, la gestione non sicura dell'output, l'avvelenamento dei dati di addestramento e le integrazioni non sicure.

Incidenti reali riflettono già questi rischi. In un caso, un'applicazione SaaS consentiva agli utenti di caricare documenti per l'elaborazione tramite IA. Un malintenzionato ha incorporato istruzioni nascoste all'interno di un file, il modello le ha eseguite e i dati sensibili dell'azienda sono stati esposti. Questi scenari si verificano in ambienti di produzione reali e le organizzazioni che non li monitorano e mitigano attivamente corrono rischi significativi per la sicurezza.

Esempio

- Un modello privo di convalida dell'output può causare la divulgazione delle chiavi amministrative durante un tentativo di prompt injection. Ciò compromette l'intero sistema nonostante i rigorosi controlli a livello di applicazione.

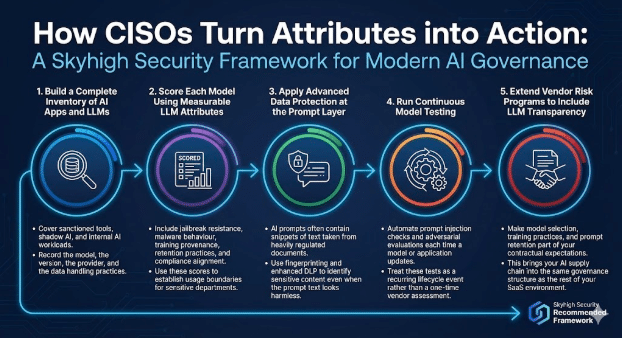

Come i CISO trasformano queste caratteristiche in azioni concrete

Un programma moderno di governance dell'IA integra controlli delle applicazioni con controlli basati sui modelli.

Skyhigh Security il seguente framework.

1. Creare un inventario completo delle applicazioni di intelligenza artificiale e dei modelli di linguaggio di grande dimensione (LLM)

Coprire gli strumenti autorizzati, l'intelligenza artificiale ombra e i carichi di lavoro interni dell'intelligenza artificiale.

Registrare il modello, la versione, il fornitore e le pratiche di trattamento dei dati.

2. Valutare ciascun modello utilizzando attributi LLM misurabili

Includere la resistenza al jailbreak, il comportamento dei malware, la provenienza della formazione, le pratiche di conservazione e l'allineamento alla conformità. Utilizzare questi punteggi per stabilire i limiti di utilizzo per i reparti sensibili.

3. Applicare la protezione avanzata dei dati a livello di prompt

I suggerimenti dell'intelligenza artificiale spesso contengono frammenti di testo tratti da documenti soggetti a rigide normative. Utilizzate il fingerprinting e il DLP avanzato per identificare i contenuti sensibili anche quando il testo del suggerimento sembra innocuo.

4. Eseguire test continui sul modello

Automatizzare i controlli di prompt injection e le valutazioni avversarie ogni volta che un modello o un'applicazione viene aggiornato. Considerare questi test come un evento ricorrente del ciclo di vita piuttosto che come una valutazione una tantum del fornitore.

5. Estendere i programmi di gestione dei rischi dei fornitori per includere la trasparenza LLM

Inserisca la selezione del modello, le pratiche di formazione e la conservazione tempestiva delle informazioni tra le sue aspettative contrattuali. In questo modo, la vostra catena di fornitura AI rientrerà nella stessa struttura di governance del resto del vostro ambiente SaaS.

Il cammino da percorrere

Gli LLM stanno ridefinendo il modo in cui le aziende utilizzano l'intelligenza artificiale e stanno ridefinendo il modo in cui i CISO valutano il rischio.

Nella governance tradizionale delle applicazioni, i team di sicurezza separano due aspetti. L'applicazione deve soddisfare gli standard aziendali in materia di controllo degli accessi, protezione dei dati, registrazione e conformità. Indipendentemente da ciò, la piattaforma sottostante deve soddisfare le aspettative in termini di affidabilità, sicurezza e operatività.

Gli LLM introducono la stessa responsabilità a due livelli, con una posta in gioco più elevata.

- A livello di applicazione, le organizzazioni devono regolare il modo in cui le funzionalità dell'IA vengono presentate agli utenti. Ciò include chi può accedere alla funzionalità, quali dati possono essere inviati, come vengono condivisi i risultati e come vengono registrate le attività per scopi di audit e indagine. Questi controlli rispecchiano le consuete pratiche di sicurezza delle applicazioni, estese ai flussi di lavoro basati sull'IA.

- A livello di modello, i CISO devono valutare il comportamento dell'LLM in condizioni reali. Ciò include il modo in cui il modello gestisce i prompt sensibili, se produce output non sicuri o distorti, come conserva o riutilizza i dati e quanto è resiliente agli abusi come l'iniezione di prompt o il data poisoning. Questi comportamenti esulano dai tradizionali test delle applicazioni e richiedono una governance esplicita.

Il monitoraggio degli attributi LLM, quali l'utilizzo dei dati, il comportamento in materia di sicurezza, la copertura delle misure di protezione e i modelli di errore, offre ai responsabili della sicurezza la stessa fiducia che si aspettano dai programmi applicativi maturi. Grazie a questa visibilità, i CISO possono supportare una più ampia adozione dell'IA, mantenendo al contempo la sicurezza, la privacy e gli impegni normativi in tutta l'azienda.

Sull'autore

Sarang Warudkar

Responsabile tecnico PMM

Sarang Warudkar è un esperto Product Marketing Manager con oltre 10 anni di esperienza nella cybersecurity, esperto nell'allineare l'innovazione tecnica alle esigenze del mercato. Ha maturato una profonda esperienza in soluzioni come CASB, DLP e rilevamento delle minacce basato sull'AI, guidando strategie go-to-market di grande impatto e il coinvolgimento dei clienti. Sarang ha conseguito un MBA presso l'IIM di Bangalore e una laurea in ingegneria presso l'Università di Pune, combinando intuizioni tecniche e strategiche.

Contenuti correlati

Blog di tendenza

Attributi LLM che ogni CISO dovrebbe monitorare oggi

Sarang Warudkar 18 febbraio 2026

Dai requisiti DPDPA alla visibilità dei dati: l'imperativo DSPM

Niharika Ray e Sarang Warudkar 12 febbraio 2026

Skyhigh Security 2025: controllo più accurato, visibilità più chiara e azioni più rapide su dati, web e cloud

Thyaga Vasudevan 21 gennaio 2026

Il rischio nascosto della GenAI che potrebbe comportare costi significativi per la vostra azienda (e come risolverlo immediatamente)

Jesse Grindeland 18 dicembre 2025

Skyhigh Security : il 2026 sarà l'anno in cui l'intelligenza artificiale determinerà un nuovo modello di sicurezza aziendale.

Thyaga Vasudevan 12 dicembre 2025