موارد

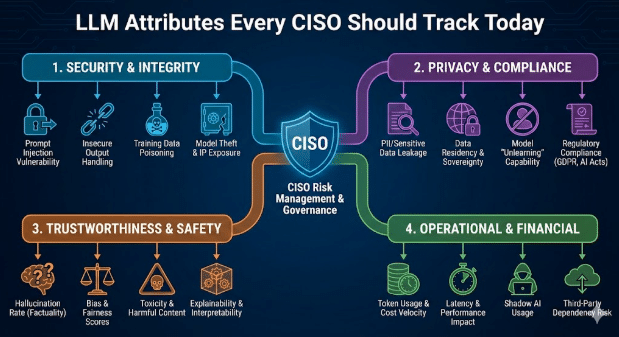

السمات التي يجب على كل مسؤول أمن المعلومات تتبعها اليوم

بقلم سارانج وارودكار - المدير الفني الأول في إدارة المشاريع التقنية (CASB والذكاء الاصطناعي)

18 فبراير 2026 5 دقيقة للقراءة

تؤثر أدوات الذكاء الاصطناعي الآن على العمل اليومي في مجالات الكتابة والتحليل وأتمتة الاجتماعات وتطوير البرمجيات. ويؤدي هذا التبني السريع إلى تحقيق مكاسب كبيرة في الإنتاجية، ولكنه يطرح أيضًا مشكلة أمنية جديدة ناجمة عن سلوك نماذج اللغة الكبيرة (LLMs). لم تعد عمليات الفحص التقليدية لبرامج SaaS كافية. يقوم مسؤولو أمن المعلومات الآن بتقييم التطبيق والنموذج الذي يقف وراءه بنفس القدر من العناية.

يوضح هذا المدونة سمات LLM التي تشكل مخاطر المؤسسة والخطوات العملية التي يمكن لقادة الأمن اتخاذها للتحكم فيها.

لماذا تعتبر سمات LLM مهمة

تتضمن معظم منتجات AI SaaS نماذج لغة كبيرة (LLM) تابعة لجهات خارجية. وهذا يخلق تبعية مزدوجة. قد يجتاز التطبيق جميع اختبارات الأمان، ولكن النموذج الأساسي قد يعرض البيانات للخطر أو ينتج رموزًا غير آمنة أو يتسبب في تسرب سير العمل الحساس. توفر الرؤية الواضحة لطبقة LLM سد هذه الفجوة وتجعل حوكمة الذكاء الاصطناعي متوافقة مع التهديدات الحديثة.

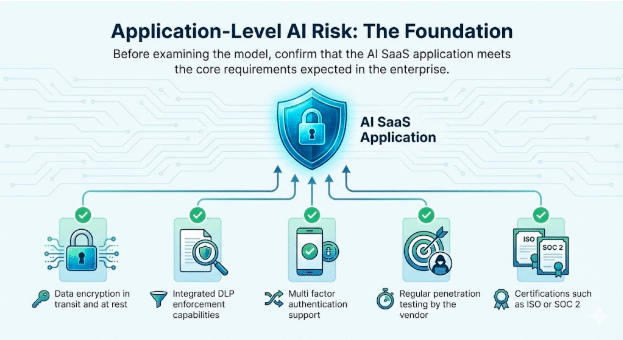

1. مخاطر الذكاء الاصطناعي على مستوى التطبيق: الأساس

قبل فحص النموذج، تأكد من أن تطبيق AI SaaS يلبي المتطلبات الأساسية المتوقعة في المؤسسة.

السمات الأساسية للتحقق منها

- تشفير البيانات أثناء النقل والتخزين

- قدرات إنفاذ DLP متكاملة

- دعم المصادقة متعددة العوامل

- اختبار الاختراق المنتظم من قبل المورد

- شهادات مثل ISO أو SOC 2

تظل هذه الفحوصات ضرورية. فهي ترسخ الثقة في الخدمة نفسها وترسي الأساس لتطبيق الذكاء الاصطناعي بشكل آمن.

2. سلوك LLM: مصدر المخاطر الجديدة

تؤثر سمات LLM بشكل مباشر على كيفية استجابة التطبيق للمستخدمين الحقيقيين والمطالبات العدائية. يقوم مسؤولو أمن المعلومات الآن بتتبع السلوكيات التالية عبر كل نموذج مدمج.

تكامل GenAI و LLM

تحديد الطراز الدقيق ومنطقة الاستضافة ونمط التحديث وما إذا كان المورد يقوم بضبطه باستخدام بيانات العملاء.

الكشف عن كسر الحماية

تحدث عمليات الاختراق عندما يتلاعب المستخدمون بالمطالبات لتجاوز ضوابط أمان LLM. تشمل التقنيات الشائعة لعب الأدوار، والتعليمات المتعددة المستويات، والتأطير الخيالي، واللغة غير المباشرة أو المشفرة. ونظرًا لأن هذه التفاعلات تشبه الاستخدام العادي، فإنها غالبًا ما تتجنب الضوابط الأساسية. يساعد تتبع محاولات الاختراق فرق الأمان على اكتشاف سوء الاستخدام مبكرًا، وتعزيز الحواجز الوقائية، وإظهار الحوكمة الاستباقية أثناء عمليات التدقيق.

مثال

- يقنع المهاجم روبوت الدردشة بشرح كيفية تعطيل MFA على حساب أحد العملاء. وهذا يفتح طريقًا مباشرًا للوصول إلى البيانات الحساسة ويخالف حوكمة الهوية داخل سير عمل يبدو شرعيًا.

توليد البرامج الضارة والرموز الضارة

تنتج LLM أحيانًا رموزًا تتضمن مسارات تنفيذ مخفية أو إجراءات تسريب.

مثال

- يقوم مهندس بلصق رمز مقترح من الذكاء الاصطناعي في خدمة داخلية. يحتوي الرمز على تسرب سري للبيانات. يؤدي هذا إلى حدوث خرق غير مكتشف لأن المنطق يبدو صحيحًا.

السمية والتحيز ومخاطر النتائج الكيميائية والبيولوجية والإشعاعية والنووية

يمكن أن تولد النماذج نصوصًا غير آمنة عند عرض مطالبات حساسة أو عدائية عليها. تتبع هذه السلوكيات في وحدات الأعمال التي تندرج ضمن نطاق السلامة أو الامتثال أو المخاطر المادية.

أمثلة

- السمية: يستجيب روبوت الدردشة الداخلي للدعم لشكوى عميل تمت إحالتها إلى المستوى الأعلى بلغة مسيئة أو تهديدية بعد أن تم تزويده بمطالبات عدائية، مما يخلق مخاطر على الموارد البشرية والعلامة التجارية عندما يتم تسجيل المحادثة أو مشاركتها.

- التحيز: يستخدم فريق التوظيف نموذج LLM لتصنيف المرشحين، ويقوم النموذج باستمرار بتخفيض تصنيف الملفات الشخصية التي تحتوي على مؤشرات الجنس أو الطبقة الاجتماعية، مما يعرض المنظمة للتمييز ونتائج التدقيق.

- مخاطر الناتج الكيميائي والبيولوجي والإشعاعي والنووي: يسأل مستخدم في مجال البحث والتطوير نموذج LLM عن تحسين عملية كيميائية، فيقدم النموذج إرشادات خطوة بخطوة تتوافق مع التوليف الكيميائي المقيد، مما يخلق مخاطر تتعلق بالسلامة التنظيمية والمادية.

التوافق مع إرشادات NIST و OWASP LLM

أصدر المعهد الوطني للمعايير والتقنية (NIST) ملف تعريف للذكاء الاصطناعي التوليدي الذي سرعان ما أصبح المعيار الأساسي لإدارة مخاطر الذكاء الاصطناعي بشكل مسؤول. تتوقع فرق الأمن والامتثال الآن أن تتوافق جميع التطبيقات القائمة على LLM بوضوح مع هذه التوقعات.

الشركات تطرح أسئلة مباشرة

- من المسؤول عن كيفية استخدام الذكاء الاصطناعي وعن نتائجه؟

- ما هي حالات استخدام LLM المسموح بها أو المحظورة صراحةً؟

- ما إذا كانت بيانات التدريب والضبط الدقيق معلنة بشكل شفاف

- كيفية التعامل مع المخاطر مثل الحقن الفوري والهلوسة والوصول غير المصرح به إلى البيانات

عندما لا توجد إجابات واضحة لهذه الأسئلة، تزداد مخاطر التدقيق بشكل حاد. في القطاعات الخاضعة للتنظيم مثل الرعاية الصحية والخدمات المالية، يؤدي عدم التوافق مع إرشادات NIST إلى زيادة احتمالية تسرب البيانات، والعقوبات التنظيمية، وفشل عمليات التدقيق.

بالتوازي مع ذلك، توثق قائمة OWASP Top 10 لتطبيقات LLM فئة جديدة من الثغرات الأمنية التي تتجاوز المخاوف التقليدية المتعلقة بأمن التطبيقات. وتشمل هذه الثغرات الحقن الفوري، والمعالجة غير الآمنة للمخرجات، وتسميم بيانات التدريب، والتكاملات غير الآمنة.

تنعكس هذه المخاطر بالفعل في حوادث حقيقية. في إحدى الحالات، سمح تطبيق SaaS للمستخدمين بتحميل مستندات لمعالجتها بواسطة الذكاء الاصطناعي. قام أحد المهاجمين بتضمين تعليمات مخفية داخل ملف، وقام النموذج بتنفيذها، مما أدى إلى كشف بيانات حساسة تخص الشركة. تحدث هذه السيناريوهات في بيئات الإنتاج الحية، وتواجه المؤسسات التي لا تتعقبها وتخفف من حدتها بشكل فعال مخاطر أمنية جوهرية.

مثال

- نموذج بدون التحقق من صحة المخرجات يؤدي إلى تسرب مفاتيح الإدارة أثناء محاولة حقن موجه. يؤدي ذلك إلى اختراق النظام بالكامل على الرغم من وجود ضوابط قوية على مستوى التطبيق.

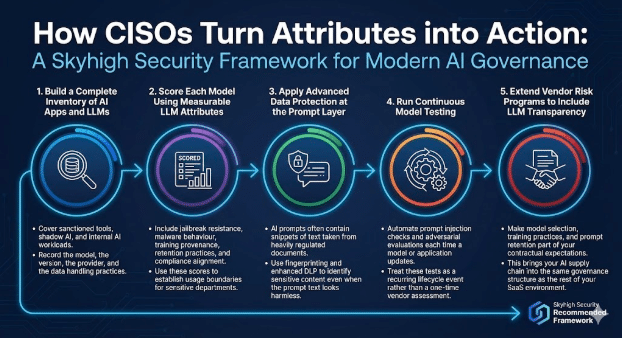

كيف يحول مسؤولو أمن المعلومات هذه السمات إلى أفعال

يجمع برنامج الحوكمة الحديثة للذكاء الاصطناعي بين فحوصات التطبيقات والضوابط التي تراعي النماذج.

Skyhigh Security بالإطار التالي.

1. إنشاء قائمة كاملة بتطبيقات الذكاء الاصطناعي ونماذج اللغة الكبيرة (LLMs)

تغطية الأدوات المعتمدة، والذكاء الاصطناعي الخفي، وأعباء عمل الذكاء الاصطناعي الداخلية.

سجل النموذج والإصدار والمزود وممارسات معالجة البيانات.

2. تقييم كل نموذج باستخدام سمات LLM القابلة للقياس

تشمل مقاومة الاختراق، وسلوك البرامج الضارة، ومصدر التدريب، وممارسات الاحتفاظ، ومواءمة الامتثال. استخدم هذه الدرجات لوضع حدود للاستخدام بالنسبة للأقسام الحساسة.

3. تطبيق الحماية المتقدمة للبيانات في طبقة المطالبة

غالبًا ما تحتوي مطالبات الذكاء الاصطناعي على مقتطفات نصية مأخوذة من مستندات خاضعة لرقابة صارمة. استخدم البصمات الرقمية ونظام DLP المحسّن لتحديد المحتوى الحساس حتى عندما يبدو نص المطالبة غير ضار.

4. إجراء اختبار النموذج المستمر

أتمتة عمليات فحص الحقن الفوري والتقييمات التنافسية في كل مرة يتم فيها تحديث نموذج أو تطبيق. تعامل مع هذه الاختبارات على أنها حدث متكرر في دورة الحياة بدلاً من تقييم لمرة واحدة من قبل المورد.

5. توسيع برامج مخاطر الموردين لتشمل شفافية LLM

اجعل اختيار النموذج وممارسات التدريب والاحتفاظ الفوري جزءًا من توقعاتك التعاقدية. وهذا يجعل سلسلة التوريد الخاصة بالذكاء الاصطناعي الخاصة بك في نفس هيكل الحوكمة مثل بقية بيئة SaaS الخاصة بك.

الطريق إلى الأمام

تعيد نماذج اللغة الكبيرة (LLM) تشكيل الطريقة التي تستخدم بها الشركات الذكاء الاصطناعي، كما تعيد تشكيل الطريقة التي يقيّم بها مسؤولو أمن المعلومات المخاطر.

في إدارة التطبيقات التقليدية، تفصل فرق الأمن بين مسألتين. يجب أن يفي التطبيق بمعايير المؤسسة فيما يتعلق بالتحكم في الوصول وحماية البيانات والتسجيل والامتثال. وبشكل مستقل، يجب أن تفي المنصة الأساسية بمتطلبات الموثوقية والأمان والتشغيل.

تقدم LLM نفس المسؤولية ذات الطبقتين، مع مخاطر أعلى.

- في طبقة التطبيقات، يجب على المؤسسات تنظيم كيفية عرض ميزات الذكاء الاصطناعي للمستخدمين. ويشمل ذلك تحديد من يمكنه الوصول إلى هذه الميزات، والبيانات التي يمكن تقديمها، وكيفية مشاركة النتائج، وكيفية تسجيل الأنشطة لأغراض التدقيق والتحقيق. تعكس هذه الضوابط ممارسات أمان التطبيقات المألوفة، والتي تم توسيعها لتشمل سير العمل المدعوم بالذكاء الاصطناعي.

- على مستوى النموذج، يجب على مسؤولي أمن المعلومات تقييم كيفية عمل LLM في الظروف الواقعية. ويشمل ذلك كيفية تعامل النموذج مع المطالبات الحساسة، وما إذا كان ينتج مخرجات غير آمنة أو متحيزة، وكيفية احتفاظه بالبيانات أو إعادة استخدامها، ومدى مقاومته للإساءة مثل حقن المطالبات أو تسميم البيانات. هذه السلوكيات تقع خارج نطاق اختبار التطبيقات التقليدي وتتطلب حوكمة صريحة.

إن تتبع سمات LLM مثل استخدام البيانات والسلوك الآمن وتغطية الحواجز الوقائية وأنماط الفشل يمنح قادة الأمن نفس الثقة التي يتوقعونها من برامج التطبيقات الناضجة. وبفضل هذه الرؤية، يمكن لمسؤولي أمن المعلومات دعم اعتماد الذكاء الاصطناعي على نطاق أوسع مع الحفاظ على الأمن والخصوصية والالتزامات التنظيمية في جميع أنحاء المؤسسة.

نبذة عن الكاتب

سارانج وارودكار

مدير مشروع تقني أول

سارانج وارودكار هو مدير تسويق منتجات متمرس يتمتع بخبرة تزيد عن 10 سنوات في مجال الأمن السيبراني، ويتمتع بمهارة في مواءمة الابتكار التقني مع احتياجات السوق. وهو يتمتع بخبرة عميقة في حلول مثل CASB وDLP والكشف عن التهديدات القائمة على الذكاء الاصطناعي، مما يؤدي إلى استراتيجيات مؤثرة في السوق وإشراك العملاء. سارانج حاصل على ماجستير في إدارة الأعمال من معهد IIM بنغالور ودرجة الهندسة من جامعة بيون، ويجمع بين الرؤية التقنية والاستراتيجية.

مضامين ذات صلة

المدونات الرائجة

السمات التي يجب على كل مسؤول أمن المعلومات تتبعها اليوم

سارانغ وارودكار 18 فبراير 2026

من متطلبات DPDPA إلى رؤية البيانات: ضرورة DSPM

نيهاريكا راي وسارانغ وارودكار 12 فبراير 2026

Skyhigh Security 2025: تحكم أكثر دقة، رؤية أوضح، وإجراءات أسرع عبر البيانات والويب والسحابة

Thyaga Vasudevan 21 يناير 2026

المخاطر الخفية لـ GenAI التي قد تكلف شركتك الملايين (وكيفية إصلاحها اليوم)

جيسي غريندلاند 18 ديسمبر 2025

Skyhigh Security : 2026 هو العام الذي ستفرض فيه الذكاء الاصطناعي خطة جديدة لأمن المؤسسات

ثياغا فاسوديفان 12 ديسمبر 2025