Ressources

Les attributs LLM que tout RSSI devrait surveiller actuellement

Par Sarang Warudkar - Sr. Technical PMM (CASB & AI)

18 février 2026 5 Minutes de lecture

Les outils d'IA influencent désormais le travail quotidien dans les domaines de la rédaction, de l'analyse, de l'automatisation des réunions et du développement de logiciels. Cette adoption rapide permet de gagner considérablement en productivité, mais elle introduit également une nouvelle surface de sécurité liée au comportement des grands modèles linguistiques (LLM). Les contrôles SaaS traditionnels ne suffisent plus. Les RSSI évaluent désormais l'application et le modèle qui la sous-tend avec le même soin.

Ce blog présente les caractéristiques LLM qui influencent les risques d'entreprise et les mesures pratiques que les responsables de la sécurité peuvent mettre en œuvre pour les gérer.

Pourquoi les attributs LLM sont-ils importants ?

La plupart des produits SaaS d'IA intègrent des LLM tiers. Cela crée une double dépendance. L'application peut passer tous les contrôles de sécurité, mais le modèle sous-jacent peut toujours exposer des données, produire du code non sécurisé ou divulguer des flux de travail sensibles. Une vision claire de la couche LLM comble cette lacune et aligne la gouvernance de l'IA sur les menaces modernes.

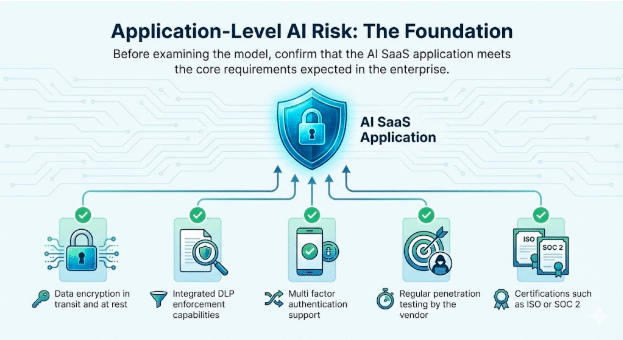

1. Risque lié à l'IA au niveau des applications : les fondements

Avant d'examiner le modèle, veuillez vous assurer que l'application SaaS d'IA répond aux exigences fondamentales attendues dans l'entreprise.

Attributs de base à vérifier

- Chiffrement des données en transit et au repos

- Fonctionnalités intégrées de mise en application DLP

- Prise en charge de l'authentification multifactorielle

- Tests de pénétration réguliers effectués par le fournisseur

- Certifications telles que ISO ou SOC 2

Ces contrôles restent indispensables. Ils instaurent la confiance dans le service lui-même et constituent la base d'un déploiement sécurisé de l'IA.

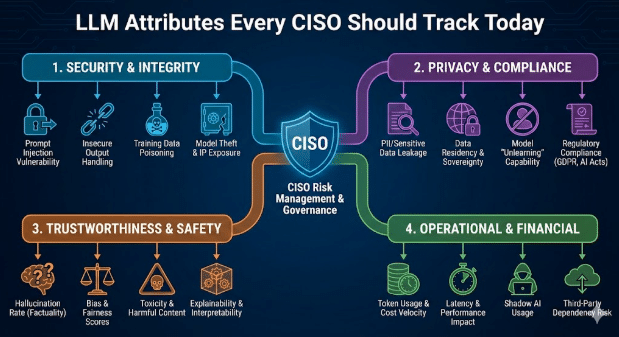

2. Comportement LLM : la source de la nouvelle surface de risque

Les attributs LLM influencent directement la manière dont l'application réagit aux utilisateurs réels et aux invites adversaires. Les RSSI suivent désormais les comportements suivants dans chaque modèle intégré.

Intégration de GenAI et LLM

Veuillez identifier le modèle exact, la région d'hébergement, le modèle de mise à jour et si le fournisseur procède à des ajustements à l'aide des données des clients.

Exposition au jailbreak

Les jailbreaks se produisent lorsque les utilisateurs manipulent les invites pour contourner les contrôles de sécurité LLM. Les techniques courantes comprennent le jeu de rôle, les instructions à plusieurs niveaux, le cadrage fictif et le langage indirect ou codé. Comme ces interactions ressemblent à une utilisation normale, elles échappent souvent aux contrôles de base. Le suivi des tentatives de jailbreak aide les équipes de sécurité à détecter rapidement les utilisations abusives, à renforcer les garde-fous et à démontrer une gouvernance proactive lors des audits.

Exemple

- Un attaquant persuade un chatbot de lui expliquer comment désactiver l'authentification multifactorielle (MFA) sur le compte d'un client. Cela lui ouvre un accès direct à des données sensibles et compromet la gouvernance des identités au sein d'un flux de travail qui semble légitime.

Génération de logiciels malveillants et de codes nuisibles

Les LLM génèrent parfois du code qui intègre des chemins d'exécution cachés ou des routines d'exfiltration.

Exemple

- Un ingénieur intègre du code suggéré par l'IA dans un service interne. Ce code contient une fuite de données dissimulée. Cela entraîne une violation non détectée, car la logique semble valide.

Risques liés à la toxicité, aux biais et aux rejets CBRN

Les modèles peuvent générer des textes inappropriés lorsqu'ils sont confrontés à des invites sensibles ou conflictuelles. Veuillez surveiller ces comportements pour les unités commerciales où la sécurité, la conformité ou les risques physiques sont concernés.

Exemples

- Toxicité : un chatbot d'assistance interne répond à une réclamation client transmise à un niveau supérieur en utilisant un langage injurieux ou menaçant après avoir reçu des instructions hostiles, ce qui crée un risque pour les ressources humaines et l'image de marque lorsque la transcription est enregistrée ou partagée.

- Biais : une équipe de recrutement utilise un modèle LLM pour classer les candidats, et ce modèle déclassifie systématiquement les profils contenant des indicateurs de genre ou de caste, exposant ainsi l'organisation à des accusations de discrimination et à des conclusions d'audit.

- Risques liés aux résultats CBRN : un utilisateur R&D interroge un LLM sur l'amélioration d'un processus chimique, et le modèle fournit des instructions étape par étape qui correspondent à une synthèse chimique soumise à des restrictions, créant ainsi un risque réglementaire et physique.

Conformité avec les directives NIST et OWASP LLM

Le NIST a publié un profil d'IA générative qui est en passe de devenir la référence en matière de gestion responsable des risques liés à l'IA. Les équipes chargées de la sécurité et de la conformité attendent désormais de toutes les applications basées sur le LLM qu'elles répondent clairement à ces attentes.

Les entreprises posent des questions directes.

- Qui est responsable de la manière dont l'IA est utilisée et de ses résultats ?

- Quels sont les cas d'utilisation de LLM explicitement autorisés ou interdits ?

- Si les données d'entraînement et d'ajustement sont déclarées de manière transparente

- Comment sont gérés les risques tels que l'injection rapide, les hallucinations et l'accès non autorisé aux données ?

Lorsque ces questions restent sans réponse claire, le risque d'audit augmente considérablement. Dans les secteurs réglementés tels que la santé et les services financiers, le non-respect des directives du NIST augmente le risque de fuite de données, de sanctions réglementaires et d'échecs aux audits.

Parallèlement, le classement OWASP Top 10 pour les applications LLM répertorie une nouvelle catégorie de vulnérabilités qui vont au-delà des préoccupations traditionnelles en matière de sécurité des applications. Il s'agit notamment de l'injection de prompt, du traitement non sécurisé des sorties, de l'empoisonnement des données d'entraînement et des intégrations non sécurisées.

Des incidents réels illustrent déjà ces risques. Dans un cas, une application SaaS permettait aux utilisateurs de télécharger des documents pour les traiter à l'aide de l'IA. Un pirate a intégré des instructions cachées dans un fichier, le modèle les a exécutées et des données sensibles de l'entreprise ont été exposées. Ces scénarios se produisent dans des environnements de production réels, et les organisations qui ne les surveillent pas activement et ne les atténuent pas s'exposent à des risques de sécurité importants.

Exemple

- Un modèle sans validation des sorties divulgue les clés d'administration lors d'une tentative d'injection d'invite. Cela entraîne une compromission à l'échelle du système malgré des contrôles rigoureux au niveau de l'application.

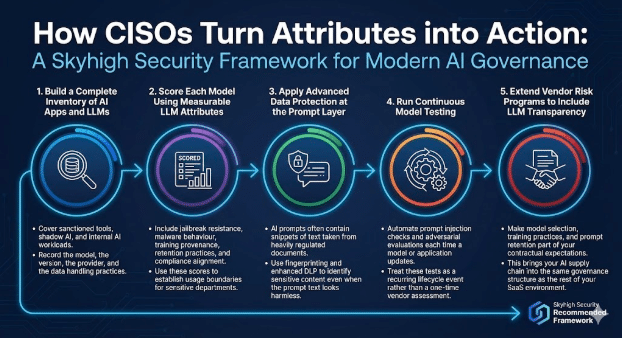

Comment les RSSI transforment ces attributs en actions

Un programme moderne de gouvernance de l'IA combine des vérifications d'applications et des contrôles tenant compte des modèles.

Skyhigh Security le cadre suivant.

1. Établir un inventaire complet des applications d'IA et des modèles d'apprentissage profond (LLM)

Couvrez les outils autorisés, l'IA parallèle et les charges de travail internes liées à l'IA.

Veuillez enregistrer le modèle, la version, le fournisseur et les pratiques de traitement des données.

2. Évaluer chaque modèle à l'aide d'attributs LLM mesurables

Veuillez inclure la résistance au jailbreak, le comportement des logiciels malveillants, la provenance de la formation, les pratiques de conservation et l'alignement sur la conformité. Veuillez utiliser ces scores pour établir des limites d'utilisation pour les services sensibles.

3. Appliquez la protection avancée des données au niveau de la couche d'invite.

Les invites d'IA contiennent souvent des extraits de texte provenant de documents soumis à une réglementation stricte. Utilisez l'empreinte digitale et la protection contre la perte de données (DLP) améliorée pour identifier les contenus sensibles, même lorsque le texte de l'invite semble inoffensif.

4. Effectuer des tests continus sur les modèles

Automatisez les vérifications d'injection rapide et les évaluations adversaires à chaque mise à jour d'un modèle ou d'une application. Considérez ces tests comme un événement récurrent du cycle de vie plutôt que comme une évaluation ponctuelle du fournisseur.

5. Étendre les programmes de gestion des risques fournisseurs afin d'inclure la transparence LLM

Intégrez la sélection des modèles, les pratiques de formation et la conservation rapide dans vos attentes contractuelles. Cela permet d'intégrer votre chaîne logistique IA dans la même structure de gouvernance que le reste de votre environnement SaaS.

La voie à suivre

Les LLM modifient la manière dont les entreprises utilisent l'IA et la manière dont les RSSI évaluent les risques.

Dans la gouvernance traditionnelle des applications, les équipes de sécurité distinguent deux aspects. L'application doit respecter les normes de l'entreprise en matière de contrôle d'accès, de protection des données, de journalisation et de conformité. Indépendamment de cela, la plateforme sous-jacente doit répondre aux attentes en matière de fiabilité, de sécurité et d'exploitation.

Les LLM introduisent la même responsabilité à deux niveaux, avec des enjeux plus importants.

- Au niveau de la couche applicative, les organisations doivent définir comment les fonctionnalités d'IA sont présentées aux utilisateurs. Cela inclut les personnes autorisées à accéder à ces fonctionnalités, les données pouvant être soumises, la manière dont les résultats sont partagés et la manière dont les activités sont consignées à des fins d'audit et d'enquête. Ces contrôles reflètent les pratiques courantes en matière de sécurité des applications, étendues aux workflows basés sur l'IA.

- Au niveau du modèle, les RSSI doivent évaluer le comportement du LLM dans des conditions réelles. Cela inclut la manière dont le modèle traite les invites sensibles, s'il produit des résultats non sécurisés ou biaisés, comment il conserve ou réutilise les données, et dans quelle mesure il est résistant aux abus tels que l'injection d'invites ou l'empoisonnement des données. Ces comportements ne relèvent pas des tests traditionnels des applications et nécessitent une gouvernance explicite.

Le suivi des attributs LLM tels que l'utilisation des données, les comportements sécuritaires, la couverture des garde-fous et les modèles de défaillance offre aux responsables de la sécurité la même confiance qu'ils attendent des programmes d'application matures. Grâce à cette visibilité, les RSSI peuvent favoriser une adoption plus large de l'IA tout en maintenant la sécurité, la confidentialité et le respect des engagements réglementaires dans toute l'entreprise.

A propos de l'auteur

Sarang Warudkar

Chef de projet technique senior

Sarang Warudkar est un chef de produit marketing expérimenté avec plus de 10 ans dans la cybersécurité, compétent pour aligner l'innovation technique avec les besoins du marché. Il apporte une expertise approfondie dans des solutions telles que CASB, DLP, et la détection des menaces basée sur l'IA, en conduisant des stratégies de mise sur le marché impactantes et l'engagement des clients. Sarang est titulaire d'un MBA de l'IIM Bangalore et d'un diplôme d'ingénieur de l'Université de Pune, alliant vision technique et stratégique.

Contenu connexe

Des exigences de la DPDPA à la visibilité des données : l'importance du DSPM

Blogs en vogue

Les attributs LLM que tout RSSI devrait surveiller actuellement

Sarang Warudkar 18 février 2026

Des exigences de la DPDPA à la visibilité des données : l'importance du DSPM

Niharika Ray et Sarang Warudkar 12 février 2026

Skyhigh Security 2025 : contrôle plus précis, visibilité plus claire et action plus rapide sur les données, le Web et le cloud

Thyaga Vasudevan 21 janvier 2026

Le risque caché de l'IA générique qui pourrait coûter des millions à votre entreprise (et comment y remédier dès aujourd'hui)

Jesse Grindeland 18 décembre 2025

Skyhigh Security : 2026 sera l'année où l'IA imposera un nouveau modèle pour la sécurité des entreprises

Thyaga Vasudevan 12 décembre 2025