ทรัพยากร

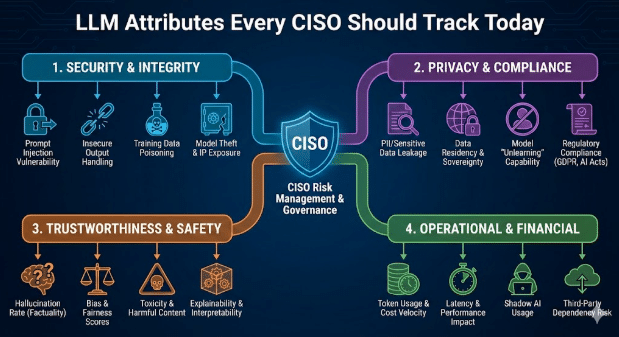

คุณลักษณะของ LLM ที่ CISO ทุกคนควรติดตามในปัจจุบัน

โดย Sarang Warudkar – หัวหน้าฝ่ายเทคนิคอาวุโส (CASB & AI)

18 กุมภาพันธ์ 2569 5 อ่านหนึ่งนาที

เครื่องมือ AI เข้ามามีบทบาทในงานประจำวันมากขึ้น ตั้งแต่การเขียน การวิเคราะห์ การจัดประชุมอัตโนมัติ และการพัฒนาซอฟต์แวร์ การนำไปใช้ที่รวดเร็วนี้ส่งผลให้ประสิทธิภาพการทำงานเพิ่มขึ้นอย่างมาก แต่ก็ทำให้เกิดความเสี่ยงด้านความปลอดภัยใหม่ๆ ที่เกิดจากพฤติกรรมของแบบจำลองภาษาขนาดใหญ่ (LLM) การตรวจสอบ SaaS แบบเดิมๆ จึงไม่เพียงพออีกต่อไป ปัจจุบัน CISO ต้องประเมินทั้งแอปพลิเคชันและแบบจำลองที่อยู่เบื้องหลังด้วยความระมัดระวังเท่าเทียมกัน

บล็อกนี้จะสรุปคุณลักษณะของ LLM ที่กำหนดรูปแบบความเสี่ยงขององค์กร และขั้นตอนเชิงปฏิบัติที่ผู้นำด้านความปลอดภัยสามารถนำไปใช้ในการกำกับดูแลคุณลักษณะเหล่านั้น

เหตุใดคุณลักษณะของหลักสูตร LLM จึงมีความสำคัญ

ผลิตภัณฑ์ AI SaaS ส่วนใหญ่ฝัง LLM ของบุคคลที่สามไว้ ซึ่งก่อให้เกิดการพึ่งพาแบบสองด้าน แอปอาจผ่านการตรวจสอบความปลอดภัยทุกอย่าง แต่โมเดลที่อยู่เบื้องหลังยังคงสามารถเปิดเผยข้อมูล สร้างโค้ดที่ไม่ปลอดภัย หรือรั่วไหลเวิร์กโฟลว์ที่ละเอียดอ่อนได้ การมองเห็นภาพรวมของเลเยอร์ LLM อย่างชัดเจนจะช่วยปิดช่องว่างนี้และทำให้การกำกับดูแล AI สอดคล้องกับภัยคุกคามสมัยใหม่

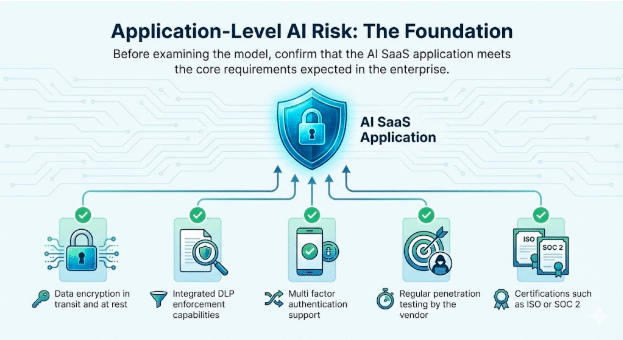

1. ความเสี่ยงด้าน AI ในระดับแอปพลิเคชัน: รากฐาน

ก่อนตรวจสอบโมเดล โปรดตรวจสอบให้แน่ใจว่าแอปพลิเคชัน AI SaaS นั้นตรงตามข้อกำหนดหลักที่องค์กรคาดหวังไว้

คุณลักษณะพื้นฐานที่ต้องตรวจสอบ

- การเข้ารหัสข้อมูลทั้งในระหว่างการส่งและขณะจัดเก็บ

- ความสามารถในการบังคับใช้ DLP แบบบูรณาการ

- รองรับการตรวจสอบสิทธิ์แบบหลายปัจจัย

- การทดสอบการเจาะระบบเป็นประจำโดยผู้จำหน่าย

- ใบรับรองต่างๆ เช่น ISO หรือ SOC 2

การตรวจสอบเหล่านี้ยังคงมีความสำคัญอย่างยิ่ง เพราะเป็นการสร้างความไว้วางใจในตัวบริการเอง และวางรากฐานสำหรับการใช้งาน AI อย่างปลอดภัย

2. พฤติกรรม LLM: แหล่งที่มาของพื้นผิวความเสี่ยงใหม่

คุณลักษณะของ LLM ส่งผลโดยตรงต่อการตอบสนองของแอปพลิเคชันต่อผู้ใช้จริงและข้อความแจ้งเตือนจากฝ่ายตรงข้าม ปัจจุบัน CISO ติดตามพฤติกรรมต่อไปนี้ในทุกโมเดลฝังตัว

การผสานรวม GenAI และ LLM

ระบุรุ่นที่แน่นอน ภูมิภาคที่ให้บริการ รูปแบบการอัปเดต และว่าผู้ขายปรับแต่งระบบโดยใช้ข้อมูลลูกค้าหรือไม่

การเปิดเผยการเจลเบรก

การเจาะระบบเกิดขึ้นเมื่อผู้ใช้ดัดแปลงข้อความแจ้งเตือนเพื่อหลีกเลี่ยงการควบคุมความปลอดภัยของ LLM เทคนิคทั่วไป ได้แก่ การเล่นบทบาทสมมติ คำสั่งแบบหลายชั้น การสร้างสถานการณ์สมมติ และภาษาทางอ้อมหรือภาษาเข้ารหัส เนื่องจากปฏิสัมพันธ์เหล่านี้คล้ายกับการใช้งานปกติ จึงมักหลีกเลี่ยงการควบคุมขั้นพื้นฐานได้ การติดตามความพยายามในการเจาะระบบช่วยให้ทีมรักษาความปลอดภัยตรวจจับการใช้งานในทางที่ผิดได้ตั้งแต่เนิ่นๆ เสริมสร้างมาตรการป้องกัน และแสดงให้เห็นถึงการกำกับดูแลเชิงรุกในระหว่างการตรวจสอบ

ตัวอย่าง

- ผู้โจมตีหลอกล่อให้แชทบอทอธิบายวิธีการปิดใช้งาน MFA ในบัญชีลูกค้า ซึ่งเป็นการเปิดช่องทางโดยตรงไปสู่ข้อมูลที่ละเอียดอ่อนและทำลายการกำกับดูแลตัวตนภายในขั้นตอนการทำงานที่ดูเหมือนถูกต้องตามกฎหมาย

มัลแวร์และการสร้างโค้ดที่เป็นอันตราย

บางครั้ง LLMs สร้างโค้ดที่มีเส้นทางการเรียกใช้งานที่ซ่อนอยู่หรือรูทีนการขโมยข้อมูลอยู่ภายใน

ตัวอย่าง

- วิศวกรคนหนึ่งคัดลอกโค้ดที่ AI แนะนำลงในระบบภายใน โค้ดดังกล่าวมีข้อมูลรั่วไหลซ่อนอยู่ ซึ่งทำให้เกิดการละเมิดความปลอดภัยโดยที่ไม่มีใครตรวจพบ เนื่องจากตรรกะของโค้ดดูเหมือนถูกต้อง

ความเสี่ยงด้านความเป็นพิษ อคติ และผลลัพธ์จากสารเคมี ชีวภาพ รังสี และนิวเคลียร์ (CBRN)

โมเดลอาจสร้างข้อความที่ไม่ปลอดภัยเมื่อได้รับข้อความกระตุ้นที่ละเอียดอ่อนหรือเป็นปรปักษ์ ติดตามพฤติกรรมเหล่านี้สำหรับหน่วยธุรกิจที่เกี่ยวข้องกับความปลอดภัย การปฏิบัติตามกฎระเบียบ หรือความเสี่ยงทางกายภาพ

ตัวอย่าง

- ความเป็นพิษ: แชทบอทฝ่ายสนับสนุนภายในตอบสนองต่อข้อร้องเรียนของลูกค้าที่ได้รับการยกระดับด้วยถ้อยคำหยาบคายหรือข่มขู่ หลังจากได้รับคำสั่งที่แสดงความไม่เป็นมิตร ซึ่งก่อให้เกิดความเสี่ยงด้านทรัพยากรบุคคลและแบรนด์เมื่อมีการบันทึกหรือเผยแพร่บทสนทนา

- อคติ: ทีมสรรหาบุคลากรใช้แบบจำลอง LLM ในการจัดอันดับผู้สมัคร และแบบจำลองดังกล่าวลดระดับโปรไฟล์ที่มีตัวบ่งชี้เพศหรือวรรณะอย่างต่อเนื่อง ซึ่งอาจทำให้องค์กรเสี่ยงต่อการเลือกปฏิบัติและการตรวจสอบพบข้อบกพร่อง

- ความเสี่ยงจากผลลัพธ์ของสารเคมี ชีวภาพ รังสี และนิวเคลียร์ (CBRN): ผู้ใช้งานด้านการวิจัยและพัฒนาสอบถาม LLM เกี่ยวกับการปรับปรุงกระบวนการทางเคมี และแบบจำลองจะให้คำแนะนำทีละขั้นตอนซึ่งสอดคล้องกับการสังเคราะห์ทางเคมีที่ถูกจำกัด ทำให้เกิดความเสี่ยงด้านกฎระเบียบและความปลอดภัยทางกายภาพ

สอดคล้องกับแนวทางของ NIST และ OWASP LLM

NIST ได้เผยแพร่ Generative AI Profile ซึ่งกำลังกลายเป็นมาตรฐานพื้นฐานสำหรับการจัดการความเสี่ยงด้าน AI อย่างมีความรับผิดชอบอย่างรวดเร็ว ปัจจุบันทีมรักษาความปลอดภัยและการปฏิบัติตามกฎระเบียบคาดหวังว่าแอปพลิเคชันที่ใช้ LLM ทุกตัวจะต้องสอดคล้องกับความคาดหวังเหล่านี้อย่างชัดเจน

ภาคธุรกิจกำลังตั้งคำถามโดยตรง

- ใครเป็นผู้รับผิดชอบต่อการใช้งาน AI และผลลัพธ์ที่ได้จากการใช้งาน AI นั้น?

- กรณีการใช้งาน LLM ใดบ้างที่ได้รับอนุญาตหรือถูกห้ามอย่างชัดเจน

- มีการเปิดเผยข้อมูลการฝึกอบรมและการปรับแต่งอย่างโปร่งใสหรือไม่

- วิธีการรับมือกับความเสี่ยงต่างๆ เช่น การฉีดยาโดยไม่ตั้งใจ อาการประสาทหลอน และการเข้าถึงข้อมูลโดยไม่ได้รับอนุญาต

เมื่อคำถามเหล่านี้ขาดคำตอบที่ชัดเจน ความเสี่ยงต่อการตรวจสอบก็จะเพิ่มสูงขึ้นอย่างมาก ในภาคส่วนที่มีการกำกับดูแล เช่น การดูแลสุขภาพและบริการทางการเงิน การไม่สอดคล้องกับแนวทางของ NIST จะเพิ่มโอกาสในการรั่วไหลของข้อมูล บทลงโทษทางกฎหมาย และการตรวจสอบที่ไม่ผ่าน

ในขณะเดียวกัน เอกสาร OWASP Top 10 สำหรับแอปพลิเคชัน LLM ได้บันทึกช่องโหว่ประเภทใหม่ที่ขยายขอบเขตไปไกลกว่าข้อกังวลด้านความปลอดภัยของแอปพลิเคชันแบบดั้งเดิม ซึ่งรวมถึงการแทรกข้อความแจ้งเตือน การจัดการเอาต์พุตที่ไม่ปลอดภัย การปนเปื้อนข้อมูลการฝึกอบรม และการผสานรวมที่ไม่ปลอดภัย

เหตุการณ์จริงที่เกิดขึ้นแล้วสะท้อนให้เห็นถึงความเสี่ยงเหล่านี้ ในกรณีหนึ่ง แอปพลิเคชัน SaaS อนุญาตให้ผู้ใช้สามารถอัปโหลดเอกสารเพื่อประมวลผลโดย AI ผู้โจมตีได้ฝังคำสั่งที่ซ่อนไว้ในไฟล์ โมเดลได้ดำเนินการตามคำสั่งนั้น และข้อมูลสำคัญของบริษัทก็ถูกเปิดเผย สถานการณ์เหล่านี้เกิดขึ้นในสภาพแวดล้อมการผลิตจริง และองค์กรที่ไม่ติดตามและลดความเสี่ยงเหล่านี้อย่างจริงจังจะเผชิญกับความเสี่ยงด้านความปลอดภัยอย่างร้ายแรง

ตัวอย่าง

- โมเดลที่ไม่มีการตรวจสอบความถูกต้องของผลลัพธ์ทำให้คีย์ผู้ดูแลระบบรั่วไหลระหว่างการพยายามแทรกคำสั่ง ซึ่งส่งผลให้ ระบบโดยรวมถูกบุกรุก แม้ว่าจะมีระบบควบคุมที่เข้มงวดในระดับแอปพลิเคชันก็ตาม

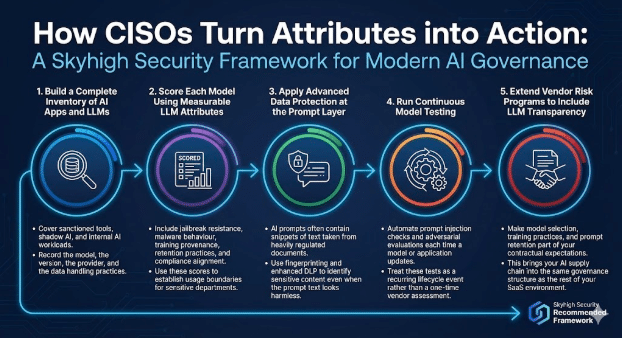

วิธีที่ CISOs นำคุณลักษณะเหล่านี้ไปสู่การปฏิบัติ

โปรแกรมการกำกับดูแล AI สมัยใหม่ผสมผสานการตรวจสอบแอปพลิเคชันเข้ากับการควบคุมที่คำนึงถึงแบบจำลอง

Skyhigh Security แนะนำกรอบการทำงานดังต่อไปนี้

1. จัดทำบัญชีรายชื่อแอปพลิเคชัน AI และ LLM ที่ครบถ้วน

ครอบคลุมเครื่องมือที่ได้รับอนุญาต ปัญญาประดิษฐ์แฝง และภาระงานปัญญาประดิษฐ์ภายในองค์กร

บันทึกข้อมูลรุ่น เวอร์ชัน ผู้ให้บริการ และแนวทางการจัดการข้อมูล

2. ให้คะแนนแต่ละแบบจำลองโดยใช้คุณลักษณะ LLM ที่วัดได้

ควรพิจารณาถึงความต้านทานต่อการเจาะระบบ พฤติกรรมของมัลแวร์ แหล่งที่มาของการฝึกอบรม แนวทางการเก็บรักษาข้อมูล และการปฏิบัติตามกฎระเบียบ ใช้คะแนนเหล่านี้เพื่อกำหนดขอบเขตการใช้งานสำหรับแผนกที่มีความสำคัญ

3. ปรับใช้การปกป้องข้อมูลขั้นสูงที่ระดับพรอมต์เลเยอร์

ข้อความแจ้งเตือนจาก AI มักมีข้อความบางส่วนที่คัดลอกมาจากเอกสารที่มีการควบคุมอย่างเข้มงวด ควรใช้เทคนิคการระบุตัวตนด้วยลายนิ้วมือและเทคโนโลยี DLP ขั้นสูงเพื่อระบุเนื้อหาที่ละเอียดอ่อน แม้ว่าข้อความแจ้งเตือนจะดูไม่เป็นอันตรายก็ตาม

4. ดำเนินการทดสอบโมเดลอย่างต่อเนื่อง

ทำการ ตรวจสอบการแทรกข้อความแจ้งเตือนและการประเมินภัยคุกคามโดยอัตโนมัติทุกครั้งที่มีการอัปเดตโมเดลหรือแอปพลิเคชัน ถือว่าการทดสอบเหล่านี้เป็นเหตุการณ์ที่เกิดขึ้นซ้ำๆ ในวงจรชีวิตของผลิตภัณฑ์ แทนที่จะเป็นการประเมินจากผู้จำหน่ายเพียงครั้งเดียว

5. ขยายโครงการบริหารความเสี่ยงของผู้ขายให้ครอบคลุมถึงความโปร่งใสของ LLM ด้วย

กำหนดให้การคัดเลือกโมเดล แนวทางการฝึกอบรม และการเก็บรักษาข้อมูลอย่างรวดเร็วเป็นส่วนหนึ่งของข้อกำหนดในสัญญา ซึ่งจะทำให้ห่วงโซ่อุปทาน AI ของคุณอยู่ภายใต้โครงสร้างการกำกับดูแลเดียวกันกับสภาพแวดล้อม SaaS ส่วนอื่นๆ ของคุณ

เส้นทางข้างหน้า

หลักสูตร LLM เปลี่ยนโฉมวิธีการที่องค์กรต่างๆ ใช้ AI และเปลี่ยนโฉมวิธีการที่ CISO ประเมินความเสี่ยง

ในการกำกับดูแลแอปพลิเคชันแบบดั้งเดิม ทีมรักษาความปลอดภัยจะแยกประเด็นออกเป็นสองส่วน แอปพลิเคชันต้องเป็นไปตามมาตรฐานขององค์กรในด้านการควบคุมการเข้าถึง การปกป้องข้อมูล การบันทึก และการปฏิบัติตามกฎระเบียบ ในขณะเดียวกัน แพลตฟอร์มพื้นฐานต้องเป็นไปตามความคาดหวังด้านความน่าเชื่อถือ ความปลอดภัย และการดำเนินงาน

หลักสูตร LLM นำเสนอความรับผิดชอบสองระดับเช่นเดียวกับหลักสูตร LLM ทั่วไป แต่มีความเสี่ยงสูงกว่า

- ในระดับแอปพลิเคชัน องค์กรต้องควบคุมวิธีการเปิดเผยฟีเจอร์ AI ให้แก่ผู้ใช้ ซึ่งรวมถึงใครบ้างที่สามารถเข้าถึงความสามารถนั้นได้ ข้อมูลใดบ้างที่สามารถส่งได้ วิธีการแบ่งปันผลลัพธ์ และวิธีการบันทึกกิจกรรมเพื่อการตรวจสอบและการสืบสวน การควบคุมเหล่านี้สะท้อนถึงแนวปฏิบัติด้านความปลอดภัยของแอปพลิเคชันที่คุ้นเคย ซึ่งขยายไปสู่เวิร์กโฟลว์ที่ขับเคลื่อนด้วย AI

- ในระดับโมเดล ผู้บริหารด้านความปลอดภัยสารสนเทศ (CISO) ต้องประเมินว่าโมเดลการจัดการความเสี่ยง (LLM) ทำงานอย่างไรภายใต้สภาวะการใช้งานจริง ซึ่งรวมถึงวิธีการที่โมเดลจัดการกับข้อความแจ้งเตือนที่ละเอียดอ่อน ว่าโมเดลสร้างเอาต์พุตที่ไม่ปลอดภัยหรือมีอคติหรือไม่ วิธีการเก็บรักษาหรือการนำข้อมูลกลับมาใช้ใหม่ และความสามารถในการรับมือกับการละเมิด เช่น การแทรกข้อความแจ้งเตือนหรือการปนเปื้อนข้อมูล พฤติกรรมเหล่านี้อยู่นอกเหนือการทดสอบแอปพลิเคชันแบบดั้งเดิมและต้องมีการกำกับดูแลอย่างชัดเจน

การติดตามคุณลักษณะของ LLM เช่น การใช้งานข้อมูล พฤติกรรมด้านความปลอดภัย การครอบคลุมมาตรการป้องกัน และรูปแบบความล้มเหลว ช่วยให้ผู้นำด้านความปลอดภัยมีความมั่นใจเช่นเดียวกับที่คาดหวังจากโปรแกรมแอปพลิเคชันที่ครบวงจร ด้วยข้อมูลเชิงลึกนี้ CISO สามารถสนับสนุนการนำ AI มาใช้ในวงกว้างขึ้น ในขณะที่ยังคงรักษาความปลอดภัย ความเป็นส่วนตัว และข้อผูกพันด้านกฎระเบียบทั่วทั้งองค์กร

เกี่ยวกับผู้เขียน

ซารัง วารุดการ์

ผู้จัดการโครงการด้านเทคนิคอาวุโส

Sarang Warudkar เป็นผู้จัดการฝ่ายการตลาดผลิตภัณฑ์ที่มีประสบการณ์มากกว่า 10 ปีในด้านความปลอดภัยทางไซเบอร์ มีความเชี่ยวชาญในการจัดแนวนวัตกรรมทางเทคนิคให้สอดคล้องกับความต้องการของตลาด เขามีความเชี่ยวชาญอย่างลึกซึ้งในโซลูชันต่างๆ เช่น CASB, DLP และการตรวจจับภัยคุกคามที่ขับเคลื่อนด้วย AI ซึ่งขับเคลื่อนกลยุทธ์การออกสู่ตลาดที่มีประสิทธิผลและการมีส่วนร่วมของลูกค้า Sarang สำเร็จการศึกษาระดับปริญญาโทสาขาบริหารธุรกิจจาก IIM Bangalore และปริญญาทางวิศวกรรมศาสตร์จาก Pune University โดยผสมผสานความรู้เชิงเทคนิคและเชิงกลยุทธ์เข้าด้วยกัน

เนื้อหาที่เกี่ยวข้อง

บล็อกที่กำลังได้รับความนิยม

คุณลักษณะของ LLM ที่ CISO ทุกคนควรติดตามในปัจจุบัน

สารัง วารุดการ์ 18 กุมภาพันธ์ 2569

จากข้อกำหนดของ DPDPA สู่การมองเห็นข้อมูล: ความจำเป็นของ DSPM

นิฮาริกา เรย์ และซารัง วารัดการ์ วันที่ 12 กุมภาพันธ์ พ.ศ. 2569

Skyhigh Security ไตรมาสที่ 4 ปี 2025: ควบคุมได้ดียิ่งขึ้น มองเห็นภาพรวมได้ชัดเจนขึ้น และดำเนินการได้รวดเร็วขึ้นในด้านข้อมูล เว็บ และคลาวด์

ไทอากา วาสุเดวัน 21 มกราคม 2569

ความเสี่ยงที่ซ่อนอยู่ของ GenAI ที่อาจทำให้บริษัทของคุณสูญเสียเงินหลายล้าน (และวิธีแก้ไขในวันนี้)

เจสซี กรินเดแลนด์ 18 ธันวาคม 2025

Skyhigh Security การคาดการณ์: ปี 2026 คือปีที่ AI จะบังคับให้เกิดพิมพ์เขียวใหม่สำหรับความปลอดภัยขององค์กร

ไทอากา วาสุเดวัน วันที่ 12 ธันวาคม พ.ศ. 2568