Recursos

Atributos LLM que todo CISO debería seguir hoy en día

Por Sarang Warudkar - PMM técnico superior (CASB y AI)

18 de febrero de 2026 5 Minutos de lectura

Las herramientas de IA influyen ahora en el trabajo diario en tareas como la redacción, el análisis, la automatización de reuniones y el desarrollo de software. Esta rápida adopción proporciona un gran aumento de la productividad, pero también introduce una nueva superficie de seguridad impulsada por el comportamiento de los modelos de lenguaje grandes (LLM). Las comprobaciones tradicionales de SaaS ya no son suficientes. Los CISO evalúan ahora la aplicación y el modelo que hay detrás de ella con el mismo cuidado.

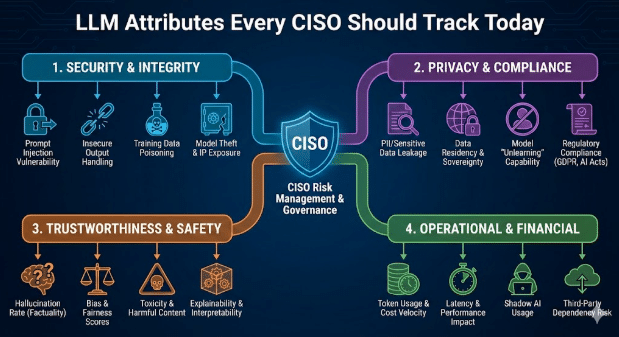

Este blog describe los atributos de LLM que determinan el riesgo empresarial y las medidas prácticas que pueden adoptar los responsables de seguridad para gestionarlos.

Por qué son importantes los atributos LLM

La mayoría de los productos SaaS de IA incorporan LLM de terceros. Esto crea una doble dependencia. La aplicación puede superar todos los controles de seguridad, pero el modelo subyacente puede seguir exponiendo datos, generando código inseguro o filtrando flujos de trabajo confidenciales. Una visión clara de la capa LLM cierra esta brecha y adapta la gobernanza de la IA a las amenazas modernas.

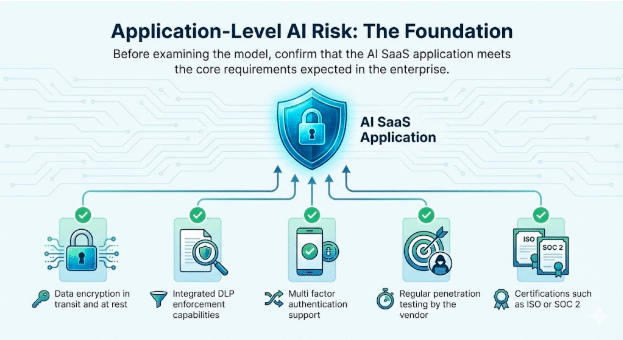

1. Riesgo de IA a nivel de aplicación: los fundamentos

Antes de examinar el modelo, confirme que la aplicación AI SaaS cumple con los requisitos básicos esperados en la empresa.

Atributos básicos para verificar

- Cifrado de datos en tránsito y en reposo

- Funciones integradas de aplicación de DLP

- Compatibilidad con autenticación multifactorial

- Pruebas de penetración periódicas realizadas por el proveedor.

- Certificaciones como ISO o SOC 2

Estas comprobaciones siguen siendo esenciales. Generan confianza en el propio servicio y sientan las bases para una implementación segura de la IA.

2. Comportamiento LLM: el origen de la nueva superficie de riesgo

Los atributos LLM influyen directamente en cómo responde la aplicación a usuarios reales y a indicaciones adversas. Los CISO ahora realizan un seguimiento de los siguientes comportamientos en todos los modelos integrados.

Integración de GenAI y LLM

Identifique el modelo exacto, la región de alojamiento, el patrón de actualización y si el proveedor lo ajusta utilizando los datos de los clientes.

Exposición al jailbreak

Los jailbreaks se producen cuando los usuarios manipulan las indicaciones para eludir los controles de seguridad de LLM. Las técnicas más habituales incluyen la simulación de roles, las instrucciones por capas, los marcos ficticios y el lenguaje indirecto o codificado. Dado que estas interacciones se asemejan al uso normal, a menudo eluden los controles básicos. El seguimiento de los intentos de jailbreak ayuda a los equipos de seguridad a detectar el uso indebido de forma temprana, reforzar las medidas de protección y demostrar una gobernanza proactiva durante las auditorías.

Ejemplo

- Un atacante convence a un chatbot para que le explique cómo desactivar la autenticación multifactorial (MFA) en una cuenta de cliente. Esto abre una vía directa al acceso a datos confidenciales y rompe la gobernanza de identidades dentro de un flujo de trabajo que parece legítimo.

Generación de malware y código malicioso

Los LLM a veces producen código que incorpora rutas de ejecución ocultas o rutinas de exfiltración.

Ejemplo

- Un ingeniero pega el código sugerido por la IA en un servicio interno. El código contiene una fuga de datos encubierta. Esto desencadena una violación no detectada porque la lógica parece válida.

Toxicidad, sesgo y riesgos de emisión CBRN

Los modelos pueden generar texto inseguro cuando se les presentan indicaciones sensibles o conflictivas. Realicen un seguimiento de estos comportamientos en las unidades de negocio en las que la seguridad, el cumplimiento normativo o el riesgo físico sean aspectos relevantes.

Ejemplos

- Toxicidad: un chatbot de asistencia interna responde a una queja de un cliente que se ha elevado con lenguaje abusivo o amenazante tras recibir indicaciones hostiles, lo que genera un riesgo para RR. HH. y la marca cuando se registra o se comparte la transcripción.

- Sesgo: un equipo de contratación utiliza un modelo LLM para clasificar a los candidatos, y el modelo degrada sistemáticamente los perfiles que contienen indicadores de género o casta, lo que expone a la organización a acusaciones de discriminación y a conclusiones de auditoría.

- Riesgos de salida CBRN: un usuario de I+D pregunta a un LLM sobre cómo mejorar un proceso químico, y el modelo devuelve una guía paso a paso que se ajusta a la síntesis química restringida, lo que crea una exposición a riesgos normativos y de seguridad física.

Alineación con las directrices LLM del NIST y OWASP

El NIST ha publicado un perfil de IA generativa que se está convirtiendo rápidamente en la base para la gestión responsable de los riesgos de la IA. Los equipos de seguridad y cumplimiento normativo esperan ahora que todas las aplicaciones basadas en LLM se ajusten claramente a estas expectativas.

Las empresas están haciendo preguntas directas.

- ¿Quién es responsable del uso que se hace de la IA y de sus resultados?

- ¿Qué casos de uso de LLM están explícitamente permitidos o prohibidos?

- Si los datos de entrenamiento y ajuste se declaran de forma transparente.

- Cómo se gestionan riesgos tales como la inyección inmediata, las alucinaciones y el acceso no autorizado a datos.

Cuando estas preguntas carecen de respuestas claras, la exposición a las auditorías aumenta considerablemente. En sectores regulados, como la sanidad y los servicios financieros, el desajuste con las directrices del NIST aumenta la probabilidad de fugas de datos, sanciones reglamentarias y auditorías fallidas.

Paralelamente, el Top 10 de OWASP para aplicaciones LLM documenta una nueva clase de vulnerabilidades que van más allá de las preocupaciones tradicionales en materia de seguridad de las aplicaciones. Entre ellas se incluyen la inyección de comandos, el manejo inseguro de los resultados, el envenenamiento de los datos de entrenamiento y las integraciones inseguras.

Hay incidentes reales que ya reflejan estos riesgos. En un caso, una aplicación SaaS permitía a los usuarios cargar documentos para su procesamiento mediante IA. Un atacante incrustó instrucciones ocultas dentro de un archivo, el modelo las ejecutó y se expusieron datos confidenciales de la empresa. Estas situaciones se están produciendo en entornos de producción reales, y las organizaciones que no las supervisan y mitigan de forma activa se enfrentan a riesgos de seguridad importantes.

Ejemplo

- Un modelo sin validación de salida filtra claves de administrador durante un intento de inyección de comandos. Esto compromete todo el sistema a pesar de los estrictos controles a nivel de aplicación.

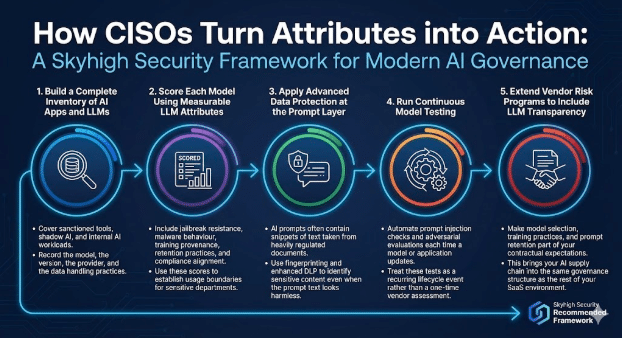

Cómo los CISO convierten estos atributos en acciones

Un programa moderno de gobernanza de la IA combina comprobaciones de aplicaciones con controles basados en modelos.

Skyhigh Security el siguiente marco.

1. Crear un inventario completo de aplicaciones de IA y LLM.

Cubra las herramientas autorizadas, la IA paralela y las cargas de trabajo internas de IA.

Registre el modelo, la versión, el proveedor y las prácticas de manejo de datos.

2. Califique cada modelo utilizando atributos LLM medibles.

Incluya resistencia al jailbreak, comportamiento de malware, procedencia de la formación, prácticas de retención y alineación con el cumplimiento normativo. Utilice estas puntuaciones para establecer límites de uso para los departamentos sensibles.

3. Aplique la protección de datos avanzada en la capa de solicitud.

Las indicaciones de IA suelen contener fragmentos de texto extraídos de documentos muy regulados. Utilice huellas digitales y DLP mejorado para identificar contenido confidencial, incluso cuando el texto de la sugerencia parezca inofensivo.

4. Ejecute pruebas continuas del modelo.

Automatice las comprobaciones de inyección rápida y las evaluaciones adversarias cada vez que se actualice un modelo o una aplicación. Trate estas pruebas como un evento recurrente del ciclo de vida en lugar de una evaluación puntual del proveedor.

5. Ampliar los programas de riesgo de proveedores para incluir la transparencia de LLM.

Incluya la selección de modelos, las prácticas de formación y la retención inmediata en sus expectativas contractuales. Esto hará que su cadena de suministro de IA se integre en la misma estructura de gobernanza que el resto de su entorno SaaS.

El camino por recorrer

Los LLM están transformando la forma en que las empresas utilizan la IA y la forma en que los CISO evalúan los riesgos.

En la gobernanza tradicional de aplicaciones, los equipos de seguridad separan dos cuestiones. La aplicación debe cumplir con los estándares empresariales en materia de control de acceso, protección de datos, registro y cumplimiento normativo. Por otra parte, la plataforma subyacente debe cumplir con las expectativas de fiabilidad, seguridad y funcionamiento.

Los LLM introducen la misma responsabilidad de dos niveles, con mayores riesgos.

- En la capa de aplicaciones, las organizaciones deben controlar cómo se exponen las funciones de IA a los usuarios. Esto incluye quién puede acceder a la capacidad, qué datos se pueden enviar, cómo se comparten los resultados y cómo se registra la actividad para su auditoría e investigación. Estos controles reflejan prácticas de seguridad de aplicaciones conocidas, ampliadas a flujos de trabajo impulsados por IA.

- En la capa del modelo, los CISO deben evaluar cómo se comporta el LLM en condiciones reales. Esto incluye cómo gestiona el modelo las indicaciones sensibles, si produce resultados inseguros o sesgados, cómo conserva o reutiliza los datos y cuál es su resistencia al abuso, como la inyección de indicaciones o el envenenamiento de datos. Estos comportamientos quedan fuera de las pruebas tradicionales de aplicaciones y requieren una gobernanza explícita.

El seguimiento de atributos de LLM como el uso de datos, el comportamiento de seguridad, la cobertura de barreras de protección y los patrones de fallo proporciona a los responsables de seguridad la misma confianza que esperan de los programas de aplicación maduros. Con esta visibilidad, los CISO pueden apoyar una adopción más amplia de la IA al tiempo que mantienen la seguridad, la privacidad y los compromisos normativos en toda la empresa.

Sobre el autor

Sarang Warudkar

Gerente técnico sénior de marketing de productos

Sarang Warudkar es un experimentado director de marketing de productos con más de 10 años de experiencia en ciberseguridad, experto en alinear la innovación técnica con las necesidades del mercado. Aporta una profunda experiencia en soluciones como CASB, DLP y detección de amenazas basada en IA, impulsando estrategias de salida al mercado impactantes y el compromiso de los clientes. Sarang posee un MBA por el IIM de Bangalore y una licenciatura en ingeniería por la Universidad de Pune, combinando una visión técnica y estratégica.

Contenido relacionado

De los requisitos de la DPDPA a la visibilidad de los datos: la importancia del DSPM

Skyhigh Security 2025: control más preciso, visibilidad más clara y acción más rápida en datos, web y nube.

Blogs de moda

Atributos LLM que todo CISO debería seguir hoy en día

Sarang Warudkar 18 de febrero de 2026

De los requisitos de la DPDPA a la visibilidad de los datos: la importancia del DSPM

Niharika Ray y Sarang Warudkar 12 de febrero de 2026

Skyhigh Security 2025: control más preciso, visibilidad más clara y acción más rápida en datos, web y nube.

Thyaga Vasudevan 21 de enero de 2026

El riesgo oculto de la IA generativa que podría costarle millones a su empresa (y cómo solucionarlo hoy mismo)

Jesse Grindeland 18 de diciembre de 2025

Skyhigh Security : 2026 es el año en que la IA impondrá un nuevo modelo de seguridad empresarial

Thyaga Vasudevan 12 de diciembre de 2025