Ressourcen

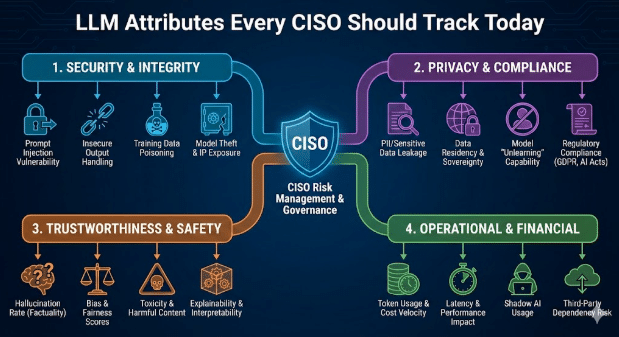

LLM-Attribute, die jeder CISO heute im Blick behalten sollte

Von Sarang Warudkar - Sr. technischer PMM (CASB & AI)

18. Februar 2026 5 Minuten Lesezeit

KI-Tools beeinflussen mittlerweile die tägliche Arbeit in den Bereichen Schreiben, Analyse, Automatisierung von Besprechungen und Softwareentwicklung. Diese rasante Verbreitung führt zu erheblichen Produktivitätssteigerungen, bringt jedoch auch neue Sicherheitsrisiken mit sich, die durch das Verhalten großer Sprachmodelle (LLMs) bedingt sind. Herkömmliche SaaS-Prüfungen reichen nicht mehr aus. CISOs bewerten nun die Anwendung und das dahinterstehende Modell mit gleicher Sorgfalt.

Dieser Blogbeitrag beschreibt die LLM-Attribute, die das Unternehmensrisiko beeinflussen, sowie die praktischen Maßnahmen, mit denen Sicherheitsverantwortliche diese steuern können.

Warum LLM-Attribute von Bedeutung sind

Die meisten KI-SaaS-Produkte integrieren LLMs von Drittanbietern. Dies führt zu einer doppelten Abhängigkeit. Die Anwendung kann zwar alle Sicherheitsprüfungen bestehen, aber das zugrunde liegende Modell kann dennoch Daten offenlegen, unsicheren Code erzeugen oder sensible Arbeitsabläufe preisgeben. Ein klarer Überblick über die LLM-Ebene schließt diese Lücke und passt die KI-Governance an moderne Bedrohungen an.

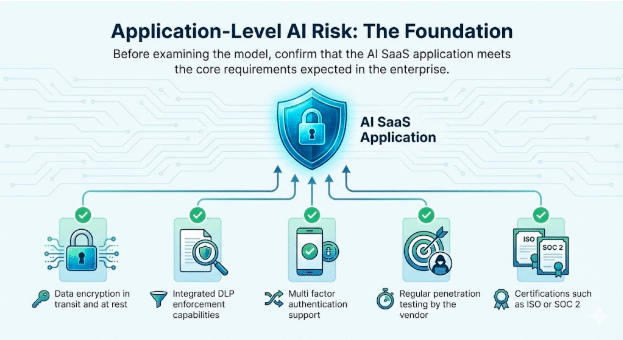

1. KI-Risiko auf Anwendungsebene: Die Grundlage

Bevor Sie das Modell untersuchen, vergewissern Sie sich, dass die KI-SaaS-Anwendung die grundlegenden Anforderungen erfüllt, die im Unternehmen erwartet werden.

Zu überprüfende Basisattribute

- Datenverschlüsselung während der Übertragung und im Ruhezustand

- Integrierte DLP-Durchsetzungsfunktionen

- Unterstützung für Multi-Faktor-Authentifizierung

- Regelmäßige Penetrationstests durch den Anbieter

- Zertifizierungen wie ISO oder SOC 2

Diese Kontrollen sind weiterhin unerlässlich. Sie schaffen Vertrauen in den Dienst selbst und bilden die Grundlage für eine sichere Einführung der KI.

2. LLM-Verhalten: Die Quelle der neuen Risikooberfläche

LLM-Attribute beeinflussen direkt, wie die Anwendung auf echte Benutzer und feindliche Eingaben reagiert. CISOs verfolgen nun die folgenden Verhaltensweisen in jedem eingebetteten Modell.

Integration von GenAI und LLM

Identifizieren Sie das genaue Modell, die Hosting-Region, das Aktualisierungsmuster und ob der Anbieter es anhand von Kundendaten optimiert.

Gefängnisausbruch

Jailbreaks treten auf, wenn Benutzer Eingabeaufforderungen manipulieren, um die Sicherheitskontrollen von LLM zu umgehen. Zu den gängigen Techniken gehören Rollenspiele, mehrschichtige Anweisungen, fiktionale Darstellungen und indirekte oder verschlüsselte Sprache. Da diese Interaktionen einer normalen Nutzung ähneln, umgehen sie häufig grundlegende Kontrollen. Die Verfolgung von Jailbreak-Versuchen hilft Sicherheitsteams, Missbrauch frühzeitig zu erkennen, Schutzmaßnahmen zu verstärken und bei Audits proaktives Governance zu demonstrieren.

Beispiel

- Ein Angreifer überredet einen Chatbot, zu erklären, wie man die Multi-Faktor-Authentifizierung (MFA) für ein Kundenkonto deaktiviert. Dadurch wird ein direkter Zugang zu sensiblen Daten ermöglicht und die Identitätsverwaltung innerhalb eines scheinbar legitimen Arbeitsablaufs unterlaufen.

Erstellung von Malware und schädlichem Code

LLMs erzeugen gelegentlich Code, der versteckte Ausführungspfade oder Exfiltrationsroutinen enthält.

Beispiel

- Ein Ingenieur fügt einen von KI vorgeschlagenen Code in einen internen Dienst ein. Der Code enthält eine versteckte Datenlücke. Dies führt zu einer unentdeckten Sicherheitsverletzung, da die Logik gültig erscheint.

Toxizität, Verzerrung und CBRN-Ausgangsrisiken

Modelle können unsichere Texte generieren, wenn sie mit sensiblen oder feindseligen Eingaben konfrontiert werden. Bitte verfolgen Sie diese Verhaltensweisen für Geschäftsbereiche, in denen Sicherheit, Compliance oder physische Risiken eine Rolle spielen.

Beispiele

- Toxizität: Ein interner Support-Chatbot reagiert auf eine eskalierte Kundenbeschwerde mit beleidigenden oder bedrohlichen Äußerungen, nachdem er mit feindseligen Eingaben gefüttert wurde. Dies stellt ein Risiko für die Personalabteilung und die Marke dar, wenn das Protokoll gespeichert oder weitergegeben wird.

- Voreingenommenheit: Ein Einstellungsteam verwendet ein LLM, um Bewerber zu bewerten, und das Modell stuft Profile, die Indikatoren für Geschlecht oder Kaste enthalten, durchweg herab, wodurch das Unternehmen Diskriminierung und Prüfungsfeststellungen ausgesetzt ist.

- CBRN-Ausgangsrisiken: Ein F&E-Anwender befragt ein LLM zur Verbesserung eines chemischen Prozesses, und das Modell gibt eine schrittweise Anleitung zurück, die mit der eingeschränkten chemischen Synthese übereinstimmt, wodurch regulatorische und physikalische Sicherheitsrisiken entstehen.

Übereinstimmung mit den NIST- und OWASP-LLM-Richtlinien

Das NIST hat ein Generative AI Profile veröffentlicht, das sich rasch zur Grundlage für ein verantwortungsbewusstes KI-Risikomanagement entwickelt. Sicherheits- und Compliance-Teams erwarten nun, dass jede LLM-basierte Anwendung diese Erwartungen klar erfüllt.

Unternehmen stellen direkte Fragen.

- Wer ist für die Verwendung der KI und deren Ergebnisse verantwortlich?

- Welche LLM-Anwendungsfälle sind ausdrücklich erlaubt oder verboten?

- Ob Trainings- und Feinabstimmungsdaten transparent deklariert werden

- Wie mit Risiken wie sofortiger Injektion, Halluzinationen und unbefugtem Datenzugriff umgegangen wird

Wenn diese Fragen nicht eindeutig beantwortet werden können, steigt das Audit-Risiko erheblich. In regulierten Branchen wie dem Gesundheitswesen und dem Finanzdienstleistungssektor erhöht eine Nichtübereinstimmung mit den NIST-Richtlinien die Wahrscheinlichkeit von Datenlecks, behördlichen Strafen und nicht bestandenen Audits.

Parallel dazu dokumentiert die OWASP Top 10 für LLM-Anwendungen eine neue Klasse von Schwachstellen, die über die traditionellen Sicherheitsbedenken bei Anwendungen hinausgehen. Dazu gehören Prompt-Injection, unsichere Ausgabeverarbeitung, Training Data Poisoning und unsichere Integrationen.

Diese Risiken spiegeln sich bereits in realen Vorfällen wider. In einem Fall ermöglichte eine SaaS-Anwendung Benutzern das Hochladen von Dokumenten zur Verarbeitung durch künstliche Intelligenz. Ein Angreifer bettete versteckte Anweisungen in eine Datei ein, das Modell führte diese aus, und sensible Unternehmensdaten wurden offengelegt. Solche Szenarien treten in Live-Produktionsumgebungen auf, und Unternehmen, die sie nicht aktiv verfolgen und entschärfen, sind erheblichen Sicherheitsrisiken ausgesetzt.

Beispiel

- Ein Modell ohne Ausgabevalidierung gibt bei einem Prompt-Injection-Versuch Admin-Schlüssel preis. Dies führt trotz strenger Kontrollen auf Anwendungsebene zu einer systemweiten Kompromittierung.

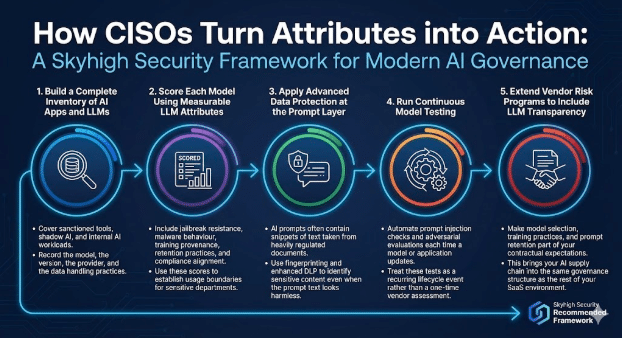

Wie CISOs diese Eigenschaften in die Praxis umsetzen

Ein modernes KI-Governance-Programm kombiniert Anwendungsprüfungen mit modellorientierten Kontrollen.

Skyhigh Security das folgende Framework.

1. Erstellen Sie ein vollständiges Verzeichnis von KI-Anwendungen und LLMs.

Bitte berücksichtigen Sie genehmigte Tools, Schatten-KI und interne KI-Workloads.

Dokumentieren Sie das Modell, die Version, den Anbieter und die Datenverarbeitungsverfahren.

2. Bewerten Sie jedes Modell anhand messbarer LLM-Attribute.

Beziehen Sie Jailbreak-Resistenz, Malware-Verhalten, Herkunft der Schulungen, Aufbewahrungspraktiken und Compliance-Anpassung mit ein. Verwenden Sie diese Bewertungen, um Nutzungsgrenzen für sensible Abteilungen festzulegen.

3. Erweitert

KI-Eingabeaufforderungen enthalten häufig Textausschnitte aus streng regulierten Dokumenten. Nutzen Sie Fingerprinting und erweiterte DLP-Funktionen, um sensible Inhalte zu identifizieren, auch wenn der Eingabeaufforderungstext harmlos erscheint.

4. Kontinuierliche Modellprüfung durchführen

Automatisieren Sie bei jeder Aktualisierung eines Modells oder einer Anwendung umgehende Injektionsprüfungen und gegnerische Bewertungen. Behandeln Sie diese Tests als wiederkehrendes Ereignis im Lebenszyklus und nicht als einmalige Lieferantenbewertung.

5. Erweiterung der Lieferantenrisikoprogramme um LLM-Transparenz

Integrieren Sie die Modellauswahl, Schulungsmaßnahmen und die sofortige Speicherung in Ihre vertraglichen Erwartungen. Dadurch wird Ihre KI-Lieferkette in dieselbe Governance-Struktur wie der Rest Ihrer SaaS-Umgebung integriert.

Der Weg nach vorn

LLMs verändern die Art und Weise, wie Unternehmen KI einsetzen, und sie verändern die Art und Weise, wie CISOs Risiken bewerten.

In der traditionellen Anwendungs-Governance trennen Sicherheitsteams zwei Aspekte voneinander. Die Anwendung muss die Unternehmensstandards für Zugriffskontrolle, Datenschutz, Protokollierung und Compliance erfüllen. Unabhängig davon muss die zugrunde liegende Plattform die Erwartungen hinsichtlich Zuverlässigkeit, Sicherheit und Betrieb erfüllen.

LLMs führen dieselbe zweistufige Verantwortung ein, jedoch mit höheren Risiken.

- Auf der Anwendungsebene müssen Unternehmen regeln, wie KI-Funktionen den Benutzern zugänglich gemacht werden. Dazu gehört, wer auf die Funktionen zugreifen darf, welche Daten übermittelt werden können, wie die Ergebnisse weitergegeben werden und wie Aktivitäten für Audits und Untersuchungen protokolliert werden. Diese Kontrollen spiegeln bekannte Anwendungssicherheitspraktiken wider, die auf KI-gesteuerte Arbeitsabläufe ausgeweitet wurden.

- Auf der Modellebene müssen CISOs beurteilen, wie sich das LLM unter realen Bedingungen verhält. Dazu gehört, wie das Modell mit sensiblen Eingaben umgeht, ob es unsichere oder voreingenommene Ergebnisse liefert, wie es Daten speichert oder wiederverwendet und wie widerstandsfähig es gegenüber Missbrauch wie Eingabeinjektionen oder Datenvergiftung ist. Diese Verhaltensweisen liegen außerhalb des traditionellen App-Testens und erfordern eine explizite Governance.

Durch die Nachverfolgung von LLM-Attributen wie Datennutzung, Sicherheitsverhalten, Guardrail-Abdeckung und Fehlermustern erhalten Sicherheitsverantwortliche das gleiche Vertrauen, das sie von ausgereiften Anwendungsprogrammen erwarten. Mit dieser Transparenz können CISOs eine breitere Einführung von KI unterstützen und gleichzeitig die Sicherheit, den Datenschutz und die Einhaltung gesetzlicher Vorschriften im gesamten Unternehmen gewährleisten.

Über den Autor

Sarang Warudkar

Senior Technischer Produktmanager

Sarang Warudkar ist ein erfahrener Produktmarketing-Manager mit mehr als 10 Jahren Erfahrung im Bereich Cybersicherheit, der es versteht, technische Innovationen mit den Marktanforderungen in Einklang zu bringen. Er verfügt über umfassende Erfahrung mit Lösungen wie CASB, DLP und KI-gestützter Erkennung von Bedrohungen und treibt wirkungsvolle Strategien zur Markteinführung und Kundenbindung voran. Sarang hat einen MBA vom IIM Bangalore und einen Abschluss als Ingenieur von der Universität Pune und kombiniert technische und strategische Kenntnisse.

Verwandter Inhalt

Von den DPDPA-Anforderungen bis zur Datentransparenz: Die Notwendigkeit von DSPM

Laufende Blogs

LLM-Attribute, die jeder CISO heute im Blick behalten sollte

Sarang Warudkar 18. Februar 2026

Von den DPDPA-Anforderungen bis zur Datentransparenz: Die Notwendigkeit von DSPM

Niharika Ray und Sarang Warudkar 12. Februar 2026

Skyhigh Security 2025: Präzisere Kontrolle, klarere Transparenz und schnellere Maßnahmen für Daten, Web und Cloud

Thyaga Vasudevan 21. Januar 2026

Das versteckte Risiko von GenAI, das Ihr Unternehmen Millionen kosten könnte (und wie Sie es heute beheben können)

Jesse Grindeland 18. Dezember 2025

Skyhigh Security : 2026 ist das Jahr, in dem künstliche Intelligenz einen neuen Entwurf für die Unternehmenssicherheit vorantreibt.

Thyaga Vasudevan 12. Dezember 2025