Sumber daya

AI Dasar: Lapisan Kritis dengan Tantangan Keamanan

Oleh Sekhar Sarukkai - Cybersecurity@UC Berkeley

10 Oktober 2024 5 Menit Baca

Dalam blog pertama dalam seri kami, "Keamanan AI: Kebutuhan dan Peluang Pelanggan," kami memberikan gambaran umum tentang tiga lapisan tumpukan teknologi AI dan kasus penggunaannya, bersama dengan ringkasan tantangan dan solusi keamanan AI. Dalam blog kedua ini, kami membahas risiko spesifik yang terkait dengan Lapisan 1: AI Dasar dan mitigasi yang dapat membantu organisasi memanfaatkan banyak manfaat AI untuk keuntungan bisnis mereka.

Seiring dengan kecerdasan buatan (AI) yang terus berevolusi dan membangun pijakan, aplikasinya menjangkau berbagai industri mulai dari perawatan kesehatan hingga keuangan. Inti dari setiap sistem AI adalah model dasar dan infrastruktur perangkat lunak untuk menyesuaikan model-model tersebut. Lapisan ini menyediakan dasar untuk semua aplikasi AI, memungkinkan sistem untuk belajar dari data, mendeteksi pola, dan membuat prediksi. Namun, meskipun penting, Lapisan AI Dasar bukannya tanpa risiko. Mulai dari serangan rekayasa yang cepat, kesalahan konfigurasi, hingga kebocoran data, tantangan keamanan pada lapisan ini dapat memiliki konsekuensi yang luas.

Mari kita bahas lebih dalam tentang risiko keamanan yang terkait dengan Foundational AI dan apa yang perlu diperhatikan oleh bisnis saat mereka mengadopsi solusi berbasis AI.

Risiko Keamanan di Lapisan AI Dasar

1. Serangan Rekayasa yang Cepat

Salah satu risiko yang paling umum terjadi pada lapisan AI Dasar adalah rekayasa permintaan, di mana penyerang memanipulasi input AI untuk menghasilkan output yang tidak diinginkan atau berbahaya. Serangan ini mengeksploitasi kerentanan dalam cara model AI menafsirkan dan merespons perintah, sehingga memungkinkan pelaku jahat untuk menghindari protokol keamanan.

Teknik-teknik baru seperti SkeletonKey dan CrescendoMation telah membuat rekayasa cepat menjadi ancaman yang terus meningkat, dengan berbagai bentuk "jailbreaking" sistem AI menjadi hal yang biasa. Serangan-serangan ini dapat ditemukan di web gelap, dengan alat-alat seperti WormGPT, FraudGPT, dan EscapeGPT yang dijual secara terbuka kepada para peretas. Setelah model AI disusupi, model tersebut dapat menghasilkan respons yang menyesatkan atau berbahaya, yang menyebabkan pelanggaran data atau kegagalan sistem.

Sebagai contoh, penyerang dapat menyuntikkan perintah ke dalam sistem AI layanan pelanggan, melewati batasan model untuk mengakses data pelanggan yang sensitif atau memanipulasi keluaran untuk menyebabkan gangguan operasional.

Untuk memitigasi risiko ini, organisasi harus menerapkan mekanisme validasi input yang kuat dan secara teratur mengaudit sistem AI untuk mengetahui potensi kerentanan, terutama saat perintah digunakan untuk mengontrol proses bisnis yang signifikan.

2. Kebocoran Data

Kebocoran data adalah masalah signifikan lainnya pada lapisan AI Dasar. Ketika organisasi menggunakan model AI untuk tugas-tugas seperti menghasilkan wawasan dari data sensitif, ada risiko bahwa beberapa informasi ini mungkin tidak sengaja terekspos selama interaksi AI. Hal ini terutama terjadi pada penyempurnaan model atau selama percakapan yang diperpanjang dengan LLM (Large Language Models).

Contoh penting terjadi ketika teknisi Samsung secara tidak sengaja membocorkan data perusahaan yang sensitif melalui interaksi dengan ChatGPT. Insiden semacam itu menggarisbawahi pentingnya memperlakukan data yang cepat sebagai data nonpribadi secara default, karena data tersebut dapat dengan mudah dimasukkan ke dalam data pelatihan AI. Meskipun kami melihat kemajuan yang terus berlanjut untuk perlindungan privasi di lapisan model dasar, Anda masih perlu memilih keluar untuk memastikan bahwa tidak ada data prompt yang masuk ke dalam model.

Selain itu, cara eksfiltrasi data yang dieksploitasi secara historis dapat lebih mudah digunakan dalam konteks percakapan yang sudah berjalan lama dengan LLM. Menyadari masalah seperti eksploitasi penurunan gambar di chatbot Bing dan juga ChatGPT juga perlu diatasi, terutama dengan penerapan LLM secara pribadi.

Teknik eksfiltrasi data yang secara historis menargetkan sistem tradisional juga diadaptasi untuk lingkungan AI. Sebagai contoh, interaksi chatbot yang sudah berjalan lama dapat dieksploitasi oleh penyerang dengan menggunakan taktik seperti eksploitasi penurunan nilai gambar (seperti yang terlihat pada ChatGPT) untuk mengekstrak data sensitif secara diam-diam dari waktu ke waktu.

Organisasi dapat mengatasi risiko ini dengan mengadopsi kebijakan penanganan data yang ketat dan menerapkan kontrol untuk memastikan bahwa informasi sensitif tidak terekspos secara tidak sengaja melalui model AI.

3. Instance yang Salah Konfigurasi

Kesalahan konfigurasi adalah sumber umum kerentanan keamanan, dan ini terutama terjadi pada lapisan AI Dasar. Mengingat penyebaran sistem AI yang cepat, banyak organisasi berjuang untuk mengonfigurasi lingkungan AI mereka dengan benar, sehingga modelnya terpapar potensi ancaman.

Contoh AI yang tidak dikonfigurasi dengan benar-seperti mengizinkan plugin pihak ketiga yang tidak tepercaya, memungkinkan integrasi data eksternal tanpa kontrol yang tepat, atau memberikan izin yang berlebihan pada model AI-dapat mengakibatkan pelanggaran data yang signifikan. Dalam model tanggung jawab bersama, organisasi juga dapat gagal menerapkan pembatasan yang diperlukan, sehingga meningkatkan risiko akses yang tidak sah atau eksfiltrasi data.

Sebagai contoh, ChatGPT memungkinkan pengaya untuk berintegrasi dengan layanan pihak ketiga, yang dapat menjadi sumber utama kebocoran data jika pengaya yang tidak tepercaya secara tidak sengaja terhubung ke instance perusahaan. Demikian pula, konfigurasi kontrol akses yang tidak tepat dapat menyebabkan pengguna yang tidak berwenang mendapatkan akses ke data sensitif melalui sistem AI.

Meskipun red teaming bukanlah konsep baru, namun hal ini sangat penting di seluruh lapisan tumpukan AI karena LLM bertindak sebagai kotak hitam dan keluarannya tidak dapat diprediksi. Sebagai contoh, penelitian dari Anthropic, menunjukkan bahwa LLM dapat berubah menjadi agen tidur dengan serangan yang tersembunyi di dalam bobot model yang dapat muncul secara tidak terduga.

Untuk mengurangi risiko ini, organisasi harus mengikuti praktik terbaik untuk konfigurasi AI dengan membatasi integrasi layanan pihak ketiga, membatasi izin, dan secara teratur meninjau konfigurasi lingkungan AI. Skyhigh SecurityPenggunaan solusi aplikasi AI yang aman menyediakan alat dan praktik terbaik untuk memastikan sistem AI terkonfigurasi dan terlindungi dengan baik.

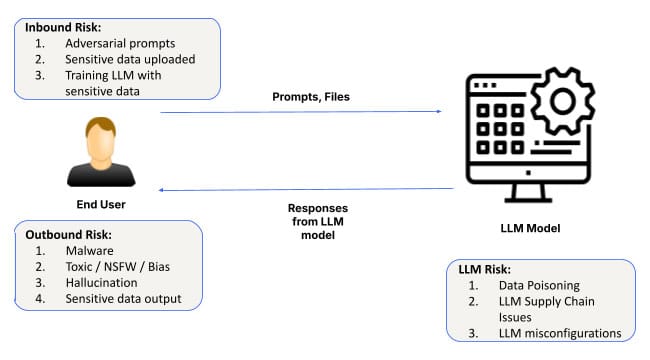

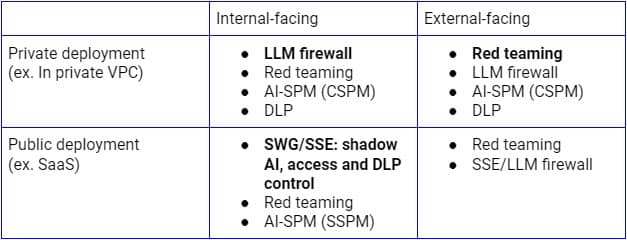

Memperkuat Keamanan AI di Lapisan 1

Risiko keamanan di atas perlu ditangani berdasarkan kasus penggunaan yang berbeda. Untuk penerapan LLM publik yang menghadap ke internal, Secure Service Edge (SSE forward proxy) adalah platform logis untuk memperluas kontrol ke aplikasi AI SaaS karena perusahaan sudah menggunakannya untuk menemukan, mengontrol akses, dan melindungi data ke semua aplikasi dan layanan SaaS. Di sisi lain, untuk penerapan pada infrastruktur privat, firewall LLM yang merupakan kombinasi dari SSE reverse proxy (atau melalui API LLM) dan pagar pembatas AI akan menjadi paradigma yang tepat untuk mencapai keamanan Zero Trust. Terlepas dari model penerapannya, penemuan yang berkelanjutan, red teaming, dan audit konfigurasi juga akan sangat penting.

Gambar di atas mengilustrasikan arsitektur yang komprehensif untuk mengamankan penggunaan LLM dari dalam perusahaan atau pengguna dan perangkat tepercaya. Pendekatan serupa untuk pelanggan dan perangkat yang tidak dikelola terutama akan berfokus pada aliran bawah, yang hanya mencakup proxy balik.

Mengatasi risiko keamanan ini sejak dini dalam penerapan AI Dasar sangat penting untuk memastikan keberhasilan dan keamanan sistem AI. Untuk memperkuat keamanan AI pada lapisan dasar ini, organisasi harus:

- Lakukan audit secara teratur: Pastikan bahwa sistem AI ditinjau secara teratur untuk mengetahui kerentanan injeksi yang cepat, kesalahan konfigurasi, dan masalah penanganan data.

- Menerapkan validasi masukan: Gunakan mekanisme yang kuat untuk memvalidasi permintaan dan masukan, sehingga mengurangi risiko serangan rekayasa.

- Menerapkan langkah-langkah perlindungan data: Menetapkan kerangka kerja tata kelola data yang kuat untuk meminimalkan risiko kebocoran data selama interaksi dengan AI.

- Mengamankan lingkungan AI: Ikuti praktik terbaik untuk mengonfigurasi sistem AI, terutama saat mengintegrasikan plugin atau layanan pihak ketiga.

Jalan ke Depan: Mengamankan AI dari Bawah ke Atas

AI dasar berfungsi sebagai tulang punggung bagi banyak aplikasi AI tingkat lanjut, tetapi juga menimbulkan risiko keamanan yang signifikan, termasuk serangan rekayasa yang cepat, kebocoran data, dan kesalahan konfigurasi. Karena AI terus memainkan peran penting dalam mendorong inovasi di seluruh industri, bisnis harus memprioritaskan keamanan sejak awal-mulai dari lapisan dasar ini.

Blog berikutnya dalam seri kami akan mengeksplorasi kebutuhan dan peluang keamanan yang terkait dengan Layer 2: AI Copilots, asisten virtual, dan alat produktivitas yang dapat membantu memandu pengambilan keputusan dan mengotomatiskan berbagai macam tugas. Untuk mempelajari lebih lanjut tentang mengamankan aplikasi AI Anda dan memitigasi risiko, jelajahi solusi Skyhigh AI.

Blog Lain Dalam Seri Ini:

- Bagian 1 - Keamanan AI: Kebutuhan dan Peluang Pelanggan

- Bagian 2 - AI Dasar: Lapisan Kritis dengan Tantangan Keamanan

- Bagian 3 - Risiko dan Tantangan Keamanan dengan Kopilot AI

Konten Terkait

Blog yang sedang tren

Atribut LLM yang Harus Dipantau oleh Setiap CISO Saat Ini

Sarang Warudkar 18 Februari 2026

Dari Persyaratan DPDPA hingga Visibilitas Data: Kebutuhan Mendesak DSPM

Niharika Ray dan Sarang Warudkar 12 Februari 2026

Skyhigh Security 2025: Pengendalian yang lebih ketat, visibilitas yang lebih jelas, dan tindakan yang lebih cepat di seluruh data, web, dan cloud.

Thyaga Vasudevan 21 Januari 2026

Risiko Tersembunyi GenAI yang Bisa Mengakibatkan Kerugian Jutaan Dolar bagi Perusahaan Anda (Dan Cara Mengatasinya Hari Ini)

Jesse Grindeland 18 Desember 2025

Skyhigh Security : 2026 Adalah Tahun di Mana Kecerdasan Buatan (AI) Memaksa Terciptanya Rencana Baru untuk Keamanan Perusahaan

Thyaga Vasudevan 12 Desember 2025