Di Sekhar Sarukkai - Cybersecurity@UC Berkeley

10 ottobre 2024 5 Minuti di lettura

Nel primo blog della nostra serie, "Sicurezza AI: Esigenze e opportunità per i clienti", abbiamo fornito una panoramica dei tre livelli dello stack tecnologico dell'IA e dei loro casi d'uso, insieme a una sintesi delle sfide e delle soluzioni per la sicurezza dell'IA. In questo secondo blog, affrontiamo i rischi specifici associati al livello 1: AI fondamentale e le mitigazioni che possono aiutare le organizzazioni a sfruttare i numerosi benefici dell'AI a loro vantaggio commerciale.

Mentre l'intelligenza artificiale (AI) continua ad evolversi e a prendere piede, le sue applicazioni abbracciano settori che vanno dalla sanità alla finanza. Al centro di ogni sistema di AI ci sono i modelli fondamentali e l'infrastruttura software per personalizzare tali modelli. Questo livello fornisce le basi per tutte le applicazioni di AI, consentendo ai sistemi di apprendere dai dati, rilevare modelli e fare previsioni. Tuttavia, nonostante la sua importanza, il livello AI fondamentale non è privo di rischi. Dagli attacchi di prompt engineering, alle configurazioni errate, alla perdita di dati, le sfide di sicurezza a questo livello possono avere conseguenze di vasta portata.

Facciamo un'immersione profonda nei rischi di sicurezza associati all'Intelligenza Artificiale Fondata e a cosa devono prestare attenzione le aziende che adottano soluzioni guidate dall'Intelligenza Artificiale.

Rischi di sicurezza al livello AI fondamentale

1. Attacchi ingegneristici tempestivi

Uno dei rischi più diffusi al livello Foundational AI è il prompt engineering, in cui gli aggressori manipolano gli input dell'AI per produrre output indesiderati o dannosi. Questi attacchi sfruttano le vulnerabilità nel modo in cui i modelli di AI interpretano e rispondono ai prompt, consentendo agli attori malintenzionati di aggirare i protocolli di sicurezza.

Nuove tecniche come SkeletonKey e CrescendoMation hanno reso il prompt engineering una minaccia crescente, con varie forme di "jailbreak" dei sistemi AI che stanno diventando comuni. Questi attacchi si possono trovare sul dark web, con strumenti come WormGPT, FraudGPT e EscapeGPT venduti apertamente agli hacker. Una volta che un modello di AI è compromesso, può generare risposte fuorvianti o pericolose, portando a violazioni dei dati o a guasti del sistema.

Ad esempio, un aggressore potrebbe iniettare dei prompt in un sistema di intelligenza artificiale del servizio clienti, aggirando i vincoli del modello per accedere ai dati sensibili dei clienti o manipolare i risultati per causare un'interruzione operativa.

Per mitigare questo rischio, le organizzazioni devono implementare solidi meccanismi di convalida degli input e verificare regolarmente i sistemi di IA per individuare potenziali vulnerabilità, soprattutto quando i prompt sono utilizzati per controllare processi aziendali significativi.

2. Perdita di dati

La fuga di dati è un'altra preoccupazione significativa al livello Foundational AI. Quando le organizzazioni utilizzano i modelli di AI per compiti come la generazione di approfondimenti da dati sensibili, c'è il rischio che alcune di queste informazioni possano essere inavvertitamente esposte durante le interazioni con l'AI. Ciò è particolarmente vero nella messa a punto del modello o durante le conversazioni prolungate con gli LLM (Large Language Models).

Un esempio notevole si è verificato quando gli ingegneri di Samsung hanno accidentalmente divulgato dati aziendali sensibili attraverso le interazioni con ChatGPT. Questi incidenti sottolineano l'importanza di trattare i dati di richiesta come non privati per impostazione predefinita, in quanto potrebbero essere facilmente incorporati nei dati di addestramento dell'AI. Anche se vediamo continui progressi per la protezione della privacy nel livello del modello di base, sarà comunque necessario fare l 'opt-out per assicurarsi che i dati prompt non entrino nel modello.

Inoltre, le modalità storicamente sfruttate di esfiltrazione dei dati potrebbero essere più facilmente impiegate nel contesto di una conversazione di lunga durata con gli LLM. Occorrerà anche essere consapevoli di problemi come l'exploit del markdown delle immagini nel chatbot di Bing e di ChatGPT, soprattutto con le implementazioni private di LLM.

Le tecniche di esfiltrazione dei dati che storicamente hanno preso di mira i sistemi tradizionali vengono adattate anche agli ambienti AI. Ad esempio, le interazioni di chatbot di lunga durata potrebbero essere sfruttate da aggressori che utilizzano tattiche come gli exploit di image markdown (come visto in ChatGPT) per estrarre furtivamente dati sensibili nel tempo.

Le organizzazioni possono affrontare questo rischio adottando politiche di gestione dei dati rigorose e implementando controlli per garantire che le informazioni sensibili non vengano inavvertitamente esposte attraverso i modelli di AI.

3. Istanze mal configurate

Le configurazioni errate sono una fonte comune di vulnerabilità della sicurezza, e questo è particolarmente vero nel livello Foundational AI. Data la rapida diffusione dei sistemi di AI, molte organizzazioni faticano a configurare correttamente i loro ambienti di AI, lasciando i modelli esposti a potenziali minacce.

Le istanze di AI configurate in modo errato, ad esempio consentendo plugin di terze parti non attendibili, abilitando l'integrazione di dati esterni senza controlli adeguati o concedendo autorizzazioni eccessive ai modelli di AI, possono causare violazioni significative dei dati. Nei modelli di responsabilità condivisa, le organizzazioni possono anche non implementare le restrizioni necessarie, aumentando il rischio di accesso non autorizzato o di esfiltrazione dei dati.

Ad esempio, ChatGPT consente ai plugin di integrarsi con servizi di terze parti, che possono essere una fonte importante di fughe di dati se i plugin non affidabili vengono inavvertitamente collegati alle istanze aziendali. Allo stesso modo, configurazioni improprie del controllo degli accessi possono portare gli utenti non autorizzati ad accedere a dati sensibili attraverso i sistemi AI.

Sebbene il red teaming non sia un concetto nuovo, è particolarmente importante in tutti i livelli dello stack AI, poiché gli LLM agiscono come scatole nere e i loro risultati non sono prevedibili. Ad esempio, la ricerca di Anthropic ha dimostrato che gli LLM potrebbero trasformarsi in agenti dormienti con attacchi nascosti nei pesi del modello che potrebbero emergere inaspettatamente.

Per ridurre questo rischio, le organizzazioni dovrebbero seguire le best practice per la configurazione dell'AI, limitando l'integrazione di servizi di terze parti, limitando le autorizzazioni e rivedendo regolarmente le configurazioni dell'ambiente AI. Skyhigh SecurityLe soluzioni per l'uso sicuro delle applicazioni di AI forniscono gli strumenti e le best practice per garantire che i sistemi di AI siano configurati e protetti correttamente.

Rafforzare la sicurezza dell'intelligenza artificiale al livello 1

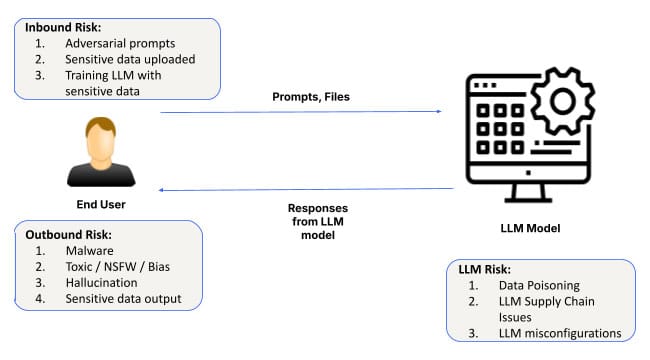

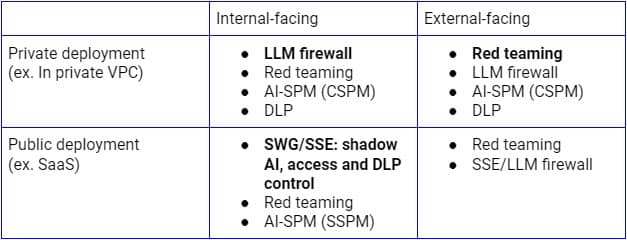

I rischi di sicurezza di cui sopra devono essere affrontati in base ai diversi casi d'uso. Per le implementazioni pubbliche di LLM rivolte all'interno, Secure Service Edge (SSE forward proxy) è la piattaforma logica su cui estendere i controlli alle applicazioni AI SaaS, poiché le aziende la utilizzano già per scoprire, controllare l'accesso e proteggere i dati di tutte le applicazioni e servizi SaaS. D'altro canto, per le implementazioni su infrastrutture private, un firewall LLM che sia una combinazione di reverse proxy SSE (o tramite API LLM) e guardrail AI sarà il paradigma giusto per raggiungere la sicurezza Zero Trust. Indipendentemente dal modello di distribuzione, saranno fondamentali anche la continuous discovery, il red teaming e gli audit di configurazione.

La figura precedente illustra un'architettura completa per proteggere l'uso di LLM dall'interno dell'azienda o da utenti e dispositivi fidati. Un approccio simile per i clienti e i dispositivi non gestiti si concentrerà principalmente sul flusso inferiore, che include solo il reverse proxy.

Affrontare questi rischi per la sicurezza nelle fasi iniziali dell'implementazione dell'IA fondamentale è garantire il successo e la sicurezza dei sistemi di IA. Per rafforzare la sicurezza dell'IA a questo livello fondamentale, le organizzazioni dovrebbero:

- Conduca audit regolari: Si assicuri che i sistemi di IA siano regolarmente controllati per verificare la presenza di vulnerabilità di tipo prompt injection, configurazioni errate e problemi di gestione dei dati.

- Implementare la convalida degli input: Utilizzi meccanismi robusti per convalidare i prompt e gli input, riducendo il rischio di attacchi di prompt engineering.

- Adottare misure di protezione dei dati: Stabilire solidi quadri di governance dei dati per ridurre al minimo il rischio di perdita di dati durante le interazioni con l'IA.

- Ambienti AI sicuri: Segua le best practice per la configurazione dei sistemi di IA, soprattutto quando integra plugin o servizi di terze parti.

Il cammino verso il futuro: Mettere in sicurezza l'IA da zero

L'IA fondamentale funge da spina dorsale per molte applicazioni di IA avanzate, ma introduce anche rischi significativi per la sicurezza, tra cui gli attacchi di prompt engineering, la fuga di dati e le configurazioni errate. Poiché l'AI continua a svolgere un ruolo centrale nel guidare l'innovazione in tutti i settori, le aziende devono dare priorità alla sicurezza fin dall'inizio, a partire da questo livello fondamentale.

Il prossimo blog della nostra serie esplorerà le esigenze e le opportunità di sicurezza associate al livello 2: copiloti AI, assistenti virtuali e strumenti di produttività che possono aiutare a guidare il processo decisionale e ad automatizzare un'ampia gamma di compiti. Per saperne di più sulla sicurezza delle sue applicazioni AI e sulla mitigazione dei rischi, esplori le soluzioni AI di Skyhigh.

Altri blog in questa serie:

Torna ai blog