By Sekhar Sarukkai - Cybersecurity@UC Berkeley

2024年10月10日 5 分で読む

シリーズ最初のブログ「AIセキュリティ:顧客のニーズと機会」では、AIセキュリティの課題とソリューションの概要とともに、AIテクノロジースタックの3つのレイヤーの概要とそのユースケースを紹介しました。この2回目のブログでは、レイヤー1「基礎的なAI」に関連する具体的なリスクと、組織がAIの多くのメリットを活用してビジネスを有利に進めるための緩和策について取り上げます。

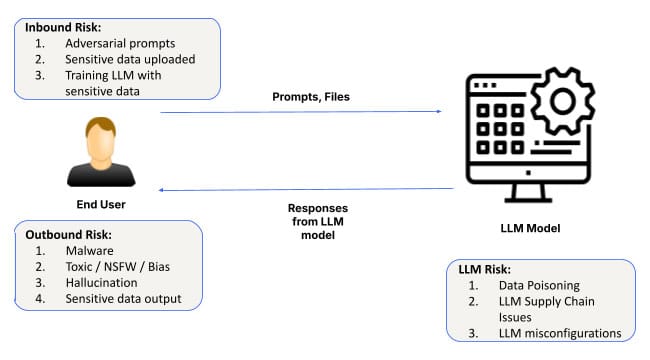

人工知能(AI)が進化を続け、足場を固めるにつれ、その応用範囲はヘルスケアから金融まで幅広い業界へと広がっている。すべてのAIシステムの中核には、基盤となるモデルと、それらのモデルをカスタマイズするためのソフトウェア・インフラがある。このレイヤーは、すべてのAIアプリケーションの基礎となり、システムがデータから学習し、パターンを検出し、予測を行うことを可能にする。しかし、その重要性にもかかわらず、AI基盤レイヤーにリスクがないわけではない。プロンプト・エンジニアリング攻撃から設定ミス、データ漏洩に至るまで、このレイヤーにおけるセキュリティ上の課題は、広範囲に及ぶ結果をもたらす可能性がある。

基礎的なAIに関連するセキュリティ・リスクと、企業がAI主導のソリューションを採用する際に注意すべき点について深く掘り下げてみよう。

AI基盤レイヤーのセキュリティ・リスク

1.プロンプトエンジニアリング攻撃

基礎AIのレイヤーで最も一般的なリスクの1つは、攻撃者がAIの入力を操作して意図しない、または有害な出力を生成するプロンプトエンジニアリングです。このような攻撃は、AIモデルがプロンプトを解釈して応答する方法の脆弱性を悪用し、悪意のある行為者がセキュリティ・プロトコルを回避することを可能にします。

SkeletonKeyや CrescendoMationのような新しい技術により、プロンプト・エンジニアリングは脅威を増しており、AIシステムを「ジェイルブレイク」する様々な形態が一般的になっている。これらの攻撃はダークウェブで見つけることができ、WormGPT、FraudGPT、EscapeGPTのようなツールがハッカーに公然と販売されている。いったんAIモデルが侵害されると、誤解を招いたり危険な反応を生成したりする可能性があり、データ漏洩やシステム障害につながる。

例えば、攻撃者は顧客サービスのAIシステムにプロンプトを注入し、モデルの制約を回避して、機密性の高い顧客データにアクセスしたり、出力を操作して業務に支障をきたす可能性がある。

このリスクを軽減するために、組織は強固な入力検証メカニズムを導入し、特に重要なビジネスプロセスを制御するためにプロンプトが使用されている場合は、潜在的な脆弱性がないかAIシステムを定期的に監査する必要がある。

2.データ漏洩

データ漏えいは、Foundational AIレイヤーにおけるもう一つの重大な懸念事項である。組織がAIモデルを機密データからの洞察の生成などのタスクに使用する場合、AIとの対話中にこれらの情報の一部が不注意で漏洩するリスクがある。これは、モデルの微調整やLLM(大規模言語モデル)との長時間の会話において特に当てはまります。

顕著な例としては、サムスンのエンジニアがChatGPTとのやり取りを通じて誤って企業の機密データを流出させてしまったことがある。このような事件は、プロンプトデータがAIの学習データに容易に組み込まれる可能性があるため、デフォルトで非公開データとして扱うことの重要性を強調している。基礎モデルレイヤーにおけるプライバシー保護は引き続き前進していますが、プロンプトデータがモデルに入り込まないようにするには、オプトアウトする必要があります。

さらに、歴史的に悪用されてきたデータ流出の方法は、LLMとの長期にわたる会話の文脈で、より容易に展開される可能性がある。Bingチャットボットにおける画像マークダウンの悪用やChatGPTのような問題を認識することも、特にLLMを私的に展開する場合には対処する必要があるだろう。

歴史的に伝統的なシステムを標的としてきたデータ流出テクニックも、AI環境に適応されつつある。例えば、長期間にわたるチャットボットとのやり取りは、(ChatGPTに見られるような)イメージマークダウンエクスプロイトのような手口を用いて攻撃者に悪用され、時間をかけてこっそりと機密データを抜き取られる可能性がある。

組織は、厳格なデータ取り扱いポリシーを採用し、AIモデルを通じて機密情報が不用意に漏洩しないように制御を導入することで、このリスクに対処することができる。

3.インスタンスの誤設定

設定ミスはセキュリティ脆弱性の一般的な原因であり、これは特にAI基盤層で顕著である。AIシステムの導入が急速に進む中、多くの組織がAI環境の適切な設定に苦慮しており、モデルが潜在的な脅威にさらされたままになっている。

信頼できないサードパーティのプラグインを許可したり、適切な管理なしに外部データ統合を可能にしたり、AIモデルに過剰な権限を付与したりするなど、AIインスタンスの設定を誤ると、重大なデータ侵害につながる可能性がある。また、責任共有モデルでは、組織が必要な制限を実施できず、不正アクセスやデータ流出のリスクが高まる可能性もある。

例えば、ChatGPTではプラグインがサードパーティのサービスと統合できるようになっており、信頼できないプラグインが不用意にエンタープライズインスタンスに接続されると、データ漏えいの大きな原因となる可能性がある。同様に、不適切なアクセス制御の設定により、権限のないユーザーがAIシステムを通じて機密データにアクセスする可能性があります。

レッド・チーミングは新しい概念ではないが、LLMはブラックボックスとして機能し、その出力は予測不可能であるため、AIスタックのすべてのレイヤーにおいて特に重要である。例えば、Anthropic社の研究によると、LLMはモデルの重みに隠された攻撃を行うスリーパーエージェントになる可能性があり、それが予期せず表面化する可能性があるという。

このリスクを低減するために、組織はサードパーティ・サービスの統合を制限し、権限を制限し、AI環境の構成を定期的に見直すなど、AI構成のベスト・プラクティスに従うべきである。Skyhigh SecurityAIアプリケーション・ソリューションの安全な使用は、AIシステムが適切に構成され、保護されていることを確認するためのツールとベスト・プラクティスを提供します。

レイヤー1でのAIセキュリティ強化

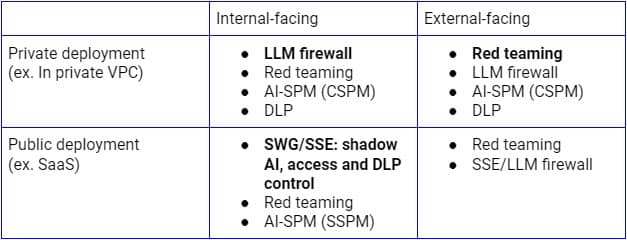

上記のセキュリティリスクは、さまざまなユースケースに基づいて対処する必要がある。LLMの内部向けパブリックデプロイメントの場合、セキュアサービスエッジ(SSEフォワードプロキシ)は、SaaSのAIアプリケーションに制御を拡張する論理的なプラットフォームである。一方、プライベート・インフラへのデプロイでは、SSEリバース・プロキシ(またはLLM API経由)とAIガードレールを組み合わせたLLMファイアウォールが、ゼロ・トラスト・セキュリティを実現するための適切なパラダイムとなる。デプロイメント・モデルに関係なく、継続的なディスカバリー、レッド・チーミング、コンフィギュレーション監査も極めて重要になる。

上図は、企業内または信頼されたユーザーとデバイスからのLLMの使用をセキュ アにするための包括的なアーキテクチャを示している。顧客や管理されていないデバイスのための同様のアプローチは、主にリバースプロキシのみを含むボトムフローに焦点を当てる。

AIシステムの成功とセキュリティを確保するためには、基盤AIの展開の早い段階でこれらのセキュリティリスクに対処することが極めて重要である。この基盤層におけるAIのセキュリティを強化するために、組織は以下を行うべきである:

- 定期的な監査の実施:AIシステムを定期的にレビューし、インジェクションの脆弱性、設定ミス、データ処理の問題がないか確認する。

- 入力検証を実施する:プロンプトと入力を検証する堅牢なメカニズムを使用し、プロンプト・エンジニアリング攻撃のリスクを低減する。

- データ保護対策を採用する:強力なデータガバナンスの枠組みを確立し、AIとのやり取りにおけるデータ漏えいのリスクを最小限に抑える。

- セキュアなAI環境:特にサードパーティのプラグインやサービスを統合する場合は、AIシステムを構成するためのベストプラクティスに従ってください。

前進への道AIを根底から守る

基礎的なAIは、多くの高度なAIアプリケーションのバックボーンとして機能しますが、プロンプトエンジニアリング攻撃、データ漏洩、設定ミスなど、重大なセキュリティリスクももたらします。AIが業界全体のイノベーションを推進する上で極めて重要な役割を果たし続ける中、企業はこの基盤レイヤーを始めとして、最初からセキュリティを優先する必要があります。

次回のブログでは、レイヤー2(AIコパイロット、仮想アシスタント、意思決定やさまざまなタスクの自動化を支援する生産性向上ツール)に関連するセキュリティのニーズと機会についてご紹介します。AIアプリケーションのセキュリティとリスク軽減の詳細については、SkyhighのAIソリューションをご覧ください。

このシリーズの他のブログ

ブログへ戻る