بقلم سيخار ساروكاي - الأمن السيبراني في جامعة بيركلي

10 أكتوبر 2024 5 قراءة دقيقة

في المدونة الأولى في سلسلتنا "أمن الذكاء الاصطناعي: احتياجات العملاء والفرص المتاحة لهم"، نقدم لمحة عامة عن الطبقات الثلاث لحزمة تقنيات الذكاء الاصطناعي وحالات استخدامها، إلى جانب ملخص للتحديات والحلول الأمنية للذكاء الاصطناعي. في هذه المدونة الثانية، نتناول في هذه المدونة الثانية المخاطر المحددة المرتبطة بالطبقة الأولى: الذكاء الاصطناعي التأسيسي والتخفيف من المخاطر التي يمكن أن تساعد المؤسسات على الاستفادة من المزايا العديدة للذكاء الاصطناعي لصالح أعمالها.

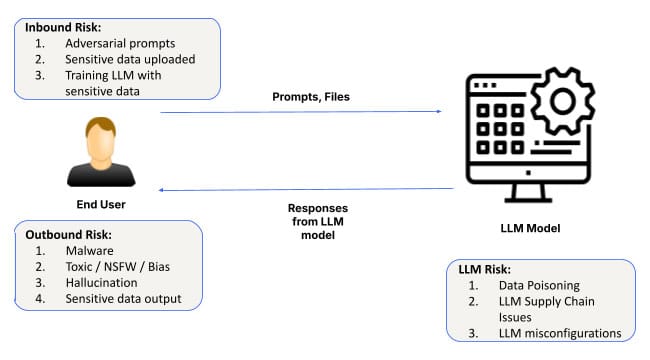

مع استمرار تطور الذكاء الاصطناعي (AI) وترسيخ موطئ قدم له، تمتد تطبيقاته في قطاعات تتراوح من الرعاية الصحية إلى التمويل. في قلب كل نظام ذكاء اصطناعي توجد نماذج أساسية وبنية تحتية برمجية لتخصيص تلك النماذج. وتوفر هذه الطبقة الأساس لجميع تطبيقات الذكاء الاصطناعي، مما يمكّن الأنظمة من التعلم من البيانات واكتشاف الأنماط والتنبؤات. ومع ذلك، وعلى الرغم من أهميتها، فإن طبقة الذكاء الاصطناعي التأسيسية لا تخلو من المخاطر. من الهجمات الهندسية السريعة، إلى التهيئة الخاطئة، إلى تسرب البيانات، يمكن أن يكون للتحديات الأمنية في هذه الطبقة عواقب بعيدة المدى.

دعنا نتعمق في المخاطر الأمنية المرتبطة بالذكاء الاصطناعي التأسيسي وما تحتاج الشركات إلى مراقبته أثناء تبنيها للحلول القائمة على الذكاء الاصطناعي.

المخاطر الأمنية في طبقة الذكاء الاصطناعي التأسيسية

1. الهجمات الهندسية الفورية

أحد أكثر المخاطر انتشاراً في طبقة الذكاء الاصطناعي التأسيسية هو هندسة المطالبات، حيث يتلاعب المهاجمون بمدخلات الذكاء الاصطناعي لإنتاج مخرجات غير مقصودة أو ضارة. تستغل هذه الهجمات نقاط الضعف في كيفية تفسير نماذج الذكاء الاصطناعي واستجابتها للمطالبات، مما يسمح للجهات الخبيثة بالتحايل على بروتوكولات الأمان.

لقد جعلت التقنيات الجديدة مثل SkeletonKey و CrescendoMation من الهندسة السريعة تهديدًا متزايدًا، حيث أصبحت أشكال مختلفة من "كسر الحماية" لأنظمة الذكاء الاصطناعي شائعة. يمكن العثور على هذه الهجمات على شبكة الإنترنت المظلمة، حيث تُباع أدوات مثل WormGPT و FraudGPT و EscapeGPT علناً للقراصنة. بمجرد أن يتم اختراق نموذج الذكاء الاصطناعي، يمكن أن يولد استجابات مضللة أو خطيرة، مما يؤدي إلى اختراق البيانات أو تعطل النظام.

على سبيل المثال، يمكن للمهاجمين حقن مطالبات في نظام ذكاء اصطناعي لخدمة العملاء، وتجاوز قيود النموذج للوصول إلى بيانات العملاء الحساسة أو التلاعب بالمخرجات لإحداث خلل في العمليات.

وللتخفيف من هذه المخاطر، يجب على المؤسسات تنفيذ آليات قوية للتحقق من صحة المدخلات والتدقيق المنتظم في أنظمة الذكاء الاصطناعي بحثاً عن نقاط الضعف المحتملة، خاصةً عند استخدام المطالبات للتحكم في العمليات التجارية المهمة.

2. تسرب البيانات

يُعد تسرب البيانات مصدر قلق كبير آخر في طبقة الذكاء الاصطناعي التأسيسية. عند استخدام المؤسسات لنماذج الذكاء الاصطناعي في مهام مثل توليد رؤى من البيانات الحساسة، هناك خطر من أن بعض هذه المعلومات قد تنكشف عن غير قصد أثناء تفاعلات الذكاء الاصطناعي. وينطبق هذا بشكل خاص على الضبط الدقيق للنموذج أو أثناء المحادثات الموسعة مع نماذج اللغات الكبيرة.

ومن الأمثلة البارزة على ذلك ما حدث عندما قام مهندسو سامسونج بتسريب بيانات الشركة الحساسة عن طريق الخطأ من خلال التفاعل مع ChatGPT. تؤكد مثل هذه الحوادث على أهمية التعامل مع البيانات الفورية على أنها غير خاصة بشكل افتراضي، حيث يمكن بسهولة دمجها في بيانات تدريب الذكاء الاصطناعي. بينما نرى تقدماً مستمراً في حماية الخصوصية في طبقة نموذج الأساس، ستظل بحاجة إلى إلغاء الاشتراك لضمان عدم وصول أي بيانات فورية إلى النموذج.

بالإضافة إلى ذلك، يمكن نشر الطرق المستغلة تاريخياً لاستخراج البيانات بسهولة أكبر في سياق محادثة طويلة الأمد مع LLMs. كما يجب أيضًا الانتباه إلى مشاكل مثل استغلال ترميز الصور في روبوت الدردشة Bing وكذلك ChatGPT، خاصةً مع عمليات النشر الخاصة لـ LLMs.

يتم أيضاً تكييف تقنيات استخراج البيانات التي استهدفت تاريخياً الأنظمة التقليدية مع بيئات الذكاء الاصطناعي. على سبيل المثال، يمكن استغلال تفاعلات روبوتات الدردشة طويلة الأمد من قبل المهاجمين الذين يستخدمون تكتيكات مثل استغلال الصور (كما رأينا في ChatGPT) لاستخراج البيانات الحساسة خلسةً بمرور الوقت.

يمكن للمؤسسات معالجة هذا الخطر من خلال اعتماد سياسات صارمة للتعامل مع البيانات وتنفيذ ضوابط لضمان عدم كشف المعلومات الحساسة عن غير قصد من خلال نماذج الذكاء الاصطناعي.

3. مثيلات تمت تهيئتها بشكل خاطئ

يُعد سوء التهيئة مصدرًا شائعًا للثغرات الأمنية، وينطبق هذا بشكل خاص على طبقة الذكاء الاصطناعي التأسيسية. ونظراً للانتشار السريع لأنظمة الذكاء الاصطناعي، تكافح العديد من المؤسسات لتهيئة بيئات الذكاء الاصطناعي الخاصة بها بشكل صحيح، مما يجعل النماذج مكشوفة للتهديدات المحتملة.

يمكن أن تؤدي مثيلات الذكاء الاصطناعي التي تمت تهيئتها بشكل خاطئ - مثل السماح بمكونات إضافية غير موثوق بها من طرف ثالث، أو تمكين تكامل البيانات الخارجية دون ضوابط مناسبة، أو منح أذونات مفرطة لنماذج الذكاء الاصطناعي - إلى حدوث انتهاكات كبيرة للبيانات. في نماذج المسؤولية المشتركة، قد تفشل المؤسسات أيضًا في تنفيذ القيود اللازمة، مما يزيد من مخاطر الوصول غير المصرح به أو تسريب البيانات.

على سبيل المثال، يسمح ChatGPT للمكونات الإضافية بالتكامل مع خدمات الطرف الثالث، والتي يمكن أن تكون مصدراً رئيسياً لتسريب البيانات إذا تم توصيل المكونات الإضافية غير الموثوق بها عن غير قصد بمثيلات المؤسسة. وبالمثل، يمكن أن تؤدي تكوينات التحكم في الوصول غير الصحيحة إلى وصول المستخدمين غير المصرح لهم إلى البيانات الحساسة من خلال أنظمة الذكاء الاصطناعي.

وعلى الرغم من أن مفهوم "الفريق الأحمر" ليس مفهوماً جديداً، إلا أنه مهم بشكل خاص في جميع طبقات مكدس الذكاء الاصطناعي لأن الآلات ذات الأوزان المنخفضة جداً تعمل كصناديق سوداء ولا يمكن التنبؤ بمخرجاتها. على سبيل المثال، أظهر بحث من شركة أنثروبيك أن الآلات ذات المسؤولية المحدودة يمكن أن تتحول إلى عملاء نائمين مع هجمات مخفية في أوزان النموذج التي قد تظهر بشكل غير متوقع.

وللحد من هذه المخاطر، يجب على المؤسسات اتباع أفضل الممارسات لتكوين الذكاء الاصطناعي من خلال الحد من تكامل خدمات الطرف الثالث، وتقييد الأذونات، ومراجعة تكوينات بيئة الذكاء الاصطناعي بانتظام. Skyhigh Securityيوفر الاستخدام الآمن لحلول تطبيقات الذكاء الاصطناعي الأدوات وأفضل الممارسات لضمان تكوين أنظمة الذكاء الاصطناعي وحمايتها بشكل صحيح.

تعزيز أمن الذكاء الاصطناعي في الطبقة 1

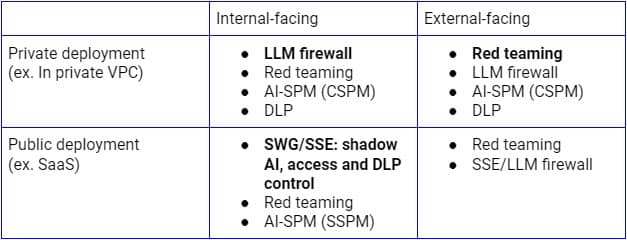

يجب معالجة المخاطر الأمنية المذكورة أعلاه بناءً على حالات الاستخدام المختلفة. بالنسبة لعمليات النشر العامة الداخلية لتطبيقات إدارة البرمجيات الخفيفة ذات المسؤولية المحدودة (LLM)، فإن جدار الحماية Secure Service Edge (الوكيل العكسي SSE) هو المنصة المنطقية التي يمكن من خلالها توسيع نطاق الضوابط لتشمل تطبيقات الذكاء الاصطناعي SaaS، حيث تستخدمها المؤسسات بالفعل لاكتشاف جميع تطبيقات وخدمات SaaS والتحكم في الوصول إليها وحمايتها. على الجانب الآخر، بالنسبة لعمليات النشر على البنية التحتية الخاصة، فإن جدار حماية LLM الذي هو مزيج من الوكيل العكسي SSE (أو عبر واجهات برمجة تطبيقات LLM) وحواجز حماية الذكاء الاصطناعي سيكون النموذج الصحيح لتحقيق أمان انعدام الثقة. وبغض النظر عن نموذج النشر، سيكون الاكتشاف المستمر، وفرق العمل الأحمر، وعمليات تدقيق التكوين أمراً بالغ الأهمية أيضاً.

يوضح الشكل أعلاه بنية شاملة لتأمين استخدام LLM من داخل المؤسسة أو المستخدمين والأجهزة الموثوق بها. سيركز نهج مماثل للعملاء والأجهزة غير المُدارة بشكل أساسي على التدفق السفلي الذي يتضمن الوكيل العكسي فقط.

إن معالجة هذه المخاطر الأمنية في مرحلة مبكرة من نشر الذكاء الاصطناعي التأسيسي أمر بالغ الأهمية لضمان نجاح وأمن أنظمة الذكاء الاصطناعي. لتعزيز أمن الذكاء الاصطناعي في هذه الطبقة التأسيسية، يجب على المؤسسات

- إجراء عمليات تدقيق منتظمة: التأكد من مراجعة أنظمة الذكاء الاصطناعي بانتظام بحثًا عن نقاط الضعف في الحقن الفوري والتهيئة الخاطئة ومشاكل معالجة البيانات.

- تنفيذ التحقق من صحة المدخلات: استخدم آليات قوية للتحقق من صحة المطالبات والمدخلات، مما يقلل من مخاطر الهجمات الهندسية الفورية.

- اعتماد تدابير حماية البيانات: إنشاء أطر عمل قوية لحوكمة البيانات لتقليل مخاطر تسرب البيانات أثناء تفاعلات الذكاء الاصطناعي.

- تأمين بيئات الذكاء الاصطناعي: اتبع أفضل الممارسات لتهيئة أنظمة الذكاء الاصطناعي، خاصةً عند دمج المكونات الإضافية أو الخدمات الخارجية.

الطريق إلى الأمام: تأمين الذكاء الاصطناعي من الألف إلى الياء

يُعتبر الذكاء الاصطناعي التأسيسي بمثابة العمود الفقري للعديد من تطبيقات الذكاء الاصطناعي المتقدمة، ولكنه يقدم أيضًا مخاطر أمنية كبيرة، بما في ذلك الهجمات الهندسية السريعة وتسريب البيانات والتكوينات الخاطئة. مع استمرار الذكاء الاصطناعي في لعب دور محوري في دفع عجلة الابتكار في مختلف الصناعات، يجب على الشركات إعطاء الأولوية للأمن منذ البداية - بدءًا من هذه الطبقة التأسيسية.

ستستكشف المدونة التالية في سلسلتنا احتياجات الأمان والفرص المرتبطة بالطبقة الثانية: الذكاء الاصطناعي المساعد والمساعدين الافتراضيين وأدوات الإنتاجية التي يمكن أن تساعد في توجيه عملية اتخاذ القرار وأتمتة مجموعة متنوعة من المهام. لمعرفة المزيد حول تأمين تطبيقات الذكاء الاصطناعي الخاصة بك وتخفيف المخاطر، استكشف حلول Skyhigh للذكاء الاصطناعي.

مدونات أخرى في هذه السلسلة

العودة إلى المدونات