शेखर सरुक्काई द्वारा - साइबरसिक्यूरिटी@यूसी बर्कले

10 अक्टूबर, 2024 5 मिनट पढ़ें

हमारी श्रृंखला के पहले ब्लॉग, " एआई सुरक्षा: ग्राहक की ज़रूरतें और अवसर " में, हम एआई प्रौद्योगिकी स्टैक की तीन परतों और उनके उपयोग के मामलों का अवलोकन प्रदान करते हैं, साथ ही एआई सुरक्षा चुनौतियों और समाधानों का सारांश भी देते हैं। इस दूसरे ब्लॉग में, हम लेयर 1 से जुड़े विशिष्ट जोखिमों को संबोधित करते हैं: मूलभूत एआई और शमन जो संगठनों को अपने व्यावसायिक लाभ के लिए एआई के कई लाभों का लाभ उठाने में मदद कर सकते हैं।

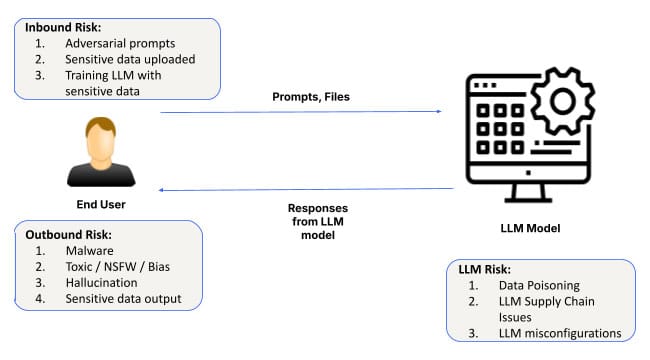

जैसे-जैसे कृत्रिम बुद्धिमत्ता (AI) विकसित होती जा रही है और अपनी पैठ जमा रही है, इसके अनुप्रयोग स्वास्थ्य सेवा से लेकर वित्त तक के उद्योगों में फैल रहे हैं। प्रत्येक AI प्रणाली के मूल में उन मॉडलों को अनुकूलित करने के लिए आधारभूत मॉडल और सॉफ़्टवेयर अवसंरचना होती है। यह परत सभी AI अनुप्रयोगों के लिए आधारभूत कार्य प्रदान करती है, जिससे सिस्टम डेटा से सीख सकते हैं, पैटर्न का पता लगा सकते हैं और भविष्यवाणियाँ कर सकते हैं। हालाँकि, इसके महत्व के बावजूद, आधारभूत AI परत जोखिम से मुक्त नहीं है। त्वरित इंजीनियरिंग हमलों से लेकर गलत कॉन्फ़िगरेशन तक, डेटा लीक होने तक, इस परत पर सुरक्षा चुनौतियों के दूरगामी परिणाम हो सकते हैं।

आइए, फाउंडेशनल एआई से जुड़े सुरक्षा जोखिमों पर गहराई से विचार करें और देखें कि व्यवसायों को एआई-संचालित समाधान अपनाते समय किन बातों का ध्यान रखना चाहिए।

आधारभूत AI परत पर सुरक्षा जोखिम

1. त्वरित इंजीनियरिंग हमले

फाउंडेशनल एआई परत पर सबसे प्रचलित जोखिमों में से एक प्रॉम्प्ट इंजीनियरिंग है, जहां हमलावर एआई इनपुट में हेरफेर करके अनपेक्षित या हानिकारक आउटपुट उत्पन्न करते हैं। ये हमले एआई मॉडल द्वारा प्रॉम्प्ट की व्याख्या और प्रतिक्रिया करने के तरीके में कमजोरियों का फायदा उठाते हैं, जिससे दुर्भावनापूर्ण अभिनेता सुरक्षा प्रोटोकॉल को दरकिनार कर सकते हैं।

स्केलेटनकी और क्रेसेंडोमेशन जैसी नई तकनीकों ने प्रॉम्प्ट इंजीनियरिंग को एक बढ़ता हुआ खतरा बना दिया है, जिसमें “जेलब्रेकिंग” एआई सिस्टम के विभिन्न रूप आम हो गए हैं। इन हमलों को डार्क वेब पर पाया जा सकता है, जिसमें वर्मजीपीटी , फ्रॉडजीपीटी और एस्केपजीपीटी जैसे उपकरण खुलेआम हैकर्स को बेचे जाते हैं। एक बार जब एआई मॉडल से समझौता हो जाता है, तो यह भ्रामक या खतरनाक प्रतिक्रियाएँ उत्पन्न कर सकता है, जिससे डेटा उल्लंघन या सिस्टम विफलताएँ हो सकती हैं।

उदाहरण के लिए, एक हमलावर ग्राहक सेवा AI प्रणाली में प्रॉम्प्ट डाल सकता है, जिससे मॉडल की बाधाओं को दरकिनार करते हुए संवेदनशील ग्राहक डेटा तक पहुंच सकता है या परिचालन में व्यवधान पैदा करने के लिए आउटपुट में हेरफेर कर सकता है।

इस जोखिम को कम करने के लिए, संगठनों को मजबूत इनपुट सत्यापन तंत्र को लागू करना चाहिए और संभावित कमजोरियों के लिए नियमित रूप से एआई प्रणालियों का ऑडिट करना चाहिए, खासकर जब संकेतों का उपयोग महत्वपूर्ण व्यावसायिक प्रक्रियाओं को नियंत्रित करने के लिए किया जाता है।

2. डेटा लीक

डेटा लीक होना फाउंडेशनल AI लेयर पर एक और महत्वपूर्ण चिंता का विषय है। जब संगठन संवेदनशील डेटा से अंतर्दृष्टि उत्पन्न करने जैसे कार्यों के लिए AI मॉडल का उपयोग करते हैं, तो इस बात का जोखिम होता है कि इस जानकारी का कुछ हिस्सा अनजाने में AI इंटरैक्शन के दौरान उजागर हो सकता है। यह मॉडल फ़ाइन-ट्यूनिंग या LLM (लार्ज लैंग्वेज मॉडल) के साथ विस्तारित बातचीत के दौरान विशेष रूप से सच है।

एक उल्लेखनीय उदाहरण तब हुआ जब सैमसंग इंजीनियरों ने चैटजीपीटी के साथ बातचीत के माध्यम से गलती से संवेदनशील कॉर्पोरेट डेटा लीक कर दिया । ऐसी घटनाएं प्रॉम्प्ट डेटा को डिफ़ॉल्ट रूप से गैर-निजी के रूप में मानने के महत्व को रेखांकित करती हैं, क्योंकि इसे आसानी से एआई के प्रशिक्षण डेटा में शामिल किया जा सकता है। जबकि हम फाउंडेशन मॉडल परत पर गोपनीयता सुरक्षा के लिए निरंतर प्रगति देखते हैं, फिर भी आपको यह सुनिश्चित करने के लिए ऑप्ट आउट करना होगा कि कोई भी प्रॉम्प्ट डेटा मॉडल में अपना रास्ता न खोजे।

इसके अतिरिक्त, डेटा एक्सफ़िल्टरेशन के ऐतिहासिक रूप से शोषित तरीकों को एलएलएम के साथ लंबे समय से चल रही बातचीत के संदर्भ में अधिक आसानी से तैनात किया जा सकता है। बिंग चैटबॉट में इमेज मार्कडाउन शोषण के साथ-साथ चैटजीपीटी जैसे मुद्दों के बारे में जागरूक होने की भी आवश्यकता होगी, विशेष रूप से एलएलएम की निजी तैनाती के साथ।

डेटा एक्सफ़िल्टरेशन तकनीकें जो ऐतिहासिक रूप से पारंपरिक प्रणालियों को लक्षित करती रही हैं, उन्हें भी AI वातावरण के लिए अनुकूलित किया जा रहा है। उदाहरण के लिए, लंबे समय तक चलने वाले चैटबॉट इंटरैक्शन का हमलावरों द्वारा इमेज मार्कडाउन एक्सप्लॉइट (जैसा कि चैटजीपीटी में देखा गया है) जैसी रणनीति का उपयोग करके समय के साथ संवेदनशील डेटा को चुपके से निकालने के लिए शोषण किया जा सकता है।

संगठन सख्त डेटा-हैंडलिंग नीतियों को अपनाकर और नियंत्रण लागू करके इस जोखिम का समाधान कर सकते हैं ताकि यह सुनिश्चित किया जा सके कि संवेदनशील जानकारी अनजाने में AI मॉडल के माध्यम से उजागर न हो जाए।

3. गलत कॉन्फ़िगर किए गए इंस्टेंस

गलत कॉन्फ़िगरेशन सुरक्षा कमज़ोरियों का एक आम स्रोत है, और यह विशेष रूप से फ़ाउंडेशनल AI परत पर सच है। AI सिस्टम की तेज़ी से तैनाती को देखते हुए, कई संगठन अपने AI वातावरण को ठीक से कॉन्फ़िगर करने के लिए संघर्ष करते हैं, जिससे मॉडल संभावित खतरों के संपर्क में आ जाते हैं।

गलत तरीके से कॉन्फ़िगर किए गए AI इंस्टेंस - जैसे कि अविश्वसनीय थर्ड-पार्टी प्लगइन्स को अनुमति देना, उचित नियंत्रण के बिना बाहरी डेटा एकीकरण को सक्षम करना, या AI मॉडल को अत्यधिक अनुमतियाँ देना - महत्वपूर्ण डेटा उल्लंघनों का कारण बन सकता है। साझा जिम्मेदारी मॉडल में, संगठन आवश्यक प्रतिबंधों को लागू करने में भी विफल हो सकते हैं, जिससे अनधिकृत पहुँच या डेटा एक्सफ़िलट्रेशन का जोखिम बढ़ जाता है।

उदाहरण के लिए, ChatGPT प्लगइन्स को थर्ड-पार्टी सेवाओं के साथ एकीकृत करने की अनुमति देता है, जो डेटा लीक का एक प्रमुख स्रोत हो सकता है यदि अविश्वसनीय प्लगइन्स अनजाने में एंटरप्राइज़ इंस्टेंस से जुड़े होते हैं। इसी तरह, अनुचित एक्सेस कंट्रोल कॉन्फ़िगरेशन के कारण अनधिकृत उपयोगकर्ता AI सिस्टम के माध्यम से संवेदनशील डेटा तक पहुँच प्राप्त कर सकते हैं।

जबकि रेड टीमिंग कोई नई अवधारणा नहीं है, यह AI स्टैक की सभी परतों में विशेष रूप से महत्वपूर्ण है क्योंकि LLM ब्लैक बॉक्स के रूप में कार्य करते हैं और उनके आउटपुट का पूर्वानुमान नहीं लगाया जा सकता है। उदाहरण के लिए, एंथ्रोपिक के शोध से पता चला है कि LLM स्लीपर एजेंट में बदल सकते हैं, जिनके हमले मॉडल वेट में छिपे होते हैं जो अप्रत्याशित रूप से सामने आ सकते हैं।

इस जोखिम को कम करने के लिए, संगठनों को तृतीय-पक्ष सेवाओं के एकीकरण को सीमित करके, अनुमतियों को प्रतिबंधित करके और AI पर्यावरण कॉन्फ़िगरेशन की नियमित समीक्षा करके AI कॉन्फ़िगरेशन के लिए सर्वोत्तम प्रथाओं का पालन करना चाहिए। Skyhigh Security एआई अनुप्रयोग समाधानों का सुरक्षित उपयोग एआई प्रणालियों को उचित रूप से कॉन्फ़िगर और संरक्षित करने के लिए उपकरण और सर्वोत्तम अभ्यास प्रदान करता है।

परत 1 पर एआई सुरक्षा को मजबूत करना

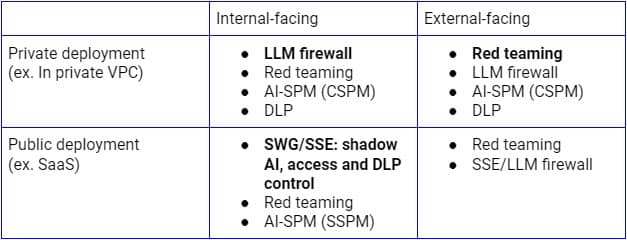

उपरोक्त सुरक्षा जोखिमों को विभिन्न उपयोग मामलों के आधार पर संबोधित करने की आवश्यकता है। LLM के आंतरिक-सामने वाले सार्वजनिक परिनियोजन के लिए, सिक्योर सर्विस एज (SSE फ़ॉरवर्ड प्रॉक्सी) एक तार्किक प्लेटफ़ॉर्म है जिस पर SaaS AI अनुप्रयोगों पर नियंत्रण बढ़ाया जा सकता है क्योंकि उद्यम पहले से ही इसका उपयोग सभी SaaS अनुप्रयोगों और सेवाओं के लिए डेटा की खोज, नियंत्रण और सुरक्षा के लिए करते हैं। दूसरी ओर, निजी बुनियादी ढांचे पर परिनियोजन के लिए, एक LLM फ़ायरवॉल जो SSE रिवर्स प्रॉक्सी (या LLM API के माध्यम से) और AI गार्डरेल का संयोजन है, ज़ीरो ट्रस्ट सुरक्षा प्राप्त करने के लिए सही प्रतिमान होगा। परिनियोजन मॉडल से स्वतंत्र, निरंतर खोज, रेड टीमिंग और कॉन्फ़िगरेशन ऑडिट भी महत्वपूर्ण होंगे।

उपरोक्त चित्र उद्यम या विश्वसनीय उपयोगकर्ताओं और उपकरणों के भीतर से LLM उपयोग को सुरक्षित करने के लिए एक व्यापक वास्तुकला को दर्शाता है। ग्राहकों और अप्रबंधित उपकरणों के लिए एक समान दृष्टिकोण मुख्य रूप से निचले प्रवाह पर ध्यान केंद्रित करेगा, जिसमें केवल रिवर्स प्रॉक्सी शामिल है।

फाउंडेशनल एआई की तैनाती में इन सुरक्षा जोखिमों को संबोधित करना एआई सिस्टम की सफलता और सुरक्षा सुनिश्चित करने के लिए महत्वपूर्ण है। इस आधारभूत स्तर पर एआई सुरक्षा को मजबूत करने के लिए, संगठनों को यह करना चाहिए:

- नियमित ऑडिट आयोजित करें : सुनिश्चित करें कि एआई प्रणालियों की नियमित रूप से त्वरित इंजेक्शन कमजोरियों, गलत कॉन्फ़िगरेशन और डेटा-हैंडलिंग मुद्दों के लिए समीक्षा की जाती है।

- इनपुट सत्यापन को कार्यान्वित करें : प्रॉम्प्ट और इनपुट को सत्यापित करने के लिए मजबूत तंत्र का उपयोग करें, जिससे प्रॉम्प्ट इंजीनियरिंग हमलों का जोखिम कम हो।

- डेटा सुरक्षा उपाय अपनाएं : एआई इंटरैक्शन के दौरान डेटा लीक के जोखिम को कम करने के लिए मजबूत डेटा गवर्नेंस फ्रेमवर्क स्थापित करें।

- सुरक्षित AI वातावरण : AI प्रणालियों को कॉन्फ़िगर करने के लिए सर्वोत्तम प्रथाओं का पालन करें, विशेष रूप से तृतीय-पक्ष प्लगइन्स या सेवाओं को एकीकृत करते समय।

आगे का रास्ता: एआई को शुरू से ही सुरक्षित करना

आधारभूत AI कई उन्नत AI अनुप्रयोगों के लिए रीढ़ की हड्डी के रूप में कार्य करता है, लेकिन यह महत्वपूर्ण सुरक्षा जोखिम भी प्रस्तुत करता है, जिसमें त्वरित इंजीनियरिंग हमले, डेटा लीक और गलत कॉन्फ़िगरेशन शामिल हैं। चूंकि AI उद्योगों में नवाचार को आगे बढ़ाने में महत्वपूर्ण भूमिका निभाना जारी रखता है, इसलिए व्यवसायों को शुरू से ही सुरक्षा को प्राथमिकता देनी चाहिए - इस आधारभूत परत से शुरू करना।

हमारी श्रृंखला का अगला ब्लॉग लेयर 2 से जुड़ी सुरक्षा आवश्यकताओं और अवसरों का पता लगाएगा: AI कोपायलट, वर्चुअल असिस्टेंट और उत्पादकता उपकरण जो निर्णय लेने में मार्गदर्शन करने और कई तरह के कार्यों को स्वचालित करने में मदद कर सकते हैं। अपने AI अनुप्रयोगों को सुरक्षित करने और जोखिम को कम करने के बारे में अधिक जानने के लिए, Skyhigh AI समाधानों का पता लगाएं ।

इस श्रृंखला के अन्य ब्लॉग:

ब्लॉग पर वापस जाएं