Ressources

L'IA fondamentale : une couche critique avec des défis en matière de sécurité

Par Sekhar Sarukkai - Cybersecurity@UC Berkeley

10 octobre 2024 5 Lecture minute

Dans le premier blog de notre série "Sécurité de l'IA : Besoins et opportunités des clients", nous avons présenté les trois couches de la pile technologique de l'IA et leurs cas d'utilisation, ainsi qu'un résumé des défis et des solutions en matière de sécurité de l'IA. Dans ce deuxième blog, nous abordons les risques spécifiques associés à la couche 1 : l'IA fondamentale et les mesures d'atténuation qui peuvent aider les entreprises à tirer profit des nombreux avantages de l'IA.

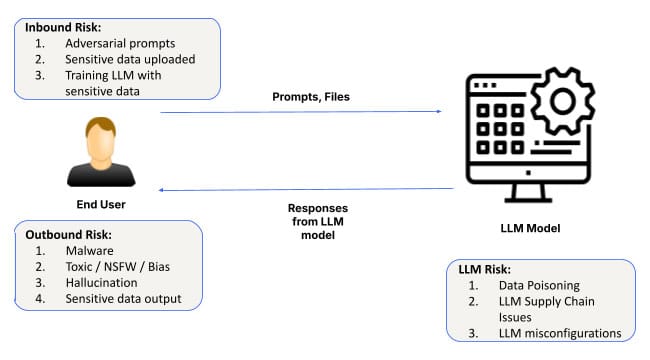

Alors que l'intelligence artificielle (IA) continue d'évoluer et de s'implanter, ses applications couvrent des secteurs allant de la santé à la finance. Au cœur de chaque système d'IA se trouvent les modèles fondamentaux et l'infrastructure logicielle permettant de personnaliser ces modèles. Cette couche constitue la base de toutes les applications d'IA, permettant aux systèmes d'apprendre à partir des données, de détecter des modèles et de faire des prédictions. Cependant, malgré son importance, la couche fondamentale de l'IA n'est pas sans risques. Qu'il s'agisse d'attaques d'ingénierie rapide, de mauvaises configurations ou de fuites de données, les problèmes de sécurité au niveau de cette couche peuvent avoir des conséquences considérables.

Nous allons nous pencher sur les risques de sécurité associés à l'IA fondamentale et sur ce que les entreprises doivent surveiller lorsqu'elles adoptent des solutions basées sur l'IA.

Risques de sécurité au niveau de la couche fondamentale de l'IA

1. Attaques d'ingénierie rapides

L'un des risques les plus répandus au niveau de la couche d'IA fondamentale est l'ingénierie des invites, où les attaquants manipulent les entrées de l'IA pour produire des résultats involontaires ou nuisibles. Ces attaques exploitent les vulnérabilités dans la manière dont les modèles d'IA interprètent et répondent aux invites, ce qui permet aux acteurs malveillants de contourner les protocoles de sécurité.

De nouvelles techniques telles que SkeletonKey et CrescendoMation ont fait de l'ingénierie prompte une menace croissante, avec diverses formes de "jailbreaking" des systèmes d'IA devenant monnaie courante. Ces attaques peuvent être trouvées sur le dark web, avec des outils tels que WormGPT, FraudGPT et EscapeGPT ouvertement vendus aux pirates. Une fois qu'un modèle d'IA est compromis, il peut générer des réponses trompeuses ou dangereuses, entraînant des violations de données ou des pannes de système.

Par exemple, un pirate pourrait injecter des invites dans un système d'IA de service à la clientèle, en contournant les contraintes du modèle pour accéder aux données sensibles des clients ou manipuler les résultats afin de provoquer des perturbations opérationnelles.

Pour atténuer ce risque, les entreprises doivent mettre en place des mécanismes robustes de validation des entrées et vérifier régulièrement si les systèmes d'IA présentent des vulnérabilités potentielles, en particulier lorsque les messages-guides sont utilisés pour contrôler des processus opérationnels importants.

2. Fuite de données

La fuite de données est une autre préoccupation importante au niveau de la couche d'IA fondamentale. Lorsque les organisations utilisent des modèles d'IA pour des tâches telles que la production d'informations à partir de données sensibles, il existe un risque que certaines de ces informations soient exposées par inadvertance au cours des interactions avec l'IA. C'est particulièrement vrai lors de la mise au point du modèle ou lors de conversations prolongées avec des LLM (Large Language Models).

Un exemple notable est celui des ingénieurs de Samsung qui ont accidentellement divulgué des données d'entreprise sensibles lors d'interactions avec ChatGPT. De tels incidents soulignent l'importance de traiter les données d'invite comme non privées par défaut, car elles pourraient facilement être incorporées dans les données d'entraînement de l'IA. Même si nous constatons des progrès constants en matière de protection de la vie privée au niveau du modèle de base, vous devrez toujours vous désengager pour vous assurer qu'aucune donnée d'invite ne se retrouve dans le modèle.

En outre, les méthodes d'exfiltration de données exploitées historiquement pourraient être plus facilement déployées dans le contexte d'une conversation de longue durée avec les LLM. Il conviendra également d'être attentif à des problèmes tels que l'exploitation de l'image markdown dans le chatbot Bing ainsi que ChatGPT, en particulier dans le cadre de déploiements privés de LLM.

Les techniques d'exfiltration de données qui ont historiquement ciblé les systèmes traditionnels sont également adaptées aux environnements d'IA. Par exemple, les interactions de longue durée avec un chatbot pourraient être exploitées par des attaquants utilisant des tactiques telles que les exploits d'image markdown (comme vu dans ChatGPT) pour extraire furtivement des données sensibles au fil du temps.

Les organisations peuvent faire face à ce risque en adoptant des politiques strictes de traitement des données et en mettant en place des contrôles pour s'assurer que les informations sensibles ne sont pas exposées par inadvertance par les modèles d'IA.

3. Instances mal configurées

Les erreurs de configuration sont une source courante de vulnérabilités en matière de sécurité, et c'est particulièrement vrai au niveau de la couche d'IA fondamentale. Compte tenu du déploiement rapide des systèmes d'IA, de nombreuses organisations peinent à configurer correctement leurs environnements d'IA, laissant les modèles exposés à des menaces potentielles.

Des instances d'IA mal configurées - telles que l'autorisation de plugins tiers non fiables, l'activation de l'intégration de données externes sans contrôles appropriés ou l'octroi d'autorisations excessives aux modèles d'IA - peuvent entraîner d'importantes violations de données. Dans les modèles de responsabilité partagée, les organisations peuvent également ne pas mettre en œuvre les restrictions nécessaires, ce qui augmente le risque d'accès non autorisé ou d'exfiltration de données.

Par exemple, ChatGPT permet aux plugins de s'intégrer à des services tiers, ce qui peut être une source majeure de fuites de données si des plugins non fiables sont connectés par inadvertance aux instances de l'entreprise. De même, une mauvaise configuration du contrôle d'accès peut permettre à des utilisateurs non autorisés d'accéder à des données sensibles par le biais de systèmes d'intelligence artificielle.

Si le red teaming n'est pas un concept nouveau, il est particulièrement important à tous les niveaux de la pile IA car les LLM agissent comme des boîtes noires et leurs résultats ne sont pas prévisibles. Par exemple, des recherches menées par Anthropic ont montré que les LLM pouvaient se transformer en agents dormants avec des attaques cachées dans les poids du modèle qui peuvent apparaître de manière inattendue.

Pour réduire ce risque, les organisations devraient suivre les meilleures pratiques pour la configuration de l'IA en limitant l'intégration de services tiers, en restreignant les autorisations et en révisant régulièrement les configurations de l'environnement de l'IA. Skyhigh SecurityLes solutions d'utilisation sécurisée des applications d'intelligence artificielle d'EADS fournissent les outils et les meilleures pratiques pour s'assurer que les systèmes d'intelligence artificielle sont correctement configurés et protégés.

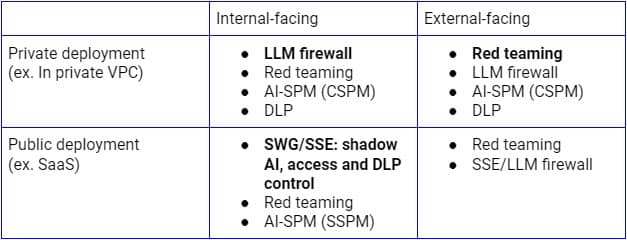

Renforcer la sécurité de l'IA au niveau 1

Les risques de sécurité susmentionnés doivent être traités en fonction des différents cas d'utilisation. Pour les déploiements publics de LLM orientés vers l'intérieur, Secure Service Edge (SSE forward proxy) est la plateforme logique sur laquelle étendre les contrôles aux applications SaaS AI puisque les entreprises l'utilisent déjà pour découvrir, contrôler l'accès et protéger les données de toutes les applications et de tous les services SaaS. D'un autre côté, pour les déploiements sur une infrastructure privée, un pare-feu LLM combinant un proxy inverse SSE (ou via des API LLM) et des garde-fous pour l'IA sera le bon paradigme pour atteindre la sécurité Zero Trust. Indépendamment du modèle de déploiement, la découverte continue, le red teaming et les audits de configuration seront également cruciaux.

La figure ci-dessus illustre une architecture complète pour sécuriser l'utilisation du LLM à partir de l'entreprise ou d'utilisateurs et d'appareils de confiance. Une approche similaire pour les clients et les appareils non gérés se concentrera principalement sur le flux inférieur, qui comprend uniquement le proxy inverse.

Il est essentiel de s'attaquer à ces risques de sécurité dès le début du déploiement de l'IA fondamentale pour garantir le succès et la sécurité des systèmes d'IA. Pour renforcer la sécurité de l'IA au niveau de cette couche fondamentale, les organisations doivent :

- Effectuez des audits réguliers: Veillez à ce que les systèmes d'IA soient régulièrement examinés pour détecter les vulnérabilités par injection rapide, les mauvaises configurations et les problèmes de traitement des données.

- Mettez en œuvre la validation des entrées: Utilisez des mécanismes robustes pour valider les invites et les entrées, afin de réduire le risque d'attaques par ingénierie.

- Adoptez des mesures de protection des données: Établissez de solides cadres de gouvernance des données pour minimiser le risque de fuite de données lors des interactions avec l'IA.

- Sécurisez les environnements d'IA: Suivez les meilleures pratiques pour configurer les systèmes d'IA, en particulier lors de l'intégration de plugins ou de services tiers.

La voie à suivre : Sécuriser l'IA dès le départ

L'IA fondamentale sert d'épine dorsale à de nombreuses applications d'IA avancées, mais elle présente également des risques de sécurité importants, notamment des attaques d'ingénierie rapides, des fuites de données et des configurations erronées. Alors que l'IA continue de jouer un rôle central dans l'innovation au sein des industries, les entreprises doivent donner la priorité à la sécurité dès le début, en commençant par cette couche fondamentale.

Le prochain blog de notre série explorera les besoins et les opportunités de sécurité associés à la couche 2 : les copilotes d'IA, les assistants virtuels et les outils de productivité qui peuvent aider à guider la prise de décision et automatiser une grande variété de tâches. Pour en savoir plus sur la sécurisation de vos applications d'IA et l'atténuation des risques, découvrez les solutions Skyhigh AI.

Autres blogs dans cette série :

- Partie 1 - Sécurité de l'IA : Besoins des clients et opportunités

- Partie 2 - L'IA fondamentale : une couche critique avec des défis en matière de sécurité

- Partie 3 - Risques et défis en matière de sécurité avec les copilotes IA

Contenu connexe

Des exigences de la DPDPA à la visibilité des données : l'importance du DSPM

Blogs en vogue

Les attributs LLM que tout RSSI devrait surveiller actuellement

Sarang Warudkar 18 février 2026

Des exigences de la DPDPA à la visibilité des données : l'importance du DSPM

Niharika Ray et Sarang Warudkar 12 février 2026

Skyhigh Security 2025 : contrôle plus précis, visibilité plus claire et action plus rapide sur les données, le Web et le cloud

Thyaga Vasudevan 21 janvier 2026

Le risque caché de l'IA générique qui pourrait coûter des millions à votre entreprise (et comment y remédier dès aujourd'hui)

Jesse Grindeland 18 décembre 2025

Skyhigh Security : 2026 sera l'année où l'IA imposera un nouveau modèle pour la sécurité des entreprises

Thyaga Vasudevan 12 décembre 2025