Ressources

Adoptez ChatGPT sans mettre en péril les données critiques de votre entreprise

Par Tony Frum - Spécialiste produit, Skyhigh Security

6 juin 2023 6 Lecture minute

Ayant grandi en sachant utiliser un téléphone à cadran, j'ai vu pas mal de progrès technologiques au cours de ma vie. Toutefois, je pense qu'elles ne sont pas à la hauteur de ce que mes enfants verront au cours de leur vie grâce à l'avènement de l'intelligence artificielle (IA). Les experts dans ce domaine utilisent des comparaisons exagérées comme la bombe atomique et la découverte du feu pour décrire son importance, et il y a de fortes chances qu'il ne s'agisse pas d'exagérations.

Cette évolution suscite une grande consternation, certains réclamant des mesures de sécurité, des réglementations gouvernementales, voire un moratoire sur la recherche en matière d'IA. Dans le domaine de la cybersécurité, l'utilisation d'outils d'IA tels que ChatGPT et leurs implications pour la sécurité des données suscitent beaucoup d'inquiétude. En tant que fournisseur de Security Service Edge (SSE) maniaquement axé sur les données, nous, chez Skyhigh Security nous sommes interrogés au moins une fois par jour sur la manière dont la perte de données par ChatGPT peut être évitée. Nos clients prennent connaissance de situations telles que l'incident de perte de données de Samsung via ChatGPT et veulent s'assurer qu'ils ont mis en place les bons contrôles.

Malgré la nouveauté d'outils comme ChatGPT, je dois résister à l'envie de citer l'Ecclésiaste : "Il n'y a rien de nouveau sous le soleil". Bien que le risque spécifique d'un modèle d'IA entraîné sur vos données puisse être une nouveauté, la logistique de la protection de vos données contre ChatGPT n'est en fait pas nouvelle. C'est ce que nous faisons tous les jours ! Et, pour parler franchement, si vous avez mis en place les bons contrôles de sécurité des données, vous devriez déjà avoir toutes les cartes en main. Passons brièvement en revue les contrôles applicables, dont beaucoup sont probablement déjà en place, et la manière dont ils peuvent vous aider à faire face à ce nouveau risque, qui n'est pas si nouveau.

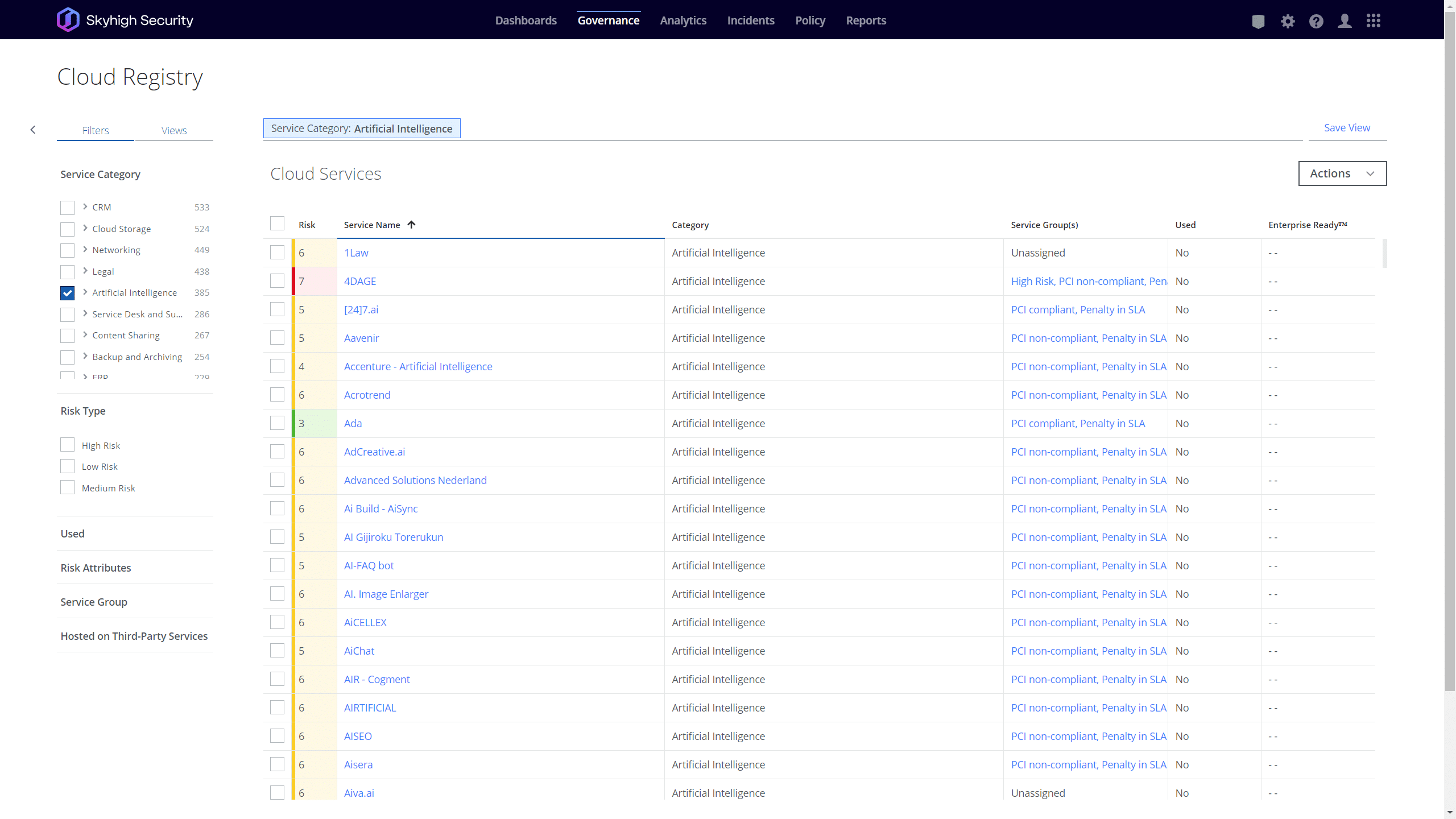

Blocage par catégorie/application

De nombreuses organisations n'ont pas d'appétit pour les risques posés par les chatbots et autres services d'IA générative. Pour ces entités, le blocage pur et simple de l'utilisation de ces applications est leur stratégie préférée. Apple a récemment rejoint une liste de plus en plus longue de ces entreprises. Mais, comme je le dis depuis des années à nos clients de Secure Web Gateway (SWG), "Bloquer quelque chose est facile. Tout le monde peut le faire. Savoir ce qu'il faut bloquer est la partie la plus difficile". Cela étant dit, tout GTS digne de ce nom devrait déjà être au courant de l'existence de ces outils d'IA et devrait être en mesure d'élaborer facilement une politique visant à les bloquer. À l'heure où nous écrivons ces lignes, le registre cloud deSkyhigh Security contient une analyse de risque complète de plus de 400 applications d'IA, et la liste s'allonge de jour en jour ! Chacune d'entre elles comprend plus de 65 attributs de risque et une liste de tous les domaines liés aux applications. En quelques clics, ces données riches peuvent être exploitées dans les politiques de sécurité web de nos clients pour contrôler ces applications. Pour les clients qui cherchent à interdire l'utilisation de chatbots d'IA, c'est le "bouton facile" pour eux.

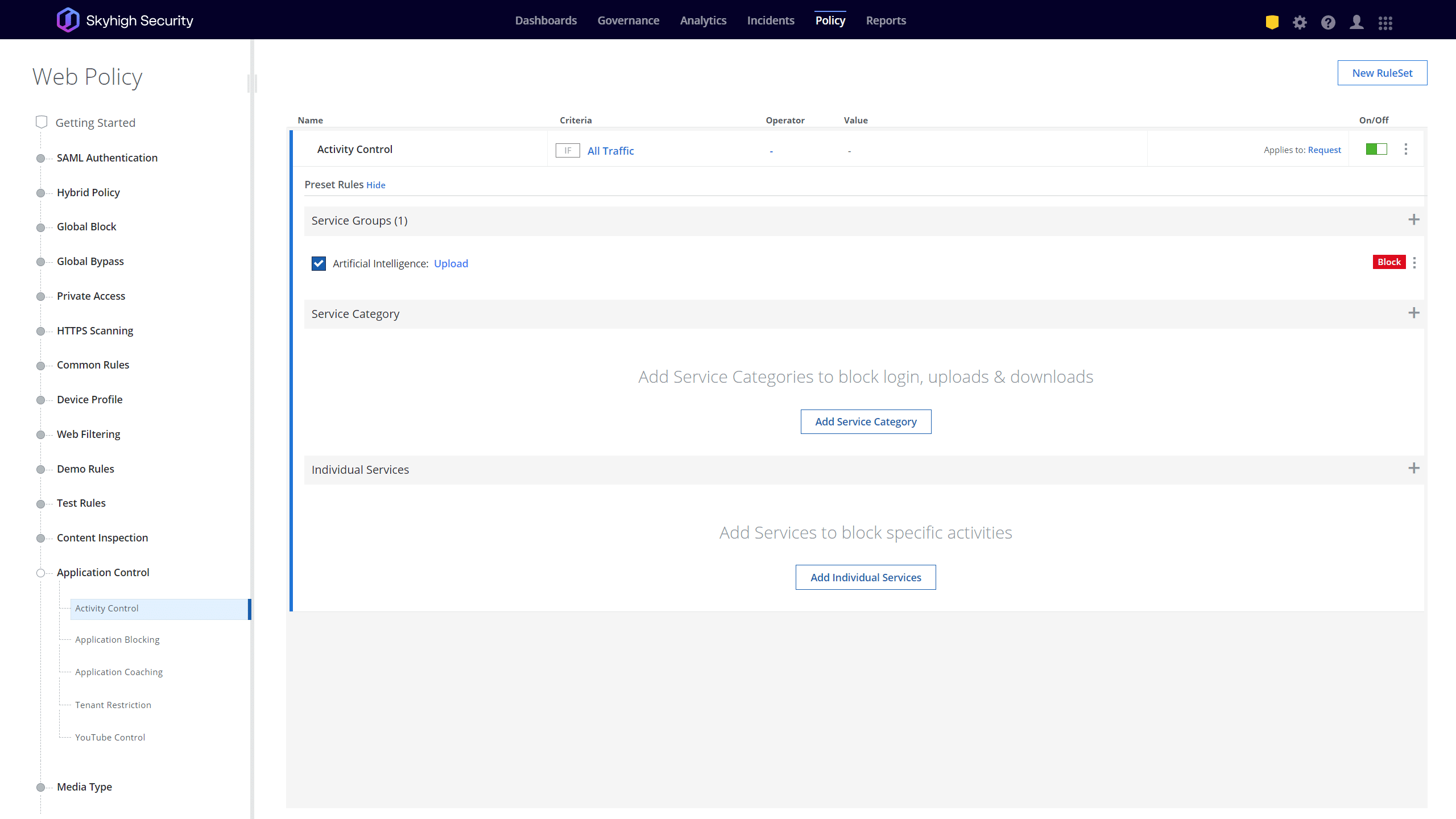

Restreindre des activités spécifiques

Certaines organisations considèrent qu'il est utile d'autoriser l'utilisation de chatbots d'IA, mais veulent s'assurer que leurs données les plus critiques restent sécurisées. Il existe aujourd'hui plusieurs façons d'écorcher ce chat proverbial. Une option consiste à utiliser le contrôle d'activité pour autoriser une application basée sur l'IA, mais pour empêcher certaines activités telles que le téléchargement de fichiers ou l'envoi d'invites. Le SWG de Skyhigh prend en charge les contrôles d'activité pour les plus de 35 000 applications de notre registre, y compris les plus de 400 applications classées comme IA. Là encore, en quelques clics, vous pouvez empêcher le téléchargement de tout contenu vers ces applications en quelques minutes.

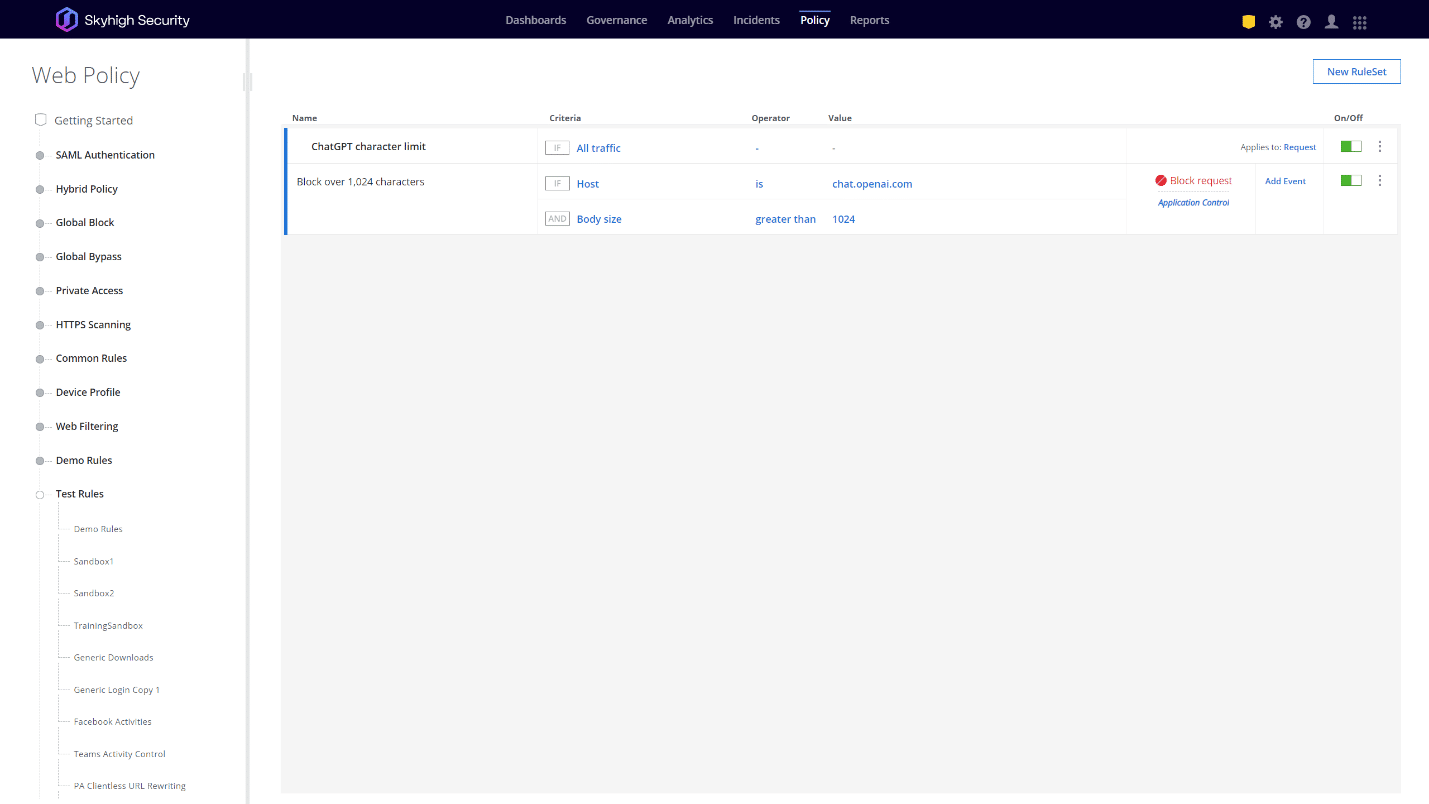

Bien entendu, certaines applications, comme ChatGPT, peuvent être rendues inutiles si l'on empêche des activités telles que l'envoi de questions. À quoi bon autoriser l'application si vous ne pouvez pas lui poser de questions ? Dans ce cas, les clients peuvent adopter une approche plus nuancée. Samsung, par exemple, a d'abord réagi aux fuites de données en limitant les invites de ChatGPT à 1 024 octets. D'autres options peuvent consister à empêcher le téléchargement de certains types de fichiers, à limiter l'accès en fonction de la géolocalisation, etc. Pour nombre de ces options, un moteur de politique Web très granulaire est nécessaire. La solution Skyhigh SWG possède, sans aucun doute, le moteur de politique Web le plus puissant et le plus granulaire sur le marché aujourd'hui, ce qui permet de réaliser rapidement des cas d'utilisation tels que ceux-ci. Par exemple, avec une seule règle personnalisée, nos clients peuvent mettre en œuvre une politique qui bloque toute requête adressée à une plateforme basée sur l'IA si elle dépasse 1024 octets. Ainsi, quelle que soit votre approche préférée, nous sommes susceptibles de vous permettre d'exercer ce contrôle en toute simplicité.

Protéger les données critiques de votre entreprise

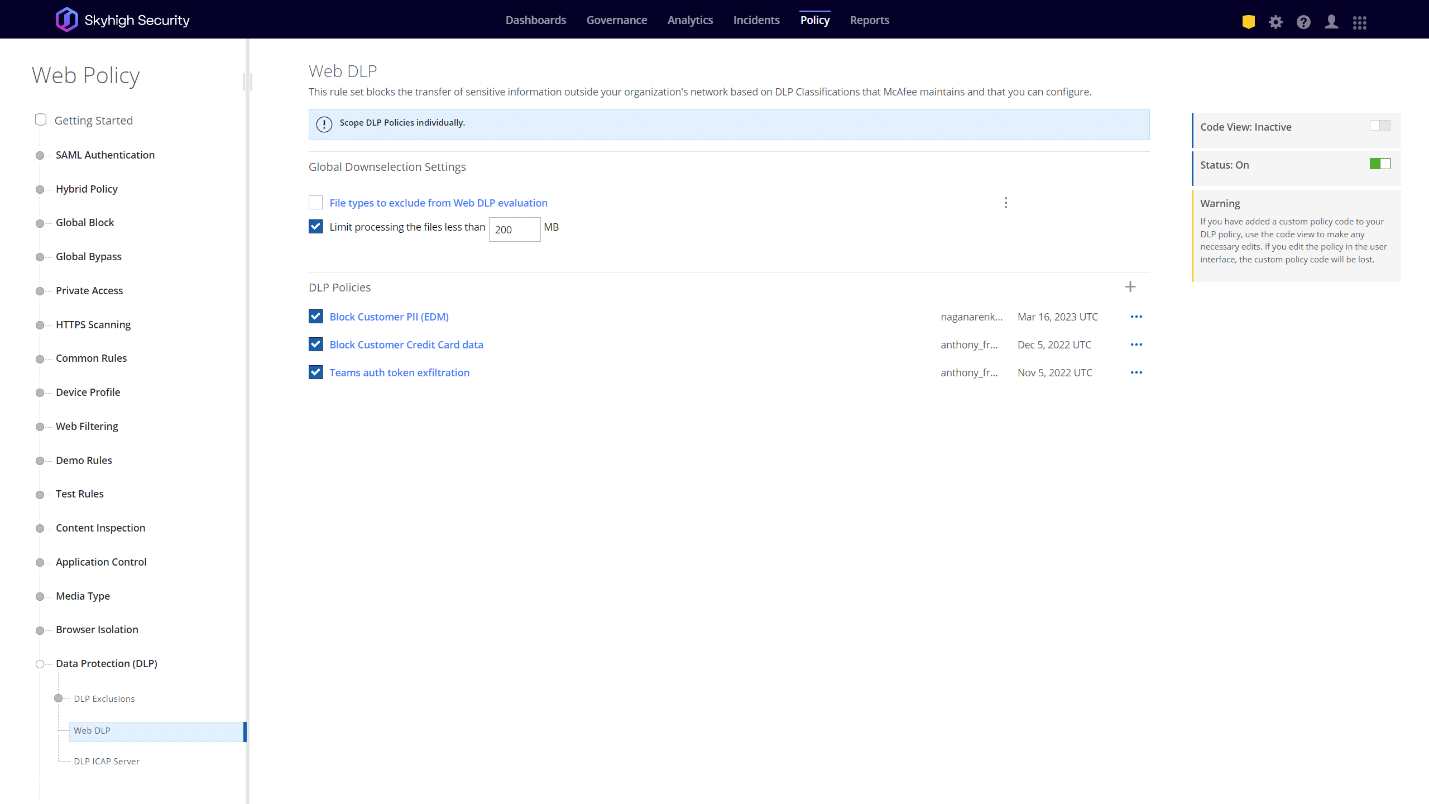

Personnellement, je pense que la meilleure approche passe par la connaissance des données. Dans le monde actuel basé sur le cloud, les organisations devraient déjà avoir une bonne idée des données qu'elles doivent protéger, et elles devraient appliquer une politique visant à empêcher l'envoi de ces données à toute application externe qui n'est pas approuvée et correctement sécurisée par l'organisation. À cet égard, ChatGPT n'est pas vraiment différent d'un compte Dropbox personnel. Votre organisation peut autoriser et tolérer l'utilisation d'un compte Dropbox personnel, mais elle devrait également s'assurer que ses données les plus critiques ne sont pas téléchargées vers cette application non approuvée et non sécurisée. De la même manière, les organisations dotées de programmes de sécurité des données matures auront probablement déjà une politique visant à empêcher l'exfiltration de données sensibles vers toute application non approuvée, ce qui devrait naturellement s'étendre à des applications telles que ChatGPT. Les clients de Skyhigh Security ont déjà une longueur d'avance dans ce domaine car ils utilisent déjà un moteur Data Loss Prevention (DLP) mature et très avancé avec des capacités robustes telles que Exact Data Match (EDM), Indexed Data Matching (IDM), Optical Character Recognition (OCR), et bien d'autres.

Un développement récent d'OpenAI qui apporte un espoir supplémentaire est un nouveau contrôle pour désactiver l'historique des conversations de ChatGPT et l'entraînement sur ces conversations. En appuyant simplement sur un interrupteur dans l'interface utilisateur, les utilisateurs peuvent indiquer qu'ils ne veulent pas que leurs données soient stockées et qu'elles ne soient pas utilisées pour l'entraînement de ChatGPT. Les utilisateurs devront activer manuellement cette option, qui est désactivée par défaut, mais elle offre une couche de sécurité supplémentaire pour empêcher le modèle ChatGPT d'être formé sur des données potentiellement sensibles. Skyhigh Security a déjà testé une politique dans notre solution SWG qui force cette nouvelle option à être activée pour tout appareil géré passant par notre proxy, quel que soit le compte dans lequel l'utilisateur est connecté.

Sanctionner le service

OpenAI a également annoncé des plans pour un abonnement ChatGPT Business à l'avenir. Avec cette nouvelle option d'abonnement, les organisations pourront créer des comptes professionnels pour leurs utilisateurs et gérer de manière centralisée la manière dont leurs données sont traitées. Cela pourrait, potentiellement, mettre en jeu plusieurs autres capacités de la plateforme Skyhigh Security SSE. La première est ce que nous appelons les "restrictions de locataire", qui vous permettent de n'autoriser les connexions qu'à votre locataire sanctionné, ou instance, d'une application, tout en bloquant les comptes personnels et tiers. Cet aspect sera essentiel si les organisations souhaitent suivre la voie de ChatGPT Business pour appliquer des politiques de traitement des données dans l'ensemble de l'entreprise. Cela serait futile si vous ne pouviez pas empêcher les utilisateurs de se connecter à des comptes ChatGPT personnels non contrôlés.

Skyhigh SecurityL'équipe d'ingénieurs d'OpenAI a déjà réalisé avec succès une démonstration de faisabilité en interagissant avec les API d'OpenAI pour examiner les fichiers téléchargés sur la plateforme OpenAI en utilisant la partie cloud access security broker (CASB ) de notre portefeuille. Bien que les API d'OpenAI ne prennent pas encore en charge tous les cas d'utilisation, nous continuerons à rechercher des possibilités d'analyser et de remédier aux données sensibles des locataires d'entreprise dans le cadre d'un processus hors bande utilisant nos capacités API CASB.

De même, si ChatGPT offre la possibilité d'utiliser l'authentification unique (SSO) à partir d'un fournisseur d'identité tiers, la technologie CASB de Skyhigh Securitypourra apporter de la valeur. En se connectant au processus de transfert SAML entre ChatGPT et un fournisseur d'identité tiers, le CASB peut se mettre en ligne pour n'importe quel appareil dans le monde s'authentifiant auprès de votre locataire ChatGPT et effectuer un contrôle d'accès à l'appareil. De cette manière, nous pourrions restreindre l'accès à ChatGPT de votre organisation afin que seuls les appareils de confiance y aient accès. Il n'a pas été confirmé, à l'heure où nous écrivons ces lignes, qu'OpenAI prévoit d'offrir le SSO, mais c'est très probable car il s'agit d'une approche courante pour l'authentification et la gestion des comptes.

Pour mes collègues de Skyhigh Security, ce dont nous venons de parler ressemble à un bref résumé de nos conversations quotidiennes avec les clients. Voici ce que nous faisons. Les chatbots d'IA, et plus particulièrement le ChatGPT, peuvent apporter une nouvelle tournure au risque de perte de données, mais pour les professionnels de la sécurité des données, il s'agit toujours du même travail nécessitant les mêmes outils et avec les mêmes enjeux. Il y a de fortes chances que vous soyez déjà préparé avec bon nombre de ces outils, mais si vous trouvez que vos contrôles de sécurité sont insuffisants, donnez-nous une chance de vous montrer comment nous pouvons vous aider. Nous sommes tout à fait dans notre rôle, car la protection des données de nos clients est ce que nous faisons tous les jours.

Pour en savoir plus sur la manière dont Skyhigh Security peut vous aider , contactez-nous dès aujourd'hui.

Retour à BlogsContenu connexe

Des exigences de la DPDPA à la visibilité des données : l'importance du DSPM

Blogs en vogue

Les attributs LLM que tout RSSI devrait surveiller actuellement

Sarang Warudkar 18 février 2026

Des exigences de la DPDPA à la visibilité des données : l'importance du DSPM

Niharika Ray et Sarang Warudkar 12 février 2026

Skyhigh Security 2025 : contrôle plus précis, visibilité plus claire et action plus rapide sur les données, le Web et le cloud

Thyaga Vasudevan 21 janvier 2026

Le risque caché de l'IA générique qui pourrait coûter des millions à votre entreprise (et comment y remédier dès aujourd'hui)

Jesse Grindeland 18 décembre 2025

Skyhigh Security : 2026 sera l'année où l'IA imposera un nouveau modèle pour la sécurité des entreprises

Thyaga Vasudevan 12 décembre 2025