Recursos

IA fundacional: una capa crítica con retos de seguridad

Por Sekhar Sarukkai - Ciberseguridad@UC Berkeley

10 de octubre de 2024 5 Minuto de lectura

En el primer blog de nuestra serie, "Seguridad de la IA: Necesidades y oportunidades de los clientes", proporcionamos una visión general de las tres capas de la pila tecnológica de la IA y sus casos de uso, junto con un resumen de los retos y soluciones de seguridad de la IA. En este segundo blog, abordamos los riesgos específicos asociados a la Capa 1: IA fundacional y las mitigaciones que pueden ayudar a las organizaciones a aprovechar las numerosas ventajas de la IA en beneficio de su negocio.

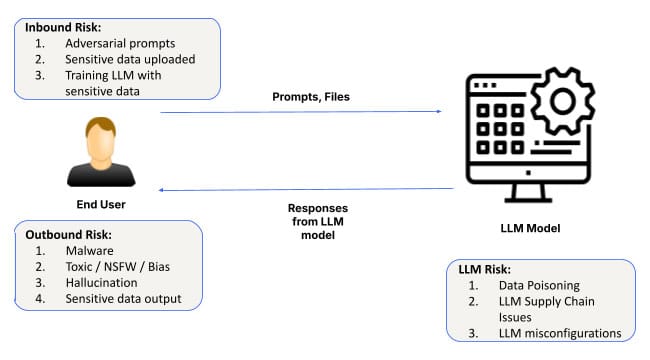

A medida que la inteligencia artificial (IA) sigue evolucionando y afianzándose, sus aplicaciones abarcan sectores que van desde la sanidad a las finanzas. En el corazón de todo sistema de IA se encuentran los modelos fundacionales y la infraestructura de software para personalizar esos modelos. Esta capa proporciona la base para todas las aplicaciones de IA, permitiendo a los sistemas aprender de los datos, detectar patrones y hacer predicciones. Sin embargo, a pesar de su importancia, la capa fundacional de la IA no está exenta de riesgos. Desde los ataques de ingeniería de pronóstico, pasando por las configuraciones erróneas, hasta la fuga de datos, los retos de seguridad en esta capa pueden tener consecuencias de gran alcance.

Profundicemos en los riesgos de seguridad asociados a la IA fundacional y en lo que las empresas deben tener en cuenta al adoptar soluciones basadas en la IA.

Riesgos de seguridad en la capa fundacional de la IA

1. Provocar ataques de ingeniería

Uno de los riesgos más frecuentes en la capa de la IA Fundacional es la ingeniería de indicaciones, en la que los atacantes manipulan las entradas de la IA para producir salidas no deseadas o dañinas. Estos ataques aprovechan las vulnerabilidades en la forma en que los modelos de IA interpretan y responden a las indicaciones, lo que permite a los actores maliciosos eludir los protocolos de seguridad.

Nuevas técnicas como SkeletonKey y CrescendoMation han hecho de la ingeniería rápida una amenaza creciente, con diversas formas de "jailbreaking" de los sistemas de IA convirtiéndose en algo habitual. Estos ataques pueden encontrarse en la web oscura, con herramientas como WormGPT, FraudGPT y EscapeGPT que se venden abiertamente a los piratas informáticos. Una vez que un modelo de IA se ve comprometido, puede generar respuestas engañosas o peligrosas, provocando violaciones de datos o fallos del sistema.

Por ejemplo, un atacante podría inyectar mensajes en un sistema de IA de atención al cliente, saltándose las restricciones del modelo para acceder a datos sensibles de los clientes o manipular los resultados para causar una interrupción operativa.

Para mitigar este riesgo, las organizaciones deben implantar sólidos mecanismos de validación de entradas y auditar periódicamente los sistemas de IA en busca de posibles vulnerabilidades, especialmente cuando se utilizan avisos para controlar procesos empresariales significativos.

2. Fuga de datos

La fuga de datos es otra preocupación importante en la capa de IA fundacional. Cuando las organizaciones utilizan modelos de IA para tareas como la generación de perspectivas a partir de datos sensibles, existe el riesgo de que parte de esta información quede expuesta inadvertidamente durante las interacciones con la IA. Esto es especialmente cierto en el ajuste fino de los modelos o durante las conversaciones prolongadas con los LLM (Large Language Models).

Un ejemplo notable se produjo cuando los ingenieros de Samsung filtraron accidentalmente datos corporativos sensibles a través de interacciones con ChatGPT. Este tipo de incidentes subraya la importancia de tratar los datos prompt como no privados por defecto, ya que podrían incorporarse fácilmente a los datos de entrenamiento de la IA. Si bien vemos avances continuos para la protección de la privacidad en la capa del modelo base, seguirá siendo necesario optar por la exclusión para garantizar que ningún dato puntual encuentre su camino en el modelo.

Además, las formas históricamente explotadas de exfiltración de datos podrían desplegarse más fácilmente en el contexto de una conversación de larga duración con los LLM. También habrá que tener en cuenta cuestiones como el exploit de markdown de imágenes en el chatbot de Bing, así como ChatGPT, especialmente con despliegues privados de LLM.

Las técnicas de exfiltración de datos que históricamente se han dirigido a los sistemas tradicionales también se están adaptando a los entornos de IA. Por ejemplo, las interacciones de chatbot de larga duración podrían ser explotadas por atacantes que utilicen tácticas como los exploits de marcado de imágenes (como se ha visto en ChatGPT) para extraer sigilosamente datos sensibles a lo largo del tiempo.

Las organizaciones pueden hacer frente a este riesgo adoptando políticas estrictas de tratamiento de datos y aplicando controles para garantizar que la información sensible no quede expuesta inadvertidamente a través de los modelos de IA.

3. Instancias mal configuradas

Los errores de configuración son una fuente común de vulnerabilidades de seguridad, y esto es particularmente cierto en la capa de IA fundacional. Dado el rápido despliegue de los sistemas de IA, muchas organizaciones luchan por configurar adecuadamente sus entornos de IA, dejando los modelos expuestos a posibles amenazas.

Las instancias de IA mal configuradas -como permitir plugins de terceros que no sean de confianza, habilitar la integración de datos externos sin los controles adecuados o conceder permisos excesivos a los modelos de IA- pueden dar lugar a importantes filtraciones de datos. En los modelos de responsabilidad compartida, las organizaciones también pueden no aplicar las restricciones necesarias, lo que aumenta el riesgo de acceso no autorizado o de exfiltración de datos.

Por ejemplo, ChatGPT permite que los plugins se integren con servicios de terceros, lo que puede ser una fuente importante de fugas de datos si plugins no fiables se conectan inadvertidamente a instancias de la empresa. Del mismo modo, una configuración inadecuada del control de acceso puede dar lugar a que usuarios no autorizados accedan a datos confidenciales a través de sistemas de IA.

Aunque el "red teaming" no es un concepto nuevo, es especialmente importante en todas las capas de la pila de IA, ya que los LLM actúan como cajas negras y sus resultados no son predecibles. Por ejemplo, la investigación de Anthropic, demostró que los LLM pueden convertirse en agentes durmientes con ataques ocultos en los pesos del modelo que pueden salir a la superficie de forma inesperada.

Para reducir este riesgo, las organizaciones deben seguir las mejores prácticas para la configuración de la IA limitando la integración de servicios de terceros, restringiendo los permisos y revisando periódicamente las configuraciones del entorno de IA. Skyhigh Security's secure use of AI applications solutions proporciona las herramientas y las mejores prácticas para garantizar que los sistemas de IA estén correctamente configurados y protegidos.

Reforzar la seguridad de la IA en la capa 1

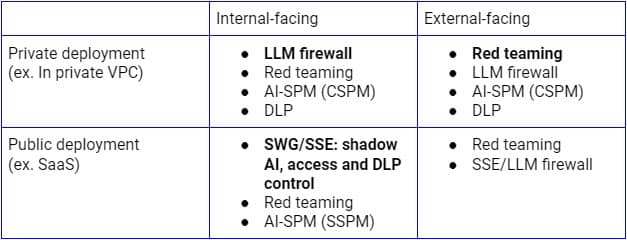

Los riesgos de seguridad mencionados deben abordarse en función de los distintos casos de uso. Para los despliegues públicos de LLM orientados hacia el interior, Secure Service Edge (SSE proxy inverso) es la plataforma lógica sobre la que extender los controles a las aplicaciones SaaS de IA, puesto que las empresas ya la utilizan para descubrir, controlar el acceso y proteger los datos de todas las aplicaciones y servicios SaaS. Por otro lado, para los despliegues en infraestructuras privadas, un cortafuegos LLM que sea una combinación de proxy inverso SSE (o a través de API LLM) y guardarraíles de IA será el paradigma adecuado para lograr la seguridad de Confianza Cero. Independientemente del modelo de despliegue, el descubrimiento continuo, el red teaming y las auditorías de configuración también serán cruciales.

La figura anterior ilustra una arquitectura integral para asegurar el uso de LLM desde dentro de la empresa o desde usuarios y dispositivos de confianza. Un enfoque similar para clientes y dispositivos no gestionados se centrará principalmente en el flujo inferior, que incluye únicamente el proxy inverso.

Abordar estos riesgos de seguridad en una fase temprana del despliegue de la IA fundacional es crucial para garantizar el éxito y la seguridad de los sistemas de IA. Para reforzar la seguridad de la IA en esta capa fundacional, las organizaciones deben:

- Realice auditorías periódicas: Asegúrese de que los sistemas de IA se revisan regularmente en busca de vulnerabilidades de inyección rápida, configuraciones erróneas y problemas de manejo de datos.

- Implemente la validación de entradas: Utilice mecanismos robustos para validar las solicitudes y las entradas, reduciendo así el riesgo de ataques de ingeniería de solicitudes.

- Adopte medidas de protección de datos: Establezca marcos sólidos de gobernanza de datos para minimizar el riesgo de fuga de datos durante las interacciones con la IA.

- Asegure los entornos de IA: Siga las mejores prácticas para configurar los sistemas de IA, especialmente cuando integre complementos o servicios de terceros.

El camino a seguir: Asegurar la IA desde la base

La IA fundacional sirve de columna vertebral para muchas aplicaciones avanzadas de IA, pero también introduce importantes riesgos de seguridad, como ataques de ingeniería rápida, fugas de datos y configuraciones erróneas. A medida que la IA sigue desempeñando un papel fundamental en el impulso de la innovación en todos los sectores, las empresas deben dar prioridad a la seguridad desde el principio, empezando por esta capa fundacional.

El próximo blog de nuestra serie explorará las necesidades y oportunidades de seguridad asociadas a la Capa 2: Copilotos de IA, asistentes virtuales y herramientas de productividad que pueden ayudar a guiar la toma de decisiones y automatizar una amplia variedad de tareas. Para obtener más información sobre cómo proteger sus aplicaciones de IA y mitigar los riesgos, explore las soluciones de IA de Skyhigh.

Otros blogs de esta serie:

- Parte 1 - Seguridad de la IA: Necesidades y oportunidades de los clientes

- Parte 2 - IA fundacional: una capa crítica con retos de seguridad

- Parte 3 - Riesgos y retos de seguridad con los copilotos de IA

Contenido relacionado

De los requisitos de la DPDPA a la visibilidad de los datos: la importancia del DSPM

Skyhigh Security 2025: control más preciso, visibilidad más clara y acción más rápida en datos, web y nube.

Blogs de moda

Atributos LLM que todo CISO debería seguir hoy en día

Sarang Warudkar 18 de febrero de 2026

De los requisitos de la DPDPA a la visibilidad de los datos: la importancia del DSPM

Niharika Ray y Sarang Warudkar 12 de febrero de 2026

Skyhigh Security 2025: control más preciso, visibilidad más clara y acción más rápida en datos, web y nube.

Thyaga Vasudevan 21 de enero de 2026

El riesgo oculto de la IA generativa que podría costarle millones a su empresa (y cómo solucionarlo hoy mismo)

Jesse Grindeland 18 de diciembre de 2025

Skyhigh Security : 2026 es el año en que la IA impondrá un nuevo modelo de seguridad empresarial

Thyaga Vasudevan 12 de diciembre de 2025