Risorse

Adotti il ChatGPT senza mettere a rischio i suoi dati aziendali critici

Di Tony Frum - Specialista di prodotto, Skyhigh Security

6 giugno 2023 6 Minuti di lettura

Essendo cresciuta sapendo usare un telefono rotativo, ho visto una discreta quantità di progressi tecnologici nei miei anni. Tuttavia, penso che potrebbe impallidire rispetto a ciò che vedranno i miei figli nella loro vita, grazie all'avvento dell'Intelligenza Artificiale (AI). Gli esperti del settore usano paragoni esagerati come la bomba atomica e la scoperta del fuoco per descriverne l'importanza, e c'è una buona probabilità che non si tratti di esagerazioni.

C'è una grande costernazione intorno a questo sviluppo, con alcuni che chiedono misure di sicurezza, regolamenti governativi e persino una moratoria sulla ricerca sull'AI. Nel campo della cybersecurity, c'è una grande ansia riguardo all'uso di strumenti di AI come ChatGPT e alle loro implicazioni per la sicurezza dei dati. In qualità di fornitore di Security Service Edge (SSE) focalizzato sui dati, noi di Skyhigh Security riceviamo almeno quotidianamente domande su come sia possibile prevenire la perdita di dati tramite ChatGPT. I nostri clienti leggono di situazioni come l'incidente della perdita di dati di Samsung tramite ChatGPT e vogliono assicurarsi di avere i giusti controlli.

Nonostante la novità di strumenti come ChatGPT, devo resistere all'impulso di citare l'Ecclesiaste che dice: "Non c'è niente di nuovo sotto il sole". Mentre il rischio specifico di un modello AI addestrato sui suoi dati può essere una novità, la logistica della protezione dei suoi dati da ChatGPT non è in realtà una novità. È quello che facciamo ogni giorno! E, per dirla senza mezzi termini, se dispone dei giusti controlli di sicurezza dei dati, dovrebbe avere già le basi coperte. Rivediamo brevemente i controlli applicabili, molti dei quali probabilmente già implementati, e come possono aiutarla ad affrontare questo nuovo, ma non così nuovo, rischio.

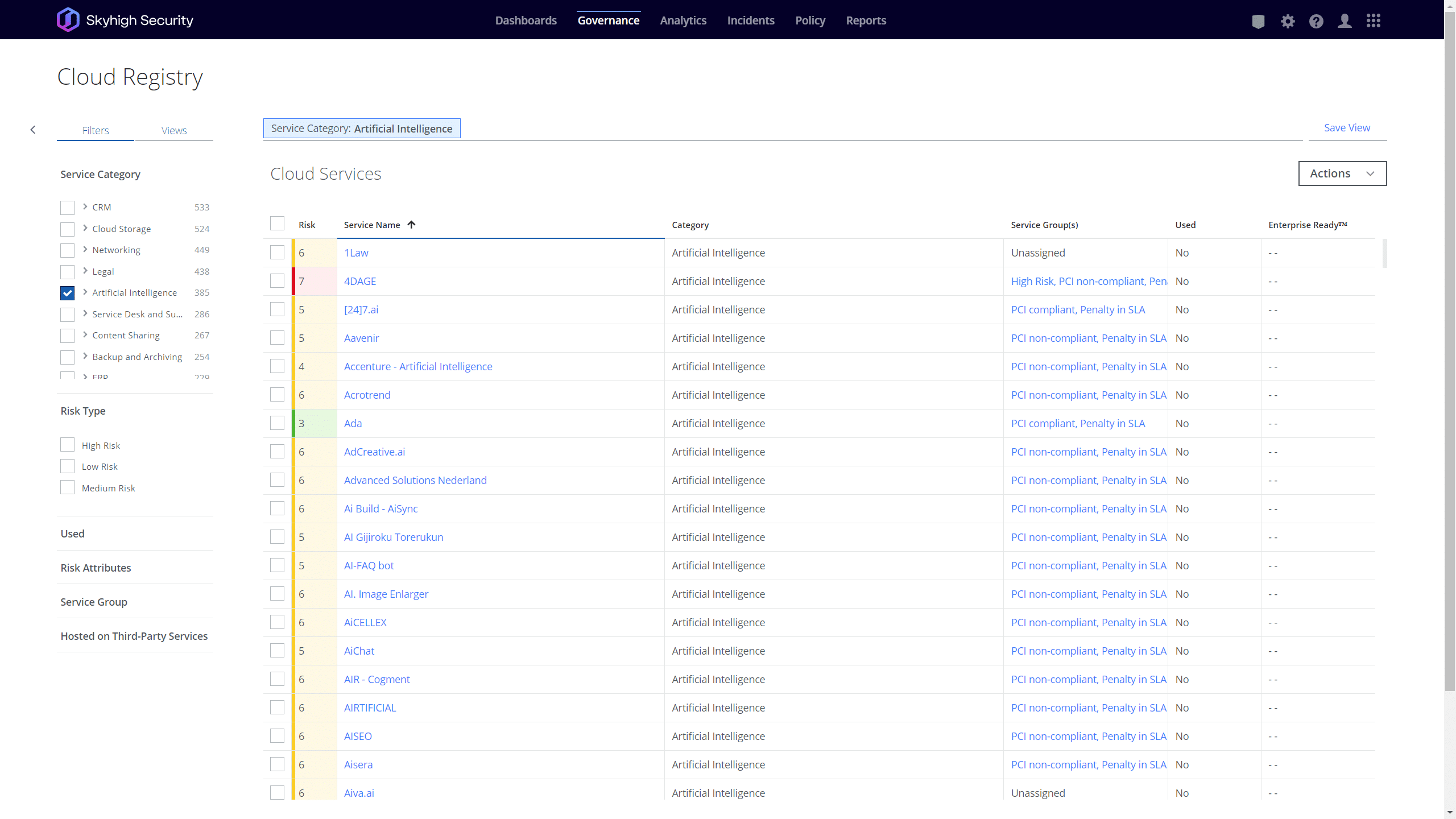

Blocco per categoria/app

Molte organizzazioni non sono disposte ad accettare i rischi posti dai chatbot AI e da altri servizi di AI generativa. Per queste entità, il blocco totale dell'uso di queste applicazioni è la strategia preferita. Apple si è recentemente unita a un elenco crescente di queste aziende. Ma, come ho detto per anni ai nostri clienti di Secure Web Gateway (SWG), "Bloccare qualcosa è facile. Tutti possono farlo. Sapere cosa bloccare è la parte difficile". Detto questo, qualsiasi SWG degno di nota oggi dovrebbe già essere a conoscenza di questi strumenti di AI e dovrebbe essere in grado di creare facilmente una politica per bloccarli. Al momento in cui scriviamo, il registro cloud diSkyhigh Security contiene un'analisi completa dei rischi di oltre 400 applicazioni AI, e l'elenco cresce ogni giorno! Ognuna di queste include oltre 65 attributi di rischio e un elenco di tutti i domini correlati alle applicazioni. Con un paio di clic, questi dati ricchi possono essere sfruttati nelle politiche di sicurezza web dei nostri clienti per controllare queste applicazioni. Per i clienti che desiderano vietare l'uso di chatbot AI, questo è il "pulsante facile" per loro.

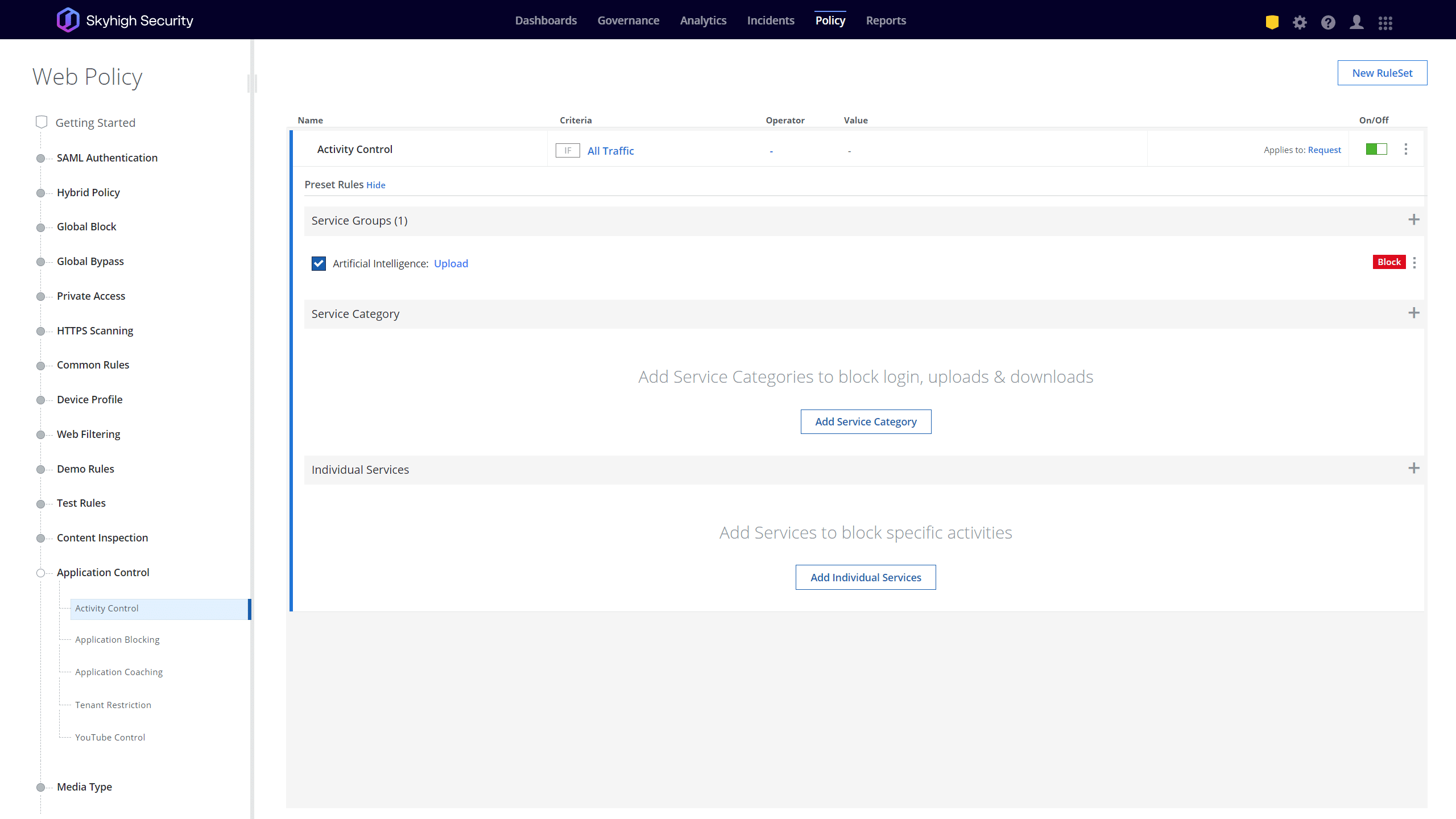

Limitare attività specifiche

Alcune organizzazioni vedono il valore di consentire l'uso di chatbot AI, ma vogliono garantire che i loro dati più critici rimangano sicuri. Oggi esistono diversi modi per scuoiare questo proverbiale gatto. Un'opzione è quella di utilizzare il Controllo attività per consentire un'applicazione basata sull'AI, ma per impedire alcune attività come il caricamento di file o l'invio di richieste. L'SWG di Skyhigh supporta il controllo delle attività per tutte le oltre 35k applicazioni presenti nel nostro registro, comprese le oltre 400 applicazioni classificate come AI. Anche in questo caso, con pochi clic può impedire il caricamento di qualsiasi contenuto in queste applicazioni in pochi minuti.

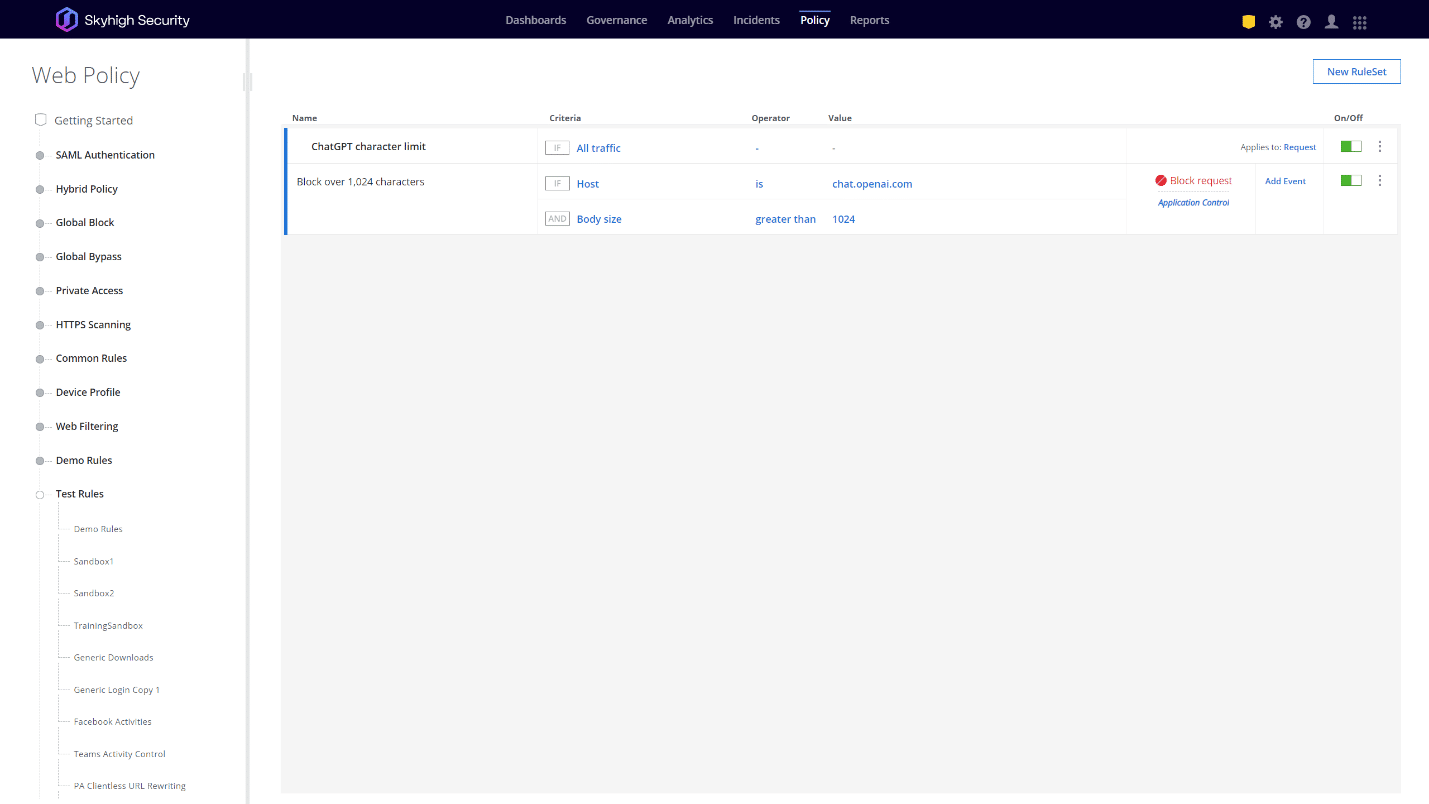

Naturalmente, alcune applicazioni, come ChatGPT, possono essere rese inutili impedendo attività come l'invio di domande. A cosa serve consentire l'applicazione se non si possono fare domande? In queste situazioni, i clienti potrebbero voler adottare un approccio più sfumato. Samsung, ad esempio, ha inizialmente risposto alle fughe di dati limitando le richieste di ChatGPT a 1.024 byte. Altre opzioni possono includere la prevenzione del caricamento di alcuni tipi di file, la limitazione dell'accesso in base alla geolocalizzazione e altro ancora. Per molte di queste opzioni, è necessario un motore di Web policy altamente granulare. La soluzione Skyhigh SWG ha, senza dubbio, il motore di criteri Web più potente e granulare oggi disponibile sul mercato, che consente di risolvere rapidamente casi d'uso come questi. Ad esempio, con un'unica regola personalizzata i nostri clienti possono implementare una policy che, se una richiesta a qualsiasi piattaforma basata sull'AI supera i 1024 byte, la blocca. Quindi, qualunque sia il suo approccio preferito, siamo in grado di consentirle di esercitare tale controllo con facilità.

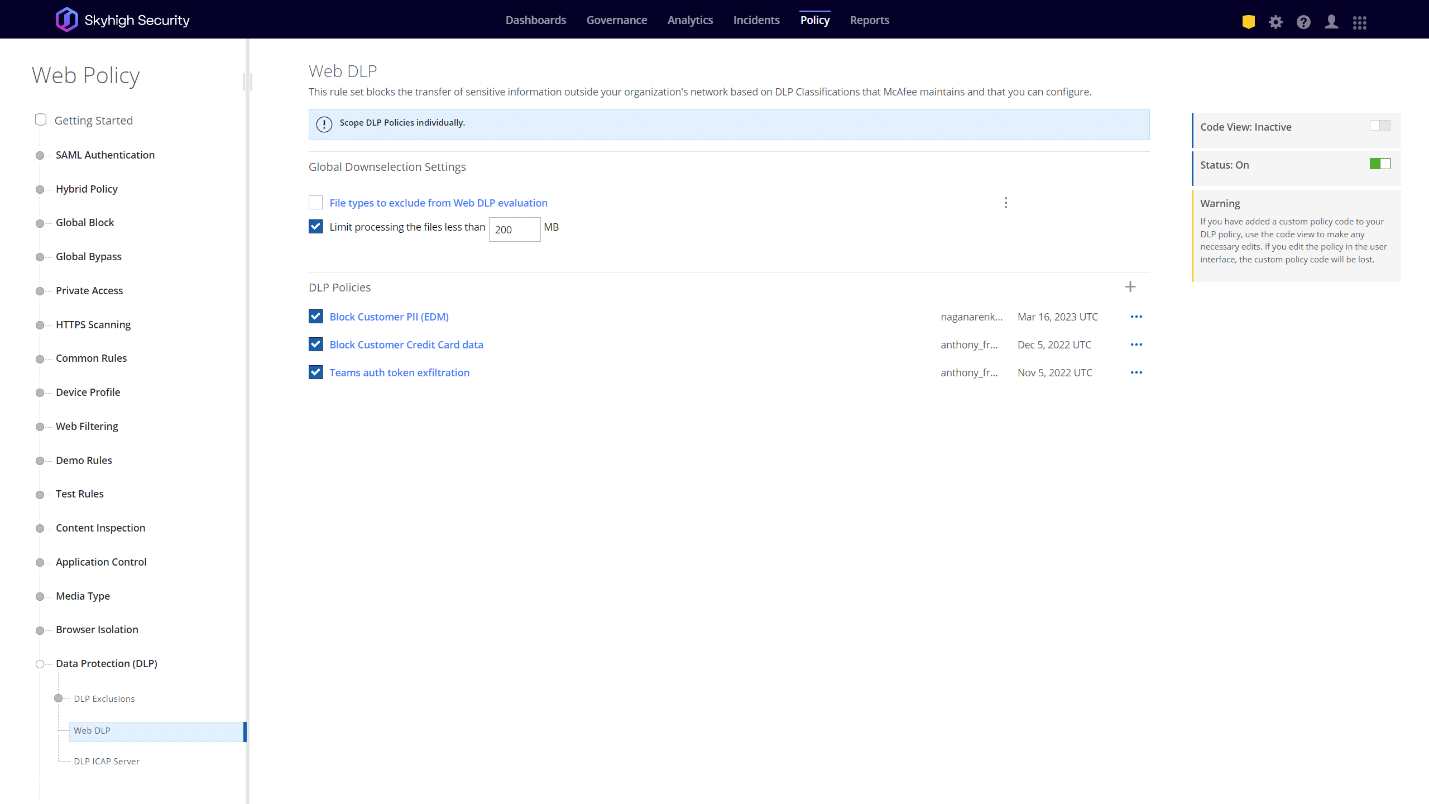

Proteggere i dati critici della sua azienda

Personalmente, ritengo che l'approccio migliore sia la consapevolezza dei dati. Nel mondo di oggi basato sul cloud, le organizzazioni dovrebbero già avere una buona conoscenza dei dati da proteggere, e dovrebbero applicare una politica per impedire l'invio di tali dati a qualsiasi applicazione esterna che non sia autorizzata e adeguatamente protetta dall'organizzazione. A questo proposito, ChatGPT non è diverso da un account Dropbox personale. La sua organizzazione può consentire e tollerare l'uso di Dropbox personale, ma dovrebbe anche assicurarsi che i suoi dati più critici non vengano caricati su questa applicazione non autorizzata e non protetta. Allo stesso modo, le organizzazioni con programmi di sicurezza dei dati maturi probabilmente dispongono già di una politica per impedire l'esfiltrazione dei dati sensibili in qualsiasi applicazione non autorizzata, che dovrebbe naturalmente estendersi ad applicazioni come ChatGPT. I clienti di Skyhigh Security sono già all'avanguardia in questo settore, in quanto sfruttano già un motore di Data Loss Prevention (DLP) maturo e altamente avanzato, con solide capacità come Exact Data Match (EDM), Indexed Data Matching (IDM), Optical Character Recognition (OCR) e altro ancora.

Un recente sviluppo di OpenAI che porta ulteriori speranze è un nuovo controllo per disabilitare la cronologia delle conversazioni di ChatGPT e la formazione su tali conversazioni. Con la semplice pressione di un interruttore nell'interfaccia utente, gli utenti possono indicare che non vogliono che i loro dati vengano memorizzati e che non vengano utilizzati per la formazione di ChatGPT. Gli utenti dovranno attivare manualmente questa opzione, che è disattivata per impostazione predefinita, ma offre un ulteriore livello di sicurezza per evitare che il modello ChatGPT venga addestrato su dati potenzialmente sensibili. Skyhigh Security ha già testato una politica nella nostra soluzione SWG che obbliga ad attivare questa nuova opzione per qualsiasi dispositivo gestito che passa attraverso il nostro proxy, indipendentemente dall'account dell'utente.

Sanzionare il servizio

OpenAI ha anche annunciato i piani per un abbonamento ChatGPT Business in futuro. Con questa nuova opzione di abbonamento, le organizzazioni potranno creare account aziendali per i loro utenti e gestire in modo centralizzato la gestione dei loro dati. Questo potrebbe potenzialmente mettere in gioco diverse altre funzionalità della piattaforma Skyhigh Security SSE. La prima è quella che noi chiamiamo "restrizione dell'inquilino", che consente di consentire l'accesso solo all'inquilino, o all'istanza, di un'applicazione da lei autorizzata, bloccando gli account personali e di terzi. Questo sarà fondamentale se le organizzazioni vogliono seguire la strada di ChatGPT Business per applicare le politiche di gestione dei dati in tutta l'azienda. Ciò sarebbe inutile se non fosse possibile impedire agli utenti di accedere ad account ChatGPT personali e non controllati.

Skyhigh SecurityIl team di ingegneri di OpenAI ha già eseguito con successo un proof of concept interagendo con le API di OpenAI per esaminare i file caricati sulla piattaforma OpenAI utilizzando la parte cloud access security broker (CASB) del nostro portafoglio. Sebbene le API di OpenAI non supportino ancora tutti i casi d'uso, continueremo a cercare opportunità per scansionare e rimediare ai dati sensibili nei tenant aziendali in un processo fuori banda, utilizzando le nostre capacità API CASB.

Allo stesso modo, se ChatGPT offre la possibilità di utilizzare il single sign-on (SSO) da un fornitore di identità di terze parti, la tecnologia CASB di Skyhigh Securitysarà in grado di apportare valore. Inserendosi nel processo di hand-off SAML tra ChatGPT e un provider di identità di terze parti, il CASB può essere in linea per qualsiasi dispositivo nel mondo che si autentica al suo tenant ChatGPT ed eseguire il controllo di accesso del dispositivo. In questo modo, saremo in grado di limitare l'accesso al ChatGPT della sua organizzazione, in modo che solo i dispositivi fidati possano accedervi. Non è stato confermato, al momento della stesura di questo articolo, che OpenAI abbia in programma di offrire il SSO, ma è altamente probabile, in quanto si tratta di un approccio comune per l'autenticazione e la gestione degli account.

Per i miei colleghi di Skyhigh Security, quello che abbiamo appena discusso sembrerà un breve riassunto delle nostre conversazioni quotidiane con i clienti. Ecco cosa facciamo. I chatbot AI, e in particolare ChatGPT, possono dare una nuova svolta al rischio di perdita di dati, ma per i professionisti della sicurezza dei dati si tratta sempre dello stesso lavoro che richiede gli stessi strumenti e la stessa posta in gioco. È probabile che lei sia già preparato con molti di questi strumenti, ma se ritiene che i suoi controlli di sicurezza siano carenti, ci dia la possibilità di mostrarle come possiamo aiutarla. Questo è proprio il nostro campo, perché proteggere i dati dei nostri clienti è ciò che facciamo ogni giorno.

Per saperne di più su come Skyhigh Security può aiutarla , ci contatti oggi stesso.

Torna ai blogContenuti correlati

Blog di tendenza

Attributi LLM che ogni CISO dovrebbe monitorare oggi

Sarang Warudkar 18 febbraio 2026

Dai requisiti DPDPA alla visibilità dei dati: l'imperativo DSPM

Niharika Ray e Sarang Warudkar 12 febbraio 2026

Skyhigh Security 2025: controllo più accurato, visibilità più chiara e azioni più rapide su dati, web e cloud

Thyaga Vasudevan 21 gennaio 2026

Il rischio nascosto della GenAI che potrebbe comportare costi significativi per la vostra azienda (e come risolverlo immediatamente)

Jesse Grindeland 18 dicembre 2025

Skyhigh Security : il 2026 sarà l'anno in cui l'intelligenza artificiale determinerà un nuovo modello di sicurezza aziendale.

Thyaga Vasudevan 12 dicembre 2025