リソース

AIオートパイロットの利点とリスクを比較する

By Sekhar Sarukkai - Cybersecurity@UC Berkeley

2024年10月25日 6 分で読む

前回のブログでは、AIコパイロット(タスクや意思決定を支援するが、依然として人間の入力に依存するシステム)に関連するセキュリティ上の課題について検討した。データポイズニング、権限の悪用、不正なAIコパイロットなどのリスクについて説明した。LangGraphや AutoGenのようなAIエージェントフレームワークの出現によってAIシステムが進歩するにつれて、セキュリティリスクの可能性は増大します。

シリーズ最終回となる今回のブログでは、レイヤー3「AIオートパイロット」-人間の介入をほとんど、あるいは全く必要とせずにタスクを実行できる自律エージェント・システム-に焦点を当てます。AIオートパイロットは、タスクの自動化と業務効率化に大きな可能性を提供する一方で、安全な導入のために組織が対処しなければならない重大なセキュリティ・リスクももたらします。

AIオートパイロットのメリットとリスク

エージェントシステムは、大規模言語モデル(LLM)と検索拡張世代(RAG)を基盤としている。また、内観、タスク分析、関数呼び出し、他のエージェントや人間を活用してタスクを完了させるなど、行動を起こす能力も追加される。このためエージェントは、エージェントと人間のアイデンティティを識別・検証し、アクションと結果が信頼に足るものであることを保証するためのフレームワークを使用する必要がある。LLMがレイヤ1で人間と対話するという単純な見方は、タスクを完了するために協力し合う、動的に形成されるエージェントのグループの集まりに置き換えられ、セキュリティの懸念は何倍にも増加します。実際、AnthropicのClaudeの最新リリースは、AIがあなたの代わりにコンピュータを使用することを可能にする機能であり、AIが自律的にタスクを完了するために必要なツールを使用することを可能にする。

1.不正または敵対的な自律行動

AIオートパイロットは、あらかじめ定義された目的に基づいて、独自にタスクを実行することができる。しかし、この自律性は、プログラミングの欠陥や敵対的な操作により、自動操縦が意図された動作から逸脱する可能性がある、不正な行動のリスクを開きます。不正なAIシステムは、データ漏洩から運用の失敗に至るまで、意図しない有害な結果を引き起こす可能性がある。

例えば、重要なインフラシステムを管理するAIオートパイロットが、入力データの誤認識やプログラミングの見落としにより、誤って送電網を遮断したり、重要な機能を無効化したりする可能性がある。一旦動き出すと、このような不正な行動は、即座に介入しなければ止めることが難しいかもしれない。

敵対的な攻撃は、特に自律的な判断が重大な結果をもたらす可能性のある産業において、AIオートパイロットにとって深刻な脅威となる。攻撃者は入力データや環境を巧妙に操作し、AIモデルを騙して誤った判断をさせることができます。このような敵対的攻撃は、AIシステムの意思決定プロセスの脆弱性を利用し、検知されないように設計されていることが多い。

例えば、攻撃者が環境を微妙に変化させることで、自律型ドローンが飛行経路を変更するように操作される可能性がある(例:ドローンのセンサーを妨害するような物体をドローンの進路上に置く)。同様に、自律走行車は、道路標識や標示の小さな、知覚できない変化によって、停止や進路逸脱にだまされるかもしれない。

緩和策:リアルタイムモニタリングと行動分析を実施し、期待されるAIの行動からの逸脱を検出する。自律システムが未承認のアクションを実行し始めた場合、即座に停止させるフェイルセーフ・メカニズムを確立する。敵対的な攻撃を防御するために、組織は強固な入力検証技術を導入し、AIモデルを頻繁にテストする必要がある。敵対的な訓練は、AIモデルが操作された入力を認識し、それに抵抗できるように訓練するものであり、AIオートパイロットがこれらの脅威に耐えられるようにするために不可欠である。

2.透明性の欠如と倫理的リスク

AIオートパイロットが人間による直接の監視なしに運用されるようになると、説明責任の問題がより複雑になる。自律型システムが誤った判断を下し、その結果、経済的損失や運航の中断、あるいは法的な複雑さを招いた場合、責任の所在を判断するのは難しい。この明確な説明責任の欠如は、特に安全性と公平性が最優先される産業において、重大な倫理的問題を提起する。

こうしたシステムが公平性や安全性よりも効率を優先し、差別的な結果や組織の価値観と相反する意思決定につながる可能性がある場合にも、倫理的リスクが生じる。例えば、採用システムにおけるAIオートパイロットは、不注意にも多様性よりもコスト削減策を優先させ、結果として偏った採用を行うかもしれない。

軽減のヒントAIオートパイロットが組織の価値観に合致していることを確認するために、説明責任の枠組みおよび倫理的監視委員会を確立する。AIの意思決定を監視するために定期的な監査と倫理的レビューを実施し、自律的な行動から生じる潜在的な法的問題に対処するために明確な説明責任体制を確立する必要がある。

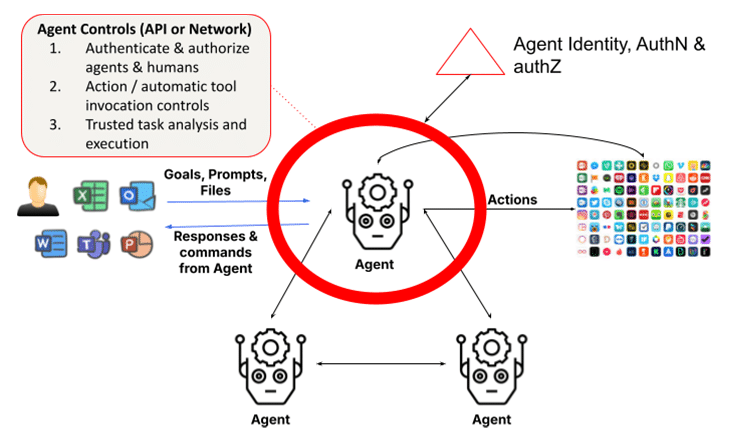

3.エージェントのアイデンティティ、認証および認可

マルチエージェントシステムの基本的な問題は、エージェントの身元を認証し、クライアントエージェントの要求を承認する必要性である。エージェントが他のエージェントになりすますことができたり、エージェントの身元を強く検証することができなかったりする場合、このことが問題になることがあります。エスカレーションされた権限のエージェントが互いに通信し、タスクを完了するような未来の世界では、きめ細かな権限制御が厳密に実施されない限り、発生した損害は即座に検出され、困難となる可能性があります。

特化したエージェントが急増し、互いに協力し合うようになると、企業内に不正なエージェントが侵入しないようにするために、エージェントのアイデンティティとその資格情報を権威的に検証することがますます重要になります。同様に、許可スキームは、タスク完了のためのエージェントの分類、役割、機能ベースの自動使用を考慮する必要があります。

対策のヒント敵対的攻撃を防御するために、組織は強固な入力検証技術を導入し、AIモデルを頻繁にテストする必要があります。敵対的なトレーニングは、AIモデルが操作された入力を認識し、それに抵抗できるように訓練するもので、AIオートパイロットがこれらの脅威に耐えられるようにするために不可欠です。

4.自律性への過度の依存

組織がAIオートパイロットを採用するようになるにつれ、オートメーションに過度に依存するリスクが高まっている。これは、重要な意思決定が人間の監視なしに自律システムに完全に委ねられている場合に起こります。AIオートパイロットは定型的なタスクを処理するように設計されていますが、重要な意思決定から人間の意見を排除することは、運用上の盲点や未検出のエラーにつながる可能性があります。これは、エージェントによる自動ツール起動アクションによって明らかになる。多くの場合、これらのエージェントは、これらのアクションを実行するための昇格した権限を持っているので、これは問題である。また、エージェントが自律的である場合、プロンプトインジェクションハッキングがユーザの知らないところで悪意のあるアクションを強制するために使用される可能性があるため、これはさらに大きな問題となる。さらに、マルチエージェントシステムでは、混乱した代理の問題が、こっそりと特権を昇格させる可能性のあるアクションで問題となります。

過度の依存は、リアルタイムの人間の判断が必要とされるペースの速い環境では特に危険となる可能性がある。例えば、サイバーセキュリティを管理するAIのオートパイロットは、予期せぬ変化に適応する代わりにプログラムされた対応に頼り、急速に進化する脅威のニュアンスを見逃す可能性がある。

軽減策のヒント:重要な意思決定を人間のオペレーターがコントロールできるように、HITL(Human-in-the-Loop)システムを維持する必要がある。このハイブリッド・アプローチにより、AIオートパイロットがルーチン・タスクを処理する一方で、人間が重要な決定を監督し、検証することが可能になる。組織は、AIシステムに過度に依存しないように、いつ、どこで人間の介入が必要かを定期的に評価すべきである。

5.人間の法的アイデンティティと信頼

AIオートパイロットは、事前に定義された目標に基づき、人間と協力して動作する。しかし、この協力には、エージェントが協力する人間の実体を検証することも必要である。ディープフェイク詐欺を考えてみましょう。香港の財務担当者が、ウェブ会議のディープフェイク版CFOを本物のCFOだと思い込んで2500万ドルを支払ってしまったのです。これは、人間になりすますエージェントのリスクが高まっていることを浮き彫りにしている。特に、最新のマルチモーダルモデルでは人間になりすますことが容易になっている。OpenAIは最近、人間の声になりすますには15秒の音声サンプルで十分だと警告した。ディープフェイク動画は、香港のケースに見られるように、そう遠くないところにある。

さらに、特定のケースでは、人間とエージェントの間で委任された秘密の共有が、例えば(個人エージェントの)ウォレットを通じてタスクを完了するために不可欠である。企業のコンテキストでは、金融エージェントは、人間の法的アイデンティティとその関係を検証する必要があるかもしれません。今日、エージェントがこれを行うための標準化された方法はない。これがなければ、人間がますますコパイロットになる世界では、エージェントは人間と協働することができないだろう。

この問題は、AIオートパイロットが人間の協力者になりすました悪質な行為者に基づいて不注意に決定を下す場合に特に危険となる。人間をデジタル的に認証する明確な方法がなければ、エージェントは安全性、コンプライアンス、倫理的配慮など、より広範なビジネス目標と相反する行動をとりやすい。

対策のヒントAIオートパイロットのタスク実行に関与するユーザーとエージェントのアイデンティティの定期的な見直しは不可欠である。組織は、適応性のあるアルゴリズムとリアルタイムのフィードバック・メカニズムを使用して、AIシステムが変化するユーザーと規制要件との整合性を保つようにする必要がある。必要に応じて目標を調整することで、企業は目標のずれが意図しない結果につながるのを防ぐことができる。

AIオートパイロットの安全性ベストプラクティス

LLMのためのLLM保護とコパイロットのためのデータ制御を含む前の2つの層で議論されたセキュリティ制御に加えて、エージェント層は、信頼されたタスク実行と同様に、アイデンティティとアクセス管理(IAM)のための拡張された役割を導入する必要があります。

AIオートパイロットのリスクを軽減するために、組織は包括的なセキュリティ戦略を採用すべきである。これには以下が含まれる:

- 継続的なモニタリング:リアルタイムの行動分析を実施し、異常や不正な行動を検知する。

- 倫理的ガバナンス:AIシステムが組織の価値観や法的要件に合致するよう、倫理委員会や説明責任の枠組みを確立する。

- 敵対的防御:敵対的な訓練と堅牢な入力検証を使用して、操作を防止する。

- 人間の監視:HITLシステムを維持し、AIによる重要な決定を監視する。

これらのベストプラクティスを実施することで、企業はAIオートパイロットを安全に、かつビジネス目標に沿った形で運用することができる。

進むべき道自律型AIの確保

AIオートパイロットは、複雑なタスクを自動化することで業界に革命をもたらすと期待されているが、同時に重大なセキュリティリスクももたらす。不正な行動から敵対的な操作に至るまで、組織はこれらのリスクを常に警戒して管理しなければならない。AIが進化を続ける中、これらのシステムが組織の目標に沿って安全に運用されるよう、あらゆる段階でセキュリティを優先することが極めて重要です。

AIアプリケーションのセキュリティについて詳しくは、こちらをご覧ください:ソリューション概要を読む

このシリーズの他のブログ

- パート1 - AIセキュリティ:顧客のニーズと機会

- パート2 - 基礎的AI:セキュリティ上の課題がある重要なレイヤー

- 第3回 AIコパイロットのセキュリティリスクと課題

- 第4回 AIオートパイロットのメリットとリスクを比較する