Di Sekhar Sarukkai - Cybersecurity@UC Berkeley

25 ottobre 2024 6 Minuti di lettura

Nel blog precedente, abbiamo esplorato le sfide di sicurezza associate ai copiloti AI, sistemi che assistono con compiti e decisioni, ma che si basano ancora sull'input umano. Abbiamo parlato di rischi come l'avvelenamento dei dati, l'uso improprio delle autorizzazioni e i copiloti AI disonesti. Man mano che i sistemi di AI avanzano con l'emergere di framework agonici di AI come LangGraph e AutoGen, il potenziale di rischi per la sicurezza aumenta, soprattutto con gli Autopiloti di AI, il prossimo livello di sviluppo dell'AI.

In questo blog conclusivo della nostra serie, ci concentreremo sul livello 3: gli autopiloti AI - sistemi agenziali autonomi che possono eseguire compiti con un intervento umano minimo o nullo. Sebbene offrano un enorme potenziale per l'automazione dei compiti e l'efficienza operativa, gli autopiloti AI introducono anche rischi significativi per la sicurezza che le organizzazioni devono affrontare per garantire un'implementazione sicura.

Vantaggi e rischi dei piloti automatici AI

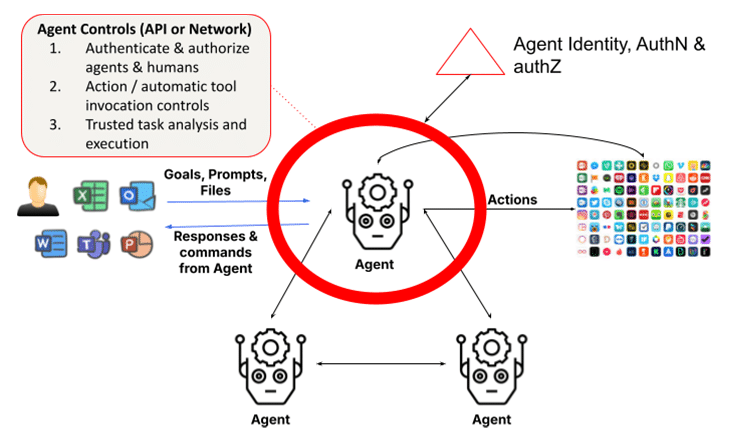

I sistemi agenziali si basano su modelli linguistici di grandi dimensioni (LLM) e sulla generazione aumentata dal reperimento (RAG). Aggiungono la capacità di agire attraverso l'introspezione, l'analisi dei compiti, la chiamata di funzioni e il ricorso ad altri agenti o umani per completare i loro compiti. Ciò richiede che gli agenti utilizzino un quadro per identificare e convalidare le identità di agenti e umani, nonché per garantire che le azioni e i risultati siano affidabili. La semplice visione di un LLM che interagisce con un umano nel Livello 1 è sostituita da una collezione di gruppi di agenti formati dinamicamente che lavorano insieme per completare un compito, aumentando le preoccupazioni di sicurezza di molte volte. Infatti, la più recente versione di Claude di Anthropic è una funzione che consente all'AI di utilizzare i computer per conto dell'utente, permettendo all'AI di utilizzare gli strumenti necessari per completare un compito in modo autonomo - una benedizione per gli utenti e una sfida per i responsabili della sicurezza.

1. Azioni autonome rocambolesche o avversarie

Gli autopiloti AI sono in grado di eseguire compiti in modo indipendente sulla base di obiettivi predefiniti. Tuttavia, questa autonomia apre il rischio di azioni disoneste, in cui un autopilota potrebbe deviare dal comportamento previsto a causa di difetti di programmazione o di manipolazioni avversarie. I sistemi di Intelligenza Artificiale disonesti potrebbero causare esiti indesiderati o dannosi, che vanno dalle violazioni dei dati ai fallimenti operativi.

Ad esempio, un pilota automatico AI che gestisce sistemi di infrastrutture critiche potrebbe accidentalmente spegnere le reti elettriche o disattivare funzioni essenziali a causa di un'errata interpretazione dei dati di input o di una svista di programmazione. Una volta avviate, queste azioni anomale potrebbero essere difficili da fermare senza un intervento immediato.

Gli attacchi avversari rappresentano una seria minaccia per gli autopiloti AI, in particolare nei settori in cui le decisioni autonome possono avere conseguenze critiche. Gli aggressori possono manipolare in modo sottile i dati di input o l'ambiente per ingannare i modelli di AI e indurli a prendere decisioni sbagliate. Questi attacchi avversari sono spesso progettati per passare inosservati, sfruttando le vulnerabilità nel processo decisionale del sistema AI.

Ad esempio, un drone autonomo potrebbe essere manipolato per cambiare la sua traiettoria di volo da aggressori che alterano sottilmente l'ambiente (ad esempio, posizionando oggetti sul percorso del drone che disturbano i suoi sensori). Allo stesso modo, i veicoli autonomi potrebbero essere indotti a fermarsi o a deviare dalla rotta a causa di piccole e impercettibili modifiche alla segnaletica stradale.

Suggerimento per la mitigazione: implementare il monitoraggio in tempo reale e l'analisi comportamentale per rilevare qualsiasi deviazione dal comportamento previsto dell'IA. Occorre stabilire meccanismi di sicurezza per arrestare immediatamente i sistemi autonomi se iniziano a eseguire azioni non autorizzate. Per difendersi dagli attacchi avversari, le organizzazioni devono implementare solide tecniche di validazione degli input e test frequenti dei modelli di AI. L'addestramento alle avversità, in cui i modelli di IA vengono addestrati a riconoscere e a resistere agli input manipolativi, è essenziale per garantire che i piloti automatici di IA possano resistere a queste minacce.

2. Mancanza di trasparenza e rischi etici

Con gli autopiloti AI che operano senza la diretta supervisione umana, le questioni di responsabilità diventano più complesse. Se un sistema autonomo prende una decisione sbagliata che provoca perdite finanziarie, interruzioni operative o complicazioni legali, determinare la responsabilità può essere difficile. Questa mancanza di responsabilità chiara solleva questioni etiche significative, in particolare nei settori in cui la sicurezza e l'equità sono fondamentali.

I rischi etici sorgono anche quando questi sistemi privilegiano l'efficienza rispetto all'equità o alla sicurezza, portando potenzialmente a risultati discriminatori o a decisioni in conflitto con i valori organizzativi. Per esempio, un pilota automatico AI in un sistema di assunzione potrebbe inavvertitamente privilegiare le misure di risparmio sui costi rispetto alla diversità, dando luogo a pratiche di assunzione distorte.

Suggerimento per la mitigazione: Stabilire quadri di responsabilità e commissioni di supervisione etica per garantire che i piloti automatici dell'IA siano in linea con i valori organizzativi. È necessario condurre audit regolari e revisioni etiche per monitorare il processo decisionale dell'IA, e stabilire chiare strutture di responsabilità per gestire potenziali problemi legali derivanti da azioni autonome.

3. Identità dell'agente, autenticazione e autorizzazione

Un problema fondamentale dei sistemi multi-agente è la necessità di autenticare le identità degli agenti e di autorizzare le richieste degli agenti client. Questo può rappresentare una sfida se gli agenti possono mascherarsi da altri agenti o se le identità degli agenti richiedenti non possono essere verificate con forza. In un mondo futuro in cui gli agenti con privilegi escalation comunicano tra loro e completano i compiti, i danni subiti possono essere istantanei e difficili da rilevare, a meno che non vengano applicati controlli di autorizzazione a grana fine.

Con la proliferazione degli agenti specializzati e la loro collaborazione, diventa sempre più importante la convalida autorevole delle identità degli agenti e delle loro credenziali, per garantire l'assenza di infiltrazioni di agenti disonesti nelle aziende. Allo stesso modo, gli schemi di autorizzazione devono tenere conto dell'uso automatizzato degli agenti in base alla classificazione, al ruolo e alla funzione, per il completamento dei compiti.

Suggerimento per la mitigazione: Per difendersi dagli attacchi avversari, le organizzazioni devono implementare solide tecniche di convalida degli input e test frequenti dei modelli AI. L'addestramento alle avversità, in cui i modelli di AI vengono addestrati a riconoscere e a resistere agli input manipolativi, è essenziale per garantire che i piloti automatici di AI possano resistere a queste minacce.

4. Eccessiva fiducia nell'autonomia

Man mano che le organizzazioni adottano sempre di più i piloti automatici AI, cresce il rischio di un'eccessiva dipendenza dall'automazione. Ciò accade quando le decisioni critiche vengono lasciate interamente ai sistemi autonomi, senza la supervisione umana. Sebbene gli autopiloti AI siano progettati per gestire le attività di routine, l'eliminazione dell'input umano dalle decisioni critiche può portare a punti ciechi operativi ed errori non rilevati. Ciò si manifesta attraverso l'invocazione automatica di strumenti da parte degli agenti. Questo è un problema perché, in molti casi, questi agenti hanno privilegi elevati per eseguire queste azioni. Si tratta di un problema ancora più grave quando gli agenti sono autonomi, dove l'hacking con prompt injection può essere utilizzato per forzare azioni nefaste all'insaputa dell'utente. Inoltre, nei sistemi multi-agente, il problema del vice confuso è un problema con azioni che possono aumentare i privilegi in modo furtivo.

L'eccessiva dipendenza può diventare particolarmente pericolosa in ambienti frenetici, dove è ancora necessario il giudizio umano in tempo reale. Ad esempio, un pilota automatico AI che gestisce la cybersecurity potrebbe non cogliere le sfumature di una minaccia in rapida evoluzione, affidandosi alle sue risposte programmate invece di adattarsi ai cambiamenti inattesi.

Suggerimento per la mitigazione: i sistemi Human-in-the-loop (HITL) devono essere mantenuti per garantire che gli operatori umani mantengano il controllo sulle decisioni critiche. Questo approccio ibrido consente agli autopiloti AI di gestire i compiti di routine, mentre gli esseri umani supervisionano e convalidano le decisioni più importanti. Le organizzazioni devono valutare regolarmente quando e dove è necessario l'intervento umano per evitare un'eccessiva dipendenza dai sistemi AI.

5. Identità giuridica umana e fiducia

I piloti automatici AI operano sulla base di obiettivi predefiniti e in collaborazione con gli esseri umani. Tuttavia, questa cooperazione richiede anche che gli agenti convalidino le entità umane con cui stanno collaborando, poiché queste interazioni non sono sempre con persone autenticate che utilizzano uno strumento di suggerimento. Si consideri la truffa deepfake, in cui un impiegato della finanza di Hong Kong ha pagato 25 milioni di dollari presumendo che una versione deepfake del CFO in una riunione web fosse effettivamente il vero CFO. Ciò evidenzia il rischio crescente di agenti che possono impersonare gli esseri umani, soprattutto perché impersonare gli esseri umani diventa più facile con i più recenti modelli multimodali. OpenAI ha recentemente avvertito che un campione vocale di 15 secondi è sufficiente per impersonare la voce di un umano. I video deepfake non sono lontani, come illustrato dal caso di Hong Kong.

Inoltre, in alcuni casi, la condivisione delegata di segreti tra esseri umani e agenti è essenziale per completare un compito, ad esempio attraverso un portafoglio (per un agente personale). Nel contesto aziendale, un agente finanziario potrebbe aver bisogno di convalidare l'identità legale degli esseri umani e le loro relazioni. Oggi non esiste un modo standardizzato per gli agenti di farlo. Senza questo, gli agenti non saranno in grado di collaborare con gli umani in un mondo in cui gli umani saranno sempre più i copiloti.

Questo problema diventa particolarmente pericoloso quando i piloti automatici dell'IA prendono inavvertitamente decisioni basate su cattivi attori che impersonano un collaboratore umano. Senza un modo chiaro per autenticare digitalmente gli esseri umani, gli agenti sono suscettibili di agire in modi che sono in conflitto con obiettivi aziendali più ampi, come la sicurezza, la conformità o le considerazioni etiche.

Suggerimento per la mitigazione: Sono essenziali revisioni regolari delle identità degli utenti e degli agenti coinvolti nelle esecuzioni dei compiti dell'AI Autopilot. Le organizzazioni dovrebbero utilizzare algoritmi adattivi e meccanismi di feedback in tempo reale per garantire che i sistemi di AI rimangano allineati con l'evoluzione degli utenti e dei requisiti normativi. Regolando gli obiettivi in base alle necessità, le aziende possono evitare che gli obiettivi non allineati portino a conseguenze indesiderate.

Proteggere i piloti automatici AI: Le migliori pratiche

Oltre ai controlli di sicurezza discussi nei due livelli precedenti, che includono la protezione dei LLM per i LLM e i controlli dei dati per i Copiloti, il livello agenziale richiede l'introduzione di un ruolo ampliato per la gestione dell'identità e dell'accesso (IAM), nonché l'esecuzione di compiti affidabili.

Per mitigare i rischi dei piloti automatici AI, le organizzazioni dovrebbero adottare una strategia di sicurezza completa. Questo include:

- Monitoraggio continuo: Implementa l'analisi comportamentale in tempo reale per rilevare anomalie e azioni non autorizzate.

- Governance etica: Istituire comitati etici e quadri di responsabilità per garantire che i sistemi di IA siano in linea con i valori organizzativi e i requisiti legali.

- Difesa avversaria: Utilizza una formazione avversaria e una robusta convalida degli input per evitare la manipolazione.

- Supervisione umana: Mantenere i sistemi HITL per mantenere la supervisione delle decisioni critiche prese dall'IA.

Implementando queste best practice, le organizzazioni possono garantire che gli autopiloti AI operino in modo sicuro e in linea con i loro obiettivi aziendali.

Il cammino verso il futuro: Proteggere l'intelligenza artificiale autonoma

Gli autopiloti AI promettono di rivoluzionare le industrie automatizzando compiti complessi, ma introducono anche rischi significativi per la sicurezza. Dalle azioni illecite alle manipolazioni avversarie, le organizzazioni devono rimanere vigili nella gestione di questi rischi. Con l'evoluzione dell'AI, è fondamentale dare priorità alla sicurezza in ogni fase, per garantire che questi sistemi funzionino in modo sicuro e in linea con gli obiettivi organizzativi.

Per saperne di più sulla protezione delle sue applicazioni AI: Legga il nostro Solution Brief

Altri blog in questa serie:

Torna ai blog