بقلم سيخار ساروكاي - الأمن السيبراني في جامعة بيركلي

25 أكتوبر 2024 6 قراءة دقيقة

في المدونة السابقة، استكشفنا في المدونة السابقة التحديات الأمنية المرتبطة بالذكاء الاصطناعي المساعد، وهي أنظمة تساعد في المهام والقرارات ولكنها لا تزال تعتمد على المدخلات البشرية. وناقشنا مخاطر مثل تسميم البيانات، وإساءة استخدام الأذونات، والذكاء الاصطناعي المساعد المارق. مع تقدم أنظمة الذكاء الاصطناعي مع ظهور أطر عمل الذكاء الاصطناعي الوكيل مثل LangGraph و AutoGen، تزداد احتمالية المخاطر الأمنية - خاصةً مع الذكاء الاصطناعي الآلي، وهو الطبقة التالية من تطوير الذكاء الاصطناعي.

في هذه المدونة الأخيرة من سلسلتنا، سنركز في هذه المدونة على الطبقة الثالثة: الطيارون الآليون للذكاء الاصطناعي - وهي أنظمة ذاتية التشغيل ذاتية التشغيل يمكنها أداء المهام بتدخل بشري ضئيل أو بدون تدخل بشري. على الرغم من أنها توفر إمكانات هائلة لأتمتة المهام والكفاءة التشغيلية، إلا أن أنظمة الذكاء الاصطناعي الآلية تقدم أيضًا مخاطر أمنية كبيرة يجب على المؤسسات معالجتها لضمان النشر الآمن.

فوائد ومخاطر الذكاء الاصطناعي الآلي للطيارين الآليين

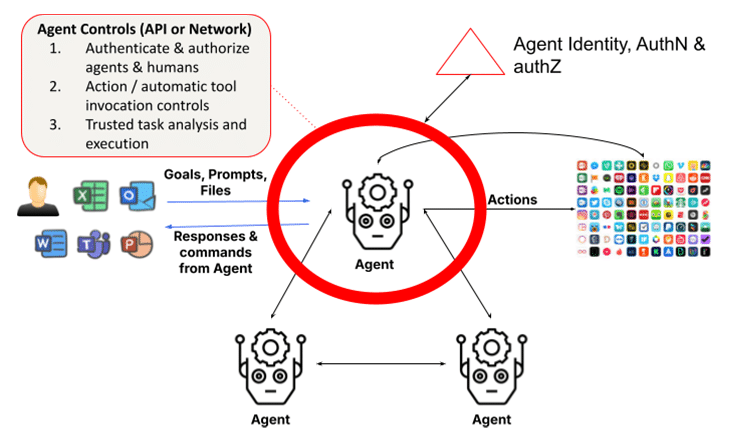

تعتمد الأنظمة الوكيلة على النماذج اللغوية الكبيرة (LLMs) والجيل المعزز بالاسترجاع (RAGs). وهي تضيف القدرة على اتخاذ الإجراءات من خلال الاستبطان وتحليل المهام واستدعاء الوظائف والاستفادة من الوكلاء الآخرين أو البشر لإكمال مهامهم. ويتطلب ذلك من الوكلاء استخدام إطار عمل لتحديد هويات الوكلاء والبشر والتحقق من هوياتهم والتحقق من صحتها، وكذلك لضمان أن تكون الإجراءات والنتائج جديرة بالثقة. يتم استبدال المنظر البسيط لتفاعل الوكيل مع الإنسان في الطبقة الأولى بمجموعة من مجموعات الوكلاء المشكّلة ديناميكيًا والتي تعمل معًا لإكمال مهمة ما، مما يزيد من المخاوف الأمنية أضعافًا مضاعفة. في الواقع، أحدث إصدار من Claude من Anthropic هو أحدث إصدار من Claude من Anthropic، وهي ميزة تسمح للذكاء الاصطناعي باستخدام أجهزة الكمبيوتر نيابةً عنك، مما يتيح للذكاء الاصطناعي استخدام الأدوات اللازمة لإكمال مهمة ما بشكل مستقل - وهي نعمة للمستخدمين وتحديًا للأشخاص الذين يعملون في مجال الأمن.

1. التصرفات المارقة أو العدائية المستقلة

يستطيع الطيار الآلي للذكاء الاصطناعي تنفيذ المهام بشكل مستقل بناءً على أهداف محددة مسبقاً. ومع ذلك، فإن هذه الاستقلالية تفتح الباب أمام مخاطر الإجراءات المارقة، حيث قد ينحرف الطيار الآلي عن السلوك المقصود بسبب عيوب البرمجة أو التلاعب العدائي. يمكن أن تتسبب أنظمة الذكاء الاصطناعي المارقة في نتائج غير مقصودة أو ضارة، بدءاً من انتهاكات البيانات إلى الفشل التشغيلي.

على سبيل المثال، قد يقوم الطيار الآلي للذكاء الاصطناعي الذي يدير أنظمة البنية التحتية الحيوية بإغلاق شبكات الطاقة عن طريق الخطأ أو تعطيل وظائف أساسية بسبب سوء تفسير بيانات الإدخال أو سهو في البرمجة. وبمجرد بدء تشغيله، قد يكون من الصعب إيقاف هذه الإجراءات المارقة دون تدخل فوري.

تشكّل الهجمات العدائية تهديداً خطيراً للذكاء الاصطناعي الآلي، لا سيما في الصناعات التي يمكن أن يكون للقرارات المستقلة فيها عواقب وخيمة. يمكن للمهاجمين التلاعب بمهارة ببيانات المدخلات أو البيئة لخداع نماذج الذكاء الاصطناعي لاتخاذ قرارات غير صحيحة. وغالباً ما يتم تصميم هذه الهجمات العدائية بحيث لا يتم اكتشافها، مستغلين نقاط الضعف في عملية اتخاذ القرارات في نظام الذكاء الاصطناعي.

على سبيل المثال، يمكن التلاعب بطائرة بدون طيار ذاتية القيادة لتغيير مسار طيرانها من قبل المهاجمين الذين يغيرون البيئة المحيطة بمهارة (على سبيل المثال: وضع أجسام في مسار الطائرة بدون طيار لتعطيل أجهزة الاستشعار الخاصة بها). وبالمثل، يمكن خداع المركبات ذاتية القيادة للتوقف أو الانحراف عن مسارها بسبب تغييرات صغيرة غير محسوسة في علامات أو إشارات الطرق.

نصيحة التخفيف: تنفيذ المراقبة في الوقت الحقيقي والتحليل السلوكي لاكتشاف أي انحرافات عن سلوك الذكاء الاصطناعي المتوقع. يجب إنشاء آليات آمنة من الفشل لإيقاف الأنظمة المستقلة فوراً إذا بدأت في تنفيذ إجراءات غير مصرح بها. للدفاع ضد الهجمات العدائية، يجب على المؤسسات تنفيذ تقنيات قوية للتحقق من صحة المدخلات والاختبار المتكرر لنماذج الذكاء الاصطناعي. يعد التدريب على الخصومات، حيث يتم تدريب نماذج الذكاء الاصطناعي على التعرف على المدخلات المتلاعبة ومقاومتها، أمراً ضرورياً لضمان قدرة أنظمة الذكاء الاصطناعي الآلية على الصمود أمام هذه التهديدات.

2. الافتقار إلى الشفافية والمخاطر الأخلاقية

مع تشغيل الذكاء الاصطناعي للطيار الآلي دون إشراف بشري مباشر، تصبح قضايا المساءلة أكثر تعقيداً. إذا اتخذ نظام ذاتي التشغيل قراراً سيئاً يؤدي إلى خسارة مالية أو اضطراب تشغيلي أو تعقيدات قانونية، فقد يكون من الصعب تحديد المسؤولية. ويثير هذا الافتقار إلى المساءلة الواضحة تساؤلات أخلاقية مهمة، لا سيما في الصناعات التي تتسم فيها السلامة والإنصاف بأهمية قصوى.

كما تنشأ المخاطر الأخلاقية أيضاً عندما تعطي هذه الأنظمة الأولوية للكفاءة على حساب العدالة أو السلامة، مما قد يؤدي إلى نتائج تمييزية أو قرارات تتعارض مع القيم التنظيمية. على سبيل المثال، قد يقوم الطيار الآلي للذكاء الاصطناعي في نظام التوظيف بإعطاء الأولوية عن غير قصد لتدابير توفير التكاليف على حساب التنوع، مما يؤدي إلى ممارسات توظيف متحيزة.

نصيحة التخفيف: إنشاء أطر للمساءلة ومجالس رقابة أخلاقية لضمان توافق الذكاء الاصطناعي الآلي مع القيم المؤسسية. يجب إجراء عمليات تدقيق ومراجعات أخلاقية منتظمة لمراقبة عملية اتخاذ القرارات المتعلقة بالذكاء الاصطناعي، كما يجب إنشاء هياكل مساءلة واضحة للتعامل مع القضايا القانونية المحتملة التي تنشأ عن الإجراءات المستقلة.

3. هوية الوكيل والمصادقة والتوثيق والتفويض

تتمثل إحدى المشكلات الأساسية في الأنظمة متعددة الوكلاء في الحاجة إلى التحقق من هويات الوكلاء وتفويض طلبات وكلاء العملاء. يمكن أن يشكل هذا الأمر تحدياً إذا كان بإمكان الوكلاء التنكر كوكلاء آخرين أو إذا لم يكن بالإمكان التحقق من هويات الوكلاء الطالبين بشكل قوي. في العالم المستقبلي حيث يتواصل الوكلاء ذوو الامتيازات المتصاعدة مع بعضهم البعض ويكملون المهام، يمكن أن يكون الضرر المتكبد فورياً ويصعب اكتشافه ما لم يتم فرض ضوابط تفويض دقيقة الحساسية بشكل صارم.

ومع تكاثر الوكلاء المتخصصين وتعاونهم مع بعضهم البعض، يصبح من المهم بشكل متزايد التحقق الموثوق من هويات الوكلاء وبيانات اعتمادهم لضمان عدم تسلل وكلاء مارقين إلى المؤسسات. وبالمثل، يجب أن تأخذ مخططات منح الأذونات في الحسبان الاستخدام الآلي القائم على تصنيف الوكلاء والأدوار والوظائف لإتمام المهام.

نصيحة التخفيف: للدفاع ضد الهجمات العدائية، يجب على المؤسسات تنفيذ تقنيات قوية للتحقق من صحة المدخلات والاختبار المتكرر لنماذج الذكاء الاصطناعي. يعد التدريب على الخصومات، حيث يتم تدريب نماذج الذكاء الاصطناعي على التعرف على المدخلات المتلاعبة ومقاومتها، أمراً ضرورياً لضمان قدرة الذكاء الاصطناعي الآلي على الصمود أمام هذه التهديدات.

4. الإفراط في الاعتماد على الاستقلالية

مع تزايد اعتماد المؤسسات على الذكاء الاصطناعي الآلي بشكل متزايد، هناك خطر متزايد من الاعتماد المفرط على الأتمتة. ويحدث ذلك عندما تُترك القرارات الحاسمة بالكامل للأنظمة ذاتية التشغيل دون إشراف بشري. في حين أن أنظمة الذكاء الاصطناعي الآلية مصممة للتعامل مع المهام الروتينية، فإن إزالة المدخلات البشرية من القرارات الحاسمة يمكن أن يؤدي إلى نقاط تشغيلية عمياء وأخطاء غير مكتشفة. ويتجلى ذلك من خلال إجراءات استدعاء الأدوات التلقائية التي يتخذها الوكلاء. وهذه مشكلة لأن هؤلاء الوكلاء يتمتعون في كثير من الحالات بامتيازات عالية لتنفيذ هذه الإجراءات. وتمثل هذه مشكلة أكبر عندما يكون الوكلاء مستقلين حيث يمكن استخدام اختراق الحقن الفوري لفرض إجراءات شائنة دون علم المستخدم. بالإضافة إلى ذلك، في الأنظمة متعددة الوكلاء، تمثل مشكلة النائب المشوش مشكلة مع الإجراءات التي يمكن أن تصعّد الامتيازات خلسةً.

يمكن أن يصبح الاعتماد المفرط خطيراً بشكل خاص في البيئات سريعة الوتيرة حيث لا تزال هناك حاجة إلى حكم بشري في الوقت الحقيقي. على سبيل المثال، يمكن أن يفوت الطيار الآلي للذكاء الاصطناعي الذي يدير الأمن السيبراني الفروق الدقيقة في التهديدات سريعة التطور، معتمداً على استجاباته المبرمجة بدلاً من التكيف مع التغيرات غير المتوقعة.

نصيحة للتخفيف من المخاطر: يجب الحفاظ على أنظمة التحكم البشري في الحلقة (HITL) لضمان احتفاظ المشغلين البشريين بالسيطرة على القرارات الحاسمة. يسمح هذا النهج الهجين للذكاء الاصطناعي الآلي بالتعامل مع المهام الروتينية بينما يشرف البشر على القرارات الرئيسية ويتحققون من صحتها. يجب على المؤسسات أن تقيّم بانتظام متى وأين يكون التدخل البشري ضرورياً لمنع الاعتماد المفرط على أنظمة الذكاء الاصطناعي.

5. الهوية القانونية للإنسان والثقة

تعمل روبوتات الذكاء الاصطناعي الآلية بناءً على أهداف محددة مسبقاً وبالتعاون مع البشر. ومع ذلك، يتطلب هذا التعاون أيضاً من الوكلاء التحقق من صحة الكيانات البشرية التي يتعاونون معها، حيث أن هذه التفاعلات لا تتم دائماً مع أشخاص موثقين باستخدام أداة مطالبة. ضع في اعتبارك عملية الاحتيال الوهمي العميق، حيث دفع موظف مالي في هونغ كونغ 25 مليون دولار من خلال افتراض أن نسخة مزيفة من المدير المالي في اجتماع عبر الإنترنت هي بالفعل المدير المالي الحقيقي. وهذا يسلط الضوء على الخطر المتزايد للوكلاء الذين يمكنهم انتحال شخصية البشر، خاصة وأن انتحال شخصية البشر أصبح أسهل مع أحدث النماذج متعددة الوسائط. وقد حذّرت OpenAI مؤخراً من أن عينة صوتية مدتها 15 ثانية ستكون كافية لانتحال صوت الإنسان. وليست مقاطع الفيديو المزيفة العميقة ببعيدة، كما يتضح من حالة هونغ كونغ.

بالإضافة إلى ذلك، في بعض الحالات، تكون المشاركة السرية المفوضة بين البشر والوكلاء ضرورية لإكمال مهمة ما، على سبيل المثال، من خلال المحفظة (للوكيل الشخصي). في سياق المؤسسة، قد يحتاج الوكيل المالي إلى التحقق من الهوية القانونية للبشر وعلاقاتهم. لا توجد طريقة موحدة للوكلاء للقيام بذلك اليوم. وبدون ذلك، لن يكون الوكلاء قادرين على التعاون مع البشر في عالم سيصبح فيه البشر بشكل متزايد هم الطيارون المساعدون.

وتصبح هذه المشكلة خطيرة بشكل خاص عندما يتخذ الوكلاء الآليون للذكاء الاصطناعي قرارات غير مقصودة بناءً على جهات سيئة تنتحل شخصية متعاون بشري. فبدون وجود طريقة واضحة للمصادقة الرقمية على البشر، يكون الوكلاء عرضة للتصرف بطرق تتعارض مع أهداف العمل الأوسع، مثل السلامة أو الامتثال أو الاعتبارات الأخلاقية.

نصيحة التخفيف: من الضروري إجراء مراجعات منتظمة لهويات المستخدمين والوكلاء المشاركين في تنفيذ مهام الذكاء الاصطناعي الآلي. يجب على المؤسسات استخدام الخوارزميات التكيفية وآليات التغذية الراجعة في الوقت الحقيقي لضمان بقاء أنظمة الذكاء الاصطناعي متوافقة مع المستخدمين المتغيرين والمتطلبات التنظيمية. من خلال تعديل الأهداف حسب الحاجة، يمكن للشركات منع الأهداف غير المتوافقة من أن تؤدي إلى عواقب غير مقصودة.

تأمين الطيار الآلي للذكاء الاصطناعي: أفضل الممارسات

وبالإضافة إلى ضوابط الأمان التي تمت مناقشتها في الطبقتين السابقتين والتي تتضمن حماية LLM لـ LLMs وضوابط البيانات لـ Copilots، فإن الطبقة الوكيلة تستلزم إدخال دور موسع لإدارة الهوية والوصول (IAM)، بالإضافة إلى تنفيذ المهام الموثوق بها.

للحد من مخاطر الذكاء الاصطناعي الآلي، يجب على المؤسسات اعتماد استراتيجية أمنية شاملة. ويشمل ذلك:

- المراقبة المستمرة: تنفيذ التحليل السلوكي في الوقت الفعلي للكشف عن الحالات الشاذة والإجراءات غير المصرح بها.

- الحوكمة الأخلاقية: إنشاء مجالس الأخلاقيات وأطر المساءلة لضمان توافق أنظمة الذكاء الاصطناعي مع القيم المؤسسية والمتطلبات القانونية.

- دفاع الخصومة: استخدام التدريب العدائي والتحقق القوي من صحة المدخلات لمنع التلاعب.

- الرقابة البشرية: الحفاظ على أنظمة HITL للاحتفاظ بالرقابة على القرارات الحاسمة التي يتخذها الذكاء الاصطناعي.

من خلال تنفيذ أفضل الممارسات هذه، يمكن للمؤسسات ضمان عمل الذكاء الاصطناعي الآلي بشكل آمن ومتوافق مع أهداف أعمالها.

الطريق إلى الأمام: تأمين الذكاء الاصطناعي المستقل

يَعِد الذكاء الاصطناعي الآلي بإحداث ثورة في الصناعات من خلال أتمتة المهام المعقدة، ولكنه يُدخل أيضاً مخاطر أمنية كبيرة. من الإجراءات المارقة إلى التلاعب العدائي، يجب على المؤسسات أن تظل يقظة في إدارة هذه المخاطر. مع استمرار تطور الذكاء الاصطناعي في التطور، من الضروري إعطاء الأولوية للأمن في كل مرحلة لضمان عمل هذه الأنظمة بأمان وبما يتماشى مع الأهداف المؤسسية.

لمعرفة المزيد حول تأمين تطبيقات الذكاء الاصطناعي الخاصة بك: اقرأ موجز الحلول الخاص بنا

مدونات أخرى في هذه السلسلة

العودة إلى المدونات