Par Sekhar Sarukkai - Cybersecurity@UC Berkeley

25 octobre 2024 6 Lecture minute

Dans le blog précédent, nous avons exploré les défis de sécurité associés aux copilotes d'IA, des systèmes qui aident à effectuer des tâches et à prendre des décisions, mais qui dépendent toujours de l'intervention humaine. Nous avons évoqué des risques tels que l'empoisonnement des données, l'utilisation abusive des autorisations et les copilotes d'IA malhonnêtes. À mesure que les systèmes d'IA progressent avec l'émergence de cadres agentiques d'IA tels que LangGraph et AutoGen, le potentiel de risques de sécurité augmente, en particulier avec les pilotes automatiques d'IA, la prochaine couche de développement de l'IA.

Dans ce dernier blog de notre série, nous nous concentrerons sur la couche 3 : les pilotes automatiques d'IA - des systèmes agentiques autonomes qui peuvent effectuer des tâches avec peu ou pas d'intervention humaine. Bien qu'ils offrent un potentiel énorme en matière d'automatisation des tâches et d'efficacité opérationnelle, les pilotes automatiques d'IA présentent également des risques de sécurité importants que les organisations doivent prendre en compte pour garantir un déploiement sûr.

Avantages et risques des pilotes automatiques à IA

Les systèmes agentiques s'appuient sur les grands modèles de langage (LLM) et la génération augmentée par la recherche (RAG). Ils ajoutent la capacité d'agir par l'introspection, l'analyse des tâches, l'appel de fonctions et l'utilisation d'autres agents ou d'humains pour accomplir leurs tâches. Pour ce faire, les agents doivent utiliser un cadre permettant d'identifier et de valider les identités des agents et des humains, ainsi que de garantir que les actions et les résultats sont dignes de confiance. La vision simple d'un LLM interagissant avec un humain dans la couche 1 est remplacée par une collection de groupes d'agents formés dynamiquement qui travaillent ensemble pour accomplir une tâche, ce qui multiplie les problèmes de sécurité. En fait, la version la plus récente de Claude d'Anthropic est une fonction qui permet à l'IA d'utiliser des ordinateurs en votre nom, permettant à l'IA d'utiliser les outils nécessaires pour accomplir une tâche de manière autonome - une bénédiction pour les utilisateurs et un défi pour les responsables de la sécurité.

1. Actions autonomes malhonnêtes ou adverses

Les pilotes automatiques d'IA sont capables d'exécuter des tâches de manière indépendante sur la base d'objectifs prédéfinis. Toutefois, cette autonomie ouvre la voie au risque d'actions malhonnêtes, où un pilote automatique peut s'écarter du comportement prévu en raison de défauts de programmation ou de manipulations adverses. Les systèmes d'IA malveillants peuvent avoir des conséquences involontaires ou néfastes, allant de la violation de données à des défaillances opérationnelles.

Par exemple, un pilote automatique d'IA gérant des systèmes d'infrastructures critiques pourrait accidentellement fermer des réseaux électriques ou désactiver des fonctions essentielles en raison d'une mauvaise interprétation des données d'entrée ou d'un oubli de programmation. Une fois déclenchées, ces actions malveillantes pourraient être difficiles à arrêter sans une intervention immédiate.

Les attaques adverses constituent une menace sérieuse pour les pilotes automatiques d'IA, en particulier dans les secteurs où les décisions autonomes peuvent avoir des conséquences critiques. Les attaquants peuvent manipuler subtilement les données d'entrée ou l'environnement pour amener les modèles d'IA à prendre des décisions incorrectes. Ces attaques adverses sont souvent conçues pour passer inaperçues, en exploitant les vulnérabilités du processus de prise de décision du système d'IA.

Par exemple, un drone autonome pourrait être manipulé pour changer sa trajectoire de vol par des attaquants qui modifient subtilement l'environnement (par exemple en plaçant des objets sur la trajectoire du drone qui perturbent ses capteurs). De même, les véhicules autonomes pourraient être amenés à s'arrêter ou à dévier de leur trajectoire par de petites modifications imperceptibles de la signalisation routière.

Conseil d'atténuation: mettez en œuvre une surveillance en temps réel et une analyse comportementale pour détecter tout écart par rapport au comportement attendu de l'IA. Des mécanismes de sécurité devraient être mis en place pour arrêter immédiatement les systèmes autonomes s'ils commencent à exécuter des actions non autorisées. Pour se défendre contre les attaques adverses, les organisations doivent mettre en œuvre des techniques robustes de validation des données d'entrée et tester fréquemment les modèles d'IA. La formation aux attaques adverses, qui consiste à entraîner les modèles d'IA à reconnaître et à résister aux intrants manipulés, est essentielle pour garantir que les pilotes automatiques d'IA puissent résister à ces menaces.

2. Manque de transparence et risques éthiques

Avec les pilotes automatiques d'IA fonctionnant sans surveillance humaine directe, les questions de responsabilité deviennent plus complexes. Si un système autonome prend une mauvaise décision qui entraîne une perte financière, une perturbation opérationnelle ou des complications juridiques, il peut être difficile de déterminer les responsabilités. Cette absence de responsabilité claire soulève d'importantes questions éthiques, en particulier dans les secteurs où la sécurité et l'équité sont primordiales.

Des risques éthiques surviennent également lorsque ces systèmes donnent la priorité à l'efficacité plutôt qu'à l'équité ou à la sécurité, ce qui peut conduire à des résultats discriminatoires ou à des décisions contraires aux valeurs de l'organisation. Par exemple, un pilote automatique d'IA dans un système de recrutement pourrait, par inadvertance, donner la priorité aux mesures de réduction des coûts plutôt qu'à la diversité, ce qui se traduirait par des pratiques de recrutement biaisées.

Conseil d'atténuation: Établissez des cadres de responsabilité et des conseils de surveillance éthique pour vous assurer que les pilotes automatiques d'IA s'alignent sur les valeurs de l'organisation. Des audits réguliers et des examens éthiques doivent être menés pour contrôler la prise de décision en matière d'IA, et des structures de responsabilité claires doivent être établies pour gérer les problèmes juridiques potentiels qui découlent des actions autonomes.

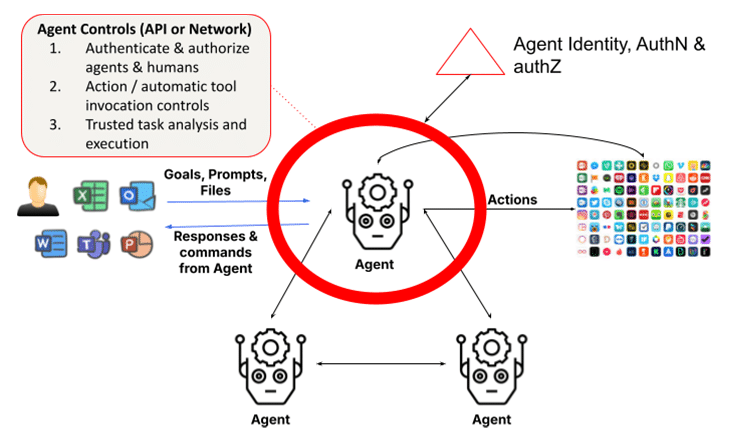

3. Identité, authentification et autorisation des agents

Un problème fondamental des systèmes multi-agents est la nécessité d'authentifier les identités des agents et d'autoriser les demandes des agents clients. Cela peut poser un problème si les agents peuvent se faire passer pour d'autres agents ou si les identités des agents demandeurs ne peuvent pas être fortement vérifiées. Dans un monde futur où des agents à privilèges accrus communiquent entre eux et accomplissent des tâches, les dommages subis peuvent être instantanés et difficiles à détecter à moins que des contrôles d'autorisation à grain fin ne soient strictement appliqués.

À mesure que les agents spécialisés prolifèrent et collaborent les uns avec les autres, il devient de plus en plus important de valider avec autorité les identités des agents et leurs références afin d'éviter l'infiltration d'agents malhonnêtes dans les entreprises. De même, les systèmes d'autorisation doivent tenir compte de la classification des agents, de leur rôle et de l'utilisation automatisée basée sur les fonctions pour l'accomplissement des tâches.

Conseil d'atténuation: Pour se défendre contre les attaques adverses, les organisations doivent mettre en œuvre des techniques robustes de validation des entrées et tester fréquemment les modèles d'IA. La formation aux attaques adverses, qui consiste à entraîner les modèles d'IA à reconnaître et à résister aux entrées manipulatrices, est essentielle pour s'assurer que les pilotes automatiques d'IA peuvent résister à ces menaces.

4. Dépendance excessive à l'égard de l'autonomie

Alors que les organisations adoptent de plus en plus les pilotes automatiques d'IA, il existe un risque croissant de dépendance excessive à l'égard de l'automatisation. Cela se produit lorsque des décisions critiques sont entièrement laissées à des systèmes autonomes sans surveillance humaine. Alors que les pilotes automatiques d'IA sont conçus pour gérer les tâches de routine, la suppression de l'intervention humaine dans les décisions critiques peut conduire à des angles morts opérationnels et à des erreurs non détectées. Cela se manifeste par l'invocation automatique d'outils par les agents. Il s'agit d'un problème car, dans de nombreux cas, ces agents disposent de privilèges élevés pour effectuer ces actions. Le problème est encore plus important lorsque les agents sont autonomes et que le piratage par injection peut être utilisé pour forcer des actions néfastes à l'insu de l'utilisateur. En outre, dans les systèmes multi-agents, le problème de l'adjoint confus est un problème avec les actions qui peuvent furtivement élever les privilèges.

Une dépendance excessive peut s'avérer particulièrement dangereuse dans des environnements en évolution rapide où le jugement humain en temps réel est toujours nécessaire. Par exemple, une IA Autopilot gérant la cybersécurité pourrait manquer les nuances d'une menace évoluant rapidement, en se fiant à ses réponses programmées au lieu de s'adapter aux changements inattendus.

Conseil d'atténuation: les systèmes "Human-in-the-loop" (HITL) doivent être maintenus pour s'assurer que les opérateurs humains conservent le contrôle des décisions critiques. Cette approche hybride permet aux pilotes automatiques d'IA de gérer les tâches de routine tandis que les humains supervisent et valident les décisions majeures. Les organisations devraient régulièrement évaluer quand et où l'intervention humaine est nécessaire pour éviter une dépendance excessive aux systèmes d'IA.

5. Identité juridique humaine et confiance

Les pilotes automatiques d'IA fonctionnent sur la base d'objectifs prédéfinis et en coopération avec les humains. Toutefois, cette coopération exige également que les agents valident les entités humaines avec lesquelles ils collaborent, car ces interactions ne se font pas toujours avec des personnes authentifiées à l'aide d'un outil d'incitation. Prenez l'exemple de l'escroquerie du deepfake, où un employé du secteur financier à Hong Kong a déboursé 25 millions de dollars en supposant qu'une version deepfake du directeur financier lors d'une réunion sur le web était en fait le vrai directeur financier. Cette situation met en évidence le risque croissant que représentent les agents capables d'usurper l'identité d'un être humain, d'autant plus qu'il est plus facile de le faire avec les modèles multimodaux les plus récents. L'OpenAI a récemment averti qu'un échantillon de voix de 15 secondes suffirait pour se faire passer pour la voix d'un être humain. Les vidéos "deepfake" ne sont pas loin derrière, comme l'illustre l'affaire de Hong Kong.

En outre, dans certains cas, le partage de secrets délégués entre les humains et les agents est essentiel pour mener à bien une tâche, par exemple par l'intermédiaire d'un portefeuille (pour un agent personnel). Dans le contexte de l'entreprise, un agent financier peut avoir besoin de valider l'identité légale des personnes et leurs relations. Il n' existe aujourd'hui aucune méthode normalisée permettant aux agents de le faire. Sans cela, les agents ne pourront pas collaborer avec les humains dans un monde où les humains seront de plus en plus les copilotes.

Ce problème devient particulièrement dangereux lorsque les pilotes automatiques d'IA prennent par inadvertance des décisions basées sur des acteurs malveillants se faisant passer pour un collaborateur humain. En l'absence d'un moyen clair d'authentifier numériquement les humains, les agents sont susceptibles d'agir d'une manière qui entre en conflit avec des objectifs commerciaux plus larges, tels que la sécurité, la conformité ou les considérations éthiques.

Conseil d'atténuation: Il est essentiel de procéder à des examens réguliers des identités des utilisateurs et des agents impliqués dans l'exécution des tâches des pilotes automatiques d'IA. Les organisations devraient utiliser des algorithmes adaptatifs et des mécanismes de retour d'information en temps réel pour s'assurer que les systèmes d'IA restent en phase avec l'évolution des utilisateurs et des exigences réglementaires. En ajustant les objectifs en fonction des besoins, les entreprises peuvent éviter que des objectifs mal alignés n'entraînent des conséquences imprévues.

Sécuriser les pilotes automatiques d'IA : Meilleures pratiques

Outre les contrôles de sécurité examinés dans les deux couches précédentes, qui comprennent la protection des LLM pour les LLM et les contrôles de données pour les copilotes, la couche agentique nécessite l'introduction d'un rôle élargi pour la gestion de l'identité et de l'accès (IAM), ainsi que pour l'exécution de tâches de confiance.

Pour atténuer les risques liés aux pilotes automatiques d'IA, les organisations doivent adopter une stratégie de sécurité globale. Cela inclut :

- Surveillance continue : Mettez en œuvre une analyse comportementale en temps réel pour détecter les anomalies et les actions non autorisées.

- Gouvernance éthique : Mettez en place des comités d'éthique et des cadres de responsabilité pour veiller à ce que les systèmes d'IA soient conformes aux valeurs de l'organisation et aux exigences légales.

- Défense contre les adversaires : Utilisez une formation contradictoire et une validation robuste des entrées pour éviter les manipulations.

- Contrôle humain : Maintenir les systèmes HITL afin d'assurer le contrôle des décisions critiques prises par l'IA.

En mettant en œuvre ces bonnes pratiques, les organisations peuvent s'assurer que les pilotes automatiques d'IA fonctionnent en toute sécurité et en adéquation avec leurs objectifs commerciaux.

La voie à suivre : Sécuriser l'IA autonome

Les pilotes automatiques d'IA promettent de révolutionner les industries en automatisant des tâches complexes, mais ils introduisent également des risques de sécurité importants. Qu'il s'agisse d'actions malhonnêtes ou de manipulations adverses, les organisations doivent rester vigilantes dans la gestion de ces risques. Alors que l'IA continue d'évoluer, il est crucial de donner la priorité à la sécurité à chaque étape pour s'assurer que ces systèmes fonctionnent en toute sécurité et en conformité avec les objectifs de l'organisation.

Pour en savoir plus sur la sécurisation de vos applications d'IA : Lisez notre Solution Brief

Autres blogs dans cette série :

Retour à Blogs