Por Sekhar Sarukkai - Ciberseguridad@UC Berkeley

25 de octubre de 2024 6 Minuto de lectura

En el blog anterior, exploramos los retos de seguridad asociados a los Copilotos de IA, sistemas que ayudan con tareas y decisiones pero que siguen dependiendo de la aportación humana. Hablamos de riesgos como el envenenamiento de datos, el uso indebido de permisos y los Copilotos de IA deshonestos. A medida que los sistemas de IA avanzan con la aparición de marcos agénticos de IA como LangGraph y AutoGen, aumenta el potencial de riesgos para la seguridad, especialmente con los Autopilotos de IA, la siguiente capa de desarrollo de la IA.

En este último blog de nuestra serie, nos centraremos en la capa 3: los pilotos automáticos de IA, sistemas autónomos que pueden realizar tareas con poca o ninguna intervención humana. Aunque ofrecen un enorme potencial para la automatización de tareas y la eficiencia operativa, los pilotos automáticos de IA también introducen importantes riesgos de seguridad que las organizaciones deben abordar para garantizar un despliegue seguro.

Beneficios y riesgos de los pilotos automáticos de IA

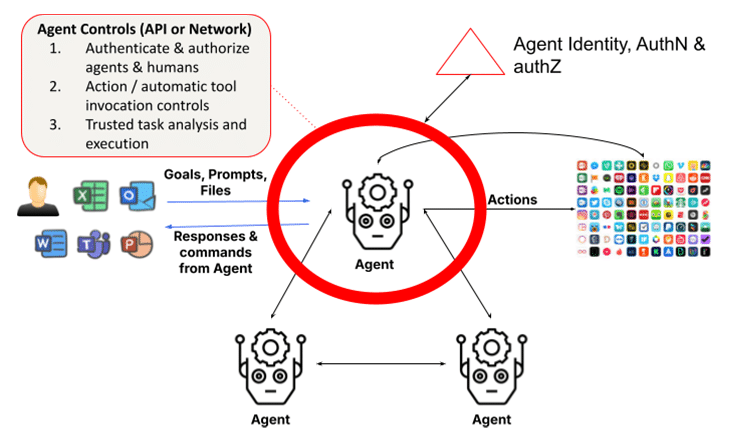

Los sistemas agenéticos se basan en grandes modelos lingüísticos (LLM) y en la generación aumentada por recuperación (RAG). Añaden la capacidad de actuar mediante la introspección, el análisis de tareas, la llamada a funciones y el aprovechamiento de otros agentes o humanos para completar sus tareas. Esto requiere que los agentes utilicen un marco para identificar y validar las identidades de agentes y humanos, así como para garantizar que las acciones y los resultados son fiables. La simple visión de un LLM interactuando con un humano en la Capa 1 se sustituye por una colección de grupos de agentes formados dinámicamente que trabajan juntos para completar una tarea, lo que multiplica las preocupaciones en materia de seguridad. De hecho, la versión más reciente de Claude de Anthropic es una función que permite a la IA utilizar ordenadores en su nombre, lo que permite a la IA utilizar las herramientas necesarias para completar una tarea de forma autónoma: una bendición para los usuarios y un reto para los responsables de la seguridad.

1. Acciones autónomas rebeldes o adversarias

Los pilotos automáticos de IA son capaces de ejecutar tareas de forma autónoma basándose en objetivos predefinidos. Sin embargo, esta autonomía abre el riesgo de acciones deshonestas, en las que un piloto automático podría desviarse del comportamiento previsto debido a fallos de programación o a la manipulación de un adversario. Los sistemas de IA deshonestos podrían causar resultados no deseados o perjudiciales, desde violaciones de datos hasta fallos operativos.

Por ejemplo, un piloto automático de IA que gestione sistemas de infraestructuras críticas podría apagar accidentalmente las redes eléctricas o desactivar funciones esenciales debido a una mala interpretación de los datos de entrada o a un descuido de programación. Una vez puestas en marcha, estas acciones deshonestas podrían ser difíciles de detener sin una intervención inmediata.

Los ataques de los adversarios suponen una grave amenaza para los pilotos automáticos de IA, sobre todo en sectores en los que las decisiones autónomas pueden tener consecuencias críticas. Los atacantes pueden manipular sutilmente los datos de entrada o el entorno para engañar a los modelos de IA y hacerles tomar decisiones incorrectas. Estos ataques adversarios suelen estar diseñados para pasar desapercibidos, explotando las vulnerabilidades del proceso de toma de decisiones del sistema de IA.

Por ejemplo, un dron autónomo podría ser manipulado para que cambie su trayectoria de vuelo por atacantes que alteren sutilmente el entorno (ejemplo: colocando objetos en la trayectoria del dron que perturben sus sensores). Del mismo modo, los vehículos autónomos podrían ser engañados para que se detuvieran o desviaran de su trayectoria debido a pequeños cambios imperceptibles en las señales o marcas viales.

Consejo de mitigación: Implemente la supervisión en tiempo real y el análisis del comportamiento para detectar cualquier desviación del comportamiento esperado de la IA. Deben establecerse mecanismos a prueba de fallos para detener inmediatamente los sistemas autónomos si comienzan a ejecutar acciones no autorizadas. Para defenderse de los ataques adversarios, las organizaciones deben implantar técnicas sólidas de validación de entradas y pruebas frecuentes de los modelos de IA. El entrenamiento contra adversarios, en el que los modelos de IA se entrenan para reconocer y resistir entradas manipuladoras, es esencial para garantizar que los pilotos automáticos de IA puedan resistir estas amenazas.

2. Falta de transparencia y riesgos éticos

Con los pilotos automáticos de IA operando sin supervisión humana directa, las cuestiones de responsabilidad se vuelven más complejas. Si un sistema autónomo toma una mala decisión que provoca pérdidas financieras, interrupciones operativas o complicaciones legales, determinar la responsabilidad puede resultar difícil. Esta falta de rendición de cuentas clara plantea importantes cuestiones éticas, sobre todo en industrias en las que la seguridad y la equidad son primordiales.

Los riesgos éticos también surgen cuando estos sistemas priorizan la eficiencia sobre la equidad o la seguridad, lo que puede conducir a resultados discriminatorios o a decisiones que entren en conflicto con los valores de la organización. Por ejemplo, un piloto automático de IA en un sistema de contratación podría priorizar inadvertidamente las medidas de ahorro sobre la diversidad, dando lugar a prácticas de contratación sesgadas.

Consejo de mitigación: Establezca marcos de responsabilidad y consejos de supervisión ética para garantizar que los pilotos automáticos de IA se alinean con los valores de la organización. Deben realizarse auditorías periódicas y revisiones éticas para supervisar la toma de decisiones de la IA, y deben establecerse estructuras claras de rendición de cuentas para gestionar los posibles problemas legales que surjan de las acciones autónomas.

3. Identidad del agente, autenticación y autorización

Un problema fundamental de los sistemas multiagente es la necesidad de autenticar las identidades de los agentes y autorizar las solicitudes de los agentes clientes. Esto puede suponer un reto si los agentes pueden hacerse pasar por otros agentes o si las identidades de los agentes solicitantes no pueden verificarse con firmeza. En un mundo futuro en el que los agentes con privilegios escalados se comuniquen entre sí y completen tareas, los daños ocasionados pueden ser instantáneos y difíciles de detectar a menos que se apliquen estrictamente controles de autorización de grano fino.

A medida que los agentes especializados proliferan y colaboran entre sí, resulta cada vez más importante la validación autorizada de las identidades de los agentes y sus credenciales para garantizar que no se infiltren agentes deshonestos en las empresas. Del mismo modo, los esquemas de permisos deben tener en cuenta el uso automatizado basado en la clasificación, el papel y la función de los agentes para la realización de tareas.

Consejo de mitigación: Para defenderse de los ataques de adversarios, las organizaciones deben implementar técnicas sólidas de validación de entradas y pruebas frecuentes de los modelos de IA. El entrenamiento contra adversarios, en el que los modelos de IA se entrenan para reconocer y resistir entradas manipuladoras, es esencial para garantizar que los pilotos automáticos de IA puedan resistir estas amenazas.

4. Exceso de confianza en la autonomía

A medida que las organizaciones adoptan cada vez más los pilotos automáticos de IA, crece el riesgo de confiar demasiado en la automatización. Esto sucede cuando las decisiones críticas se dejan enteramente en manos de sistemas autónomos sin supervisión humana. Aunque los pilotos automáticos de IA están diseñados para gestionar tareas rutinarias, eliminar la aportación humana de las decisiones críticas puede provocar puntos ciegos operativos y errores no detectados. Esto se manifiesta a través de las acciones automáticas de invocación de herramientas que llevan a cabo los agentes. Esto es un problema ya que, en muchos casos, estos agentes tienen privilegios elevados para realizar estas acciones. Y es un problema aún mayor cuando los agentes son autónomos, donde se puede utilizar el pirateo por inyección de comandos para forzar acciones nefastas sin el conocimiento del usuario. Además, en los sistemas multiagente, el problema del adjunto conf uso es un problema con las acciones que pueden elevar sigilosamente los privilegios.

La dependencia excesiva puede resultar especialmente peligrosa en entornos de ritmo rápido en los que sigue siendo necesario el juicio humano en tiempo real. Por ejemplo, un piloto automático de IA que gestione la ciberseguridad podría pasar por alto los matices de una amenaza en rápida evolución, confiando en sus respuestas programadas en lugar de ajustarse a los cambios inesperados.

Consejo de mitigación: Los sistemas "Human-in-the-loop" (HITL ) deben mantenerse para garantizar que los operadores humanos conservan el control sobre las decisiones críticas. Este enfoque híbrido permite a los pilotos automáticos de IA encargarse de las tareas rutinarias mientras los humanos supervisan y validan las decisiones importantes. Las organizaciones deben evaluar regularmente cuándo y dónde es necesaria la intervención humana para evitar una dependencia excesiva de los sistemas de IA.

5. Identidad jurídica humana y confianza

Los pilotos automáticos de IA operan basándose en objetivos predefinidos y en cooperación con los humanos. Sin embargo, esta cooperación también requiere que los agentes validen a las entidades humanas con las que están colaborando, ya que estas interacciones no siempre se producen con personas autentificadas que utilizan una herramienta de ayuda. Consideremos la estafa del deepfake, en la que un trabajador financiero de Hong Kong pagó 25 millones de dólares al asumir que una versión deepfake del director financiero en una reunión web era realmente el director financiero real. Esto pone de relieve el creciente riesgo de los agentes que pueden hacerse pasar por humanos, especialmente desde que hacerse pasar por humanos se hace más fácil con los últimos modelos multimodales. OpenAI advirtió recientemente de que una muestra de voz de 15 segundos bastaría para hacerse pasar por la voz de un humano. Los vídeos deepfake no se quedan atrás, como ilustra el caso de Hong Kong.

Además, en ciertos casos, el intercambio delegado de secretos entre humanos y agentes es esencial para completar una tarea, por ejemplo, a través de una cartera (para un agente personal). En el contexto empresarial, un agente financiero puede necesitar validar la identidad legal de los humanos y sus relaciones. Hoy en día no existe una forma estandarizada para que los agentes lo hagan. Sin ello, los agentes no podrán colaborar con los humanos en un mundo en el que éstos serán cada vez más los copilotos.

Esta cuestión se vuelve especialmente peligrosa cuando los pilotos automáticos de IA toman inadvertidamente decisiones basadas en malos actores que se hacen pasar por un colaborador humano. Sin una forma clara de autenticar digitalmente a los humanos, los agentes son susceptibles de actuar de formas que entran en conflicto con objetivos empresariales más amplios, como la seguridad, el cumplimiento o las consideraciones éticas.

Consejo de mitigación: Es esencial realizar revisiones periódicas de las identidades de los usuarios y agentes implicados en las ejecuciones de tareas de los pilotos automáticos de IA. Las organizaciones deben utilizar algoritmos adaptativos y mecanismos de retroalimentación en tiempo real para garantizar que los sistemas de IA permanezcan alineados con los usuarios cambiantes y los requisitos normativos. Ajustando los objetivos según sea necesario, las empresas pueden evitar que los objetivos desalineados provoquen consecuencias imprevistas.

Asegurar los pilotos automáticos de IA: Buenas prácticas

Además de los controles de seguridad comentados en las dos capas anteriores, que incluyen la protección de los LLM y los controles de datos para los copilotos, la capa agéntica requiere la introducción de un papel ampliado para la gestión de identidades y accesos (IAM), así como la ejecución de tareas de confianza.

Para mitigar los riesgos de los pilotos automáticos de IA, las organizaciones deben adoptar una estrategia de seguridad integral. Esto incluye:

- Supervisión continua: Implemente análisis de comportamiento en tiempo real para detectar anomalías y acciones no autorizadas.

- Gobernanza ética: Establezca consejos de ética y marcos de responsabilidad para garantizar que los sistemas de IA se ajustan a los valores de la organización y a los requisitos legales.

- Defensa adversarial: Utilice la formación adversarial y una sólida validación de las entradas para evitar la manipulación.

- Supervisión humana: Mantener los sistemas HITL para conservar la supervisión de las decisiones críticas tomadas por la IA.

Mediante la aplicación de estas mejores prácticas, las organizaciones pueden garantizar que los pilotos automáticos de IA funcionen de forma segura y en consonancia con sus objetivos empresariales.

El camino a seguir: Asegurar la IA autónoma

Los pilotos automáticos de IA prometen revolucionar las industrias automatizando tareas complejas, pero también introducen importantes riesgos de seguridad. Desde las acciones deshonestas hasta la manipulación adversaria, las organizaciones deben mantenerse vigilantes en la gestión de estos riesgos. A medida que la IA sigue evolucionando, es crucial dar prioridad a la seguridad en cada etapa para garantizar que estos sistemas funcionen de forma segura y en consonancia con los objetivos de la organización.

Para saber más sobre la seguridad de sus aplicaciones de IA: Lea nuestro Resumen de la solución

Otros blogs de esta serie:

Volver a Blogs