Sumber daya

Menimbang Manfaat dan Risiko Autopilot AI

Oleh Sekhar Sarukkai - Cybersecurity@UC Berkeley

25 Oktober 2024 6 Menit Baca

Dalam blog sebelumnya, kami telah membahas tantangan keamanan yang terkait dengan AI Copilot, sistem yang membantu tugas dan keputusan tetapi masih bergantung pada input manusia. Kami membahas risiko seperti keracunan data, penyalahgunaan izin, dan AI Copilot yang nakal. Seiring kemajuan sistem AI dengan munculnya kerangka kerja agen AI seperti LangGraph dan AutoGen, potensi risiko keamanan meningkat-terutama dengan Autopilot AI, lapisan pengembangan AI berikutnya.

Dalam blog terakhir dari seri ini, kami akan berfokus pada Layer 3: Autopilot AI - sistem agen otonom yang dapat melakukan tugas dengan sedikit atau tanpa campur tangan manusia. Meskipun menawarkan potensi yang luar biasa untuk otomatisasi tugas dan efisiensi operasional, Autopilot AI juga memperkenalkan risiko keamanan yang signifikan yang harus diatasi oleh organisasi untuk memastikan penerapan yang aman.

Manfaat dan Risiko Autopilot AI

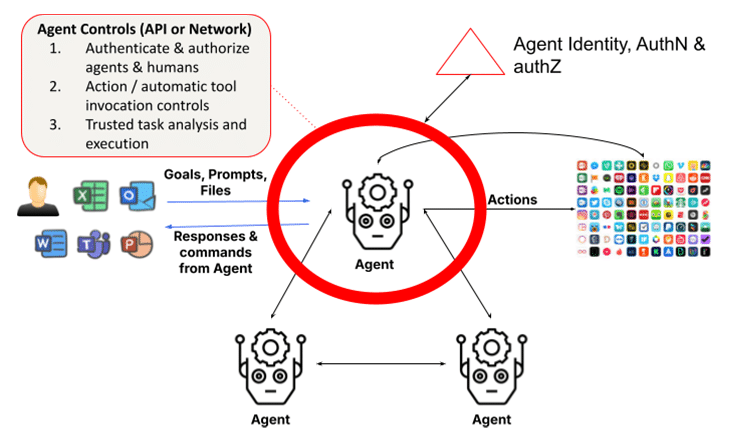

Sistem agen dibangun di atas model bahasa besar (LLM) dan generasi yang ditambah dengan pengambilan (RAG). Sistem ini menambahkan kemampuan untuk mengambil tindakan melalui introspeksi, analisis tugas, pemanggilan fungsi, dan memanfaatkan agen atau manusia lain untuk menyelesaikan tugasnya. Hal ini mengharuskan agen untuk menggunakan kerangka kerja untuk mengidentifikasi dan memvalidasi identitas agen dan manusia serta memastikan bahwa tindakan dan hasilnya dapat dipercaya. Tampilan sederhana LLM yang berinteraksi dengan manusia di Layer 1 digantikan oleh kumpulan kelompok agen yang dibentuk secara dinamis yang bekerja sama untuk menyelesaikan tugas, sehingga meningkatkan masalah keamanan berkali-kali lipat. Faktanya, rilis terbaru Claude dari Anthropic adalah fitur yang memungkinkan AI untuk menggunakan komputer atas nama Anda, memungkinkan AI untuk menggunakan alat yang diperlukan untuk menyelesaikan tugas secara mandiri - sebuah berkah bagi pengguna dan tantangan bagi para petugas keamanan.

1. Tindakan Otonom yang Nakal atau Bermusuhan

Autopilot AI mampu melaksanakan tugas secara mandiri berdasarkan tujuan yang telah ditentukan. Namun, otonomi ini membuka risiko tindakan nakal, di mana autopilot mungkin menyimpang dari perilaku yang dimaksudkan karena kekurangan pemrograman atau manipulasi yang merugikan. Sistem AI yang nakal dapat menyebabkan hasil yang tidak diinginkan atau berbahaya, mulai dari pelanggaran data hingga kegagalan operasional.

Misalnya, Autopilot AI yang mengelola sistem infrastruktur penting dapat secara tidak sengaja mematikan jaringan listrik atau menonaktifkan fungsi-fungsi penting karena data input yang salah diartikan atau kesalahan pemrograman. Setelah dijalankan, tindakan nakal ini akan sulit dihentikan tanpa intervensi segera.

Serangan musuh merupakan ancaman serius bagi Autopilot AI, terutama di industri di mana keputusan otonom dapat memiliki konsekuensi yang sangat penting. Penyerang dapat memanipulasi data input atau lingkungan secara halus untuk mengelabui model AI agar membuat keputusan yang salah. Serangan musuh ini sering kali dirancang untuk tidak terdeteksi, mengeksploitasi kerentanan dalam proses pengambilan keputusan sistem AI.

Sebagai contoh, drone otonom dapat dimanipulasi untuk mengubah jalur penerbangannya oleh penyerang yang secara halus mengubah lingkungan (contoh: menempatkan objek di jalur drone yang mengganggu sensornya). Demikian pula, kendaraan otonom dapat diakali untuk berhenti atau berbelok dari jalurnya karena perubahan kecil yang tidak terlihat pada rambu-rambu atau marka jalan.

Tip Mitigasi: Terapkan pemantauan waktu nyata dan analisis perilaku untuk mendeteksi penyimpangan dari perilaku AI yang diharapkan. Mekanisme gagal-aman harus dibuat untuk segera menghentikan sistem otonom jika mereka mulai melakukan tindakan yang tidak sah. Untuk mempertahankan diri dari serangan lawan, organisasi harus menerapkan teknik validasi input yang kuat dan pengujian model AI yang sering. Pelatihan musuh, di mana model AI dilatih untuk mengenali dan menolak input manipulatif, sangat penting untuk memastikan bahwa Autopilot AI dapat bertahan dari ancaman ini.

2. Kurangnya Transparansi dan Risiko Etika

Dengan Autopilot AI yang beroperasi tanpa pengawasan langsung dari manusia, masalah akuntabilitas menjadi lebih kompleks. Jika sistem otonom membuat keputusan yang buruk yang mengakibatkan kerugian finansial, gangguan operasional, atau komplikasi hukum, menentukan tanggung jawab bisa menjadi sulit. Kurangnya akuntabilitas yang jelas ini menimbulkan pertanyaan etis yang signifikan, terutama dalam industri yang mengutamakan keselamatan dan keadilan.

Risiko etika juga muncul ketika sistem ini memprioritaskan efisiensi di atas keadilan atau keamanan, yang berpotensi mengarah pada hasil diskriminatif atau keputusan yang bertentangan dengan nilai-nilai organisasi. Misalnya, Autopilot AI dalam sistem perekrutan mungkin secara tidak sengaja memprioritaskan langkah-langkah penghematan biaya daripada keragaman, yang mengakibatkan praktik perekrutan yang bias.

Kiat Mitigasi: Tetapkan kerangka kerja akuntabilitas dan dewan pengawas etika untuk memastikan Autopilot AI selaras dengan nilai-nilai organisasi. Audit rutin dan tinjauan etika harus dilakukan untuk memantau pengambilan keputusan AI, dan struktur akuntabilitas yang jelas harus dibuat untuk menangani potensi masalah hukum yang muncul dari tindakan otonom.

3. Identitas Agen, Otentikasi dan Otorisasi

Masalah mendasar pada sistem multi-agen adalah kebutuhan untuk mengautentikasi identitas agen dan mengesahkan permintaan agen klien. Hal ini bisa menjadi tantangan jika agen bisa menyamar sebagai agen lain atau jika permintaan identitas agen tidak bisa diverifikasi dengan baik. Di dunia masa depan di mana agen yang memiliki hak istimewa berkomunikasi satu sama lain dan menyelesaikan tugas, kerusakan yang terjadi dapat terjadi seketika dan sulit dideteksi kecuali jika kontrol otorisasi yang sangat halus ditegakkan secara ketat.

Ketika agen khusus berkembang biak dan berkolaborasi satu sama lain, menjadi semakin penting untuk validasi otoritatif identitas agen dan kredensial mereka untuk memastikan tidak ada penyusupan agen nakal di perusahaan. Demikian pula, skema pemberian izin perlu memperhitungkan penggunaan otomatis berbasis klasifikasi agen, peran, dan fungsi untuk penyelesaian tugas.

Tip Mitigasi: Untuk mempertahankan diri dari serangan lawan, organisasi harus menerapkan teknik validasi input yang kuat dan pengujian model AI yang sering. Pelatihan adversarial, di mana model AI dilatih untuk mengenali dan menolak input manipulatif, sangat penting untuk memastikan bahwa Autopilot AI dapat bertahan dari ancaman ini.

4. Ketergantungan yang Berlebihan pada Otonomi

Seiring dengan semakin banyaknya organisasi yang mengadopsi Autopilot AI, terdapat risiko ketergantungan yang berlebihan pada otomatisasi. Hal ini terjadi ketika keputusan penting diserahkan sepenuhnya kepada sistem otonom tanpa pengawasan manusia. Meskipun Autopilot AI dirancang untuk menangani tugas-tugas rutin, menghilangkan input manusia dari keputusan penting dapat menyebabkan titik buta operasional dan kesalahan yang tidak terdeteksi. Hal ini dimanifestasikan melalui tindakan pemanggilan alat otomatis yang dilakukan oleh agen. Hal ini menjadi masalah karena, dalam banyak kasus, agen-agen ini memiliki hak istimewa yang tinggi untuk melakukan tindakan ini. Dan ini adalah masalah yang lebih besar ketika agen bersifat otonom di mana peretasan injeksi yang cepat dapat digunakan untuk memaksa tindakan jahat tanpa sepengetahuan pengguna. Selain itu, dalam sistem multi-agen, masalah wakil yang bingung adalah masalah dengan tindakan yang secara diam-diam dapat meningkatkan hak istimewa.

Ketergantungan yang berlebihan dapat menjadi sangat berbahaya di lingkungan yang bergerak cepat di mana penilaian manusia secara real-time masih diperlukan. Misalnya, Autopilot AI yang mengelola keamanan siber dapat kehilangan nuansa ancaman yang berkembang dengan cepat, karena mengandalkan respons terprogram alih-alih menyesuaikan diri dengan perubahan yang tidak terduga.

Tip Mitigasi: Sistem human-in-the-loop (HITL ) harus dipertahankan untuk memastikan bahwa operator manusia tetap memegang kendali atas keputusan penting. Pendekatan hibrida ini memungkinkan Autopilot AI untuk menangani tugas-tugas rutin sementara manusia mengawasi dan memvalidasi keputusan-keputusan penting. Organisasi harus secara teratur mengevaluasi kapan dan di mana campur tangan manusia diperlukan untuk mencegah ketergantungan yang berlebihan pada sistem AI.

5. Identitas Hukum dan Kepercayaan Manusia

Autopilot AI beroperasi berdasarkan tujuan yang telah ditentukan dan bekerja sama dengan manusia. Namun, kerja sama ini juga mengharuskan agen untuk memvalidasi entitas manusia yang bekerja sama dengan mereka, karena interaksi ini tidak selalu dengan orang yang terautentikasi menggunakan alat bantu. Pertimbangkan penipuan deepfake, di mana seorang pekerja keuangan di Hong Kong membayar $25 juta dengan mengasumsikan bahwa versi deepfake dari CFO dalam rapat web adalah CFO yang sebenarnya. Hal ini menyoroti meningkatnya risiko agen yang dapat menyamar sebagai manusia, terutama karena peniruan manusia menjadi lebih mudah dengan model multi-modal terbaru. OpenAI baru-baru ini memperingatkan bahwa sampel suara berdurasi 15 detik sudah cukup untuk meniru suara manusia. Video deepfake juga tidak ketinggalan, seperti yang diilustrasikan oleh kasus di Hong Kong.

Selain itu, dalam kasus tertentu, pembagian rahasia yang didelegasikan antara manusia dan agen sangat penting untuk menyelesaikan suatu tugas, misalnya, melalui dompet (untuk agen pribadi). Dalam konteks perusahaan, agen keuangan mungkin perlu memvalidasi identitas hukum manusia dan hubungan mereka. Tidak ada cara standar bagi agen untuk melakukannya saat ini. Tanpa ini, agen tidak akan dapat berkolaborasi dengan manusia di dunia di mana manusia akan semakin menjadi Kopilot.

Masalah ini menjadi sangat berbahaya ketika Autopilot AI secara tidak sengaja membuat keputusan berdasarkan aktor jahat yang menyamar sebagai kolaborator manusia. Tanpa cara yang jelas untuk mengautentikasi manusia secara digital, agen rentan bertindak dengan cara yang bertentangan dengan tujuan bisnis yang lebih luas, seperti keamanan, kepatuhan, atau pertimbangan etika.

Tip Mitigasi: Peninjauan rutin terhadap identitas pengguna dan agen yang terlibat dalam eksekusi tugas Autopilot AI sangatlah penting. Organisasi harus menggunakan algoritme adaptif dan mekanisme umpan balik waktu nyata untuk memastikan bahwa sistem AI tetap selaras dengan perubahan pengguna dan persyaratan peraturan. Dengan menyesuaikan tujuan sesuai kebutuhan, perusahaan dapat mencegah ketidakselarasan tujuan yang dapat menyebabkan konsekuensi yang tidak diinginkan.

Mengamankan Autopilot AI: Praktik Terbaik

Selain kontrol keamanan yang dibahas dalam dua lapisan sebelumnya yang mencakup perlindungan LLM untuk LLM dan kontrol data untuk Copilot, lapisan agen memerlukan pengenalan peran yang diperluas untuk manajemen identitas dan akses (IAM), serta eksekusi tugas tepercaya.

Untuk mengurangi risiko Autopilot AI, organisasi harus mengadopsi strategi keamanan yang komprehensif. Hal ini mencakup:

- Pemantauan berkelanjutan: Menerapkan analisis perilaku waktu nyata untuk mendeteksi anomali dan tindakan yang tidak sah.

- Tata kelola yang etis: Membentuk dewan etika dan kerangka kerja akuntabilitas untuk memastikan sistem AI selaras dengan nilai-nilai organisasi dan persyaratan hukum.

- Pertahanan lawan: Gunakan pelatihan lawan dan validasi masukan yang kuat untuk mencegah manipulasi.

- Pengawasan manusia: Menjaga sistem HITL untuk mempertahankan pengawasan terhadap keputusan penting yang dibuat oleh AI.

Dengan menerapkan praktik terbaik ini, organisasi dapat memastikan bahwa Autopilot AI beroperasi dengan aman dan selaras dengan tujuan bisnis mereka.

Jalan ke Depan: Mengamankan AI Otonom

Autopilot AI menjanjikan untuk merevolusi industri dengan mengotomatisasi tugas-tugas yang kompleks, tetapi juga menimbulkan risiko keamanan yang signifikan. Mulai dari tindakan jahat hingga manipulasi yang merugikan, organisasi harus tetap waspada dalam mengelola risiko ini. Karena AI terus berkembang, sangat penting untuk memprioritaskan keamanan di setiap tahap untuk memastikan sistem ini beroperasi dengan aman dan selaras dengan tujuan organisasi.

Untuk mempelajari lebih lanjut tentang mengamankan aplikasi AI Anda: Baca Ringkasan Solusi kami

Blog Lain Dalam Seri Ini:

- Bagian 1 - Keamanan AI: Kebutuhan dan Peluang Pelanggan

- Bagian 2 - AI Dasar: Lapisan Kritis dengan Tantangan Keamanan

- Bagian 3 - Risiko dan Tantangan Keamanan dengan Kopilot AI

- Bagian 4 - Menimbang Manfaat dan Risiko Autopilot AI

Konten Terkait

Blog yang sedang tren

Atribut LLM yang Harus Dipantau oleh Setiap CISO Saat Ini

Sarang Warudkar 18 Februari 2026

Dari Persyaratan DPDPA hingga Visibilitas Data: Kebutuhan Mendesak DSPM

Niharika Ray dan Sarang Warudkar 12 Februari 2026

Skyhigh Security 2025: Pengendalian yang lebih ketat, visibilitas yang lebih jelas, dan tindakan yang lebih cepat di seluruh data, web, dan cloud.

Thyaga Vasudevan 21 Januari 2026

Risiko Tersembunyi GenAI yang Bisa Mengakibatkan Kerugian Jutaan Dolar bagi Perusahaan Anda (Dan Cara Mengatasinya Hari Ini)

Jesse Grindeland 18 Desember 2025

Skyhigh Security : 2026 Adalah Tahun di Mana Kecerdasan Buatan (AI) Memaksa Terciptanya Rencana Baru untuk Keamanan Perusahaan

Thyaga Vasudevan 12 Desember 2025