Ressourcen

Abwägung der Vorteile und Risiken von KI-Autopiloten

Von Sekhar Sarukkai - Cybersecurity@UC Berkeley

Oktober 25, 2024 6 Minute gelesen

Im letzten Blog haben wir uns mit den Sicherheitsherausforderungen im Zusammenhang mit KI-Copiloten beschäftigt, also Systemen, die bei Aufgaben und Entscheidungen helfen, aber immer noch auf menschliche Eingaben angewiesen sind. Wir haben Risiken wie Data Poisoning, Missbrauch von Berechtigungen und böswillige KI-Copiloten besprochen. Mit der Weiterentwicklung von KI-Systemen und dem Aufkommen von KI-Agenten-Frameworks wie LangGraph und AutoGen steigt das Potenzial für Sicherheitsrisiken - insbesondere bei KI-Autopiloten, der nächsten Stufe der KI-Entwicklung.

In diesem letzten Blog unserer Serie konzentrieren wir uns auf Schicht 3: KI-Autopiloten - autonome agentenbasierte Systeme, die Aufgaben mit wenig oder gar keinem menschlichen Eingriff ausführen können. Sie bieten zwar ein enormes Potenzial für die Automatisierung von Aufgaben und betriebliche Effizienz, aber KI-Autopiloten bergen auch erhebliche Sicherheitsrisiken, die Unternehmen angehen müssen, um einen sicheren Einsatz zu gewährleisten.

Vorteile und Risiken von KI-Autopiloten

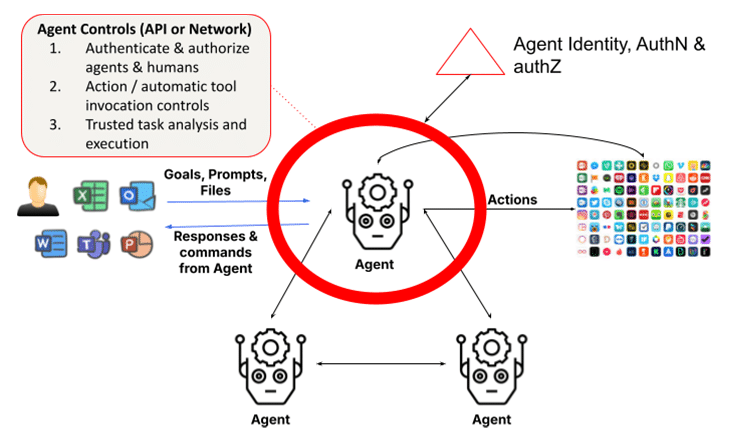

Agentische Systeme bauen auf großen Sprachmodellen (LLMs) und Retrieval-augmented Generation (RAGs) auf. Sie fügen die Fähigkeit hinzu, über Introspektion, Aufgabenanalyse, Funktionsaufrufe und die Nutzung anderer Agenten oder Menschen zur Erfüllung ihrer Aufgaben zu handeln. Dies setzt voraus, dass die Agenten ein Rahmenwerk verwenden, um die Identität von Agenten und Menschen zu identifizieren und zu validieren und um sicherzustellen, dass die Aktionen und Ergebnisse vertrauenswürdig sind. Die einfache Sichtweise eines LLM, der mit einem Menschen in Schicht 1 interagiert, wird durch eine Sammlung dynamisch gebildeter Gruppen von Agenten ersetzt, die zusammenarbeiten, um eine Aufgabe zu erfüllen, was die Sicherheitsbedenken um ein Vielfaches erhöht. Die jüngste Version von Claude von Anthropic ist eine Funktion, die es der KI ermöglicht, Computer in Ihrem Namen zu nutzen. So kann die KI Werkzeuge verwenden, die für die autonome Erledigung einer Aufgabe erforderlich sind - ein Segen für die Benutzer und eine Herausforderung für die Sicherheitsexperten.

1. Schurkische oder feindliche autonome Handlungen

KI-Autopiloten sind in der Lage, Aufgaben auf der Grundlage vordefinierter Ziele selbstständig auszuführen. Diese Autonomie birgt jedoch das Risiko, dass ein Autopilot aufgrund von Programmierfehlern oder gegnerischen Manipulationen von seinem beabsichtigten Verhalten abweicht. Schurkische KI-Systeme könnten unbeabsichtigte oder schädliche Folgen haben, die von Datenverletzungen bis hin zu Betriebsausfällen reichen.

Ein KI-Autopilot, der kritische Infrastruktursysteme verwaltet, könnte beispielsweise aufgrund falsch interpretierter Eingabedaten oder eines Programmierfehlers versehentlich Stromnetze abschalten oder wichtige Funktionen deaktivieren. Einmal in Gang gesetzt, könnten diese unvorhergesehenen Aktionen ohne sofortiges Eingreifen schwer zu stoppen sein.

Angriffe durch Angreifer stellen eine ernsthafte Bedrohung für KI-Autopiloten dar, insbesondere in Branchen, in denen autonome Entscheidungen kritische Konsequenzen haben können. Angreifer können auf subtile Weise Eingabedaten oder die Umgebung manipulieren, um KI-Modelle dazu zu bringen, falsche Entscheidungen zu treffen. Diese feindlichen Angriffe sind oft so konzipiert, dass sie unentdeckt bleiben und Schwachstellen im Entscheidungsprozess des KI-Systems ausnutzen.

Eine autonome Drohne könnte zum Beispiel durch subtile Veränderungen der Umgebung (z. B. Platzierung von Objekten in der Flugbahn der Drohne, die ihre Sensoren stören) dazu gebracht werden, ihre Flugbahn zu ändern. Ebenso könnten autonome Fahrzeuge durch kleine, nicht wahrnehmbare Änderungen von Straßenschildern oder -markierungen dazu gebracht werden, anzuhalten oder vom Kurs abzuweichen.

Tipp zur Schadensbegrenzung: Implementieren Sie Echtzeitüberwachung und Verhaltensanalyse, um Abweichungen vom erwarteten KI-Verhalten zu erkennen. Es sollten ausfallsichere Mechanismen eingerichtet werden, um autonome Systeme sofort zu stoppen, wenn sie beginnen, unautorisierte Aktionen auszuführen. Um sich gegen feindliche Angriffe zu schützen, sollten Unternehmen robuste Eingabevalidierungstechniken und häufige Tests von KI-Modellen einsetzen. Um sicherzustellen, dass KI-Autopiloten diesen Bedrohungen standhalten können, ist ein Training der KI-Modelle zur Erkennung und Abwehr von manipulativen Eingaben unerlässlich.

2. Mangelnde Transparenz und ethische Risiken

Mit KI-Autopiloten, die ohne direkte menschliche Aufsicht arbeiten, werden Fragen der Verantwortlichkeit noch komplexer. Wenn ein autonomes System eine schlechte Entscheidung trifft, die zu finanziellen Verlusten, Betriebsunterbrechungen oder rechtlichen Komplikationen führt, kann es schwierig sein, die Verantwortung zu bestimmen. Das Fehlen einer klaren Verantwortlichkeit wirft erhebliche ethische Fragen auf, insbesondere in Branchen, in denen Sicherheit und Fairness an erster Stelle stehen.

Ethische Risiken entstehen auch, wenn diese Systeme der Effizienz Vorrang vor Fairness oder Sicherheit einräumen. Dies kann zu diskriminierenden Ergebnissen oder Entscheidungen führen, die mit den Werten des Unternehmens in Konflikt stehen. Zum Beispiel könnte ein KI-Autopilot in einem Einstellungssystem versehentlich Kosteneinsparungen gegenüber der Vielfalt bevorzugen, was zu voreingenommenen Einstellungspraktiken führt.

Tipp zur Abhilfe: Schaffen Sie einen Rahmen für die Rechenschaftspflicht und ethische Aufsichtsgremien, um sicherzustellen, dass KI-Autopiloten mit den Unternehmenswerten übereinstimmen. Es sollten regelmäßige Audits und ethische Überprüfungen durchgeführt werden, um die KI-Entscheidungsfindung zu überwachen, und es sollten klare Verantwortlichkeitsstrukturen eingerichtet werden, um potenzielle rechtliche Probleme zu behandeln, die sich aus autonomen Aktionen ergeben.

3. Agentenidentität, Authentifizierung und Autorisierung

Ein grundlegendes Problem bei Multi-Agenten-Systemen ist die Notwendigkeit, die Identitäten der Agenten zu authentifizieren und Anfragen von Client-Agenten zu autorisieren. Dies kann eine Herausforderung darstellen, wenn Agenten sich als andere Agenten ausgeben können oder wenn die Identität des anfragenden Agenten nicht eindeutig überprüft werden kann. In einer zukünftigen Welt, in der Agenten mit erweiterten Rechten miteinander kommunizieren und Aufgaben erledigen, kann der entstandene Schaden sofort und schwer zu erkennen sein, wenn keine feinkörnigen Autorisierungskontrollen streng durchgesetzt werden.

Da sich spezialisierte Agenten immer weiter verbreiten und miteinander zusammenarbeiten, wird es immer wichtiger, die Identität der Agenten und ihre Berechtigungsnachweise verbindlich zu überprüfen, um sicherzustellen, dass keine bösartigen Agenten in das Unternehmen eindringen. In ähnlicher Weise müssen Berechtigungsschemata die Klassifizierung der Agenten sowie die rollen- und funktionsbasierte automatische Nutzung zur Aufgabenerfüllung berücksichtigen.

Tipp zur Schadensbegrenzung: Um sich gegen feindliche Angriffe zu schützen, sollten Unternehmen robuste Eingabevalidierungstechniken und häufige Tests von KI-Modellen implementieren. Adversarial Training, bei dem KI-Modelle darauf trainiert werden, manipulative Eingaben zu erkennen und abzuwehren, ist entscheidend, um sicherzustellen, dass KI-Autopiloten diesen Bedrohungen standhalten können.

4. Übermäßiges Vertrauen in die Autonomie

Da Unternehmen zunehmend KI-Autopiloten einsetzen, wächst die Gefahr, dass sie sich zu sehr auf die Automatisierung verlassen. Dies geschieht, wenn kritische Entscheidungen vollständig autonomen Systemen ohne menschliche Aufsicht überlassen werden. KI-Autopiloten sind zwar für die Erledigung von Routineaufgaben konzipiert, aber wenn der Mensch bei kritischen Entscheidungen nicht mehr mitwirkt, kann dies zu blinden Flecken und unentdeckten Fehlern führen. Dies äußert sich in automatischen Werkzeugaufrufen, die von Agenten durchgeführt werden. Dies ist ein Problem, da diese Agenten in vielen Fällen über erhöhte Berechtigungen verfügen, um diese Aktionen durchzuführen. Dies ist ein noch größeres Problem, wenn die Agenten autonom sind, da sie durch Prompt Injection Hacking ohne das Wissen des Benutzers schändliche Aktionen erzwingen können. In Multi-Agenten-Systemen ist außerdem das Problem des verwirrten Stellvertreters ein Problem mit Aktionen, die die Privilegien heimlich ausweiten können.

Übermäßiges Vertrauen kann vor allem in schnelllebigen Umgebungen gefährlich werden, in denen immer noch menschliches Urteilsvermögen in Echtzeit erforderlich ist. Ein KI-Autopilot, der die Cybersicherheit verwaltet, könnte beispielsweise die Feinheiten einer sich schnell entwickelnden Bedrohung übersehen, weil er sich auf seine programmierten Antworten verlässt, anstatt sich an unerwartete Veränderungen anzupassen.

Tipp zur Schadensbegrenzung: Human-in-the-Loop-Systeme (HITL) sollten beibehalten werden, um sicherzustellen, dass menschliche Bediener die Kontrolle über kritische Entscheidungen behalten. Dieser hybride Ansatz ermöglicht es KI-Autopiloten, Routineaufgaben zu erledigen, während Menschen wichtige Entscheidungen überwachen und validieren. Unternehmen sollten regelmäßig prüfen, wann und wo menschliches Eingreifen erforderlich ist, um eine übermäßige Abhängigkeit von KI-Systemen zu vermeiden.

5. Menschliche Rechtsidentität und Vertrauen

KI-Autopiloten arbeiten auf der Grundlage vordefinierter Ziele und in Zusammenarbeit mit Menschen. Diese Zusammenarbeit erfordert jedoch auch, dass die Agenten die menschlichen Entitäten, mit denen sie zusammenarbeiten, validieren, da diese Interaktionen nicht immer mit authentifizierten Personen stattfinden, die ein Prompting-Tool verwenden. Denken Sie an den Deepfake-Betrug, bei dem ein Finanzangestellter in Hongkong 25 Millionen Dollar ausgezahlt hat, weil er annahm, dass eine Deepfake-Version des CFO in einem Web-Meeting tatsächlich der echte CFO war. Dies unterstreicht das zunehmende Risiko von Agenten, die sich als Menschen ausgeben können, zumal das Nachahmen von Menschen mit den neuesten multimodalen Modellen immer einfacher wird. OpenAI warnte kürzlich, dass eine 15-sekündige Stimmprobe ausreicht, um die Stimme eines Menschen zu imitieren. Deepfake-Videos sind nicht weit entfernt, wie der Fall in Hongkong zeigt.

Darüber hinaus ist in bestimmten Fällen die delegierte Weitergabe von Geheimnissen zwischen Menschen und Agenten unerlässlich, um eine Aufgabe zu erfüllen, z. B. über eine Brieftasche (für einen persönlichen Agenten). Im Unternehmenskontext muss ein Finanzagent möglicherweise die rechtliche Identität von Menschen und deren Beziehungen überprüfen. Heute gibt es keine standardisierte Möglichkeit für Agenten, dies zu tun. Ohne diese Möglichkeit werden Agenten nicht in der Lage sein, mit Menschen in einer Welt zusammenzuarbeiten, in der Menschen zunehmend die Copiloten sein werden.

Dieses Problem wird besonders gefährlich, wenn KI-Autopiloten versehentlich Entscheidungen treffen, die auf bösartigen Akteuren basieren, die sich als menschliche Mitarbeiter ausgeben. Ohne eine eindeutige Möglichkeit, Menschen digital zu authentifizieren, sind Agenten anfällig für Handlungen, die im Widerspruch zu übergeordneten Unternehmenszielen wie Sicherheit, Compliance oder ethischen Erwägungen stehen.

Tipp zur Schadensbegrenzung: Regelmäßige Überprüfungen der Benutzer- und Agentenidentitäten, die an der Ausführung von KI-Autopilot-Aufgaben beteiligt sind, sind unerlässlich. Unternehmen sollten adaptive Algorithmen und Echtzeit-Feedback-Mechanismen verwenden, um sicherzustellen, dass KI-Systeme auf sich ändernde Benutzer und gesetzliche Anforderungen abgestimmt bleiben. Indem sie die Ziele bei Bedarf anpassen, können Unternehmen verhindern, dass falsch ausgerichtete Ziele zu unbeabsichtigten Konsequenzen führen.

Absicherung von KI-Autopiloten: Bewährte Praktiken

Zusätzlich zu den Sicherheitskontrollen, die in den beiden vorangegangenen Schichten erörtert wurden und die den LLM-Schutz für LLMs und die Datenkontrollen für Copiloten umfassen, erfordert die agentische Schicht die Einführung einer erweiterten Rolle für die Identitäts- und Zugriffsverwaltung (IAM) sowie die vertrauenswürdige Ausführung von Aufgaben.

Um die Risiken von KI-Autopiloten zu minimieren, sollten Unternehmen eine umfassende Sicherheitsstrategie verfolgen. Diese umfasst:

- Kontinuierliche Überwachung: Implementieren Sie Echtzeit-Verhaltensanalysen, um Anomalien und nicht autorisierte Aktionen zu erkennen.

- Ethische Führung: Richten Sie Ethikausschüsse ein und schaffen Sie einen Rahmen für die Rechenschaftspflicht, um sicherzustellen, dass KI-Systeme mit den Werten des Unternehmens und den rechtlichen Anforderungen übereinstimmen.

- Gegnerische Verteidigung: Verwenden Sie ein gegnerisches Training und eine robuste Eingabevalidierung, um Manipulationen zu verhindern.

- Menschliche Aufsicht: Pflegen Sie HITL-Systeme, um die Kontrolle über kritische Entscheidungen der KI zu behalten.

Durch die Umsetzung dieser Best Practices können Unternehmen sicherstellen, dass KI-Autopiloten sicher und im Einklang mit ihren Geschäftszielen arbeiten.

Der Weg nach vorn: Autonome KI absichern

KI-Autopiloten versprechen, die Industrie zu revolutionieren, indem sie komplexe Aufgaben automatisieren, aber sie bergen auch erhebliche Sicherheitsrisiken. Von böswilligen Aktionen bis hin zu feindlicher Manipulation müssen Unternehmen diese Risiken wachsam im Auge behalten. Da sich die KI weiter entwickelt, ist es wichtig, der Sicherheit in jeder Phase Priorität einzuräumen, um sicherzustellen, dass diese Systeme sicher und im Einklang mit den Unternehmenszielen arbeiten.

Erfahren Sie mehr über die Sicherung Ihrer KI-Anwendungen: Lesen Sie unseren Solution Brief

Andere Blogs in dieser Serie:

- Teil 1 - KI-Sicherheit: Kundenbedürfnisse und Chancen

- Teil 2 - Grundlegende KI: Eine kritische Schicht mit Sicherheitsherausforderungen

- Teil 3 - Sicherheitsrisiken und Herausforderungen mit KI-Kopiloten

- Teil 4 - Abwägung der Vorteile und Risiken von KI-Autopiloten

Verwandter Inhalt

Von den DPDPA-Anforderungen bis zur Datentransparenz: Die Notwendigkeit von DSPM

Laufende Blogs

LLM-Attribute, die jeder CISO heute im Blick behalten sollte

Sarang Warudkar 18. Februar 2026

Von den DPDPA-Anforderungen bis zur Datentransparenz: Die Notwendigkeit von DSPM

Niharika Ray und Sarang Warudkar 12. Februar 2026

Skyhigh Security 2025: Präzisere Kontrolle, klarere Transparenz und schnellere Maßnahmen für Daten, Web und Cloud

Thyaga Vasudevan 21. Januar 2026

Das versteckte Risiko von GenAI, das Ihr Unternehmen Millionen kosten könnte (und wie Sie es heute beheben können)

Jesse Grindeland 18. Dezember 2025

Skyhigh Security : 2026 ist das Jahr, in dem künstliche Intelligenz einen neuen Entwurf für die Unternehmenssicherheit vorantreibt.

Thyaga Vasudevan 12. Dezember 2025