ทรัพยากร

ความเสี่ยงด้านความปลอดภัยและความท้าทายกับ AI Copilots

โดย Sekhar Sarukkai - Cybersecurity@UC Berkeley

วันที่ 16 ตุลาคม 2567 6 อ่านนาที

ใน บล็อกก่อนหน้านี้ เราได้สำรวจความท้าทายด้านความปลอดภัยที่เกี่ยวข้องกับ Foundational AI ซึ่งเป็นเลเยอร์แรกที่สำคัญที่รองรับโมเดล AI ทั้งหมด เราได้ตรวจสอบความเสี่ยงต่างๆ เช่น การโจมตีทางวิศวกรรมที่รวดเร็ว การรั่วไหลของข้อมูล และสภาพแวดล้อมที่กำหนดค่าไม่ถูกต้อง เมื่อเทคโนโลยี AI ก้าวหน้าขึ้น การรักษาความปลอดภัยในแต่ละเลเยอร์จึงมีความสำคัญอย่างยิ่งเพื่อป้องกันช่องโหว่ใหม่ๆ ที่เกิดขึ้น

ในบล็อกนี้ เราจะเจาะลึกถึงความเสี่ยงด้านความปลอดภัยที่เกี่ยวข้องกับ Layer 2: AI Copilots ผู้ช่วยเสมือนที่ขับเคลื่อนด้วย AI เหล่านี้กำลังถูกนำไปใช้งานอย่างรวดเร็วในอุตสาหกรรมต่างๆ เพื่อทำงานอัตโนมัติในบางงาน รองรับการตัดสินใจ และเพิ่มประสิทธิภาพการทำงาน แม้ว่า AI Copilots จะมีประโยชน์อย่างมาก แต่ก็ก่อให้เกิดความท้าทายด้านความปลอดภัยใหม่ๆ ที่องค์กรต่างๆ ต้องจัดการเพื่อให้มั่นใจว่าจะใช้งานได้อย่างปลอดภัย

ความเสี่ยงด้านความปลอดภัยในระดับ AI Copilot

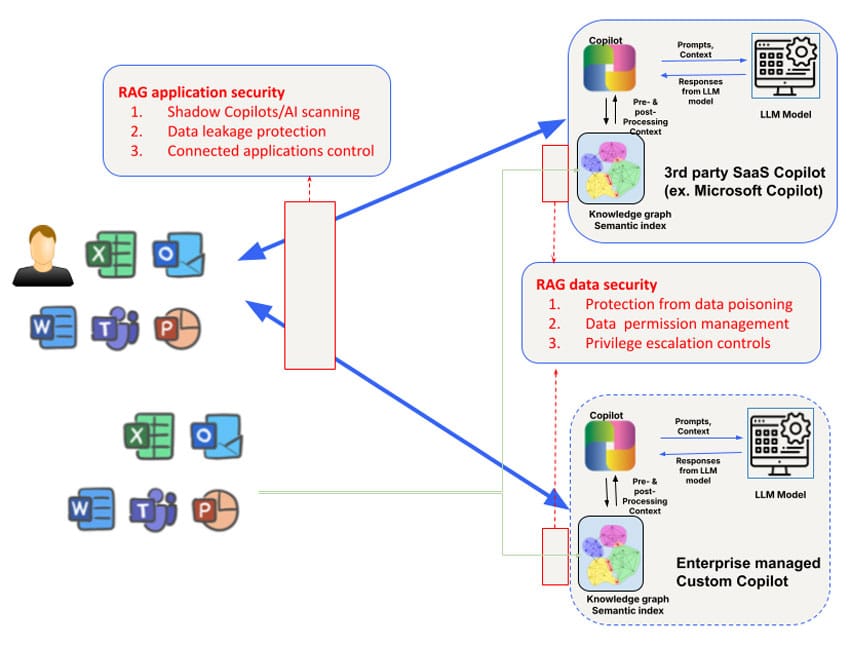

ความเสี่ยงด้านความปลอดภัยแตกต่างกันไปสำหรับ AI Copilots ของบุคคลที่สามที่พนักงานใช้ (เช่น Microsoft Copilot) และ AI Copilots แบบกำหนดเองที่พัฒนาโดยทีมธุรกิจที่เผชิญหน้ากับลูกค้าหรือคู่ค้า ตัวอย่างเช่น การเข้าถึงและการจัดการกราฟความรู้ของ AI Copilots ของบุคคลที่สามนั้นมีจำกัด เช่นเดียวกับการควบคุมข้อมูลที่ใช้ในการฝึกโมเดลเอง อย่างไรก็ตาม ข้อกังวลด้านความปลอดภัยที่ได้รับการแก้ไขในเลเยอร์ 1 จำเป็นต้องได้รับการเสริมด้วยการเน้นที่ 3 ด้าน ได้แก่ ข้อมูล บริบท และการอนุญาต เพื่อตอบสนองความต้องการด้านความปลอดภัยของ Copilot ที่กว้างขึ้น

1. การวางยาพิษข้อมูลและการจัดการโมเดล

AI Copilots พึ่งพาข้อมูลจำนวนมากเพื่อสร้างการตอบสนองและช่วยเหลือผู้ใช้ในการทำงานที่ซับซ้อน อย่างไรก็ตาม การพึ่งพาข้อมูลจำนวนมากนี้ทำให้เกิดความเสี่ยงในการโจมตีข้อมูล โดยผู้โจมตีจะบิดเบือนข้อมูลอินพุตเพื่อบิดเบือนผลลัพธ์ของโมเดล ซึ่งอาจส่งผลให้ AI Copilots ให้คำแนะนำที่ไม่ถูกต้อง ตัดสินใจผิดพลาด หรือแม้แต่ดำเนินการที่เป็นอันตรายโดยอิงจากข้อมูลที่เป็นอันตราย

ผู้กระทำความผิดอาจเปลี่ยนแปลงข้อมูลการฝึกอบรมที่ใช้ปรับแต่งโมเดลที่ขับเคลื่อน AI Copilots ซึ่งทำให้ระบบทำงานผิดปกติหรือเอื้อต่อผลลัพธ์บางอย่าง ตัวอย่างเช่น เมื่อต้นปีนี้ นักวิจัยได้สุ่มตัวอย่าง Hugging Face และค้นพบว่ามี โมเดลที่เป็นอันตรายมากกว่า 100 โมเดล ในสภาพแวดล้อมที่ใช้ AI Copilots สำหรับงานที่สำคัญ เช่น การวิเคราะห์ทางการเงินหรือการสนับสนุนลูกค้า ซึ่งอาจส่งผลกระทบในวงกว้าง ช่องโหว่นี้อาจทำให้องค์กรเผชิญกับภัยคุกคามจากภายนอก ซึ่งอาจส่งผลเสียหายทั้งทางการเงินและชื่อเสียง

เคล็ดลับการบรรเทา : เพื่อลดความเสี่ยงของการโจมตีข้อมูล องค์กรต่างๆ ควรนำกลไกการตรวจสอบข้อมูลที่เข้มงวดมาใช้ และตรวจสอบความสมบูรณ์ของข้อมูลทั้งหมดที่ใช้ในการฝึกอบรมหรืออัปเดตโมเดล AI การตรวจสอบตามกำหนดเวลาเป็นประจำและใช้เครื่องมือลำดับข้อมูลเพื่อติดตามการไหลของข้อมูลเข้าสู่ระบบ AI Copilot สามารถช่วยระบุช่องโหว่ที่อาจเกิดขึ้นได้

2. ความเสี่ยงตามบริบทและการโจมตีห่วงโซ่อุปทาน

AI Copilots มักจะใช้ประโยชน์จากข้อมูลบริบท เช่น พฤติกรรมของผู้ใช้ ข้อมูลเฉพาะของบริษัท หรือฟีดข้อมูลแบบเรียลไทม์ เพื่อปรับแต่งการตอบสนอง อย่างไรก็ตาม การพึ่งพาบริบทดังกล่าวทำให้เกิดความเสี่ยงใน การโจมตีโดยใช้บริบท ซึ่งผู้โจมตีจะดัดแปลงข้อมูลบริบทเพื่อเปลี่ยนแปลงพฤติกรรมของระบบ

ตัวอย่างเช่น ระบบ Copilot ของ Microsoft สร้างดัชนีความหมายที่หลากหลายสำหรับข้อมูลองค์กร ซึ่งรวมถึงอีเมล เอกสาร และการแชท เพื่อให้การตอบสนองที่แม่นยำและเกี่ยวข้อง อย่างไรก็ตาม บริบทนี้สามารถใช้ประโยชน์เพื่อโจมตีแบบกำหนดเป้าหมายได้ โดยการใส่ข้อมูลที่เป็นอันตรายหรือเปลี่ยนแปลงบริบทพื้นฐาน ผู้โจมตีสามารถทำให้ AI Copilot สร้างผลลัพธ์ที่เข้าใจผิด แชร์ข้อมูลที่ละเอียดอ่อนโดยไม่ได้ตั้งใจ ทำการ โจมตีแบบฟิชชิ่งแบบ เจาะจง หรือดำเนินการที่เป็นอันตรายอื่นๆ รูปแบบอื่นของการวางยาพิษในห่วงโซ่อุปทานข้อมูลในบริบทของ Microsoft Copilot สามารถดำเนินการได้โดย เพียงแค่แชร์ ไฟล์ที่เป็นอันตรายกับผู้ใช้เป้าหมาย การโจมตีนี้จะได้ผลแม้ว่าผู้ใช้จะไม่ยอมรับการแชร์และไม่รู้ด้วยซ้ำว่ามีไฟล์ที่เป็นอันตรายที่แชร์อยู่

เคล็ดลับการบรรเทาผลกระทบ : ขอแนะนำให้องค์กรต่างๆ กำหนดกฎเกณฑ์ที่ชัดเจนเกี่ยวกับวิธีการใช้และเข้าถึงข้อมูลตามบริบทโดย AI Copilots ซึ่งรวมถึงการจำกัดประเภทของข้อมูลที่สามารถรวมอยู่ในหลักสูตรฝึกอบรม AI Copilot การบังคับใช้การควบคุมการเข้าถึง และการตรวจสอบผลลัพธ์ของ AI อย่างสม่ำเสมอเพื่อดูว่ามีสัญญาณของการจัดการหรือไม่ การ ทำงานเป็นทีม (การโจมตีจำลอง) ยังช่วยระบุจุดอ่อนในระบบ AI Copilot และการประมวลผลข้อมูลตามบริบทได้อีกด้วย

3. การใช้สิทธิ์โดยมิชอบและการส่งต่อ

ความเสี่ยงหลักที่เกี่ยวข้องกับ AI Copilots คือ การใช้สิทธิ์อนุญาตอย่างไม่ถูกต้อง ระบบเหล่านี้มักต้องเข้าถึงชุดข้อมูล แอปพลิเคชัน หรือแม้แต่โครงสร้างพื้นฐานของบริษัทหลายชุดเพื่อดำเนินการงานอย่างมีประสิทธิภาพ หากไม่ได้รับการจัดการอย่างเหมาะสม AI Copilots อาจได้รับสิทธิ์อนุญาตที่มากเกินไป ซึ่งทำให้เข้าถึงข้อมูลที่ละเอียดอ่อนหรือดำเนินการที่เกินขอบเขตที่ตั้งใจไว้ได้

สิ่งนี้มีความเสี่ยงต่อการโจมตีแบบขยายขอบเขต ซึ่งผู้โจมตีจะใช้ประโยชน์จากสิทธิ์อนุญาตของ AI Copilot เพื่อเข้าถึงระบบที่ไม่ได้รับอนุญาตหรือข้อมูลที่เป็นความลับ ในบางกรณี สิทธิ์ที่กำหนดค่าไม่ถูกต้องอาจทำให้ AI Copilots สามารถดำเนินการต่างๆ เช่น เปลี่ยนแปลงการตั้งค่าบัญชี ลบไฟล์สำคัญ หรือเปิดเผยข้อมูลที่ละเอียดอ่อนต่อแอปพลิเคชันของบุคคลที่สาม

ตัวอย่างเช่น Copilot ของ GitHub ถูกระบุว่ามีความเสี่ยงเนื่องจากบูรณาการกับปลั๊กอินของบุคคลที่สามซึ่งอาจทำให้เกิดการรั่วไหลของข้อมูลได้หากปลั๊กอินเหล่านั้นไม่ได้รับการตรวจสอบอย่างเหมาะสม การศึกษาวิจัยที่ดำเนินการโดยมหาวิทยาลัยคอร์เนลล์เผยให้เห็นว่า โปรแกรมประมาณ 40% ที่สร้างโดยใช้ Copilot ของ GitHub มีช่องโหว่ ซึ่ง เน้นย้ำถึงความเสี่ยงในโลกแห่งความเป็นจริงของการให้สิทธิ์ที่มากเกินไปแก่ระบบ AI โดยไม่มีการควบคุมดูแลอย่างเข้มงวด

เคล็ดลับการบรรเทาผลกระทบ : แนวทางปฏิบัติที่ดีที่สุดในการจัดการสิทธิ์ของ AI Copilot ได้แก่ การใช้หลักการสิทธิ์ขั้นต่ำ (ให้สิทธิ์ขั้นต่ำที่จำเป็นสำหรับ AI Copilot ในการปฏิบัติงาน) และตรวจสอบบันทึกการเข้าถึงเป็นประจำ ควรใช้เครื่องมืออัตโนมัติที่ตรวจจับและทำเครื่องหมายพฤติกรรมที่ผิดปกติเพื่อบรรเทาความเสี่ยงจากการเข้าถึงโดยไม่ได้รับอนุญาตหรือการเพิ่มสิทธิ์

4. Rogue AI Copilots และ Shadow AI

เนื่องจาก AI Copilots แพร่หลายมากขึ้น องค์กรต่างๆ อาจเผชิญกับภัยคุกคามจาก AI Copilots ปลอม หรือ AI ที่เป็นเงา (แอปพลิเคชัน AI ที่ไม่ได้รับอนุญาตซึ่งถูกนำไปใช้โดยไม่ได้รับการดูแล) ระบบเงาเหล่านี้อาจทำงานนอกเหนือโปรโตคอลความปลอดภัยอย่างเป็นทางการขององค์กร ซึ่งอาจนำไปสู่ความเสี่ยงต่างๆ มากมาย เช่น การละเมิดข้อมูล การละเมิดการปฏิบัติตามข้อกำหนด และความล้มเหลวในการดำเนินงาน

พนักงานที่มีเจตนาดีซึ่งใช้โมเดล AI โอเพนซอร์สหรือผู้บุกรุกภายในที่ประสงค์ร้ายซึ่งพยายามจะหลบเลี่ยงการควบคุมของบริษัท อาจสร้าง Rogue AI Copilots ได้ ระบบที่ไม่ได้รับอนุญาตเหล่านี้มักไม่ถูกสังเกตเห็นจนกว่าจะมีการละเมิดความปลอดภัยหรือการตรวจสอบการปฏิบัติตามข้อกำหนดเผยให้เห็นการมีอยู่ของระบบเหล่านี้

การเพิ่มขึ้นของ AI ในรูปแบบเงาถูกเปรียบเทียบกับยุคแรกๆ ของ Shadow IT เมื่อพนักงานมักใช้บริการคลาวด์และแอปพลิเคชันที่ไม่ได้รับอนุญาตโดยไม่ได้รับอนุมัติจากองค์กร ในทำนองเดียวกัน Shadow AI ยังก่อให้เกิดความเสี่ยงจากช่องโหว่ที่ไม่รู้จักซึ่งแอบซ่อนอยู่ภายในโครงสร้างพื้นฐานขององค์กร โดยไม่มีมาตรการรักษาความปลอดภัยอย่างเป็นทางการเพื่อป้องกันการใช้งานในทางที่ผิด

เคล็ดลับการบรรเทาผลกระทบ : เพื่อต่อสู้กับการเพิ่มขึ้นของ AI Copilots ที่ไม่น่าเชื่อถือ องค์กรต่างๆ จำเป็นต้องดูแลการใช้งาน AI ทั้งหมดอย่างเข้มงวด การนำ กรอบการกำกับดูแล AI มาใช้จะช่วยให้มั่นใจได้ว่ามีการใช้งาน AI Copilots ที่ได้รับอนุญาตเท่านั้น ในขณะที่การตรวจสอบอย่างต่อเนื่องและเครื่องมือค้นหาอัตโนมัติสามารถตรวจจับแอปพลิเคชัน AI ที่ไม่ได้รับอนุญาตที่ทำงานภายในองค์กรได้

การรักษาความปลอดภัย AI Copilots: แนวทางปฏิบัติที่ดีที่สุด

ความเสี่ยงดังกล่าวข้างต้นสามารถจัดการได้ตามกรณีการใช้งาน สำหรับการใช้ AI Copilots จากภายนอก (เช่น Microsoft Copilot หรือ Github Copilot) ข้อกำหนดแรกคือต้องทำความเข้าใจเกี่ยวกับการใช้ AI Copilot/AI ในเงาผ่านการค้นพบ การลงทะเบียนคุณลักษณะความเสี่ยงของ AI ที่ขยายของ Skyhigh ถือเป็นวิธีที่สะดวกในการค้นหา AI Copilots จากภายนอกที่องค์กรต่างๆ ใช้ การป้องกันข้อมูลในเลเยอร์นี้จะได้รับการจัดการที่ดีที่สุดด้วยการใช้การรักษาความปลอดภัยข้อมูลแบบใช้เครือข่ายและแบบใช้ API ร่วมกัน การควบคุมแบบอินไลน์สามารถใช้ได้ทั้งผ่านพร็อกซีส่งต่อ Secure Service Edge (SSE) (เช่น สำหรับการอัปโหลดไฟล์ไปยัง AI Copilots) และพร็อกซีแบบย้อนกลับของแอปพลิเคชัน/LLM สำหรับ AI Copilots/แชทบ็อตที่สร้างขึ้นเอง หรือการควบคุมที่ใช้เบราว์เซอร์สำหรับการโต้ตอบของแอปพลิเคชันที่ใช้ WebSockets

ความเสี่ยงอีกประการหนึ่งเกิดขึ้นกับแอปพลิเคชันอื่นที่สามารถเชื่อมต่อกับ AI Copilots ได้ ตัวอย่างเช่น Microsoft Copilots สามารถกำหนดค่าให้เชื่อมต่อกับ Salesforce ได้แบบสองทิศทาง ความสามารถในการสอบถามการกำหนดค่า Microsoft Copilot เพื่อให้มองเห็นแอปพลิเคชันที่เชื่อมต่อดังกล่าวได้นั้นถือเป็นสิ่งสำคัญในการปิดกั้นช่องโหว่ด้านความปลอดภัยนี้

นอกเหนือจากการควบคุมระดับแอปพลิเคชัน AI Copilot แล้ว ยังต้องพิจารณาเป็นพิเศษถึงกราฟความรู้และดัชนีการเรียกค้นแบบเพิ่มกำลัง (RAG) ที่ใช้โดย AI Copilots ด้วย AI Copilots ของบุคคลที่สามนั้นไม่โปร่งใสในเรื่องนี้ ดังนั้น องค์กรต่างๆ จะต้องพึ่งพาการสนับสนุน API โดย AI Copilots เพื่อตรวจสอบและกำหนดนโยบายของคลังเวกเตอร์/กราฟที่ใช้ โดยเฉพาะอย่างยิ่ง ปัญหาที่ท้าทายในการแก้ไขในเลเยอร์นี้เกี่ยวข้องกับการจัดการสิทธิ์ในระดับข้อมูล รวมถึงการเพิ่มสิทธิ์ที่อาจเกิดขึ้นโดยไม่ได้ตั้งใจสำหรับเนื้อหาที่สร้างโดย AI Copilots AI Copilots หลายตัวยังไม่มีการสนับสนุน API ที่แข็งแกร่งสำหรับการควบคุมแบบอินไลน์/เรียลไทม์ ซึ่งทำให้ความท้าทายนี้ทวีความรุนแรงยิ่งขึ้น ในที่สุด API สามารถใช้เพื่อการป้องกันแบบเกือบเรียลไทม์และการสแกนฐานความรู้ตามต้องการสำหรับการควบคุมข้อมูล รวมถึงการสแกนหาการโจมตีด้วยการวางยาพิษข้อมูล

เพื่อป้องกันความเสี่ยงด้านความปลอดภัยที่เกี่ยวข้องกับ AI Copilots องค์กรต่างๆ ควรใช้แนวทางหลายชั้นในการรักษาความปลอดภัย มาตรการสำคัญ ได้แก่:

- ดำเนินการตรวจสอบตามปกติ : ตรวจสอบการปรับใช้ AI Copilot อย่างสม่ำเสมอเพื่อค้นหาช่องโหว่ด้านข้อมูลที่เป็นอันตราย ความเสี่ยงในการจัดการบริบท และการกำหนดค่าการอนุญาตที่ไม่ถูกต้อง

- นำการควบคุมการอนุญาตไปใช้งาน : ใช้โมเดลการเข้าถึงสิทธิ์น้อยที่สุดเพื่อให้แน่ใจว่า AI Copilots จะเข้าถึงเฉพาะข้อมูลและระบบที่ต้องการเท่านั้น

- ปรับใช้เครื่องมือตรวจสอบอัตโนมัติ : นำเครื่องมืออัตโนมัติมาใช้งานเพื่อตรวจสอบพฤติกรรม AI Copilot และตรวจจับความผิดปกติ เช่น การเข้าถึงที่ไม่ได้รับอนุญาตหรือการโต้ตอบข้อมูลที่น่าสงสัย

- ควบคุมการใช้งาน AI : กำหนดกรอบการกำกับดูแลที่ชัดเจนเพื่อดูแลการปรับใช้ AI ป้องกัน AI Copilots ที่ไม่น่าเชื่อถือ และให้เป็นไปตามกฎระเบียบด้านความปลอดภัยและความเป็นส่วนตัว

โดยการนำแนวทางปฏิบัติที่ดีที่สุดเหล่านี้มาใช้ องค์กรต่างๆ จะสามารถเพิ่มประโยชน์ของ AI Copilots ได้สูงสุดพร้อมทั้งลดความเสี่ยงด้านความปลอดภัยให้เหลือน้อยที่สุด

เส้นทางข้างหน้า: การรักษาความปลอดภัยชั้น AI

AI Copilots นำเสนอศักยภาพที่สำคัญในการเพิ่มผลผลิตและปรับปรุงผลลัพธ์ทางธุรกิจ แต่ยังนำมาซึ่งความเสี่ยงด้านความปลอดภัยรูปแบบใหม่ด้วย ตั้งแต่การโจมตีข้อมูลไปจนถึง AI Copilots ที่เป็นอันตราย องค์กรต่างๆ ต้องดำเนินขั้นตอนเชิงรุกเพื่อรักษาความปลอดภัยให้กับเทคโนโลยี AI ที่สำคัญนี้ เมื่อเราเปลี่ยนไปสู่ระดับ AI ขั้นสูงขึ้น ความต้องการมาตรการรักษาความปลอดภัยที่แข็งแกร่งก็ยิ่งเพิ่มมากขึ้น

โปรดติดตามบล็อกถัดไปในซีรีส์ของเรา ซึ่งเราจะมาสำรวจเลเยอร์ 3 และความท้าทายด้านความปลอดภัยที่มาพร้อมกับระบบ AI อัตโนมัติอื่นๆ หากต้องการเรียนรู้เพิ่มเติมเกี่ยวกับการรักษาความปลอดภัยแอปพลิเคชัน AI ของคุณ โปรดดูโซลูชัน AI ของ Skyhigh

บล็อกอื่นๆ ในซีรี่ส์นี้:

- ส่วนที่ 1 – ความปลอดภัยของ AI: ความต้องการและโอกาสของลูกค้า

- ส่วนที่ 2 – AI พื้นฐาน: ชั้นสำคัญที่มีความท้าทายด้านความปลอดภัย

- ส่วนที่ 3 – ความเสี่ยงด้านความปลอดภัยและความท้าทายกับ AI Copilots

เนื้อหาที่เกี่ยวข้อง

บล็อกที่กำลังได้รับความนิยม

คุณลักษณะของ LLM ที่ CISO ทุกคนควรติดตามในปัจจุบัน

สารัง วารุดการ์ 18 กุมภาพันธ์ 2569

จากข้อกำหนดของ DPDPA สู่การมองเห็นข้อมูล: ความจำเป็นของ DSPM

นิฮาริกา เรย์ และซารัง วารัดการ์ วันที่ 12 กุมภาพันธ์ พ.ศ. 2569

Skyhigh Security ไตรมาสที่ 4 ปี 2025: ควบคุมได้ดียิ่งขึ้น มองเห็นภาพรวมได้ชัดเจนขึ้น และดำเนินการได้รวดเร็วขึ้นในด้านข้อมูล เว็บ และคลาวด์

ไทอากา วาสุเดวัน 21 มกราคม 2569

ความเสี่ยงที่ซ่อนอยู่ของ GenAI ที่อาจทำให้บริษัทของคุณสูญเสียเงินหลายล้าน (และวิธีแก้ไขในวันนี้)

เจสซี กรินเดแลนด์ 18 ธันวาคม 2025

Skyhigh Security การคาดการณ์: ปี 2026 คือปีที่ AI จะบังคับให้เกิดพิมพ์เขียวใหม่สำหรับความปลอดภัยขององค์กร

ไทอากา วาสุเดวัน วันที่ 12 ธันวาคม พ.ศ. 2568