Por Sekhar Sarukkai - Ciberseguridad@UC Berkeley

16 de octubre de 2024 6 Minuto de lectura

En el blog anterior, exploramos los retos de seguridad vinculados a la IA fundacional, la primera capa crítica que sustenta todos los modelos de IA. Examinamos riesgos como los ataques de ingeniería puntual, la fuga de datos y los entornos mal configurados. A medida que avanza la tecnología de la IA, es crucial asegurar cada capa para prevenir las vulnerabilidades emergentes.

En este blog, nos sumergiremos en los riesgos de seguridad asociados a la capa 2: los copilotos de IA. Estos asistentes virtuales impulsados por la IA se están desplegando rápidamente en todas las industrias para automatizar ciertas tareas, apoyar la toma de decisiones y mejorar la productividad. Aunque los copilotos de IA ofrecen poderosos beneficios, también introducen nuevos retos de seguridad que las organizaciones deben abordar para garantizar un uso seguro y protegido.

Riesgos de seguridad en la capa de copiloto de la IA

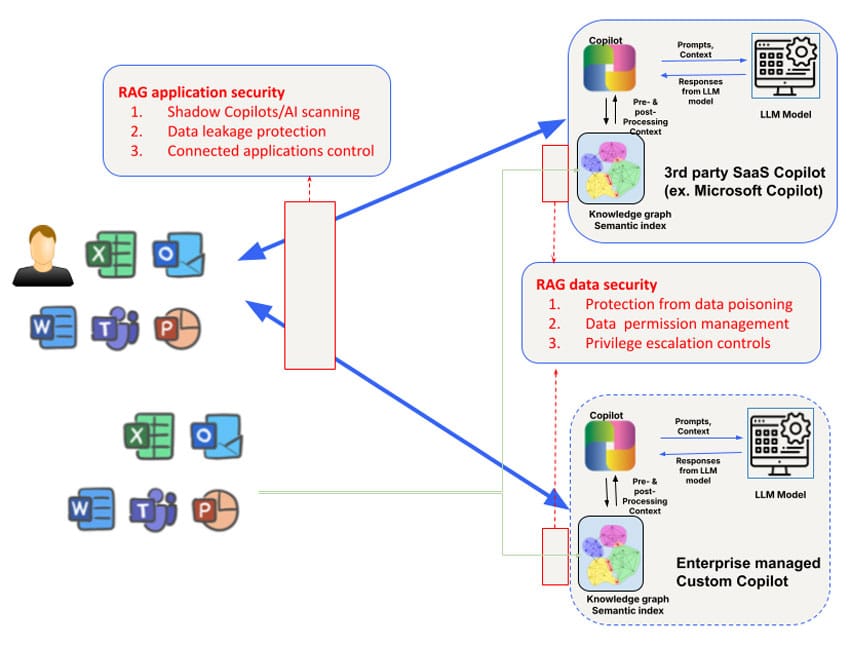

Los riesgos de seguridad difieren para los AI Copilots de terceros utilizados por los empleados (como Microsoft Copilot) y los AI Copilots personalizados desarrollados por los equipos empresariales que están orientados al cliente o al socio. Por ejemplo, el acceso y la manipulación del grafo de conocimientos de los Copilots de IA de terceros es limitado, al igual que el control de los datos que se utilizan para entrenar el propio modelo. No obstante, las preocupaciones de seguridad abordadas en la Capa 1 deben aumentarse con un enfoque en tres áreas: datos, contexto y permisos para abordar las necesidades de seguridad más amplias de los Copilots.

1. Envenenamiento de datos y manipulación de modelos

Los copilotos de IA dependen de grandes volúmenes de datos para generar respuestas y ayudar a los usuarios con tareas complejas. Sin embargo, esta gran dependencia de los datos introduce el riesgo del envenenamiento de datos, en el que los atacantes manipulan los datos de entrada para distorsionar los resultados del modelo. Esto puede dar lugar a que los copilotos de IA proporcionen sugerencias incorrectas, tomen decisiones erróneas o incluso ejecuten acciones perjudiciales basadas en los datos envenenados.

Un actor malintencionado podría alterar los datos de entrenamiento utilizados para afinar los modelos que alimentan los Copilotos AI, haciendo que el sistema se comporte de forma impredecible o favorezca ciertos resultados. Por ejemplo, a principios de este año, los investigadores tomaron muestras de Hugging Face y descubrieron que más de 100 modelos eran maliciosos. En entornos en los que los Copilotos de IA se utilizan para tareas críticas -como el análisis financiero o la atención al cliente- esto puede tener consecuencias de gran alcance. Esta vulnerabilidad podría exponer potencialmente a una organización a amenazas externas, provocando daños tanto financieros como de reputación.

Consejo de mitigación: Para reducir el riesgo de envenenamiento de datos, las organizaciones deben aplicar mecanismos estrictos de validación de datos y supervisar la integridad de todos los datos utilizados para entrenar o actualizar los modelos de IA. Las auditorías programadas con regularidad y el empleo de herramientas de linaje de datos para rastrear el flujo de datos hacia los sistemas AI Copilot pueden ayudar a identificar posibles vulnerabilidades.

2. Riesgos contextuales y ataques a la cadena de suministro

Los copilotos de IA suelen aprovechar los datos contextuales, como el comportamiento de los usuarios, información específica de la empresa o fuentes de datos en tiempo real, para adaptar sus respuestas. Sin embargo, esta dependencia del contexto introduce el riesgo del envenenamiento del contexto, en el que los atacantes manipulan los datos contextuales para alterar el comportamiento del sistema.

Por ejemplo, el sistema Copilot de Microsoft crea ricos índices semánticos de datos empresariales -incluidos correos electrónicos, documentos y chats- para ofrecer respuestas precisas y pertinentes. Sin embargo, este contexto puede ser explotado para ataques dirigidos. Al inyectar datos maliciosos o alterar el contexto subyacente, los atacantes podrían hacer que el Copiloto de IA generara resultados engañosos, compartiera inadvertidamente información sensible, realizara ataques de phishing selectivo o llevara a cabo otras acciones perjudiciales. Otra forma de envenenamiento de la cadena de suministro de datos en el contexto del Copiloto de Microsoft puede llevarse a cabo simplemente compartiendo un archivo malicioso con el usuario objetivo. Este ataque funcionará incluso si el usuario no acepta compartirlo y ni siquiera es consciente de este archivo malicioso compartido.

Consejo de mitigación: Se aconseja a las organizaciones que establezcan normas claras sobre el modo en que los copilotos de IA utilizan los datos contextuales y acceden a ellos. Esto incluye limitar los tipos de datos que pueden incluirse en el entrenamiento del Copiloto de IA, aplicar controles de acceso y auditar regularmente los resultados de la IA para detectar signos de manipulación. El "red teaming" (ataques simulados) también puede ayudar a identificar los puntos débiles de los sistemas de los copilotos de IA y su procesamiento de datos contextuales.

3. Uso indebido de permisos y escalada

Un riesgo importante asociado a los copilotos de IA es el uso indebido de los permisos. Estos sistemas suelen requerir el acceso a múltiples conjuntos de datos, aplicaciones o incluso a la infraestructura de la empresa para realizar tareas de forma eficiente. Si no se gestionan adecuadamente, los copilotos de IA podrían recibir permisos excesivos, lo que les permitiría acceder a datos sensibles o realizar acciones más allá de su alcance previsto.

Esto supone un riesgo de ataques de escalada, en los que los atacantes se aprovechan de los permisos del Copiloto IA para acceder a sistemas no autorizados o a información confidencial. En algunos casos, los permisos mal configurados pueden permitir a los Copilotos AI realizar acciones como cambiar la configuración de la cuenta, borrar archivos importantes o exponer datos confidenciales a aplicaciones de terceros.

Por ejemplo, Copilot de GitHub ha sido identificado como un riesgo debido a su integración con plugins de terceros que podrían dar lugar a fugas de datos si dichos plugins no se investigan adecuadamente. Un estudio realizado por la Universidad de Cornell reveló que aproximadamente el 40% de los programas generados mediante el Copilot de GitHub contenían vulnerabilidades, lo que pone de relieve los riesgos en el mundo real de conceder a los sistemas de IA permisos excesivos sin una supervisión estricta.

Consejo de mitigación: Las mejores prácticas para gestionar los permisos de los copilotos de IA incluyen la aplicación del principio del menor privilegio (conceder sólo los permisos mínimos necesarios para que los copilotos de IA realicen sus tareas) y la revisión periódica de los registros de acceso. También deberían emplearse herramientas automatizadas que detecten y señalen comportamientos anómalos para mitigar los riesgos derivados de accesos no autorizados o escalada de privilegios.

4. Rogue AI Copilotos y Shadow AI

A medida que proliferan los Copilotos de IA, las organizaciones pueden enfrentarse a la amenaza de Copilotos de IA deshonestos o IA en la sombra (aplicaciones de IA no autorizadas desplegadas sin supervisión). Estos sistemas en la sombra pueden operar al margen de los protocolos de seguridad formales de la organización, lo que conlleva riesgos significativos, como violaciones de datos, infracciones de la normativa y fallos operativos.

Los copilotos de IA deshonestos pueden ser creados por empleados bienintencionados que utilizan modelos de IA de código abierto o por personas malintencionadas con información privilegiada que tratan de eludir los controles de la empresa. Estos sistemas no autorizados suelen pasar desapercibidos hasta que una brecha de seguridad o una auditoría de cumplimiento revelan su existencia.

El auge de la IA en la sombra se ha comparado con los primeros días de la TI en la sombra, cuando los servicios y aplicaciones en la nube no sancionados eran utilizados habitualmente por los empleados sin la aprobación de la empresa. Del mismo modo, la IA en la sombra introduce el riesgo de vulnerabilidades desconocidas que acechan dentro de la infraestructura de una organización, sin medidas de seguridad formales para proteger contra el uso indebido.

Consejo de mitigación: Para combatir el auge de los Copilotos de IA deshonestos, las organizaciones deben mantener una supervisión estricta de todos los despliegues de IA. La implantación de marcos de gobernanza de la IA puede ayudar a garantizar que solo se desplieguen los Copilotos de IA autorizados, mientras que la supervisión continua y las herramientas de detección automatizada pueden detectar aplicaciones de IA no autorizadas que se ejecuten dentro de la organización.

Asegurar los copilotos de IA: Buenas prácticas

Los riesgos anteriores pueden abordarse en función de los casos de uso. Para el uso de Copilotos de IA externos de terceros (como Microsoft Copilot o Github Copilot), el primer requisito es obtener una comprensión del uso del Copiloto de IA/AI en la sombra a través del descubrimiento. El registro ampliado de atributos de riesgo de IA de Skyhigh puede ser una forma práctica de descubrir los Copilotos de IA de terceros utilizados por las empresas. La protección de datos en esta capa se aborda mejor con una combinación de seguridad de datos basada en la red y basada en la API. Los controles en línea pueden aplicarse a través de proxies de reenvío Secure Service Edge (SSE) (por ejemplo, para la carga de archivos a los AI Copilots) y proxies inversos de aplicación/LLM para los AI Copilots/chatbots de creación propia, o controles basados en el navegador para las interacciones de aplicaciones que utilizan WebSockets.

Otro riesgo se centra en otras aplicaciones que pueden conectarse a AI Copilots. Por ejemplo, los Copilotos Microsoft pueden configurarse para conectarse a Salesforce bidireccionalmente. La capacidad de consultar las configuraciones de los Microsoft Copilots para obtener visibilidad sobre dichas aplicaciones conectadas será esencial para bloquear este vector de fuga.

Además de los controles a nivel de aplicación del Copiloto IA, también hay que prestar especial atención al gráfico de conocimientos de generación aumentada de recuperación (RAG) y a los índices que utilizan los Copilotos IA. Los Copilotos IA de terceros son opacos a este respecto. Por lo tanto, las organizaciones dependerán del soporte de API por parte de los AI Copilots para introspeccionar y establecer políticas de los almacenes de vectores/gráficos utilizados. En particular, un problema difícil de abordar en esta capa se centra en la gestión de permisos a nivel de datos, así como en las escaladas de privilegios que pueden surgir inadvertidamente para el contenido creado por el Copiloto de IA. Muchos copilotos de IA aún no disponen de un sólido soporte de API para el control en línea/en tiempo real, lo que agrava aún más el reto. Por último, las API pueden utilizarse para la protección casi en tiempo real y el escaneado a petición de la base de conocimientos para el control de los datos, así como el escaneado en busca de ataques de envenenamiento de datos.

Para protegerse contra los riesgos de seguridad asociados a los copilotos de IA, las organizaciones deben adoptar un enfoque de seguridad de varios niveles. Las medidas clave incluyen:

- Realice auditorías periódicas: Revise regularmente los despliegues de AI Copilot para detectar vulnerabilidades de envenenamiento de datos, riesgos de manipulación de contextos y configuraciones erróneas de permisos.

- Implemente controles de permisos: Utilice modelos de acceso de mínimo privilegio para garantizar que los copilotos de IA sólo tengan acceso a los datos y sistemas que necesiten.

- Implemente herramientas de supervisión automatizadas: Implemente herramientas automatizadas para supervisar el comportamiento del Copiloto AI y detectar anomalías, como accesos no autorizados o interacciones de datos sospechosas.

- Gobernar el uso de la IA: Establezca marcos de gobernanza claros para supervisar los despliegues de IA, evitar los copilotos de IA deshonestos y garantizar el cumplimiento de las normativas de seguridad y privacidad.

Adoptando estas mejores prácticas, las organizaciones pueden maximizar los beneficios de los copilotos de IA al tiempo que minimizan los riesgos de seguridad.

El camino a seguir: Asegurar las capas de IA

Los copilotos de IA ofrecen un potencial significativo para impulsar la productividad y mejorar los resultados empresariales, pero también ponen sobre la mesa nuevos riesgos de seguridad. Desde el envenenamiento de datos hasta los Copilotos de IA deshonestos, las organizaciones deben tomar medidas proactivas para asegurar esta capa crítica de la tecnología de IA. A medida que avanzamos hacia capas más avanzadas de la IA, la necesidad de medidas de seguridad sólidas no hace más que crecer.

Permanezca atento al próximo blog de nuestra serie, en el que exploraremos la Capa 3 y los retos de seguridad que plantean otros sistemas autónomos de IA. Para saber más sobre cómo proteger sus aplicaciones de IA, explore las soluciones de IA de Skyhigh.

Otros blogs de esta serie:

Volver a Blogs