Par Sekhar Sarukkai - Cybersecurity@UC Berkeley

16 octobre 2024 6 Lecture minute

Dans le blog précédent, nous avons exploré les défis de sécurité liés à l'IA fondamentale, la première couche critique qui supporte tous les modèles d'IA. Nous avons examiné des risques tels que les attaques d'ingénierie rapide, les fuites de données et les environnements mal configurés. À mesure que la technologie de l'IA progresse, il est essentiel de sécuriser chaque couche afin de prévenir les vulnérabilités émergentes.

Dans ce blog, nous allons nous pencher sur les risques de sécurité associés à la couche 2 : les copilotes d'IA. Ces assistants virtuels pilotés par l'IA sont rapidement déployés dans tous les secteurs d'activité pour automatiser certaines tâches, faciliter la prise de décision et améliorer la productivité. Si les copilotes d'IA offrent des avantages considérables, ils posent également de nouveaux défis en matière de sécurité que les organisations doivent relever pour garantir une utilisation sûre et sécurisée.

Risques de sécurité au niveau du copilote d'IA

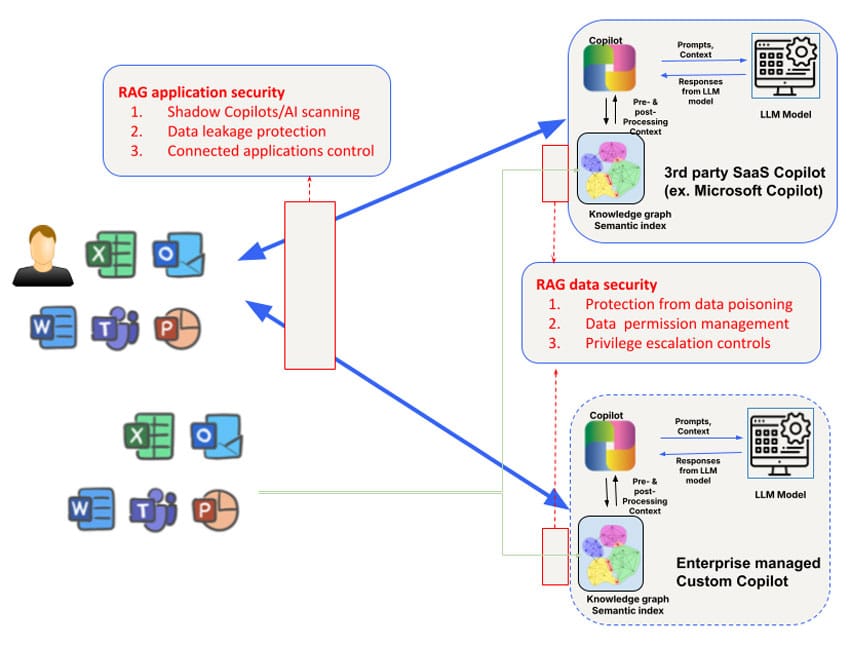

Les risques de sécurité diffèrent selon qu'il s'agit de copilotes d'IA tiers utilisés par des employés (tels que Microsoft Copilot) ou de copilotes d'IA personnalisés développés par des équipes commerciales qui sont en contact avec des clients ou des partenaires. Par exemple, l'accès et la manipulation du graphe de connaissances des copilotes d'IA tiers sont limités, tout comme le contrôle des données utilisées pour former le modèle lui-même. Néanmoins, les questions de sécurité abordées au niveau 1 doivent être complétées par une attention particulière à trois domaines : les données, le contexte et les autorisations, afin de répondre aux besoins plus larges en matière de sécurité des copilotes.

1. Empoisonnement des données et manipulation des modèles

Les copilotes d'IA s'appuient sur de grands volumes de données pour générer des réponses et aider les utilisateurs dans des tâches complexes. Cependant, cette forte dépendance aux données introduit le risque d'empoisonnement des données, où les attaquants manipulent les données d'entrée pour fausser les résultats du modèle. Les copilotes d'IA peuvent alors fournir des suggestions incorrectes, prendre des décisions erronées, voire exécuter des actions nuisibles sur la base des données empoisonnées.

Un acteur malveillant pourrait modifier les données d'entraînement utilisées pour affiner les modèles qui alimentent les copilotes d'IA, amenant le système à se comporter de manière imprévisible ou à favoriser certains résultats. Par exemple, au début de cette année, des chercheurs ont échantillonné Hugging Face et ont découvert que plus de 100 modèles étaient malveillants. Dans les environnements où les copilotes d'IA sont utilisés pour des tâches critiques, telles que l'analyse financière ou l'assistance à la clientèle, cela peut avoir des conséquences considérables. Cette vulnérabilité peut potentiellement exposer une organisation à des menaces externes, entraînant des dommages financiers et des atteintes à la réputation.

Conseil d'atténuation: Pour réduire le risque d'empoisonnement des données, les organisations doivent mettre en œuvre des mécanismes stricts de validation des données et contrôler l'intégrité de toutes les données utilisées pour former ou mettre à jour les modèles d'IA. Des audits réguliers et l'utilisation d'outils de lignage des données pour suivre le flux de données dans les systèmes d'IA Copilot peuvent aider à identifier les vulnérabilités potentielles.

2. Risques contextuels et attaques contre la chaîne d'approvisionnement

Les copilotes d'IA exploitent souvent des données contextuelles, telles que le comportement de l'utilisateur, des informations spécifiques sur l'entreprise ou des flux de données en temps réel, afin d'adapter leurs réponses. Cependant, cette dépendance au contexte introduit le risque d'empoisonnement du contexte, où les attaquants manipulent les données contextuelles pour modifier le comportement du système.

Par exemple, le système Copilot de Microsoft crée des indices sémantiques riches pour les données d'entreprise, y compris les courriels, les documents et les chats, afin de fournir des réponses précises et pertinentes. Cependant, ce contexte peut être exploité pour des attaques ciblées. En injectant des données malveillantes ou en modifiant le contexte sous-jacent, les attaquants pourraient amener l'IA Copilot à générer des résultats trompeurs, à partager par inadvertance des informations sensibles, à mener des attaques de spear phishing ou à prendre d'autres mesures préjudiciables. Une autre forme d'empoisonnement de la chaîne d'approvisionnement des données dans le contexte de Microsoft Copilot peut être réalisée en partageant simplement un fichier malveillant avec l'utilisateur cible. Cette attaque fonctionnera même si l'utilisateur n'accepte pas le partage et n'est même pas au courant de l'existence de ce fichier malveillant partagé.

Conseil d'atténuation: Il est conseillé aux organisations d'établir des règles claires sur la manière dont les données contextuelles sont utilisées et consultées par les copilotes d'IA. Il s'agit notamment de limiter les types de données qui peuvent être incluses dans la formation des copilotes d'IA, d'appliquer des contrôles d'accès et d'auditer régulièrement les résultats de l'IA pour y déceler des signes de manipulation. L'équipe rouge (attaques simulées) peut également aider à identifier les faiblesses des systèmes de copilote IA et de leur traitement des données contextuelles.

3. Utilisation abusive des autorisations et de l'escalade

L'un des principaux risques associés aux copilotes IA est l'utilisation abusive des autorisations. Ces systèmes ont souvent besoin d'accéder à de multiples ensembles de données, applications ou même à l'infrastructure de l'entreprise pour effectuer des tâches de manière efficace. S'ils ne sont pas correctement gérés, les copilotes IA pourraient se voir accorder des autorisations excessives, ce qui leur permettrait d'accéder à des données sensibles ou d'effectuer des actions dépassant le cadre prévu.

Cela présente un risque d'attaques par escalade, où les attaquants exploitent les autorisations du copilote intelligent pour accéder à des systèmes non autorisés ou à des informations confidentielles. Dans certains cas, des autorisations mal configurées peuvent permettre aux copilotes IA d'effectuer des actions telles que la modification des paramètres du compte, la suppression de fichiers importants ou l'exposition de données sensibles à des applications tierces.

Par exemple, Copilot de GitHub a été identifié comme un risque en raison de son intégration avec des plugins tiers qui pourraient conduire à des fuites de données si ces plugins ne sont pas correctement contrôlés. Une étude menée par l'université Cornell a révélé qu'environ 40 % des programmes générés à l'aide de Copilot de GitHub contenaient des vulnérabilités, ce qui met en évidence les risques réels liés à l'octroi de permissions excessives aux systèmes d'IA sans surveillance stricte.

Conseil d'atténuation: les meilleures pratiques de gestion des autorisations des copilotes IA comprennent l'application du principe du moindre privilège (accorder uniquement les autorisations minimales nécessaires aux copilotes IA pour effectuer leurs tâches) et l'examen régulier des journaux d'accès. Des outils automatisés qui détectent et signalent les comportements anormaux devraient également être utilisés pour atténuer les risques d'accès non autorisé ou d'escalade des privilèges.

4. Copilotes de l'IA scélérate et IA fantôme

Avec la prolifération des copilotes d'IA, les organisations peuvent être confrontées à la menace de copilotes d'IA malhonnêtes ou d'IA fantôme (applications d'IA non autorisées déployées sans surveillance). Ces systèmes fantômes peuvent fonctionner en dehors des protocoles de sécurité officiels de l'organisation, ce qui entraîne des risques importants, notamment des violations de données, des violations de la conformité et des défaillances opérationnelles.

Les copilotes d'IA malveillants peuvent être créés par des employés bien intentionnés utilisant des modèles d'IA en libre accès ou par des initiés malveillants cherchant à contourner les contrôles de l'entreprise. Ces systèmes non autorisés passent souvent inaperçus jusqu'à ce qu'une faille de sécurité ou un audit de conformité révèle leur existence.

L'essor de l'IA fantôme a été comparé aux premiers jours de l'informatique fantôme, lorsque des services et des applications en nuage non approuvés étaient couramment utilisés par les employés sans l'accord de l'entreprise. De la même manière, l'IA fantôme introduit le risque de vulnérabilités inconnues tapies dans l'infrastructure d'une organisation, sans aucune mesure de sécurité formelle pour se protéger contre les abus.

Conseil d'atténuation: Pour lutter contre la montée des copilotes d'IA malhonnêtes, les organisations doivent maintenir une surveillance stricte de tous les déploiements d'IA. La mise en œuvre de cadres de gouvernance de l'IA peut aider à garantir que seuls les copilotes d'IA autorisés sont déployés, tandis que la surveillance continue et les outils de découverte automatisés peuvent détecter les applications d'IA non autorisées fonctionnant au sein de l'organisation.

Sécuriser les copilotes IA : Bonnes pratiques

Les risques susmentionnés peuvent être traités en fonction des cas d'utilisation. Pour l'utilisation de copilotes d'IA tiers externes (tels que Microsoft Copilot ou Github Copilot), la première exigence est de comprendre l'utilisation du copilote d'IA/de l'IA de l'ombre par la découverte. Le registre étendu des attributs de risque de l'IA de Skyhigh peut être un moyen pratique de découvrir les copilotes d'IA tiers utilisés par les entreprises. La protection des données à ce niveau est mieux assurée par une combinaison de sécurité des données basée sur le réseau et sur l'API. Les contrôles en ligne peuvent être appliqués via des proxies avant Secure Service Edge (SSE) (par exemple, pour le téléchargement de fichiers vers les copilotes d'IA) et des proxies arrière application/LLM pour les copilotes d'IA/chatbots maison, ou des contrôles basés sur le navigateur pour les interactions d'application qui utilisent des WebSockets.

Un autre risque concerne les autres applications qui peuvent se connecter à AI Copilots. Par exemple, les copilotes Microsoft peuvent être configurés pour se connecter à Salesforce de manière bidirectionnelle. La possibilité d'interroger les configurations de Microsoft Copilot pour obtenir une visibilité sur ces applications connectées sera essentielle pour bloquer ce vecteur de fuite.

Outre les contrôles au niveau de l'application du copilote IA, il convient d'accorder une attention particulière au graphe de connaissances RAG (retrieval augmented generation) et aux indices utilisés par les copilotes IA. Les copilotes d'IA tiers sont opaques à cet égard. Les organisations dépendront donc de la prise en charge de l'API par les copilotes d'IA pour analyser et définir les politiques des entrepôts de vecteurs/graphes utilisés. En particulier, un problème difficile à résoudre à ce niveau concerne la gestion des autorisations au niveau des données ainsi que les escalades de privilèges qui peuvent survenir par inadvertance pour le contenu créé par le copilote d'IA. De nombreux copilotes d'IA ne disposent pas encore d'un support API robuste pour le contrôle en ligne/en temps réel, ce qui complique encore le problème. Enfin, les API peuvent être utilisées pour la protection en temps quasi réel et l'analyse à la demande de la base de connaissances pour les contrôles de données, ainsi que pour l'analyse des attaques par empoisonnement des données.

Pour se protéger contre les risques de sécurité associés aux copilotes IA, les organisations doivent adopter une approche multicouche de la sécurité. Les principales mesures sont les suivantes :

- Effectuez des audits réguliers: Examinez régulièrement les déploiements d'AI Copilot pour détecter les vulnérabilités liées à l'empoisonnement des données, les risques de manipulation du contexte et les mauvaises configurations des autorisations.

- Mettez en place des contrôles d'autorisation: Utilisez des modèles d'accès à moindre privilège pour vous assurer que les copilotes IA n'ont accès qu'aux données et aux systèmes dont ils ont besoin.

- Déployez des outils de surveillance automatisés: Mettez en œuvre des outils automatisés pour surveiller le comportement du copilote d'IA et détecter les anomalies, telles qu'un accès non autorisé ou des interactions de données suspectes.

- Gouverner l'utilisation de l'IA: Établissez des cadres de gouvernance clairs pour superviser les déploiements d'IA, empêcher les copilotes d'IA malhonnêtes et assurer la conformité avec les réglementations en matière de sécurité et de protection de la vie privée.

En adoptant ces bonnes pratiques, les organisations peuvent maximiser les avantages des copilotes IA tout en minimisant les risques de sécurité.

La voie à suivre : Sécuriser les couches d'IA

Les copilotes d'IA offrent un potentiel important pour stimuler la productivité et améliorer les résultats de l'entreprise, mais ils apportent également de nouveaux risques de sécurité. De l'empoisonnement des données aux copilotes d'IA malveillants, les organisations doivent prendre des mesures proactives pour sécuriser cette couche critique de la technologie d'IA. À mesure que nous évoluons vers des couches d'IA plus avancées, le besoin de mesures de sécurité robustes ne fait que croître.

Restez à l'écoute pour le prochain blog de notre série, dans lequel nous explorerons la couche 3 et les défis de sécurité qui viennent avec d'autres systèmes d'IA autonomes. Pour en savoir plus sur la sécurisation de vos applications d'IA, découvrez les solutions Skyhigh AI.

Autres blogs dans cette série :

Retour à Blogs