Von Sekhar Sarukkai - Cybersecurity@UC Berkeley

Oktober 16, 2024 6 Minute gelesen

Im letzten Blog haben wir uns mit den Sicherheitsherausforderungen im Zusammenhang mit der grundlegenden KI befasst, der entscheidenden ersten Schicht, die alle KI-Modelle unterstützt. Wir haben Risiken wie Prompt-Engineering-Angriffe, Datenverluste und falsch konfigurierte Umgebungen untersucht. Da die KI-Technologie immer weiter fortschreitet, ist es wichtig, jede Ebene zu sichern, um neue Schwachstellen zu vermeiden.

In diesem Blog befassen wir uns mit den Sicherheitsrisiken im Zusammenhang mit Schicht 2: KI-Copiloten. Diese KI-gesteuerten virtuellen Assistenten werden in vielen Branchen eingesetzt, um bestimmte Aufgaben zu automatisieren, die Entscheidungsfindung zu unterstützen und die Produktivität zu steigern. KI-Copiloten bieten zwar enorme Vorteile, bringen aber auch neue Sicherheitsherausforderungen mit sich, denen Unternehmen begegnen müssen, um eine sichere Nutzung zu gewährleisten.

Sicherheitsrisiken auf der KI-Kopilot-Ebene

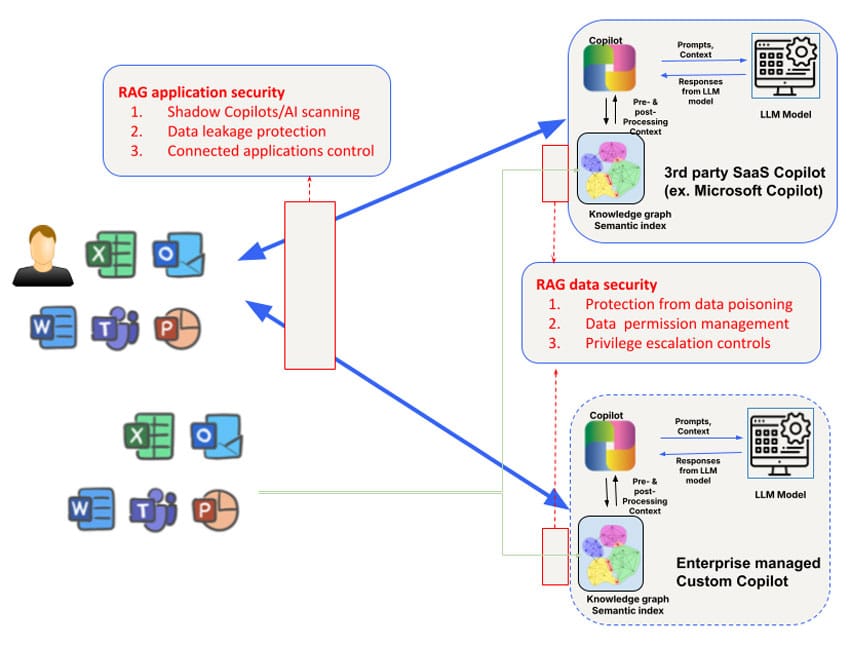

Die Sicherheitsrisiken unterscheiden sich bei KI-Kopiloten von Drittanbietern, die von Mitarbeitern verwendet werden (z. B. Microsoft Copilot), und bei benutzerdefinierten KI-Kopiloten, die von Unternehmensteams entwickelt werden, die für Kunden oder Partner tätig sind. So ist beispielsweise der Zugriff auf und die Manipulation des Wissensgraphen von KI-Copiloten von Drittanbietern begrenzt, ebenso wie die Kontrolle darüber, welche Daten zum Trainieren des Modells selbst verwendet werden. Nichtsdestotrotz müssen die Sicherheitsbedenken, die auf Ebene 1 angesprochen werden, durch einen Fokus auf drei Bereiche ergänzt werden: Daten, Kontext und Berechtigungen, um den umfassenderen Sicherheitsanforderungen für Copiloten gerecht zu werden.

1. Datenvergiftung und Modellmanipulation

KI-Copiloten sind auf große Datenmengen angewiesen, um Antworten zu generieren und Benutzer bei komplexen Aufgaben zu unterstützen. Diese starke Abhängigkeit von Daten birgt jedoch das Risiko des Data Poisoning, bei dem Angreifer die Eingabedaten manipulieren, um die Ergebnisse des Modells zu verfälschen. Dies kann dazu führen, dass KI-Copiloten falsche Vorschläge machen, fehlerhafte Entscheidungen treffen oder sogar schädliche Aktionen auf der Grundlage der vergifteten Daten ausführen.

Ein bösartiger Akteur könnte die Trainingsdaten verändern, die zur Feinabstimmung der Modelle für die KI-Copiloten verwendet werden, so dass das System sich unvorhersehbar verhält oder bestimmte Ergebnisse bevorzugt. Anfang dieses Jahres haben Forscher beispielsweise eine Stichprobe von Hugging Face durchgeführt und festgestellt, dass mehr als 100 Modelle bösartig waren. In Umgebungen, in denen KI-Copiloten für kritische Aufgaben wie Finanzanalysen oder Kundensupport eingesetzt werden, kann dies weitreichende Folgen haben. Diese Schwachstelle könnte ein Unternehmen potenziell externen Bedrohungen aussetzen, was sowohl zu finanziellen als auch zu rufschädigenden Schäden führen kann.

Tipp zur Abhilfe: Um das Risiko von Data Poisoning zu verringern, sollten Unternehmen strenge Datenvalidierungsmechanismen einführen und die Integrität aller Daten überwachen, die zum Trainieren oder Aktualisieren von KI-Modellen verwendet werden. Regelmäßig geplante Audits und der Einsatz von Data-Lineage-Tools zur Verfolgung des Datenflusses in KI-Copilot-Systeme können helfen, potenzielle Schwachstellen zu erkennen.

2. Kontextbedingte Risiken und Angriffe auf die Lieferkette

KI-Copiloten nutzen oft kontextbezogene Daten, wie z.B. das Benutzerverhalten, spezifische Unternehmensinformationen oder Echtzeit-Datenfeeds, um ihre Antworten anzupassen. Diese Abhängigkeit vom Kontext birgt jedoch das Risiko des Context Poisoning, bei dem Angreifer die Kontextdaten manipulieren, um das Verhalten des Systems zu verändern.

Das Copilot-System von Microsoft erstellt beispielsweise umfangreiche semantische Indizes für Unternehmensdaten, einschließlich E-Mails, Dokumente und Chats, um genaue und relevante Antworten zu liefern. Dieser Kontext kann jedoch für gezielte Angriffe ausgenutzt werden. Durch das Einschleusen bösartiger Daten oder die Veränderung des zugrunde liegenden Kontexts könnten Angreifer den KI-Copiloten dazu veranlassen, irreführende Ausgaben zu generieren, versehentlich sensible Informationen weiterzugeben, Spear-Phishing-Angriffe durchzuführen oder andere schädliche Aktionen durchzuführen. Eine andere Form der Vergiftung der Datenversorgungskette im Microsoft Copilot-Kontext kann durch die einfache Weitergabe einer bösartigen Datei an den Zielbenutzer erfolgen. Dieser Angriff funktioniert auch dann, wenn der Benutzer die Freigabe nicht akzeptiert und nicht einmal weiß, dass er eine bösartige Datei freigegeben hat.

Tipp zur Schadensbegrenzung: Unternehmen sollten klare Regeln für die Verwendung von und den Zugriff auf kontextbezogene Daten durch KI-Copiloten aufstellen. Dazu gehören die Begrenzung der Datentypen, die in das Training des KI-Piloten einfließen können, die Durchsetzung von Zugriffskontrollen und die regelmäßige Überprüfung der KI-Ausgaben auf Anzeichen von Manipulation. Red Teaming (simulierte Angriffe) kann ebenfalls dazu beitragen, Schwachstellen in KI-Copilot-Systemen und ihrer kontextbezogenen Datenverarbeitung zu identifizieren.

3. Missbrauch von Berechtigungen und Eskalation

Ein großes Risiko im Zusammenhang mit KI-Kopiloten ist der Missbrauch von Berechtigungen. Diese Systeme benötigen oft Zugriff auf mehrere Datensätze, Anwendungen oder sogar die Infrastruktur des Unternehmens, um Aufgaben effizient ausführen zu können. Wenn sie nicht ordnungsgemäß verwaltet werden, könnten KI-Kopiloten übermäßige Berechtigungen erhalten, so dass sie auf sensible Daten zugreifen oder Aktionen durchführen können, die über den vorgesehenen Rahmen hinausgehen.

Dies birgt das Risiko von Eskalationsangriffen, bei denen Angreifer die Berechtigungen des KI-Copiloten ausnutzen, um Zugriff auf nicht autorisierte Systeme oder vertrauliche Informationen zu erhalten. In einigen Fällen können falsch konfigurierte Berechtigungen es AI Copilots ermöglichen, Aktionen wie das Ändern von Kontoeinstellungen, das Löschen wichtiger Dateien oder die Weitergabe sensibler Daten an Drittanbieteranwendungen durchzuführen.

So wurde beispielsweise der Copilot von GitHub aufgrund seiner Integration mit Plugins von Drittanbietern als Risiko identifiziert, das zu Datenlecks führen könnte, wenn diese Plugins nicht ordnungsgemäß überprüft werden. Eine von der Cornell University durchgeführte Studie ergab, dass etwa 40 % der mit dem Copilot von GitHub erstellten Programme Schwachstellen enthielten. Dies unterstreicht die realen Risiken, die entstehen, wenn KI-Systemen ohne strenge Aufsicht übermäßige Berechtigungen eingeräumt werden.

Tipp zur Schadensbegrenzung: Zu den bewährten Verfahren für die Verwaltung von KI-Copilot-Berechtigungen gehören die Anwendung des Prinzips der geringsten Berechtigung (Gewährung nur der minimalen Berechtigungen, die für KI-Copiloten zur Ausführung ihrer Aufgaben erforderlich sind) und die regelmäßige Überprüfung von Zugriffsprotokollen. Automatisierte Tools, die anomales Verhalten erkennen und kennzeichnen, sollten ebenfalls eingesetzt werden, um die Risiken eines unbefugten Zugriffs oder einer Privilegienerweiterung zu verringern.

4. Schurken-KI Kopiloten und Schatten-KI

Mit der zunehmenden Verbreitung von KI-Copiloten sehen sich Unternehmen möglicherweise der Bedrohung durch abtrünnige KI-Copiloten oder Schatten-KI (nicht autorisierte KI-Anwendungen, die ohne Aufsicht eingesetzt werden) ausgesetzt. Diese Schattensysteme können außerhalb der formalen Sicherheitsprotokolle des Unternehmens operieren, was zu erheblichen Risiken wie Datenschutzverletzungen, Compliance-Verstößen und Betriebsausfällen führen kann.

Abtrünnige KI-Copiloten können von wohlmeinenden Mitarbeitern unter Verwendung von Open-Source-KI-Modellen oder von böswilligen Insidern erstellt werden, die versuchen, die Kontrollen des Unternehmens zu umgehen. Diese nicht genehmigten Systeme bleiben oft unbemerkt, bis eine Sicherheitsverletzung oder ein Compliance-Audit ihre Existenz aufdeckt.

Der Aufstieg der Schatten-KI wird mit den Anfängen der Schatten-IT verglichen, als nicht genehmigte Cloud-Dienste und -Anwendungen häufig von Mitarbeitern ohne Genehmigung des Unternehmens genutzt wurden. In ähnlicher Weise birgt die Schatten-KI das Risiko, dass unbekannte Schwachstellen in der Infrastruktur eines Unternehmens lauern, ohne dass formale Sicherheitsmaßnahmen zum Schutz vor Missbrauch vorhanden sind.

Tipp zur Schadensbegrenzung: Um das Aufkommen abtrünniger KI-Copiloten zu bekämpfen, müssen Unternehmen alle KI-Implementierungen streng beaufsichtigen. Die Implementierung von KI-Governance-Frameworks kann dazu beitragen, dass nur autorisierte KI-Copiloten eingesetzt werden, während eine kontinuierliche Überwachung und automatische Erkennungstools nicht autorisierte KI-Anwendungen im Unternehmen aufspüren können.

KI-Kopiloten absichern: Bewährte Praktiken

Die oben genannten Risiken können je nach Anwendungsfall angegangen werden. Für die Nutzung externer KI-Copiloten von Drittanbietern (wie Microsoft Copilot oder Github Copilot) müssen Sie zunächst ein Verständnis für die Nutzung von Schatten-KI-Copiloten/AI durch eine Erkennung erlangen. Skyhighs erweitertes Register der KI-Risikoattribute kann ein praktischer Weg sein, um KI-Copiloten von Drittanbietern zu entdecken, die von Unternehmen genutzt werden. Der Datenschutz auf dieser Ebene wird am besten durch eine Kombination aus netzwerkbasierter und API-basierter Datensicherheit gewährleistet. Inline-Kontrollen können entweder über Secure Service Edge (SSE) Forward Proxies (z. B. für das Hochladen von Dateien auf KI-Copiloten) und Application/LLM Reverse Proxies für selbst entwickelte KI-Copiloten/Chatbots oder browserbasierte Kontrollen für Anwendungsinteraktionen, die WebSockets verwenden, angewendet werden.

Ein weiteres Risiko besteht in anderen Anwendungen, die sich mit AI Copilots verbinden können. Microsoft Copilots können zum Beispiel so konfiguriert werden, dass sie sich bidirektional mit Salesforce verbinden. Die Möglichkeit, Microsoft Copilot-Konfigurationen abzufragen, um einen Einblick in solche verbundenen Anwendungen zu erhalten, ist unerlässlich, um diese Art von Leck zu verhindern.

Zusätzlich zu den Kontrollen auf der Ebene der KI-Copiloten-Anwendung müssen auch der RAG-Wissensgraph und die Indizes, die von den KI-Copiloten verwendet werden, besonders berücksichtigt werden. KI-Copiloten von Drittanbietern sind in dieser Hinsicht undurchsichtig. Daher sind Unternehmen auf die API-Unterstützung durch KI-Copiloten angewiesen, um die verwendeten Vektor-/Graphenspeicher zu untersuchen und Richtlinien festzulegen. Ein schwieriges Problem, das es auf dieser Ebene zu lösen gilt, ist die Verwaltung von Berechtigungen auf Datenebene sowie die Ausweitung von Berechtigungen, die versehentlich für von KI-Copiloten erstellte Inhalte entstehen können. Viele KI-Copiloten verfügen noch nicht über eine robuste API-Unterstützung für die Inline-/Echtzeitsteuerung, was die Herausforderung noch vergrößert. Schließlich können APIs für einen nahezu in Echtzeit erfolgenden Schutz und eine On-Demand-Überprüfung der Wissensbasis auf Datenkontrollen sowie für die Überprüfung auf Data-Poisoning-Angriffe verwendet werden.

Um sich vor den Sicherheitsrisiken zu schützen, die mit KI-Kopiloten verbunden sind, sollten Unternehmen einen mehrschichtigen Ansatz für die Sicherheit wählen. Zu den wichtigsten Maßnahmen gehören:

- Führen Sie regelmäßige Audits durch: Überprüfen Sie KI-Copilot-Einsätze regelmäßig auf Schwachstellen beim Data Poisoning, Risiken der Kontextmanipulation und Fehlkonfigurationen von Berechtigungen.

- Implementieren Sie Berechtigungskontrollen: Verwenden Sie Zugriffsmodelle mit geringsten Rechten, um sicherzustellen, dass KI-Copiloten nur auf die Daten und Systeme zugreifen können, die sie benötigen.

- Setzen Sie automatisierte Überwachungswerkzeuge ein: Implementieren Sie automatisierte Tools zur Überwachung des Verhaltens von AI Copilot und zur Erkennung von Anomalien, wie z.B. unbefugtem Zugriff oder verdächtigen Dateninteraktionen.

- Steuern Sie die KI-Nutzung: Schaffen Sie einen klaren Governance-Rahmen, um KI-Einsätze zu überwachen, abtrünnige KI-Copiloten zu verhindern und die Einhaltung von Sicherheits- und Datenschutzbestimmungen zu gewährleisten.

Durch die Übernahme dieser Best Practices können Unternehmen die Vorteile von KI-Copiloten maximieren und gleichzeitig die Sicherheitsrisiken minimieren.

Der Weg nach vorn: Sicherung von KI-Schichten

KI-Copiloten bieten ein erhebliches Potenzial zur Steigerung der Produktivität und zur Verbesserung der Geschäftsergebnisse, aber sie bringen auch neue Sicherheitsrisiken mit sich. Von Datenvergiftung bis hin zu böswilligen KI-Copiloten müssen Unternehmen proaktive Schritte unternehmen, um diese kritische Schicht der KI-Technologie zu schützen. Mit der Entwicklung fortschrittlicherer KI-Ebenen wächst der Bedarf an robusten Sicherheitsmaßnahmen.

Bleiben Sie dran für den nächsten Blog in unserer Serie, in dem wir uns mit Layer 3 und den Sicherheitsherausforderungen anderer autonomer KI-Systeme befassen werden. Wenn Sie mehr über die Sicherung Ihrer KI-Anwendungen erfahren möchten, entdecken Sie die KI-Lösungen von Skyhigh.

Andere Blogs in dieser Serie:

Zurück zu Blogs