リソース

AIコパイロットのセキュリティリスクと課題

By Sekhar Sarukkai - Cybersecurity@UC Berkeley

2024年10月16日 6 分で読む

前回のブログでは、すべてのAIモデルを支える重要な最初のレイヤーである「基盤AI」に関連するセキュリティ上の課題を探った。プロンプト・エンジニアリング攻撃、データ漏洩、設定ミス環境などのリスクについて検討した。AI技術が進歩するにつれて、新たな脆弱性を防ぐために各レイヤーを保護することが極めて重要になります。

このブログでは、レイヤー2「AIコパイロット」に関連するセキュリティリスクについて掘り下げていく。AIを活用したバーチャルアシスタントは、特定のタスクの自動化、意思決定のサポート、生産性の向上を目的として、業界全体で急速に導入が進んでいます。AIコパイロットは強力なメリットをもたらす一方で、安全でセキュアな利用を確保するために組織が対処しなければならない新たなセキュリティ上の課題ももたらします。

AIコパイロットレイヤーにおけるセキュリティリスク

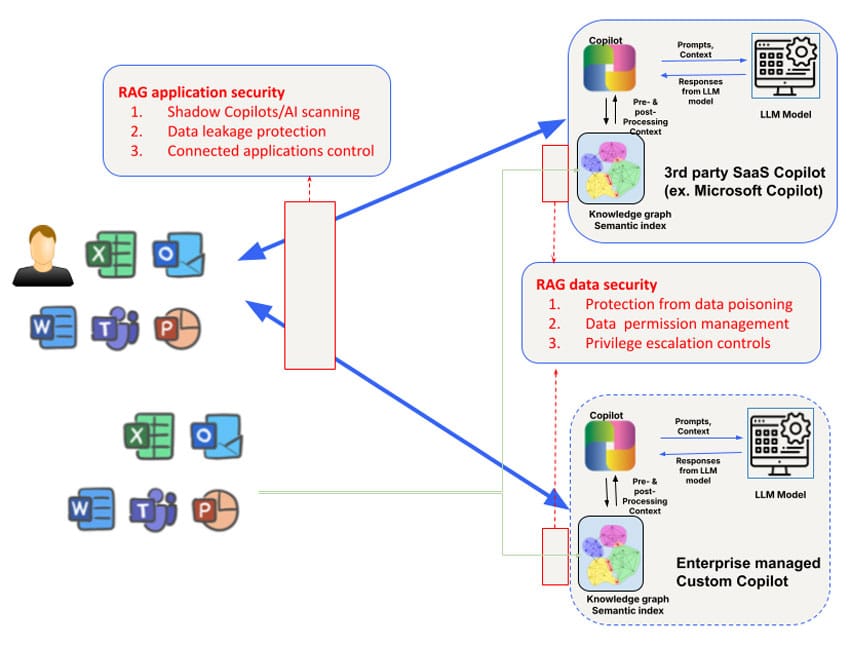

従業員が使用するサードパーティ製AIコパイロット(Microsoft Copilotなど)と、ビジネスチームが開発した顧客またはパートナー向けのカスタムAIコパイロットでは、セキュリティリスクが異なります。たとえば、サードパーティ製AIコパイロットのナレッジグラフへのアクセスや操作は制限されており、モデル自体の学習に使用するデータの制御も制限されている。とはいえ、レイヤー1で対処されるセキュリティ上の懸念は、コパイロットの広範なセキュリティニーズに対処するために、データ、コンテキスト、権限の3つの領域に焦点を当てて補強する必要がある。

1.データ汚染とモデル操作

AIコパイロットは、大量のデータに依存して応答を生成し、複雑なタスクでユーザーを支援する。しかし、データへの依存度が高いため、攻撃者が入力データを操作してモデルの出力を歪めるデータポイズニングのリスクが生じます。その結果、AIコパイロットが不正な提案をしたり、欠陥のある決定を下したり、あるいはポイズニングされたデータに基づいて有害なアクションを実行したりする可能性があります。

悪質な行為者は、AIコパイロットを動かすモデルを微調整するために使用されるトレーニングデータを改ざんし、システムが予測不可能な動作をしたり、特定の結果を好むようになる可能性がある。例えば、今年初めに研究者がHugging Faceをサンプリングしたところ、100以上のモデルが悪意を持っていることが判明しました。AI Copilotsが財務分析やカスタマーサポートのような重要なタスクに使用されている環境では、これは広範囲に及ぶ結果をもたらす可能性があります。この脆弱性は、組織を外部の脅威にさらす可能性があり、金銭的損害と風評的損害の両方につながる。

軽減のヒントデータポイズニングのリスクを低減するために、組織は厳格なデータ検証メカニズムを導入し、AIモデルの訓練または更新に使用されるすべてのデータの整合性を監視する必要があります。定期的に監査を実施し、データリネージツールを使用してAIコパイロットシステムへのデータの流れを追跡することで、潜在的な脆弱性を特定することができる。

2.コンテクストリスクとサプライチェーン攻撃

AIコパイロットは多くの場合、ユーザーの行動、特定の企業情報、リアルタイムのデータフィードなどのコンテキストデータを活用して、応答を調整します。しかし、このようなコンテキストへの依存は、攻撃者がシステムの動作を変更するためにコンテキストデータを操作するコンテキストポイズニングのリスクをもたらします。

例えば、マイクロソフトのCopilotシステムは、電子メール、文書、チャットなどの企業データに対してリッチなセマンティック・インデックスを作成し、正確で適切な応答を提供する。しかし、このコンテキストは標的型攻撃に悪用される可能性があります。悪意のあるデータを注入したり、基礎となるコンテキストを変更したりすることで、攻撃者はAI Copilotに誤解を招く出力を生成させたり、機密情報を不注意に共有させたり、スピアフィッシング攻撃を行ったり、その他の有害な行動を取らせたりする可能性があります。Microsoft Copilotのコンテキストにおけるデータサプライチェーンポイズニングのもう1つの形態は、悪意のあるファイルをターゲットユーザーと共有するだけで実行できます。この攻撃は、ユーザーが共有を受け入れず、共有された悪意のあるファイルに気づいていない場合でも機能します。

対策のヒント組織は、AIコパイロットによるコンテキストデータの使用方法とアクセス方法について明確なルールを設定することをお勧めします。これには、AIコパイロットのトレーニングに含めることができるデータの種類を制限すること、アクセス制御を実施すること、AIの出力に操作の兆候がないか定期的に監査することなどが含まれます。レッドチーム(模擬攻撃)は、AIコパイロットのシステムとそのコンテキストデータ処理の弱点を特定するのにも役立ちます。

3.権限の悪用とエスカレーション

AIコパイロットに関連する主なリスクは、権限の誤用である。これらのシステムは、タスクを効率的に実行するために、複数のデータセット、アプリケーション、あるいは企業のインフラストラクチャへのアクセスを必要とすることが多い。適切に管理されていない場合、AIコパイロットに過剰な権限が付与され、機密データにアクセスしたり、意図した範囲を超えてアクションを実行したりできる可能性があります。

このため、攻撃者がAI Copilotの権限を悪用して、許可されていないシステムや機密情報にアクセスするエスカレーション攻撃のリスクがあります。場合によっては、誤って設定された権限によって、AI Copilotがアカウント設定の変更、重要なファイルの削除、サードパーティのアプリケーションへの機密データの公開などのアクションを実行する可能性があります。

例えば、GitHubのCopilotは、サードパーティのプラグインと統合されているため、それらのプラグインが適切に審査されない場合、データ漏洩につながる危険性が指摘されている。コーネル大学が実施した調査では、GitHubのCopilotを使用して生成されたプログラムの約40%に脆弱性が含まれていることが明らかになり、厳格な監視なしにAIシステムに過剰な権限を付与することの現実的なリスクが強調された。

緩和策のヒント:AIコパイロットの権限を管理するためのベストプラクティスには、最小権限の原則を適用する(AIコパイロットがタスクを実行するために必要な最小限の権限のみを付与する)ことと、アクセスログを定期的にレビューすることが含まれる。また、不正アクセスや権限の昇格によるリスクを軽減するために、異常な動作を検出してフラグを立てる自動化ツールを採用する必要があります。

4.不正AIコパイロットとシャドーAI

AIコパイロットの普及に伴い、組織は不正なAIコパイロットやシャドーAI(監督なしに導入された未承認のAIアプリケーション)の脅威に直面する可能性がある。これらのシャドーシステムは、組織の正式なセキュリティプロトコルの範囲外で動作する可能性があり、データ侵害、コンプライアンス違反、運用障害などの重大なリスクにつながる。

不正なAIコパイロットは、オープンソースのAIモデルを使用して善意の従業員によって作成されることもあれば、企業の管理を迂回しようとする悪意のある内部者によって作成されることもある。このような無許可のシステムは、セキュリティ侵害やコンプライアンス監査で存在が明らかになるまで気づかれないことが多い。

シャドーAIの台頭は、無認可のクラウドサービスやアプリケーションが企業の承認なしに従業員によって一般的に利用されていたシャドーITの初期になぞらえられる。同様に、シャドーAIは、悪用から守るための正式なセキュリティ対策がないまま、組織のインフラ内に未知の脆弱性が潜むリスクをもたらす。

緩和のヒント不正なAI Copilotsの台頭に対抗するために、組織はすべてのAIのデプロイメントを厳しく監視する必要がある。AIガバナンスフレームワークを導入することで、許可されたAI Copilotsのみが展開されるようにし、継続的な監視と自動検出ツールによって、組織内で実行されている許可されていないAIアプリケーションを検出できる。

AIコパイロットの確保ベストプラクティス

上記のリスクは、ユースケースに応じて対処できる。外部のサードパーティ製AIコパイロット(Microsoft CopilotやGithub Copilotなど)を使用する場合、最初の要件は、シャドーAIコパイロット/AIの使用状況をディスカバリーによって把握することです。SkyhighのAIリスク属性の拡張レジストリは、企業が使用するサードパーティのAI Copilotを発見する便利な方法です。このレイヤーのデータ保護は、ネットワークベースとAPIベースのデータセキュリティの組み合わせで対処するのが最適です。インライン制御は、セキュアサービスエッジ(SSE)フォワードプロキシ(AIコパイロットにファイルをアップロードする場合など)や、自社製AIコパイロット/チャットボットのアプリケーション/LLMリバースプロキシ、またはWebSocketを使用するアプリケーションインタラクションのブラウザベースの制御を介して適用できる。

もう1つのリスクは、AI Copilotsに接続できる他のアプリケーションにある。たとえば、Microsoft CopilotsはSalesforceと双方向に接続するように設定できる。このような接続アプリケーションを可視化するためにMicrosoft Copilotの設定を照会する機能は、この漏えいのベクトルをブロックするために不可欠である。

AIコパイロットのアプリケーションレベルの制御に加えて、AIコパイロットが使用する検索拡張世代(RAG)ナレッジグラフとインデックスにも特別な配慮が必要である。サードパーティのAIコパイロットは、この点で不透明である。したがって組織は、AIコパイロットが使用するベクトル/グラフ・ストアをイントロスペクトし、ポリシーを設定するためのAPIサポートに依存することになる。特に、このレイヤーで対処すべき困難な問題の中心は、データレベルでの権限管理と、AI Copilotが作成したコンテンツで不注意に発生する可能性のある権限のエスカレーションである。多くのAIコパイロットは、インライン/リアルタイム制御のための堅牢なAPIサポートをまだ持っておらず、この課題をさらに複雑にしている。最後に、APIを使用して、ほぼリアルタイムの保護と、データ制御のための知識ベースのオンデマンドスキャン、およびデータポイズニング攻撃のスキャンを行うことができます。

AIコパイロットに関連するセキュリティリスクから保護するために、組織はセキュリティに多層的なアプローチを採用すべきである。主な対策には以下が含まれる:

- 定期的な監査を実施する:データポイズニングの脆弱性、コンテキスト操作のリスク、パーミッションの設定ミスがないか、AI Copilotのデプロイメントを定期的にレビューする。

- 権限制御を導入する:最小特権アクセスモデルを使用して、AIコパイロットが必要なデータとシステムにのみアクセスできるようにする。

- 自動監視ツールの導入AI Copilotの動作を監視し、不正アクセスや不審なデータのやり取りなどの異常を検出するための自動化ツールを導入する。

- AIの利用を管理する:AIの導入を監督し、不正なAIコパイロットを防止し、セキュリティおよびプライバシー規制の遵守を確保するために、明確なガバナンスの枠組みを確立する。

これらのベストプラクティスを採用することで、企業はセキュリティリスクを最小限に抑えながら、AIコパイロットのメリットを最大化することができる。

進むべき道AIレイヤーの保護

AIコパイロットは生産性を高め、ビジネスの成果を向上させる大きな可能性を秘めているが、同時に新たなセキュリティリスクももたらす。データポイズニングから不正なAIコパイロットに至るまで、組織はAIテクノロジーのこの重要なレイヤーを保護するために積極的な対策を講じる必要があります。AIがより高度なレイヤーに移行するにつれ、強固なセキュリティ対策の必要性は高まるばかりです。

次回のブログでは、レイヤー3とその他の自律型AIシステムに伴うセキュリティの課題についてご紹介します。AIアプリケーションのセキュリティについて詳しくは、SkyhighのAIソリューションをご覧ください。

このシリーズの他のブログ

- パート1 - AIセキュリティ:顧客のニーズと機会

- パート2 - 基礎的AI:セキュリティ上の課題がある重要なレイヤー

- 第3回 AIコパイロットのセキュリティリスクと課題