Risorse

Rischi e sfide della sicurezza con i copiloti AI

Di Sekhar Sarukkai - Cybersecurity@UC Berkeley

16 ottobre 2024 6 Minuti di lettura

Nel blog precedente, abbiamo esplorato le sfide di sicurezza legate all'AI fondamentale, il primo livello critico che supporta tutti i modelli di AI. Abbiamo esaminato rischi come gli attacchi di prompt engineering, la fuga di dati e gli ambienti mal configurati. Con l'avanzare della tecnologia AI, è fondamentale proteggere ogni livello per prevenire le vulnerabilità emergenti.

In questo blog, approfondiremo i rischi per la sicurezza associati al livello 2: i copiloti AI. Questi assistenti virtuali guidati dall'AI vengono rapidamente implementati in tutti i settori per automatizzare alcuni compiti, supportare il processo decisionale e migliorare la produttività. Se da un lato i copiloti AI offrono potenti vantaggi, dall'altro introducono nuove sfide di sicurezza che le organizzazioni devono affrontare per garantire un uso sicuro e protetto.

Rischi di sicurezza al livello del copilota AI

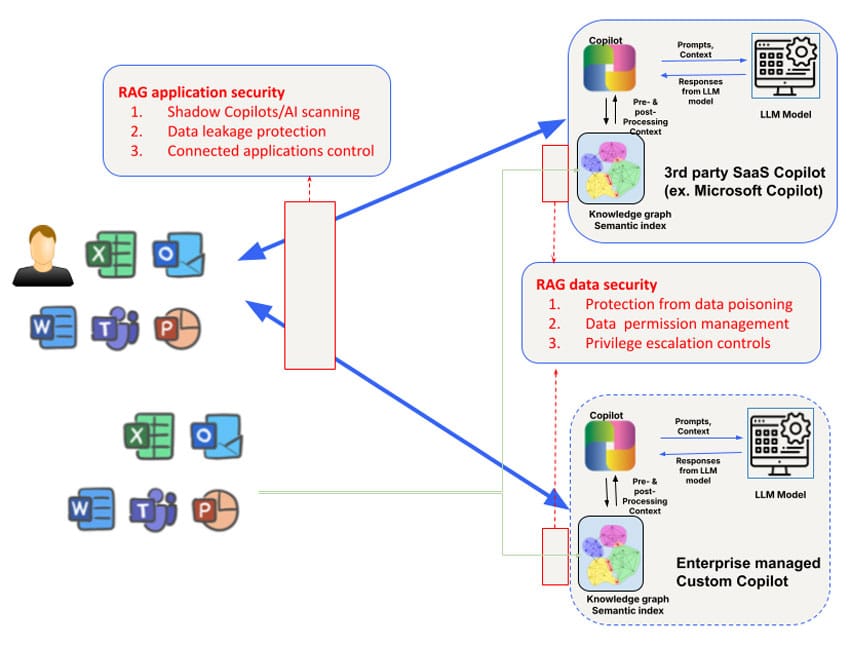

I rischi per la sicurezza differiscono per i Copilot AI di terze parti utilizzati dai dipendenti (come Microsoft Copilot) e i Copilot AI personalizzati sviluppati dai team aziendali che sono rivolti ai clienti o ai partner. Ad esempio, l'accesso e la manipolazione del Knowledge Graph dei Copilot AI di terze parti è limitato, così come il controllo dei dati utilizzati per addestrare il modello stesso. Tuttavia, le preoccupazioni sulla sicurezza affrontate al Livello 1 devono essere aumentate con un focus su tre aree: dati, contesto e autorizzazioni, per rispondere alle esigenze di sicurezza più ampie dei Copilot.

1. Avvelenamento dei dati e manipolazione del modello

I copiloti AI si basano su grandi volumi di dati per generare risposte e assistere gli utenti con compiti complessi. Tuttavia, questa forte dipendenza dai dati introduce il rischio di avvelenamento dei dati, in cui gli aggressori manipolano i dati di ingresso per distorcere i risultati del modello. Questo può far sì che i Copiloti AI forniscano suggerimenti errati, prendano decisioni sbagliate o addirittura eseguano azioni dannose sulla base dei dati avvelenati.

Un attore malintenzionato potrebbe alterare i dati di formazione utilizzati per mettere a punto i modelli che alimentano i Copiloti AI, facendo sì che il sistema si comporti in modo imprevedibile o favorisca determinati risultati. Ad esempio, all'inizio di quest'anno, i ricercatori hanno esaminato Hugging Face e hanno scoperto che più di 100 modelli erano dannosi. Negli ambienti in cui i copiloti AI sono utilizzati per compiti critici, come l'analisi finanziaria o l'assistenza ai clienti, ciò può avere conseguenze di vasta portata. Questa vulnerabilità potrebbe potenzialmente esporre un'organizzazione a minacce esterne, con conseguenti danni finanziari e di reputazione.

Suggerimento per la mitigazione: Per ridurre il rischio di avvelenamento dei dati, le organizzazioni devono implementare meccanismi rigorosi di convalida dei dati e monitorare l'integrità di tutti i dati utilizzati per addestrare o aggiornare i modelli AI. Audit programmati regolarmente e l'impiego di strumenti di data lineage per tracciare il flusso di dati nei sistemi AI Copilot possono aiutare a identificare potenziali vulnerabilità.

2. Rischi contestuali e attacchi alla catena di approvvigionamento

I copiloti AI spesso sfruttano i dati contestuali, come il comportamento degli utenti, le informazioni specifiche dell'azienda o i feed di dati in tempo reale, per adattare le loro risposte. Tuttavia, questo affidamento sul contesto introduce il rischio di avvelenamento del contesto, in cui gli aggressori manipolano i dati contestuali per alterare il comportamento del sistema.

Ad esempio, il sistema Copilot di Microsoft crea ricchi indici semantici per i dati aziendali, tra cui e-mail, documenti e chat, per fornire risposte accurate e pertinenti. Tuttavia, questo contesto può essere sfruttato per attacchi mirati. Iniettando dati dannosi o alterando il contesto sottostante, gli aggressori potrebbero indurre l'AI Copilot a generare output fuorvianti, a condividere inavvertitamente informazioni sensibili, a condurre attacchi di spear phishing o a intraprendere altre azioni dannose. Un'altra forma di avvelenamento della catena di fornitura dei dati nel contesto di Microsoft Copilot può essere effettuata semplicemente condividendo un file dannoso con l'utente target. Questo attacco funzionerà anche se l'utente non accetta la condivisione e non è nemmeno a conoscenza del file dannoso condiviso.

Suggerimento per la mitigazione: Si consiglia alle organizzazioni di stabilire regole chiare per l'utilizzo e l'accesso ai dati contestuali da parte dei Copiloti AI. Ciò include la limitazione dei tipi di dati che possono essere inclusi nell'addestramento dell'AI Copilot, l'applicazione dei controlli di accesso e l'audit regolare dei risultati dell'AI per individuare eventuali segni di manipolazione. Anche il red teaming (attacchi simulati) può aiutare a identificare i punti deboli nei sistemi di AI Copilot e nella loro elaborazione dei dati contestuali.

3. Uso improprio dei permessi e dell'escalation

Un rischio importante associato ai copiloti AI è l'uso improprio delle autorizzazioni. Questi sistemi spesso richiedono l'accesso a più set di dati, applicazioni o persino all'infrastruttura aziendale per svolgere le attività in modo efficiente. Se non vengono gestiti correttamente, i Copiloti AI potrebbero ricevere autorizzazioni eccessive, consentendo loro di accedere a dati sensibili o di eseguire azioni che vanno oltre il loro scopo.

Ciò comporta il rischio di attacchi di escalation, in cui gli aggressori sfruttano le autorizzazioni dell'AI Copilot per ottenere l'accesso a sistemi non autorizzati o a informazioni riservate. In alcuni casi, le autorizzazioni mal configurate possono consentire agli AI Copilot di eseguire azioni come la modifica delle impostazioni dell'account, l'eliminazione di file importanti o l'esposizione di dati sensibili ad applicazioni di terze parti.

Ad esempio, Copilot di GitHub è stato identificato come un rischio a causa della sua integrazione con plugin di terze parti che potrebbero portare a fughe di dati se tali plugin non sono adeguatamente controllati. Uno studio condotto dalla Cornell University ha rivelato che circa il 40% dei programmi generati utilizzando Copilot di GitHub contenevano vulnerabilità, sottolineando i rischi reali di concedere ai sistemi AI permessi eccessivi senza una rigorosa supervisione.

Suggerimento per la mitigazione: le migliori pratiche per la gestione delle autorizzazioni dei copiloti AI includono l'applicazione del principio del minimo privilegio (concedendo solo le autorizzazioni minime necessarie ai copiloti AI per svolgere i loro compiti) e la revisione regolare dei registri di accesso. Per mitigare i rischi di accesso non autorizzato o di escalation dei privilegi, si dovrebbero utilizzare anche strumenti automatizzati che rilevino e segnalino i comportamenti anomali.

4. Copiloti dell'IA ribelle e IA ombra

Con la proliferazione dei copiloti AI, le organizzazioni possono trovarsi di fronte alla minaccia di copiloti AI disonesti o di AI ombra (applicazioni AI non autorizzate distribuite senza supervisione). Questi sistemi ombra possono operare al di fuori dei protocolli di sicurezza formali dell'organizzazione, causando rischi significativi, tra cui violazioni dei dati, violazioni della conformità e fallimenti operativi.

I copiloti AI non autorizzati possono essere creati da dipendenti ben intenzionati che utilizzano modelli AI open-source o da insider malintenzionati che cercano di aggirare i controlli aziendali. Questi sistemi non autorizzati spesso passano inosservati finché una violazione della sicurezza o un audit di conformità non ne rivela l'esistenza.

L'ascesa dell'AI ombra è stata paragonata ai primi tempi dell'IT ombra, quando i servizi e le applicazioni cloud non autorizzati venivano comunemente utilizzati dai dipendenti senza l'approvazione dell'azienda. Allo stesso modo, l'AI ombra introduce il rischio di vulnerabilità sconosciute in agguato all'interno dell'infrastruttura di un'organizzazione, senza misure di sicurezza formali per proteggersi da un uso improprio.

Suggerimento per la mitigazione: Per combattere l'ascesa dei copiloti AI disonesti, le organizzazioni devono mantenere una rigorosa supervisione di tutte le implementazioni AI. L'implementazione di quadri di governance dell'AI può aiutare a garantire che vengano implementati solo Copiloti AI autorizzati, mentre il monitoraggio continuo e gli strumenti di scoperta automatizzati possono rilevare le applicazioni AI non autorizzate in esecuzione all'interno dell'organizzazione.

Protezione dei copiloti AI: Le migliori pratiche

I rischi di cui sopra possono essere affrontati in base ai casi d'uso. Per l'utilizzo di copiloti AI esterni di terze parti (come Microsoft Copilot o Github Copilot), il primo requisito è quello di comprendere l'utilizzo del copilota AI ombra tramite la scoperta. Il registro esteso di Skyhigh degli attributi di rischio AI può essere un modo utile per scoprire i copiloti AI di terze parti utilizzati dalle aziende. La protezione dei dati a questo livello è meglio affrontata con una combinazione di sicurezza dei dati basata sulla rete e sulle API. I controlli in linea possono essere applicati tramite proxy in avanti Secure Service Edge (SSE) (ad esempio, per l'upload di file verso i copiloti AI) e proxy inversi applicativi/LLM per i copiloti AI/chatbot di casa, oppure controlli basati sul browser per le interazioni con le applicazioni che utilizzano WebSockets.

Un altro rischio riguarda le altre applicazioni che possono collegarsi a AI Copilots. Ad esempio, i Copilot di Microsoft possono essere configurati per connettersi a Salesforce in modo bidirezionale. La capacità di interrogare le configurazioni di Microsoft Copilot per ottenere visibilità su tali applicazioni connesse sarà essenziale per bloccare questo vettore di perdita.

Oltre ai controlli a livello di applicazione dell'AI Copilot, è necessario prestare particolare attenzione anche al grafico di conoscenza della generazione aumentata del recupero (RAG) e agli indici che vengono utilizzati dagli AI Copilot. Gli AI Copilot di terze parti sono poco trasparenti a questo proposito. Pertanto, le organizzazioni dipenderanno dal supporto API da parte degli AI Copilot per introspezionare e impostare le politiche degli archivi vettoriali/grafici utilizzati. In particolare, un problema impegnativo da affrontare a questo livello riguarda la gestione delle autorizzazioni a livello di dati, nonché le escalation di privilegi che potrebbero inavvertitamente verificarsi per i contenuti creati dall'AI Copilot. Molti copiloti AI non dispongono ancora di un robusto supporto API per il controllo in linea/tempo reale, aggravando ulteriormente la sfida. Infine, le API possono essere utilizzate per la protezione quasi in tempo reale e per la scansione on-demand della base di conoscenza per i controlli dei dati, nonché per la scansione degli attacchi di avvelenamento dei dati.

Per proteggersi dai rischi di sicurezza associati ai copiloti AI, le organizzazioni dovrebbero adottare un approccio alla sicurezza a più livelli. Le misure chiave includono:

- Conduca controlli regolari: Esamini regolarmente le implementazioni di AI Copilot per verificare le vulnerabilità di avvelenamento dei dati, i rischi di manipolazione del contesto e le errate configurazioni dei permessi.

- Implementare i controlli dei permessi: Utilizzi modelli di accesso con privilegi minimi per garantire che i copiloti AI abbiano accesso solo ai dati e ai sistemi di cui hanno bisogno.

- Implementare strumenti di monitoraggio automatizzati: Implementa strumenti automatizzati per monitorare il comportamento di AI Copilot e rilevare le anomalie, come l'accesso non autorizzato o le interazioni sospette con i dati.

- Governare l'uso dell'AI: Stabilire quadri di governance chiari per supervisionare le implementazioni dell'IA, prevenire i copiloti dell'IA disonesti e garantire la conformità alle normative sulla sicurezza e sulla privacy.

Adottando queste best practice, le organizzazioni possono massimizzare i vantaggi dei copiloti AI, minimizzando i rischi per la sicurezza.

La strada da percorrere: Proteggere i livelli di intelligenza artificiale

I copiloti AI offrono un potenziale significativo per aumentare la produttività e migliorare i risultati aziendali, ma comportano anche nuovi rischi per la sicurezza. Dall'avvelenamento dei dati agli AI Copilot disonesti, le organizzazioni devono adottare misure proattive per proteggere questo livello critico della tecnologia AI. Con il passaggio a livelli più avanzati di AI, la necessità di misure di sicurezza robuste non fa che crescere.

Rimanga sintonizzato per il prossimo blog della nostra serie, dove esploreremo il Layer 3 e le sfide di sicurezza che si presentano con altri sistemi AI autonomi. Per saperne di più sulla sicurezza delle sue applicazioni AI, esplori le soluzioni AI di Skyhigh.

Altri blog in questa serie:

- Parte 1 - Sicurezza AI: Esigenze e opportunità dei clienti

- Parte 2 - AI fondamentale: un livello critico con sfide di sicurezza

- Parte 3 - Rischi e sfide della sicurezza con i copiloti AI

Contenuti correlati

Blog di tendenza

Attributi LLM che ogni CISO dovrebbe monitorare oggi

Sarang Warudkar 18 febbraio 2026

Dai requisiti DPDPA alla visibilità dei dati: l'imperativo DSPM

Niharika Ray e Sarang Warudkar 12 febbraio 2026

Skyhigh Security 2025: controllo più accurato, visibilità più chiara e azioni più rapide su dati, web e cloud

Thyaga Vasudevan 21 gennaio 2026

Il rischio nascosto della GenAI che potrebbe comportare costi significativi per la vostra azienda (e come risolverlo immediatamente)

Jesse Grindeland 18 dicembre 2025

Skyhigh Security : il 2026 sarà l'anno in cui l'intelligenza artificiale determinerà un nuovo modello di sicurezza aziendale.

Thyaga Vasudevan 12 dicembre 2025