Sumber daya

Risiko dan Tantangan Keamanan dengan Kopilot AI

Oleh Sekhar Sarukkai - Cybersecurity@UC Berkeley

16 Oktober 2024 6 Menit Baca

Di blog sebelumnya, kami telah membahas tantangan keamanan yang terkait dengan Foundational AI, lapisan pertama yang sangat penting yang mendukung semua model AI. Kami memeriksa risiko seperti serangan rekayasa yang cepat, kebocoran data, dan lingkungan yang salah konfigurasi. Seiring dengan kemajuan teknologi AI, sangat penting untuk mengamankan setiap lapisan untuk mencegah kerentanan yang muncul.

Dalam blog ini, kita akan membahas risiko keamanan yang terkait dengan Layer 2: AI Copilots. Asisten virtual yang digerakkan oleh AI ini dengan cepat digunakan di seluruh industri untuk mengotomatiskan tugas-tugas tertentu, mendukung pengambilan keputusan, dan meningkatkan produktivitas. Meskipun AI Copilots menawarkan manfaat yang kuat, mereka juga memperkenalkan tantangan keamanan baru yang harus ditangani oleh organisasi untuk memastikan penggunaan yang aman dan terlindungi.

Risiko Keamanan pada Lapisan Kopilot AI

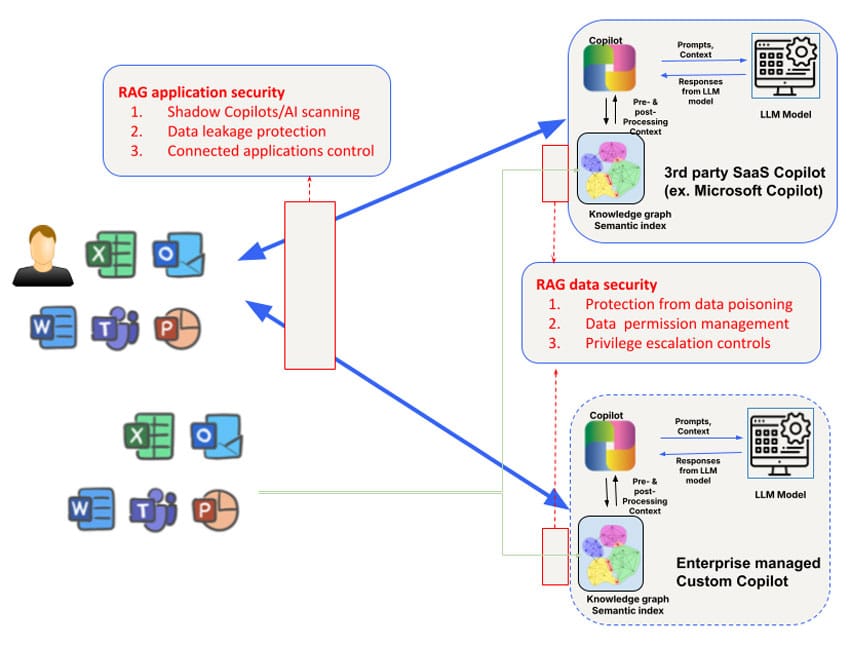

Risiko keamanan berbeda untuk AI Copilot pihak ketiga yang digunakan oleh karyawan (seperti Microsoft Copilot) dan AI Copilot khusus yang dikembangkan oleh tim bisnis yang berhadapan dengan pelanggan atau mitra. Misalnya, akses dan manipulasi grafik pengetahuan dari AI Copilot pihak ketiga terbatas, begitu pula dengan kontrol terhadap data yang digunakan untuk melatih model itu sendiri. Namun demikian, masalah keamanan yang dibahas di Layer 1 perlu ditambah dengan fokus pada tiga area: data, konteks, dan izin untuk memenuhi kebutuhan keamanan Copilot yang lebih luas.

1. Keracunan Data dan Manipulasi Model

AI Copilot mengandalkan volume data yang besar untuk menghasilkan respons dan membantu pengguna dengan tugas-tugas yang kompleks. Namun, ketergantungan yang besar pada data ini menimbulkan risiko keracunan data, di mana penyerang memanipulasi data input untuk mendistorsi output model. Hal ini dapat mengakibatkan AI Copilot memberikan saran yang salah, membuat keputusan yang salah, atau bahkan mengeksekusi tindakan berbahaya berdasarkan data yang diracuni.

Aktor jahat dapat mengubah data pelatihan yang digunakan untuk menyempurnakan model yang menggerakkan AI Copilot, menyebabkan sistem berperilaku tidak terduga atau mendukung hasil tertentu. Sebagai contoh, pada awal tahun ini, para peneliti mengambil sampel dari Hugging Face dan menemukan lebih dari 100 model yang berbahaya. Di lingkungan di mana AI Copilots digunakan untuk tugas-tugas penting-seperti analisis keuangan atau dukungan pelanggan-ini dapat memiliki konsekuensi yang luas. Kerentanan ini berpotensi membuat organisasi terpapar ancaman eksternal, yang menyebabkan kerusakan finansial dan reputasi.

Tip Mitigasi: Untuk mengurangi risiko keracunan data, organisasi harus menerapkan mekanisme validasi data yang ketat dan memantau integritas semua data yang digunakan untuk melatih atau memperbarui model AI. Audit yang dijadwalkan secara teratur dan menggunakan alat bantu silsilah data untuk melacak aliran data ke dalam sistem AI Copilot dapat membantu mengidentifikasi potensi kerentanan.

2. Risiko Kontekstual dan Serangan Rantai Pasokan

AI Copilot sering kali memanfaatkan data kontekstual, seperti perilaku pengguna, informasi perusahaan tertentu, atau umpan data waktu nyata, untuk menyesuaikan respons mereka. Namun, ketergantungan pada konteks ini menimbulkan risiko keracunan konteks, di mana penyerang memanipulasi data kontekstual untuk mengubah perilaku sistem.

Sebagai contoh, sistem Copilot Microsoft menciptakan indeks semantik yang kaya untuk data perusahaan-termasuk email, dokumen, dan obrolan-untuk memberikan respons yang akurat dan relevan. Namun, konteks ini dapat dieksploitasi untuk serangan yang ditargetkan. Dengan menyuntikkan data berbahaya atau mengubah konteks yang mendasarinya, penyerang dapat menyebabkan AI Copilot menghasilkan output yang menyesatkan, secara tidak sengaja membagikan informasi sensitif, melakukan serangan spear phishing, atau melakukan tindakan berbahaya lainnya. Bentuk lain dari peracunan rantai pasokan data dalam konteks Microsoft Copilot dapat dilakukan hanya dengan membagikan file berbahaya kepada pengguna target. Serangan ini akan berhasil meskipun pengguna tidak menerima pembagian tersebut dan bahkan tidak menyadari adanya file berbahaya yang dibagikan.

Tip Mitigasi: Organisasi disarankan untuk membuat aturan yang jelas tentang bagaimana data kontekstual digunakan dan diakses oleh AI Copilot. Hal ini termasuk membatasi jenis data yang dapat disertakan dalam pelatihan AI Copilot, memberlakukan kontrol akses, dan mengaudit output AI secara teratur untuk mengetahui tanda-tanda manipulasi. Red teaming (simulasi serangan) juga dapat membantu mengidentifikasi kelemahan dalam sistem AI Copilot dan pemrosesan data kontekstualnya.

3. Penyalahgunaan Izin dan Eskalasi

Risiko utama yang terkait dengan AI Copilot adalah penyalahgunaan izin. Sistem ini sering kali membutuhkan akses ke beberapa kumpulan data, aplikasi, atau bahkan infrastruktur perusahaan untuk melakukan tugas secara efisien. Jika tidak dikelola dengan baik, AI Copilot dapat diberikan izin yang berlebihan, sehingga mereka dapat mengakses data sensitif atau melakukan tindakan di luar cakupan yang seharusnya.

Hal ini menimbulkan risiko serangan eskalasi, di mana penyerang mengeksploitasi izin AI Copilot untuk mendapatkan akses ke sistem yang tidak sah atau informasi rahasia. Dalam beberapa kasus, izin yang salah dikonfigurasi dapat memungkinkan AI Copilot melakukan tindakan seperti mengubah pengaturan akun, menghapus file penting, atau mengekspos data sensitif ke aplikasi pihak ketiga.

Sebagai contoh, Copilot GitHub telah diidentifikasi sebagai risiko karena integrasinya dengan plugin pihak ketiga yang dapat menyebabkan kebocoran data jika plugin tersebut tidak diperiksa dengan benar. Sebuah studi yang dilakukan oleh Cornell University mengungkapkan bahwa sekitar 40% program yang dibuat menggunakan Copilot GitHub mengandung kerentanan, yang menekankan risiko dunia nyata dalam memberikan izin yang berlebihan kepada sistem AI tanpa pengawasan yang ketat.

Tip Mitigasi: Praktik terbaik untuk mengelola izin AI Copilot termasuk menerapkan prinsip hak istimewa yang paling sedikit (hanya memberikan izin minimum yang diperlukan bagi AI Copilot untuk melakukan tugas mereka) dan secara teratur meninjau log akses. Alat otomatis yang mendeteksi dan menandai perilaku anomali juga harus digunakan untuk memitigasi risiko dari akses yang tidak sah atau eskalasi hak istimewa.

4. Kopilot AI Nakal dan AI Bayangan

Seiring dengan berkembangnya AI Copilot, organisasi mungkin menghadapi ancaman AI Copilot nakal atau AI bayangan (aplikasi AI yang tidak sah yang digunakan tanpa pengawasan). Sistem bayangan ini dapat beroperasi di luar protokol keamanan formal organisasi, sehingga menimbulkan risiko yang signifikan, termasuk pelanggaran data, pelanggaran kepatuhan, dan kegagalan operasional.

Rogue AI Copilot dapat dibuat oleh karyawan yang bermaksud baik dengan menggunakan model AI sumber terbuka atau oleh orang dalam yang jahat yang ingin menerobos kontrol perusahaan. Sistem yang tidak disetujui ini sering kali tidak diketahui hingga pelanggaran keamanan atau audit kepatuhan mengungkapkan keberadaannya.

Munculnya AI bayangan telah disamakan dengan masa-masa awal TI bayangan, ketika layanan dan aplikasi cloud yang tidak disetujui biasanya digunakan oleh karyawan tanpa persetujuan perusahaan. Demikian pula, AI bayangan memperkenalkan risiko kerentanan yang tidak diketahui yang mengintai di dalam infrastruktur organisasi, tanpa adanya langkah-langkah keamanan formal untuk melindungi dari penyalahgunaan.

Tip Mitigasi: Untuk memerangi maraknya AI Copilot yang nakal, organisasi perlu mempertahankan pengawasan ketat terhadap semua penerapan AI. Menerapkan kerangka kerja tata kelola AI dapat membantu memastikan bahwa hanya AI Copilot resmi yang digunakan, sementara pemantauan berkelanjutan dan alat penemuan otomatis dapat mendeteksi aplikasi AI yang tidak sah yang berjalan di dalam organisasi.

Mengamankan Kopilot AI: Praktik Terbaik

Risiko di atas dapat diatasi berdasarkan kasus penggunaan. Untuk penggunaan AI Copilot pihak ketiga eksternal (seperti Microsoft Copilot atau Github Copilot), persyaratan pertama adalah mendapatkan pemahaman tentang penggunaan AI Copilot/ AI bayangan melalui penemuan. Daftar atribut risiko AI yang diperluas dari Skyhigh dapat menjadi cara yang berguna untuk menemukan AI Copilot pihak ketiga yang digunakan oleh perusahaan. Perlindungan data pada lapisan ini paling baik ditangani dengan kombinasi keamanan data berbasis jaringan dan API. Kontrol inline dapat diterapkan melalui proksi maju Secure Service Edge (SSE) (misalnya, untuk mengunggah file ke AI Copilots) dan proksi mundur aplikasi/LLM untuk AI Copilots/chatbots yang dibuat sendiri, atau kontrol berbasis peramban untuk interaksi aplikasi yang menggunakan WebSockets.

Risiko lain berpusat di sekitar aplikasi lain yang dapat terhubung ke AI Copilots. Sebagai contoh, Microsoft Copilots dapat dikonfigurasi untuk terhubung ke Salesforce secara dua arah. Kemampuan untuk menanyakan konfigurasi Microsoft Copilot untuk mendapatkan visibilitas ke dalam aplikasi yang terhubung seperti itu akan sangat penting untuk memblokir vektor kebocoran ini.

Selain kontrol tingkat aplikasi AI Copilot, pertimbangan khusus juga perlu diberikan pada grafik pengetahuan retrieval augmented generation (RAG) dan indeks yang digunakan oleh AI Copilot. AI Copilot pihak ketiga tidak jelas dalam hal ini. Oleh karena itu, organisasi akan bergantung pada dukungan API oleh AI Copilots untuk melakukan introspeksi dan menetapkan kebijakan penyimpanan vektor/grafik yang digunakan. Secara khusus, masalah yang menantang untuk diatasi pada lapisan ini berpusat pada manajemen izin di tingkat data serta eskalasi hak istimewa yang mungkin muncul secara tidak sengaja untuk konten yang dibuat oleh AI Copilot. Banyak AI Copilot yang belum memiliki dukungan API yang kuat untuk kontrol inline/real-time yang semakin menambah tantangan. Terakhir, API dapat digunakan untuk perlindungan hampir seketika dan pemindaian sesuai permintaan dari basis pengetahuan untuk kontrol data serta pemindaian serangan keracunan data.

Untuk melindungi dari risiko keamanan yang terkait dengan AI Copilot, organisasi harus mengadopsi pendekatan keamanan berlapis. Langkah-langkah utama meliputi:

- Melakukan audit rutin: Tinjau penerapan AI Copilot secara teratur untuk mengetahui kerentanan keracunan data, risiko manipulasi konteks, dan kesalahan konfigurasi izin.

- Menerapkan kontrol izin: Gunakan model akses yang paling sedikit untuk memastikan bahwa AI Copilot hanya memiliki akses ke data dan sistem yang mereka butuhkan.

- Menerapkan alat pemantauan otomatis: Menerapkan alat bantu otomatis untuk memantau perilaku AI Copilot dan mendeteksi anomali, seperti akses yang tidak sah atau interaksi data yang mencurigakan.

- Mengatur penggunaan AI: Menetapkan kerangka kerja tata kelola yang jelas untuk mengawasi penggunaan AI, mencegah Copilot AI yang nakal, dan memastikan kepatuhan terhadap peraturan keamanan dan privasi.

Dengan mengadopsi praktik terbaik ini, organisasi dapat memaksimalkan manfaat AI Copilot sekaligus meminimalkan risiko keamanan.

Jalan ke Depan: Mengamankan Lapisan AI

AI Copilot menawarkan potensi yang signifikan untuk meningkatkan produktivitas dan meningkatkan hasil bisnis, tetapi juga membawa risiko keamanan baru. Mulai dari keracunan data hingga AI Copilot yang nakal, organisasi harus mengambil langkah proaktif untuk mengamankan lapisan teknologi AI yang sangat penting ini. Saat kita beralih ke lapisan AI yang lebih canggih, kebutuhan akan langkah-langkah keamanan yang kuat semakin meningkat.

Nantikan blog berikutnya dalam seri blog kami, di mana kami akan menjelajahi Layer 3 dan tantangan keamanan yang ada pada sistem AI otonom lainnya. Untuk mempelajari lebih lanjut tentang mengamankan aplikasi AI Anda, jelajahi solusi Skyhigh AI.

Blog Lain Dalam Seri Ini:

- Bagian 1 - Keamanan AI: Kebutuhan dan Peluang Pelanggan

- Bagian 2 - AI Dasar: Lapisan Kritis dengan Tantangan Keamanan

- Bagian 3 - Risiko dan Tantangan Keamanan dengan Kopilot AI

Konten Terkait

Blog yang sedang tren

Atribut LLM yang Harus Dipantau oleh Setiap CISO Saat Ini

Sarang Warudkar 18 Februari 2026

Dari Persyaratan DPDPA hingga Visibilitas Data: Kebutuhan Mendesak DSPM

Niharika Ray dan Sarang Warudkar 12 Februari 2026

Skyhigh Security 2025: Pengendalian yang lebih ketat, visibilitas yang lebih jelas, dan tindakan yang lebih cepat di seluruh data, web, dan cloud.

Thyaga Vasudevan 21 Januari 2026

Risiko Tersembunyi GenAI yang Bisa Mengakibatkan Kerugian Jutaan Dolar bagi Perusahaan Anda (Dan Cara Mengatasinya Hari Ini)

Jesse Grindeland 18 Desember 2025

Skyhigh Security : 2026 Adalah Tahun di Mana Kecerdasan Buatan (AI) Memaksa Terciptanya Rencana Baru untuk Keamanan Perusahaan

Thyaga Vasudevan 12 Desember 2025