संसाधन

एआई सह-पायलटों के साथ सुरक्षा जोखिम और चुनौतियाँ

शेखर सरुक्काई द्वारा - साइबरसिक्यूरिटी@यूसी बर्कले

16 अक्टूबर, 2024 6 मिनट पढ़ें

पिछले ब्लॉग में, हमने फाउंडेशनल एआई से जुड़ी सुरक्षा चुनौतियों का पता लगाया, जो सभी एआई मॉडल का समर्थन करने वाली महत्वपूर्ण पहली परत है। हमने त्वरित इंजीनियरिंग हमलों, डेटा लीक और गलत तरीके से कॉन्फ़िगर किए गए वातावरण जैसे जोखिमों की जांच की। जैसे-जैसे एआई तकनीक आगे बढ़ती है, उभरती हुई कमजोरियों को रोकने के लिए प्रत्येक परत को सुरक्षित करना महत्वपूर्ण है।

इस ब्लॉग में, हम लेयर 2: AI Copilots से जुड़े सुरक्षा जोखिमों पर चर्चा करेंगे। ये AI-संचालित वर्चुअल असिस्टेंट कुछ कार्यों को स्वचालित करने, निर्णय लेने में सहायता करने और उत्पादकता बढ़ाने के लिए उद्योगों में तेज़ी से तैनात किए जा रहे हैं। जबकि AI Copilots शक्तिशाली लाभ प्रदान करते हैं, वे नई सुरक्षा चुनौतियाँ भी पेश करते हैं जिन्हें संगठनों को सुरक्षित और सुरक्षित उपयोग सुनिश्चित करने के लिए संबोधित करना चाहिए।

एआई कोपायलट स्तर पर सुरक्षा जोखिम

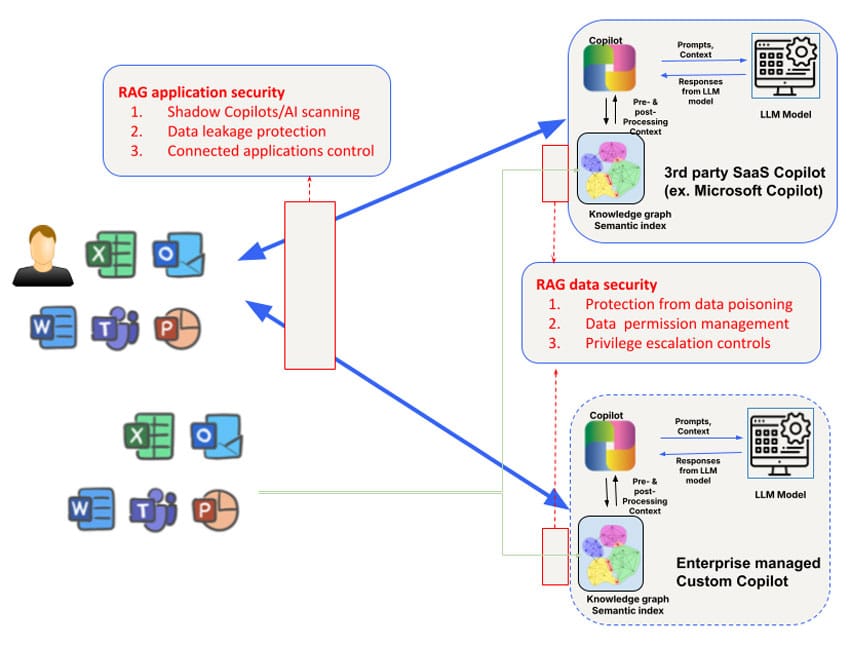

कर्मचारियों द्वारा उपयोग किए जाने वाले थर्ड-पार्टी AI कोपायलट (जैसे कि Microsoft Copilot) और ग्राहक- या भागीदार-सामना करने वाली व्यावसायिक टीमों द्वारा विकसित कस्टम AI कोपायलट के लिए सुरक्षा जोखिम अलग-अलग होते हैं। उदाहरण के लिए, थर्ड-पार्टी AI कोपायलट के नॉलेज ग्राफ तक पहुँच और उसमें हेरफेर सीमित है और मॉडल को प्रशिक्षित करने के लिए किस डेटा का उपयोग किया जाता है, इस पर नियंत्रण भी सीमित है। फिर भी, लेयर 1 पर संबोधित सुरक्षा चिंताओं को तीन क्षेत्रों पर ध्यान केंद्रित करके बढ़ाने की आवश्यकता है: डेटा, संदर्भ और अनुमतियाँ ताकि व्यापक कोपायलट सुरक्षा आवश्यकताओं को संबोधित किया जा सके।

1. डेटा पॉइज़निंग और मॉडल हेरफेर

AI कोपायलट प्रतिक्रियाएँ उत्पन्न करने और जटिल कार्यों में उपयोगकर्ताओं की सहायता करने के लिए बड़ी मात्रा में डेटा पर निर्भर करते हैं। हालाँकि, डेटा पर यह भारी निर्भरता डेटा विषाक्तता के जोखिम को जन्म देती है, जहाँ हमलावर मॉडल के आउटपुट को विकृत करने के लिए इनपुट डेटा में हेरफेर करते हैं। इसके परिणामस्वरूप AI कोपायलट गलत सुझाव दे सकते हैं, त्रुटिपूर्ण निर्णय ले सकते हैं, या यहाँ तक कि विषाक्त डेटा के आधार पर हानिकारक कार्य भी कर सकते हैं।

एक खराब अभिनेता AI Copilots को संचालित करने वाले मॉडल को ठीक करने के लिए उपयोग किए जाने वाले प्रशिक्षण डेटा को बदल सकता है, जिससे सिस्टम अप्रत्याशित रूप से व्यवहार कर सकता है या कुछ परिणामों का पक्ष ले सकता है। उदाहरण के लिए, इस साल की शुरुआत में, शोधकर्ताओं ने हगिंग फेस का नमूना लिया और पाया कि 100 से अधिक मॉडल दुर्भावनापूर्ण थे। ऐसे वातावरण में जहाँ AI Copilots का उपयोग महत्वपूर्ण कार्यों के लिए किया जाता है - जैसे कि वित्तीय विश्लेषण या ग्राहक सहायता - इसके दूरगामी परिणाम हो सकते हैं। यह भेद्यता संभावित रूप से किसी संगठन को बाहरी खतरों के लिए उजागर कर सकती है, जिससे वित्तीय और प्रतिष्ठा दोनों को नुकसान हो सकता है।

शमन सुझाव : डेटा विषाक्तता के जोखिम को कम करने के लिए, संगठनों को सख्त डेटा सत्यापन तंत्र लागू करना चाहिए और AI मॉडल को प्रशिक्षित या अपडेट करने के लिए उपयोग किए जाने वाले सभी डेटा की अखंडता की निगरानी करनी चाहिए। नियमित रूप से निर्धारित ऑडिट और AI कोपायलट सिस्टम में डेटा के प्रवाह को ट्रैक करने के लिए डेटा वंशावली उपकरणों को नियोजित करने से संभावित कमजोरियों की पहचान करने में मदद मिल सकती है।

2. प्रासंगिक जोखिम और आपूर्ति श्रृंखला हमले

एआई सह-पायलट अक्सर अपने जवाबों को अनुकूलित करने के लिए प्रासंगिक डेटा, जैसे कि उपयोगकर्ता व्यवहार, विशिष्ट कंपनी की जानकारी या वास्तविक समय के डेटा फ़ीड का लाभ उठाते हैं। हालाँकि, संदर्भ पर यह निर्भरता संदर्भ विषाक्तता के जोखिम को जन्म देती है, जहाँ हमलावर सिस्टम के व्यवहार को बदलने के लिए प्रासंगिक डेटा में हेरफेर करते हैं।

उदाहरण के लिए, Microsoft का Copilot सिस्टम एंटरप्राइज़ डेटा के लिए समृद्ध सिमेंटिक इंडेक्स बनाता है - जिसमें ईमेल, दस्तावेज़ और चैट शामिल हैं - सटीक और प्रासंगिक प्रतिक्रियाएँ प्रदान करने के लिए। हालाँकि, इस संदर्भ का लक्षित हमलों के लिए फायदा उठाया जा सकता है। दुर्भावनापूर्ण डेटा को इंजेक्ट करके या अंतर्निहित संदर्भ को बदलकर, हमलावर AI Copilot को भ्रामक आउटपुट उत्पन्न करने, अनजाने में संवेदनशील जानकारी साझा करने, स्पीयर फ़िशिंग हमले करने या अन्य हानिकारक कार्य करने का कारण बन सकते हैं। Microsoft Copilot संदर्भ में डेटा सप्लाई चेन पॉइज़निंग का एक और रूप केवल लक्षित उपयोगकर्ता के साथ एक दुर्भावनापूर्ण फ़ाइल साझा करके किया जा सकता है। यह हमला तब भी काम करेगा जब उपयोगकर्ता शेयर को स्वीकार नहीं करता है और उसे इस साझा की गई दुर्भावनापूर्ण फ़ाइल के बारे में पता भी नहीं है।

शमन सुझाव : संगठनों को सलाह दी जाती है कि वे AI Copilots द्वारा प्रासंगिक डेटा का उपयोग और एक्सेस करने के तरीके के बारे में स्पष्ट नियम स्थापित करें। इसमें AI Copilot प्रशिक्षण में शामिल किए जा सकने वाले डेटा के प्रकारों को सीमित करना, एक्सेस नियंत्रण लागू करना और हेरफेर के संकेतों के लिए नियमित रूप से AI आउटपुट का ऑडिट करना शामिल है। रेड टीमिंग (नकली हमले) AI Copilot सिस्टम और उनके प्रासंगिक डेटा प्रोसेसिंग में कमज़ोरियों की पहचान करने में भी मदद कर सकते हैं।

3. अनुमतियों का दुरुपयोग और वृद्धि

AI Copilots से जुड़ा एक बड़ा जोखिम अनुमतियों का दुरुपयोग है। इन प्रणालियों को अक्सर कार्यों को कुशलतापूर्वक करने के लिए कई डेटा सेट, एप्लिकेशन या यहां तक कि कंपनी के बुनियादी ढांचे तक पहुंच की आवश्यकता होती है। यदि ठीक से प्रबंधित नहीं किया जाता है, तो AI Copilots को अत्यधिक अनुमतियाँ दी जा सकती हैं, जिससे उन्हें संवेदनशील डेटा तक पहुँचने या उनके इच्छित दायरे से परे कार्य करने की अनुमति मिलती है।

इससे एस्केलेशन हमलों का जोखिम पैदा होता है, जहां हमलावर अनधिकृत सिस्टम या गोपनीय जानकारी तक पहुंच प्राप्त करने के लिए AI Copilot की अनुमतियों का फायदा उठाते हैं। कुछ मामलों में, गलत तरीके से कॉन्फ़िगर की गई अनुमतियाँ AI Copilot को खाता सेटिंग बदलने, महत्वपूर्ण फ़ाइलों को हटाने या तीसरे पक्ष के अनुप्रयोगों के लिए संवेदनशील डेटा को उजागर करने जैसी क्रियाएं करने की अनुमति दे सकती हैं।

उदाहरण के लिए, GitHub के Copilot को तीसरे पक्ष के प्लगइन्स के साथ इसके एकीकरण के कारण जोखिम के रूप में पहचाना गया है, जो डेटा लीक का कारण बन सकता है यदि उन प्लगइन्स की उचित जांच नहीं की जाती है। कॉर्नेल यूनिवर्सिटी द्वारा किए गए एक अध्ययन से पता चला है कि GitHub के Copilot का उपयोग करके तैयार किए गए लगभग 40% प्रोग्राम में कमज़ोरियाँ थीं , जो सख्त निगरानी के बिना AI सिस्टम को अत्यधिक अनुमतियाँ देने के वास्तविक दुनिया के जोखिमों पर जोर देता है।

शमन सुझाव : AI सह-पायलट अनुमतियों के प्रबंधन के लिए सर्वोत्तम अभ्यासों में न्यूनतम विशेषाधिकार के सिद्धांत को लागू करना (AI सह-पायलट को उनके कार्य करने के लिए आवश्यक न्यूनतम अनुमतियाँ प्रदान करना) और नियमित रूप से एक्सेस लॉग की समीक्षा करना शामिल है। अनधिकृत पहुँच या विशेषाधिकार वृद्धि से होने वाले जोखिमों को कम करने के लिए असामान्य व्यवहार का पता लगाने और उसे चिह्नित करने वाले स्वचालित उपकरणों का भी उपयोग किया जाना चाहिए।

4. दुष्ट एआई सहपायलट और छाया एआई

जैसे-जैसे AI कोपायलट बढ़ते हैं, संगठनों को दुष्ट AI कोपायलट या छाया AI (बिना निगरानी के तैनात अनधिकृत AI अनुप्रयोग) के खतरे का सामना करना पड़ सकता है। ये छाया प्रणालियाँ संगठन के औपचारिक सुरक्षा प्रोटोकॉल के बाहर काम कर सकती हैं, जिससे डेटा उल्लंघन, अनुपालन उल्लंघन और परिचालन विफलताओं सहित महत्वपूर्ण जोखिम पैदा हो सकते हैं।

दुष्ट AI सह-पायलट को ओपन-सोर्स AI मॉडल का उपयोग करने वाले अच्छे कर्मचारियों द्वारा या कंपनी के नियंत्रण को दरकिनार करने की कोशिश करने वाले दुर्भावनापूर्ण अंदरूनी लोगों द्वारा बनाया जा सकता है। ये अनधिकृत सिस्टम अक्सर तब तक किसी का ध्यान नहीं जाते जब तक कि सुरक्षा उल्लंघन या अनुपालन ऑडिट उनके अस्तित्व का पता नहीं लगा लेता।

शैडो एआई के उदय की तुलना शैडो आईटी के शुरुआती दिनों से की जा रही है, जब कॉर्पोरेट की मंजूरी के बिना कर्मचारियों द्वारा बिना अनुमति के क्लाउड सेवाओं और अनुप्रयोगों का इस्तेमाल किया जाता था। इसी तरह, शैडो एआई किसी संगठन के बुनियादी ढांचे में छिपी अज्ञात कमजोरियों के जोखिम को पेश करता है, जिसका दुरुपयोग करने से बचाने के लिए कोई औपचारिक सुरक्षा उपाय नहीं है।

शमन सुझाव : दुष्ट AI सह-पायलटों के उदय से निपटने के लिए, संगठनों को सभी AI परिनियोजनों की सख्त निगरानी बनाए रखने की आवश्यकता है। AI गवर्नेंस फ्रेमवर्क को लागू करने से यह सुनिश्चित करने में मदद मिल सकती है कि केवल अधिकृत AI सह-पायलट ही तैनात किए जाएं, जबकि निरंतर निगरानी और स्वचालित खोज उपकरण संगठन के भीतर चल रहे अनधिकृत AI अनुप्रयोगों का पता लगा सकते हैं।

एआई सह-पायलटों को सुरक्षित करना: सर्वोत्तम अभ्यास

उपरोक्त जोखिमों को उपयोग के मामलों के आधार पर संबोधित किया जा सकता है। बाहरी तृतीय-पक्ष AI Copilots (जैसे Microsoft Copilot या Github Copilot) के उपयोग के लिए, पहली आवश्यकता डिस्कवरी के माध्यम से छाया AI Copilot/AI उपयोग की समझ प्राप्त करना है। AI जोखिम विशेषताओं की Skyhigh की विस्तारित रजिस्ट्री उद्यमों द्वारा उपयोग किए जाने वाले तृतीय-पक्ष AI Copilots की खोज करने का एक आसान तरीका हो सकता है। इस स्तर पर डेटा सुरक्षा को नेटवर्क-आधारित और API-आधारित डेटा सुरक्षा के संयोजन के साथ सबसे अच्छा संबोधित किया जाता है। इनलाइन नियंत्रण या तो सिक्योर सर्विस एज (SSE) फ़ॉरवर्ड प्रॉक्सी (उदाहरण के लिए, AI Copilots पर फ़ाइल अपलोड करने के लिए) और घरेलू AI Copilots/चैटबॉट्स के लिए एप्लिकेशन/LLM रिवर्स प्रॉक्सी या WebSockets का उपयोग करने वाले एप्लिकेशन इंटरैक्शन के लिए ब्राउज़र-आधारित नियंत्रण के माध्यम से लागू किया जा सकता है।

एक और जोखिम उन अन्य अनुप्रयोगों के इर्द-गिर्द केंद्रित है जो AI Copilots से जुड़ सकते हैं। उदाहरण के लिए, Microsoft Copilots को Salesforce से द्विदिश रूप से कनेक्ट करने के लिए कॉन्फ़िगर किया जा सकता है। इस तरह के कनेक्टेड अनुप्रयोगों में दृश्यता प्राप्त करने के लिए Microsoft Copilot कॉन्फ़िगरेशन को क्वेरी करने की क्षमता रिसाव के इस वेक्टर को रोकने के लिए आवश्यक होगी।

AI Copilot एप्लिकेशन-स्तरीय नियंत्रणों के अलावा, AI Copilot द्वारा उपयोग किए जाने वाले रिट्रीवल ऑगमेंटेड जेनरेशन (RAG) नॉलेज ग्राफ और इंडेक्स पर भी विशेष ध्यान देने की आवश्यकता है। इस संबंध में थर्ड-पार्टी AI Copilot अपारदर्शी हैं। इसलिए संगठन आत्मनिरीक्षण करने और उपयोग किए जाने वाले वेक्टर/ग्राफ़ स्टोर की नीतियाँ निर्धारित करने के लिए AI Copilot द्वारा API समर्थन पर निर्भर होंगे। विशेष रूप से, इस स्तर पर संबोधित करने के लिए एक चुनौतीपूर्ण समस्या डेटा स्तर पर अनुमति प्रबंधन के साथ-साथ विशेषाधिकार वृद्धि के आसपास केंद्रित है जो अनजाने में AI Copilot द्वारा बनाई गई सामग्री के लिए उत्पन्न हो सकती है। कई AI Copilot में अभी भी इनलाइन/रीयल-टाइम नियंत्रण के लिए मज़बूत API समर्थन नहीं है, जो चुनौती को और बढ़ा देता है। अंत में, API का उपयोग लगभग रीयल-टाइम सुरक्षा और डेटा नियंत्रण के लिए ज्ञान आधार की ऑन-डिमांड स्कैनिंग के साथ-साथ डेटा पॉइज़निंग हमलों के लिए स्कैनिंग के लिए किया जा सकता है।

AI Copilots से जुड़े सुरक्षा जोखिमों से बचने के लिए, संगठनों को सुरक्षा के लिए बहुस्तरीय दृष्टिकोण अपनाना चाहिए। मुख्य उपायों में शामिल हैं:

- नियमित ऑडिट आयोजित करें : डेटा पॉइज़निंग भेद्यता, संदर्भ हेरफेर जोखिम और अनुमति गलत कॉन्फ़िगरेशन के लिए नियमित रूप से AI कोपायलट परिनियोजन की समीक्षा करें।

- अनुमति नियंत्रण लागू करें : न्यूनतम-विशेषाधिकार पहुंच मॉडल का उपयोग करें ताकि यह सुनिश्चित किया जा सके कि AI सह-पायलटों को केवल उन डेटा और प्रणालियों तक पहुंच प्राप्त हो जिनकी उन्हें आवश्यकता है।

- स्वचालित निगरानी उपकरण तैनात करें : AI सह-पायलट व्यवहार की निगरानी करने और अनधिकृत पहुंच या संदिग्ध डेटा इंटरैक्शन जैसी विसंगतियों का पता लगाने के लिए स्वचालित उपकरण लागू करें।

- एआई उपयोग को नियंत्रित करें : एआई तैनाती की देखरेख करने, दुष्ट एआई सह-पायलटों को रोकने और सुरक्षा और गोपनीयता विनियमों के अनुपालन को सुनिश्चित करने के लिए स्पष्ट शासन ढांचे की स्थापना करें।

इन सर्वोत्तम प्रथाओं को अपनाकर, संगठन सुरक्षा जोखिमों को न्यूनतम करते हुए AI सह-पायलट के लाभों को अधिकतम कर सकते हैं।

आगे का रास्ता: एआई परतों को सुरक्षित करना

AI कोपायलट उत्पादकता बढ़ाने और व्यावसायिक परिणामों में सुधार करने की महत्वपूर्ण क्षमता प्रदान करते हैं, लेकिन वे नए सुरक्षा जोखिम भी लाते हैं। डेटा पॉइज़निंग से लेकर दुष्ट AI कोपायलट तक, संगठनों को AI तकनीक की इस महत्वपूर्ण परत को सुरक्षित करने के लिए सक्रिय कदम उठाने चाहिए। जैसे-जैसे हम AI की अधिक उन्नत परतों की ओर बढ़ते हैं, मजबूत सुरक्षा उपायों की आवश्यकता बढ़ती ही जाती है।

हमारी श्रृंखला के अगले ब्लॉग के लिए बने रहें, जहाँ हम लेयर 3 और अन्य स्वायत्त AI सिस्टम के साथ आने वाली सुरक्षा चुनौतियों का पता लगाएंगे। अपने AI अनुप्रयोगों को सुरक्षित करने के बारे में अधिक जानने के लिए, Skyhigh AI समाधानों का पता लगाएँ ।

इस श्रृंखला के अन्य ब्लॉग:

- भाग 1 – एआई सुरक्षा: ग्राहकों की ज़रूरतें और अवसर

- भाग 2 – आधारभूत AI: सुरक्षा चुनौतियों के साथ एक महत्वपूर्ण परत

- भाग 3 – AI सह-पायलटों के साथ सुरक्षा जोखिम और चुनौतियाँ

संबंधित सामग्री

ट्रेंडिंग ब्लॉग

एलएलएम के वे गुण जिन्हें हर सीआईएसओ को आज ही ट्रैक करना चाहिए

सारंग वारुडकर 18 फरवरी, 2026

डीपीडीपीए आवश्यकताओं से लेकर डेटा दृश्यता तक: डीएसपीएम की अनिवार्यता

निहारिका रे और सारंग वरुडकर 12 फरवरी, 2026

Skyhigh Security 2025 की चौथी तिमाही: डेटा, वेब और क्लाउड पर बेहतर नियंत्रण, स्पष्ट दृश्यता और त्वरित कार्रवाई

त्याग वासुदेवन 21 जनवरी, 2026

GenAI का वह छिपा हुआ खतरा जो आपकी कंपनी को लाखों का नुकसान पहुंचा सकता है (और इसे आज ही कैसे ठीक करें)

जेसी ग्रिंडेलैंड 18 दिसंबर, 2025

Skyhigh Security भविष्यवाणियाँ: 2026 वह वर्ष है जब एआई उद्यम सुरक्षा के लिए एक नया खाका तैयार करने पर मजबूर करेगा।

त्याग वासुदेवन 12 दिसंबर, 2025