موارد

المخاطر والتحديات الأمنية مع الذكاء الاصطناعي الآلي المساعد

بقلم سيخار ساروكاي - الأمن السيبراني في جامعة بيركلي

16 أكتوبر 2024 6 قراءة دقيقة

في المدونة السابقة، استكشفنا في المدونة السابقة التحديات الأمنية المرتبطة بالذكاء الاصطناعي التأسيسي الذي يمثل الطبقة الأولى المهمة التي تدعم جميع نماذج الذكاء الاصطناعي. لقد درسنا مخاطر مثل الهجمات الهندسية السريعة، وتسريب البيانات، والبيئات ذات التكوين الخاطئ. مع تقدم تكنولوجيا الذكاء الاصطناعي، من الضروري تأمين كل طبقة لمنع الثغرات الأمنية الناشئة.

في هذه المدونة، سنتعمق في هذه المدونة في المخاطر الأمنية المرتبطة بالطبقة الثانية: مساعدو الذكاء الاصطناعي. يتم نشر هؤلاء المساعدين الافتراضيين الذين يعتمدون على الذكاء الاصطناعي بسرعة في مختلف الصناعات لأتمتة مهام معينة، ودعم اتخاذ القرارات، وتعزيز الإنتاجية. وعلى الرغم من أن روبوتات الذكاء الاصطناعي المساعدة تقدم مزايا قوية، إلا أنها تقدم أيضًا تحديات أمنية جديدة يجب على المؤسسات معالجتها لضمان الاستخدام الآمن والآمن.

المخاطر الأمنية في طبقة الذكاء الاصطناعي التجريبية

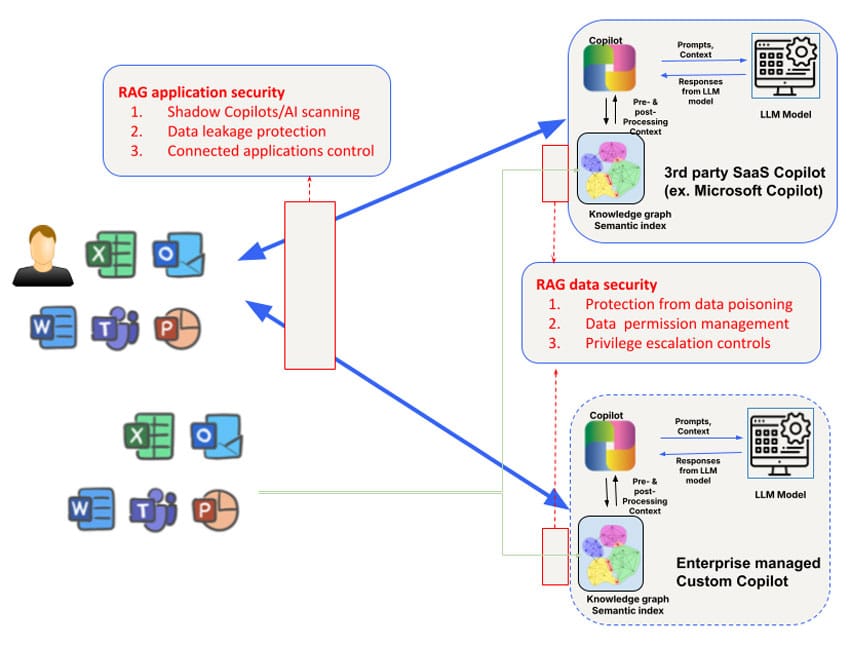

تختلف المخاطر الأمنية بالنسبة لنماذج الذكاء الاصطناعي التعاونية للجهات الخارجية التي يستخدمها الموظفون (مثل Microsoft Copilot) ونماذج الذكاء الاصطناعي المخصصة التي طورتها فرق العمل التي تواجه العملاء أو الشركاء. على سبيل المثال، يكون الوصول إلى الرسم البياني المعرفي لروبوتات الذكاء الاصطناعي التعاونية التابعة لجهات خارجية والتلاعب به محدوداً، وكذلك التحكم في البيانات المستخدمة لتدريب النموذج نفسه. ومع ذلك، يجب تعزيز المخاوف الأمنية التي تتم معالجتها في الطبقة الأولى بالتركيز على ثلاثة مجالات: البيانات والسياق والأذونات لتلبية الاحتياجات الأمنية الأوسع نطاقاً للطيار الآلي التعاوني.

1. التسمم بالبيانات والتلاعب بالنماذج

تعتمد روبوتات الذكاء الاصطناعي على كميات كبيرة من البيانات لتوليد الاستجابات ومساعدة المستخدمين في المهام المعقدة. ومع ذلك، فإن هذا الاعتماد الكبير على البيانات ينطوي على خطر تسميم البيانات، حيث يتلاعب المهاجمون ببيانات الإدخال لتشويه مخرجات النموذج. وقد يؤدي ذلك إلى قيام روبوتات الذكاء الاصطناعي بتقديم اقتراحات غير صحيحة، أو اتخاذ قرارات خاطئة، أو حتى تنفيذ إجراءات ضارة بناءً على البيانات المسمومة.

يمكن للفاعل السيئ أن يغير بيانات التدريب المستخدمة لضبط النماذج التي تشغّل روبوتات الذكاء الاصطناعي Copilots، مما يجعل النظام يتصرف بشكل غير متوقع أو يفضل نتائج معينة. على سبيل المثال، في وقت سابق من هذا العام، أخذ الباحثون عينة من عينة من برنامج Hugging Face واكتشفوا أن أكثر من 100 نموذج كانت خبيثة. في البيئات التي يتم فيها استخدام روبوتات الذكاء الاصطناعي في المهام الحرجة - مثل التحليل المالي أو دعم العملاء - يمكن أن يكون لذلك عواقب بعيدة المدى. من المحتمل أن تؤدي هذه الثغرة إلى تعريض المؤسسة لتهديدات خارجية، مما يؤدي إلى أضرار مالية وأضرار بالسمعة.

نصيحة للتخفيف من المخاطر: للحد من مخاطر تسمم البيانات، يجب على المؤسسات تنفيذ آليات صارمة للتحقق من صحة البيانات ومراقبة سلامة جميع البيانات المستخدمة لتدريب أو تحديث نماذج الذكاء الاصطناعي. يمكن أن تساعد عمليات التدقيق المجدولة بانتظام وتوظيف أدوات تسلسل البيانات لتتبع تدفق البيانات إلى أنظمة الذكاء الاصطناعي التجريبية في تحديد الثغرات المحتملة.

2. المخاطر السياقية وهجمات سلسلة التوريد

غالبًا ما تستفيد روبوتات الذكاء الاصطناعي من البيانات السياقية، مثل سلوك المستخدم، أو معلومات محددة عن الشركة، أو موجزات البيانات في الوقت الفعلي، لتخصيص استجاباتها. ومع ذلك، فإن هذا الاعتماد على السياق ينطوي على خطر تسميم السياق، حيث يتلاعب المهاجمون بالبيانات السياقية لتغيير سلوك النظام.

على سبيل المثال، يقوم نظام Copilot من مايكروسوفت بإنشاء مؤشرات دلالية غنية لبيانات المؤسسة - بما في ذلك رسائل البريد الإلكتروني والمستندات والمحادثات - لتوفير استجابات دقيقة وذات صلة. ومع ذلك، يمكن استغلال هذا السياق في الهجمات المستهدفة. فمن خلال حقن بيانات خبيثة أو تغيير السياق الأساسي، يمكن للمهاجمين أن يتسببوا في قيام نظام الذكاء الاصطناعي Copilot بتوليد مخرجات مضللة، أو مشاركة معلومات حساسة عن غير قصد، أو شن هجمات تصيد احتيالي، أو اتخاذ إجراءات ضارة أخرى. يمكن تنفيذ شكل آخر من أشكال تسميم سلسلة توريد البيانات في سياق Microsoft Copilot عن طريق مشاركة ملف خبيث مع المستخدم المستهدف. سيعمل هذا الهجوم حتى لو لم يقبل المستخدم المشاركة ولم يكن على علم بهذا الملف الخبيث الذي تمت مشاركته.

نصيحة للتخفيف من حدة المشكلة: تُنصح المؤسسات بوضع قواعد واضحة لكيفية استخدام البيانات السياقية والوصول إليها من قبل روبوتات الذكاء الاصطناعي. ويشمل ذلك الحد من أنواع البيانات التي يمكن تضمينها في تدريب الذكاء الاصطناعي الطيار الآلي المساعد، وفرض ضوابط الوصول، والتدقيق المنتظم لمخرجات الذكاء الاصطناعي بحثاً عن علامات التلاعب. يمكن أن يساعد الفريق الأحمر (هجمات المحاكاة) أيضاً في تحديد نقاط الضعف في أنظمة الذكاء الاصطناعي المستند إلى الذكاء الاصطناعي ومعالجة البيانات السياقية.

3. إساءة استخدام الأذونات والتصعيد

يتمثل أحد المخاطر الرئيسية المرتبطة بالذكاء الاصطناعي التعاوني في إساءة استخدام الأذونات. فغالباً ما تتطلب هذه الأنظمة الوصول إلى مجموعات بيانات أو تطبيقات أو حتى بنية تحتية متعددة للشركة لأداء المهام بكفاءة. إذا لم تتم إدارتها بشكل صحيح، فقد يتم منح روبوتات الذكاء الاصطناعي المستنسخة أذونات مفرطة، مما يسمح لها بالوصول إلى بيانات حساسة أو تنفيذ إجراءات خارج نطاقها المقصود.

ويشكل هذا خطر هجمات التصعيد، حيث يستغل المهاجمون أذونات الذكاء الاصطناعي Copilot للوصول إلى أنظمة غير مصرح بها أو معلومات سرية. في بعض الحالات، قد تسمح الأذونات التي تمت تهيئتها بشكل خاطئ للذكاء الاصطناعي Copilots بتنفيذ إجراءات مثل تغيير إعدادات الحساب، أو حذف الملفات المهمة، أو تعريض البيانات الحساسة لتطبيقات الطرف الثالث.

على سبيل المثال، تم تحديد برنامج Copilot الخاص بـ GitHub على أنه خطر بسبب تكامله مع المكونات الإضافية للجهات الخارجية التي يمكن أن تؤدي إلى تسرب البيانات إذا لم يتم فحص هذه المكونات الإضافية بشكل صحيح. وقد كشفت دراسة أجرتها جامعة كورنيل أن ما يقرب من 40% من البرامج التي تم إنشاؤها باستخدام برنامج Copilot الخاص بـ GitHub تحتوي على ثغرات، مما يؤكد على المخاطر الحقيقية لمنح أنظمة الذكاء الاصطناعي أذونات مفرطة دون رقابة صارمة.

نصيحة التخفيف من المخاطر: تتضمن أفضل الممارسات لإدارة أذونات الذكاء الاصطناعي للطيار الآلي المساعد تطبيق مبدأ الامتيازات الأقل (منح الحد الأدنى من الأذونات اللازمة فقط للطيار الآلي المساعد لأداء مهامه) ومراجعة سجلات الوصول بانتظام. يجب أيضًا استخدام الأدوات الآلية التي تكتشف السلوكيات الشاذة وتحددها للتخفيف من المخاطر الناجمة عن الوصول غير المصرح به أو تصعيد الامتيازات.

4. الذكاء الاصطناعي المارق والذكاء الاصطناعي الظل

مع انتشار روبوتات الذكاء الاصطناعي المستنسخة، قد تواجه المؤسسات خطر روبوتات الذكاء الاصطناعي المارقة أو الذكاء الاصطناعي الظل (تطبيقات الذكاء الاصطناعي غير المصرح بها التي يتم نشرها دون رقابة). يمكن أن تعمل أنظمة الظل هذه خارج بروتوكولات الأمان الرسمية للمؤسسة، مما يؤدي إلى مخاطر كبيرة، بما في ذلك انتهاكات البيانات، وانتهاكات الامتثال، والفشل التشغيلي.

يمكن إنشاء روبوتات الذكاء الاصطناعي المارقة من قبل موظفين ذوي نوايا حسنة باستخدام نماذج ذكاء اصطناعي مفتوحة المصدر أو من قبل أشخاص خبيثين من الداخل يسعون إلى تجاوز ضوابط الشركة. وغالباً ما تمر هذه الأنظمة غير المصرح بها دون أن يلاحظها أحد إلى أن يكشف اختراق أمني أو تدقيق الامتثال عن وجودها.

وقد تم تشبيه ظهور الذكاء الاصطناعي في الظل بالأيام الأولى لتكنولوجيا المعلومات في الظل، عندما كان الموظفون يستخدمون الخدمات والتطبيقات السحابية غير المصرح بها بشكل شائع دون موافقة الشركة. وبالمثل، فإن الذكاء الاصطناعي في الظل ينطوي على مخاطر الثغرات الأمنية غير المعروفة الكامنة داخل البنية التحتية للمؤسسة، مع عدم وجود تدابير أمنية رسمية للحماية من سوء الاستخدام.

نصيحة للتخفيف من المخاطر: لمكافحة ظهور روبوتات الذكاء الاصطناعي المارقة، تحتاج المؤسسات إلى فرض رقابة صارمة على جميع عمليات نشر الذكاء الاصطناعي. يمكن أن يساعد تطبيق أطر حوكمة الذكاء الاصطناعي في ضمان نشر روبوتات الذكاء الاصطناعي المستنسخة المصرح بها فقط، بينما يمكن لأدوات المراقبة المستمرة وأدوات الاكتشاف الآلية اكتشاف تطبيقات الذكاء الاصطناعي غير المصرح بها التي تعمل داخل المؤسسة.

تأمين روبوتات الذكاء الاصطناعي: أفضل الممارسات

يمكن معالجة المخاطر المذكورة أعلاه بناءً على حالات الاستخدام. بالنسبة لاستخدام روبوتات الذكاء الاصطناعي الخارجية (مثل Microsoft Copilot أو Github Copilot)، فإن الشرط الأول هو الحصول على فهم لاستخدامات الذكاء الاصطناعي/الذكاء الاصطناعي الخفي عن طريق الاكتشاف. يمكن أن يكون سجل Skyhigh الموسع لسمات مخاطر الذكاء الاصطناعي طريقة مفيدة لاكتشاف روبوتات الذكاء الاصطناعي التعاونية الخارجية التي تستخدمها المؤسسات. من الأفضل معالجة حماية البيانات في هذه الطبقة من خلال مزيج من أمان البيانات المستند إلى الشبكة وواجهة برمجة التطبيقات. يمكن تطبيق عناصر التحكم المضمنة إما عن طريق الوكلاء الأمامي للخدمة الآمنة (SSE) عبر وكلاء أماميين (على سبيل المثال، لتحميل الملفات إلى روبوتات الذكاء الاصطناعي) والوكلاء العكسيون للتطبيقات/التطبيقات/التطبيقات الآلية المحلية للذكاء الاصطناعي/روبوتات الدردشة، أو عناصر التحكم المستندة إلى المتصفح لتفاعلات التطبيقات التي تستخدم WebSockets.

هناك خطر آخر يتمحور حول التطبيقات الأخرى التي يمكنها الاتصال بـ AI Copilots. على سبيل المثال، يمكن تكوين Microsoft Copilots للاتصال بـ Salesforce ثنائي الاتجاه. ستكون القدرة على الاستعلام عن تكوينات Microsoft Copilot للحصول على رؤية واضحة في مثل هذه التطبيقات المتصلة ضرورية لمنع هذا الناقل من التسرب.

بالإضافة إلى عناصر التحكم على مستوى تطبيق الذكاء الاصطناعي للذكاء الاصطناعي Copilot، يجب أيضًا إيلاء اعتبار خاص للرسم البياني المعرفي للجيل المعزز للاسترجاع (RAG) والمؤشرات التي يستخدمها الذكاء الاصطناعي Copilots. تعتبر روبوتات الذكاء الاصطناعي التعاونية للذكاء الاصطناعي التابعة لجهات خارجية مبهمة في هذا الصدد. ومن ثم ستعتمد المؤسسات على دعم واجهة برمجة التطبيقات من قبل روبوتات الذكاء الاصطناعي Copilots لاستبطان وتعيين سياسات مخازن المتجهات/الرسم البياني المستخدمة. على وجه الخصوص، تتمحور المشكلة الصعبة التي يجب معالجتها في هذه الطبقة حول إدارة الأذونات على مستوى البيانات بالإضافة إلى تصعيد الامتيازات التي قد تنشأ عن غير قصد للمحتوى الذي أنشأه الذكاء الاصطناعي Copilots. لا يتوفر لدى العديد من روبوتات الذكاء الاصطناعي التعاونية حتى الآن دعم قوي لواجهة برمجة التطبيقات للتحكم في الوقت الفعلي/في الوقت الحقيقي، مما يزيد من تفاقم التحدي. أخيرًا، يمكن استخدام واجهات برمجة التطبيقات للحماية في الوقت الفعلي تقريبًا والمسح عند الطلب لقاعدة المعرفة للتحكم في البيانات بالإضافة إلى المسح بحثًا عن هجمات تسمم البيانات.

وللحماية من المخاطر الأمنية المرتبطة بالذكاء الاصطناعي الآلي، يجب على المؤسسات اعتماد نهج متعدد الطبقات للأمن. وتشمل التدابير الرئيسية ما يلي:

- إجراء عمليات تدقيق منتظمة: مراجعة عمليات نشر الذكاء الاصطناعي التجريبي للذكاء الاصطناعي بانتظام بحثًا عن الثغرات الأمنية في تسميم البيانات، ومخاطر التلاعب بالسياق، والتهيئة الخاطئة للأذونات.

- تنفيذ ضوابط الأذونات: استخدم نماذج الوصول ذات الامتيازات الأقل لضمان أن يكون لدى مساعدو الذكاء الاصطناعي فقط إمكانية الوصول إلى البيانات والأنظمة التي يحتاجون إليها.

- نشر أدوات المراقبة الآلية: تنفيذ أدوات آلية لمراقبة سلوك الذكاء الاصطناعي التجريبي واكتشاف الحالات الشاذة، مثل الوصول غير المصرح به أو تفاعلات البيانات المشبوهة.

- حوكمة استخدام الذكاء الاصطناعي: إنشاء أطر حوكمة واضحة للإشراف على عمليات نشر الذكاء الاصطناعي، ومنع استخدام الذكاء الاصطناعي المارقين، وضمان الامتثال للوائح الأمن والخصوصية.

من خلال اعتماد أفضل الممارسات هذه، يمكن للمؤسسات تعظيم فوائد الذكاء الاصطناعي الآلي التعاوني مع تقليل المخاطر الأمنية إلى الحد الأدنى.

الطريق إلى الأمام: تأمين طبقات الذكاء الاصطناعي

توفر روبوتات الذكاء الاصطناعي التعاونية إمكانات كبيرة لتعزيز الإنتاجية وتحسين نتائج الأعمال، ولكنها تجلب أيضاً مخاطر أمنية جديدة. بدءًا من تسمم البيانات إلى روبوتات الذكاء الاصطناعي المارقة التي تعمل بالذكاء الاصطناعي، يجب على المؤسسات اتخاذ خطوات استباقية لتأمين هذه الطبقة المهمة من تكنولوجيا الذكاء الاصطناعي. بينما ننتقل إلى طبقات أكثر تقدماً من الذكاء الاصطناعي، تزداد الحاجة إلى تدابير أمنية قوية.

ترقبوا المدونة التالية في سلسلتنا، حيث سنستكشف الطبقة 3 والتحديات الأمنية التي تأتي مع أنظمة الذكاء الاصطناعي المستقلة الأخرى. لمعرفة المزيد حول تأمين تطبيقات الذكاء الاصطناعي الخاصة بك، استكشف حلول Skyhigh AI.

مدونات أخرى في هذه السلسلة

- الجزء 1 - أمن الذكاء الاصطناعي: احتياجات العملاء والفرص المتاحة

- الجزء 2 - الذكاء الاصطناعي التأسيسي: طبقة حرجة ذات تحديات أمنية

- الجزء 3 - المخاطر والتحديات الأمنية مع الذكاء الاصطناعي المساعد

مضامين ذات صلة

المدونات الرائجة

السمات التي يجب على كل مسؤول أمن المعلومات تتبعها اليوم

سارانغ وارودكار 18 فبراير 2026

من متطلبات DPDPA إلى رؤية البيانات: ضرورة DSPM

نيهاريكا راي وسارانغ وارودكار 12 فبراير 2026

Skyhigh Security 2025: تحكم أكثر دقة، رؤية أوضح، وإجراءات أسرع عبر البيانات والويب والسحابة

Thyaga Vasudevan 21 يناير 2026

المخاطر الخفية لـ GenAI التي قد تكلف شركتك الملايين (وكيفية إصلاحها اليوم)

جيسي غريندلاند 18 ديسمبر 2025

Skyhigh Security : 2026 هو العام الذي ستفرض فيه الذكاء الاصطناعي خطة جديدة لأمن المؤسسات

ثياغا فاسوديفان 12 ديسمبر 2025