ทรัพยากร

ความปลอดภัยของ AI: ความต้องการและโอกาสของลูกค้า

โดย Sekhar Sarukkai - Cybersecurity@UC Berkeley

28 กันยายน 2567 6 อ่านนาที

สัญญาณทั้งหมดในอุตสาหกรรมชี้ไปที่การเติบโตอย่างรวดเร็วของนวัตกรรมและการนำเครื่องมือและบริการด้าน AI มาใช้ การลงทุนในสตาร์ทอัพด้านปัญญาประดิษฐ์ (AI) พุ่งสูงถึง 24,000 ล้านดอลลาร์ในช่วงเดือนเมษายนถึงมิถุนายน ซึ่งเพิ่มขึ้นมากกว่าสองเท่าจากไตรมาสก่อนหน้า ตามข้อมูลจาก Crunchbase ผู้ก่อตั้ง 75% ในกลุ่ม Y Combinator ล่าสุดกำลังทำงานในสตาร์ทอัพด้าน AI และผู้จำหน่ายเทคโนโลยีเกือบทั้งหมดกำลังดำเนินการปรับปรุงกลยุทธ์ของตนให้เน้นด้าน AI

จากการสำรวจล่าสุด PWC พบว่าบริษัทมากกว่า 50% ได้นำ genAI มาใช้แล้ว และ บริษัทในสหรัฐฯ 73% ได้นำ AI มาใช้ในอย่างน้อยบางพื้นที่ของการทำงานทางธุรกิจแล้ว ในเดือนนี้เอง OpenAI ยังได้ประกาศจำนวนที่นั่งระดับองค์กรที่ 1 ล้าน ซึ่งน้อยกว่า 1 ปีนับตั้งแต่เปิดตัวผลิตภัณฑ์ระดับองค์กร

การลงทุนและนวัตกรรมทั้งหมดนี้มาพร้อมกับความเสี่ยงจาก AI และมุมมองเกี่ยวกับปัญหาความปลอดภัย ความเป็นส่วนตัว และการกำกับดูแลที่สำคัญที่สุดที่จะทำให้บริษัทต่างๆ ไม่ใช้ AI ในการผลิต บล็อกนี้เป็นบล็อกแรกในซีรีส์นี้ ซึ่งรวบรวมมุมมองของฉันเกี่ยวกับความท้าทายด้านความปลอดภัยหลักๆ ที่ AI stack เผชิญ ซึ่งฉันได้รวบรวมมาในช่วงปีที่ผ่านมา

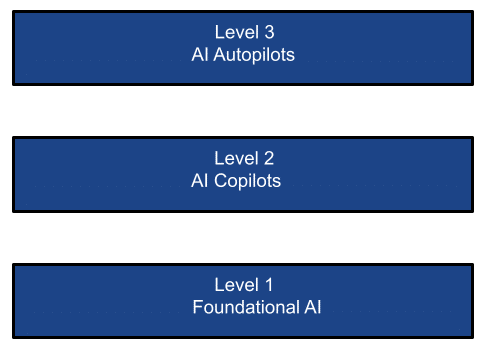

สแต็ก AI แบบง่าย

การขยายตัวของเทคโนโลยี AI สามารถมองเห็นได้ใน 3 ชั้นดังต่อไปนี้:

ชั้นที่ 1: AI พื้นฐาน

แบบจำลองพื้นฐานเป็นรูปแบบหนึ่งของปัญญาประดิษฐ์เชิงสร้างสรรค์ ซึ่งจะสร้างผลลัพธ์จากคำสั่งที่อิงตามภาษาของมนุษย์ แบบจำลองเหล่านี้อิงตามเครือข่ายประสาทที่ซับซ้อน รวมถึงเครือข่ายต่อต้านเชิงสร้างสรรค์ ตัวแปลง และตัวเข้ารหัสแบบแปรผัน ความก้าวหน้าของนวัตกรรมในปัญญาประดิษฐ์เชิงสร้างสรรค์นั้นน่าทึ่งมากด้วยการเปิดตัวที่เปลี่ยนเกม โดยล่าสุดคือ GPT-4o ที่มีแบบจำลองหลายโหมด เงินจำนวนมหาศาลได้หลั่งไหลเข้ามาในระดับนี้ โดยพื้นฐานแล้วคือการคัดเลือกผู้ชนะในเลเยอร์โครงสร้างพื้นฐานปัญญาประดิษฐ์หลักนี้

มีโครงสร้างพื้นฐานสองประเภทในชั้นนี้:

- โมเดลพื้นฐาน นั้นถูกครอบงำโดย OpenAI, Google Gemini, Mistral, Grok, Llama และ Anthropic โมเดลเหล่านี้ (โอเพ่นซอร์สหรือโคลสซอร์ส) ได้รับการฝึกอบรมจากคลังข้อมูลขนาดใหญ่ (สาธารณะหรือส่วนตัว) โมเดลเหล่านี้สามารถใช้สำหรับการอนุมานในรูปแบบ SaaS (เช่น ChatGPT), PaaS (เช่น AWS Bedrock, แพลตฟอร์ม Azure/Google AI) หรือปรับใช้ในอินสแตนซ์ส่วนตัว บริษัทโมเดลพื้นฐานเหล่านี้เพียงบริษัทเดียวคิดเป็นเกือบ 50% ของธุรกิจชิป AI ของ Nvidia

- มี โมเดลที่กำหนดเองได้ หลายพันโมเดลในตลาด เช่น Hugging Face โมเดลเหล่านี้ได้รับการฝึกอบรมบนชุดข้อมูลเฉพาะทาง (สาธารณะหรือส่วนตัว) สำหรับกรณีการใช้งานหรือแนวตั้งที่กำหนดเป้าหมาย นอกจากนี้ยังสามารถใช้เป็นบริการ SaaS หรือ PaaS หรือโดยการใช้งานในอินสแตนซ์ส่วนตัว นอกจากนี้ องค์กรต่างๆ สามารถเลือกสร้างและใช้งานโมเดลที่ปรับแต่งเองซึ่งใช้งานในศูนย์ข้อมูลส่วนตัว คลาวด์ส่วนตัว หรือในสภาพแวดล้อมไฮบริด (เช่น H2O.ai) ตัวอย่างเช่น รายงานไตรมาสล่าสุดจาก Microsoft แสดงให้เห็นว่าแม้ว่าการเติบโตของคลาวด์สาธารณะทั่วไปจะเล็กน้อยโดยไม่คำนึงถึง AI PaaS แต่ส่วนที่เติบโตเร็วที่สุดของธุรกิจคลาวด์สาธารณะคือ AI PaaS

กรณีการใช้งาน LLM/SLM:

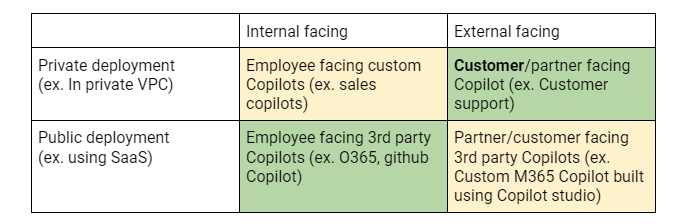

สามารถดูสรุปกรณีการใช้งานของลูกค้าในแต่ละเลเยอร์ได้จากมุมมองของสองมิติ: แกน X ระบุว่าความพยายาม/แอปพลิเคชัน AI มีเป้าหมายที่พนักงานภายในหรือลูกค้า/พันธมิตรภายนอก แกน Y ระบุว่าการปรับใช้แอปพลิเคชัน AI อยู่ในอินสแตนซ์ส่วนตัว (เช่นบน Google/MS AI หรือ AWS Bedrock) หรือเป็นบริการ SaaS ของบุคคลที่สาม (เช่น ChatGPT) เมทริกซ์นี้ช่วยชี้แจงความเสี่ยงด้านความปลอดภัย การเคลื่อนไหวของผู้ซื้อ/ผู้ใช้ และข้อกำหนดที่สำคัญ

เมทริกซ์ 2×2 ด้านบนแสดงให้เห็นกรณีการใช้งานที่แตกต่างกันซึ่งผลักดันการนำ LLM มาใช้ในองค์กรและลำดับความสำคัญในการปรับใช้ของลูกค้า เซลล์สีเขียวแสดงถึงการลงทุน/POC ในปัจจุบัน เซลล์สีเหลืองแสดงถึงการพัฒนาที่กำลังดำเนินอยู่ และเซลล์สีแดงแสดงถึงการลงทุนในอนาคตที่อาจเกิดขึ้น

เลเยอร์ 2: ผู้ช่วยนักบิน AI

หาก Mindshare เป็นตัววัดความสำเร็จในเลเยอร์ AI ที่เป็นพื้นฐาน รายได้ก็ถือเป็นมาตรวัดในเลเยอร์นี้อย่างไม่ต้องสงสัย เช่นเดียวกับในช่วงที่อินเทอร์เน็ตเฟื่องฟู ผู้จำหน่ายโครงสร้างพื้นฐานอินเทอร์เน็ต (ลองนึกถึง AT&T) ถือเป็นผู้มีส่วนสำคัญแต่ไม่ใช่ผู้ได้รับประโยชน์ทางธุรกิจรายใหญ่ที่สุดจากการปฏิวัติอินเทอร์เน็ต แอปพลิเคชันที่ใช้โครงสร้างพื้นฐานอินเทอร์เน็ตนี้เพื่อสร้างแอปพลิเคชันใหม่ๆ ที่น่าสนใจ เช่น Google, Uber และ Meta ถือเป็นผู้ชนะที่ยิ่งใหญ่กว่า ในทำนองเดียวกัน ในยุค AI แอปพลิเคชันมูลค่ามหาศาลก็ปรากฏขึ้นแล้วในรูปแบบของผู้ช่วยนำร่อง AI ดังที่ Satya Nadela ซีอีโอของ Microsoft ประกาศที่ Ignite 2023 ว่าพวกเขาเป็นบริษัทผู้ช่วยนำร่อง โดยมองเห็นภาพอนาคตที่ทุกสิ่งทุกอย่างและทุกคนจะมีผู้ช่วยนำร่อง การศึกษาวิจัยแสดงให้เห็นถึง ศักยภาพในการเพิ่มผลผลิตของนักพัฒนามากกว่า 30% หรือ เพิ่มผลผลิตในการประมวลผลการเรียกร้องค่าสินไหมทดแทนมากกว่า 50% ไม่น่าแปลกใจที่ Nadela กล่าวเมื่อไม่นานนี้ว่า Copilot เป็นผลิตภัณฑ์ชุด M365 ที่เติบโตเร็วที่สุดของ Microsoft และได้กลายเป็นผู้นำที่ก้าวล้ำในการปรับใช้ผู้ช่วยนำร่องระดับองค์กรไปแล้ว ข้อมูลล่าสุดของ Skyhigh ยืนยันสิ่งนี้ด้วยการใช้งาน M365 Copilot เพิ่มขึ้นมากกว่า 5,000% ในช่วง 6 เดือนที่ผ่านมา!

ที่สำคัญกว่านั้น มันคือเทคโนโลยี genAI ที่โดดเด่นซึ่งใช้ในองค์กรขนาดใหญ่ แม้ว่าการเจาะตลาด M365 Copilot จะอยู่ที่เพียง 1% ของธุรกิจ M365 เท่านั้น ซึ่งยังคงมีช่องว่างให้เติบโตได้อีกมาก ไม่ควรประเมินผลกระทบต่อองค์กรต่ำเกินไป เพราะปริมาณข้อมูลองค์กรที่ถูกจัดทำดัชนี รวมถึงข้อมูลที่แชร์กับ M365 Copilot นั้นไม่เคยมีมาก่อน องค์กรเกือบทั้งหมดบล็อก ChatGPT และเกือบทั้งหมดยังอนุญาตให้ O365 Co-pilot ใช้บริการ Azure AI (โดยเฉพาะ OpenAI) อีกด้วย การกำหนดราคาต่อที่นั่งเพิ่มเติมของ M365 สำหรับ Copilot กำลังจะกลายเป็นรูปแบบที่ผู้จำหน่าย SaaS ทั้งหมดจะเปิดตัว Copilot ของตนเอง ซึ่งจะสร้างกระแสรายได้ที่ทำกำไรมหาศาล

กรณีการใช้งานผู้ช่วยนักบิน:

เมทริกซ์ 2×2 ด้านบนแสดงกรณีการใช้งานที่แตกต่างกันซึ่งขับเคลื่อนการนำ Copilots มาใช้ในองค์กรและลำดับความสำคัญในการปรับใช้ของลูกค้า เซลล์สีเขียวแสดงถึงการลงทุน/POC ในปัจจุบัน เซลล์สีเหลืองแสดงถึงการพัฒนาที่กำลังดำเนินอยู่ และเซลล์สีแดงแสดงถึงการลงทุนในอนาคตที่อาจเกิดขึ้น

เลเยอร์ 3: ระบบนำร่องอัตโนมัติของ AI

นอกจากนี้ ยังมีเลเยอร์การทำงานอัตโนมัติของ AI ซึ่งเป็นระบบตัวแทนที่ทำงานโดยแทบไม่มีการแทรกแซงจากมนุษย์เลย เลเยอร์นี้มีแนวโน้มว่าจะเข้ามาทำลายธุรกิจ SI/ที่ปรึกษา ซึ่งปัจจุบันเป็นธุรกิจแบบแมนนวล มีราคาแพง และจากการประมาณการบางส่วนพบว่ามีขนาดใหญ่กว่าธุรกิจ SaaS/ซอฟต์แวร์เกือบ 8-10 เท่า แม้ว่าจะเป็นช่วงเริ่มต้น แต่ระบบตัวแทนเหล่านี้ (ระบบที่ออกแบบมาเพื่อทำหน้าที่เป็นตัวแทนอิสระ) มีแนวโน้มที่จะโดดเด่นในด้านการวิเคราะห์งาน การแยกย่อยงาน และการดำเนินการงานอิสระเพื่อตอบสนองต่อเป้าหมายที่ผู้ใช้กำหนด [หรือโดยนัย] ซึ่งอาจช่วยขจัดมนุษย์ในวงจร ได้ ปัจจุบันมีเงินทุนจาก VC จำนวนมาก ที่มุ่งเป้าไปที่พื้นที่นี้ สตาร์ทอัพ 75% ในกลุ่ม YC ล่าสุด ส่วนใหญ่เป็นสตาร์ทอัพด้าน AI ที่อยู่ในเลเยอร์นี้ เมื่อสัปดาห์ที่แล้ว Salesforce ได้ประกาศเปิด ตัว Agentforce เพื่อเพิ่มผลผลิตของพนักงาน และ Microsoft ได้เปิดตัว Copilot Agent ซึ่งมุ่งเป้าไปที่ SMB ในตอนแรก ซึ่งสามารถเปิดใช้งานระบบอัตโนมัติของกระบวนการทางธุรกิจ รวมถึงขยาย Copilot Studio เพื่อรองรับตัวแทนที่กำหนดเองได้

มีตัวแทนอิสระสำหรับผู้ช่วยส่วนตัว (เช่น Multion.ai) ตัวแทนฝ่ายสนับสนุน (เช่น Ada.cx, intercom.com) นักพัฒนา (เช่น Cognition.ai (devin), Cursor.com, Replit.com) ทีมขาย (เช่น Apollo.io, accountstory.com) ฝ่ายปฏิบัติการด้านความปลอดภัย (เช่น AirMDR.com, Prophetsecurity.ai, AgamottoSecurity.com, torq.io) นักวิจัย UX (เช่น Altis.io, Maze.co) นักออกแบบ UX (เช่น DesignPro.ai) ผู้ผสานรวมระบบ (เช่น TechStack.management) ผู้จัดการโครงการ (เช่น Clickup.com) พนักงานฝ่ายการเงินฝ่ายธุรการ (เช่น Prajna.ai) หรือแม้แต่พนักงาน AI สากล (เช่น ema.co) การศึกษาวิจัยบางกรณีระบุว่าระบบตัวแทนดังกล่าวที่ดำเนินการโดยอัตโนมัติอาจส่งผลให้มีค่าใช้จ่ายด้านซอฟต์แวร์เพิ่มขึ้น 1.5 ล้านล้านดอลลาร์สหรัฐ ซึ่งจะทำให้บริษัทสายพันธุ์ใหม่เหล่านี้กลายเป็นผู้นำในกลุ่มบริษัทที่ให้บริการในรูปแบบซอฟต์แวร์ที่สามารถครองตลาดด้านไอทีได้

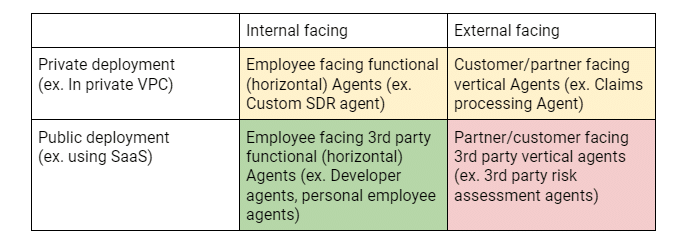

กรณีการใช้งานระบบอัตโนมัติ:

เมทริกซ์ 2×2 ด้านบนแสดงกรณีการใช้งานที่แตกต่างกันซึ่งขับเคลื่อนการนำเอเจนต์มาใช้ในองค์กรและลำดับความสำคัญในการปรับใช้ของลูกค้า เซลล์สีเขียวแสดงถึงการลงทุน/POC ในปัจจุบัน เซลล์สีเหลืองแสดงถึงการพัฒนาที่กำลังดำเนินอยู่ และเซลล์สีแดงแสดงถึงการลงทุนในอนาคตที่อาจเกิดขึ้น

ความต้องการและโอกาสด้านความปลอดภัยของ AI

ไม่น่าแปลกใจเลยที่ตั้งแต่มีการเปิดตัว ChatGPT เมื่อ 2 ปีที่แล้ว ศัพท์เฉพาะด้านความปลอดภัย ความเป็นส่วนตัว และการกำกับดูแลที่ไม่เคยมีใครรู้จักมาก่อนก็กลายเป็นกระแสหลัก เช่น วิศวกรรมที่รวดเร็ว การเจลเบรก ภาพหลอน การวางยาพิษข้อมูล เป็นต้น อุตสาหกรรมได้พยายามทำความเข้าใจกับปัญหาใหม่ๆ เหล่านี้อย่างรวดเร็ว และได้ส่งผลให้มีการวัดค่าบางอย่างที่ใช้ในการวัดแนวโน้มของ LLM ต่างๆ ที่จะแสดงลักษณะเหล่านี้ โครงการ Open Worldwide Application Security Project (OWASP) ได้ทำงานที่ดีในการระบุความเสี่ยง LLM 10 อันดับแรกที่ครอบคลุมและได้รับการอัปเดตอย่างต่อเนื่อง นอกจากนี้ Enkrypt AI ยังทำงานได้ดีในการสร้างและดูแลกระดานผู้นำด้านความปลอดภัย LLM ที่ครอบคลุม ซึ่งเป็นเครื่องมือที่มีประโยชน์ในการวัดคะแนนความปลอดภัยของ LLM ชั้นนำในสี่มิติของอคติ ความเป็นพิษ การเจลเบรก และมัลแวร์ การวิเคราะห์แบบเดียวกันนี้ยังสามารถทำได้สำหรับ LLM ที่กำหนดเองโดยใช้ทีมสีแดงอีกด้วย

อย่างไรก็ตาม หากพิจารณาบริบททั้งหมดของ AI stack การมองความปลอดภัยของ AI ในมุมแคบถือเป็นการมองที่ไร้เดียงสามาก แต่ละชั้นจำเป็นต้องพิจารณาปัญหาที่แตกต่างกันเพื่อรับมือกับความท้าทายเฉพาะตัวที่เกิดจากผู้ซื้อที่อาจแตกต่างกันได้ ตัวอย่างเช่น การใช้ทีมสีแดงเพื่อระบุปัญหาของโมเดลที่ลูกค้าใช้งานนั้นน่าจะเป็นที่สนใจของทีมแอปพลิเคชัน ในขณะที่การรั่วไหลของข้อมูลผ่านผู้ช่วยนักบินหรือข้อมูลที่ใช้ปรับแต่งโมเดลอาจเป็นปัญหาด้านความปลอดภัยของข้อมูลหรือ CDO

ในบล็อกถัดไป ฉันจะเจาะลึกลงไปถึงความเสี่ยงด้านความปลอดภัยและวิธีแก้ปัญหาที่เสนอในแต่ละเลเยอร์ที่อธิบายไว้ 3 เลเยอร์

บล็อกอื่นๆ ในซีรี่ส์นี้:

- ส่วนที่ 1 – ความปลอดภัยของ AI: ความต้องการและโอกาสของลูกค้า

- ส่วนที่ 2 – AI พื้นฐาน: ชั้นสำคัญที่มีความท้าทายด้านความปลอดภัย

- ส่วนที่ 3 – ความเสี่ยงด้านความปลอดภัยและความท้าทายกับ AI Copilots

เนื้อหาที่เกี่ยวข้อง

บล็อกที่กำลังได้รับความนิยม

คุณลักษณะของ LLM ที่ CISO ทุกคนควรติดตามในปัจจุบัน

สารัง วารุดการ์ 18 กุมภาพันธ์ 2569

จากข้อกำหนดของ DPDPA สู่การมองเห็นข้อมูล: ความจำเป็นของ DSPM

นิฮาริกา เรย์ และซารัง วารัดการ์ วันที่ 12 กุมภาพันธ์ พ.ศ. 2569

Skyhigh Security ไตรมาสที่ 4 ปี 2025: ควบคุมได้ดียิ่งขึ้น มองเห็นภาพรวมได้ชัดเจนขึ้น และดำเนินการได้รวดเร็วขึ้นในด้านข้อมูล เว็บ และคลาวด์

ไทอากา วาสุเดวัน 21 มกราคม 2569

ความเสี่ยงที่ซ่อนอยู่ของ GenAI ที่อาจทำให้บริษัทของคุณสูญเสียเงินหลายล้าน (และวิธีแก้ไขในวันนี้)

เจสซี กรินเดแลนด์ 18 ธันวาคม 2025

Skyhigh Security การคาดการณ์: ปี 2026 คือปีที่ AI จะบังคับให้เกิดพิมพ์เขียวใหม่สำหรับความปลอดภัยขององค์กร

ไทอากา วาสุเดวัน วันที่ 12 ธันวาคม พ.ศ. 2568