Por Sekhar Sarukkai - Ciberseguridad@UC Berkeley

28 de septiembre de 2024 6 Minuto de lectura

Todos los indicios del sector apuntan hacia un crecimiento desenfrenado de la innovación y la adopción de herramientas y servicios de IA. Las inversiones en startups de inteligencia artificial (IA) ascendieron a 24.000 millones de dólares de abril a junio, más del doble que en el trimestre anterior, según datos de Crunchbase. El 75% de los fundadores de la última cohorte de Y Combinator están trabajando en startups de IA y casi todos los proveedores de tecnología están ejecutando la renovación de su estrategia para centrarse en la IA.

En una encuesta reciente, PWC descubrió que más del 50% de las empresas ya han adoptado la genAI y el 73% de las empresas estadounidenses ya han adoptado la IA en al menos algunas áreas de sus funciones empresariales. Este mismo mes, OpenAI también anunció su puesto empresarial un millón, menos de un año desde que lanzó el producto para empresas.

Con toda esta inversión e innovación llega el lado negativo de los peligros de la IA, y las perspectivas sobre los mayores problemas de seguridad, protección, privacidad y gobernanza que impedirán que las empresas utilicen la IA en producción. Este blog, el primero de una serie, recoge mi perspectiva sobre los principales retos de seguridad a los que se enfrenta esa pila de IA que he ido recopilando a lo largo del último año.

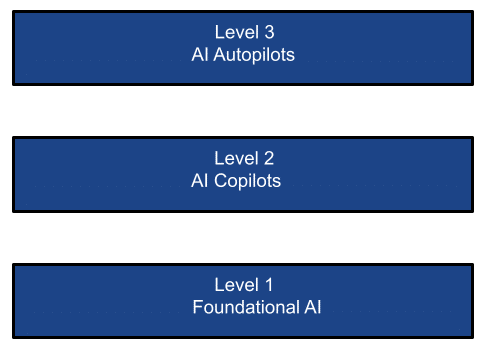

La pila de IA simplificada

La proliferación de las tecnologías de IA puede considerarse en los tres niveles siguientes:

CAPA 1: IA fundacional

Los modelos de fundamentos son una forma de inteligencia artificial generativa. Generan resultados a partir de indicaciones basadas en el lenguaje humano. Los modelos se basan en redes neuronales complejas que incluyen redes generativas adversariales, transformadores y codificadores variacionales. El ritmo de la innovación en la IA fundacional ha sido impresionante, con lanzamientos que han cambiado las reglas del juego, el último de ellos el GPT-4o con su modelo multimodal. Las grandes fortunas han inyectado mucho dinero a este nivel, eligiendo en esencia a los ganadores en esta capa de infraestructura básica de la IA.

Hay dos tipos de infraestructura en esta capa:

- Los modelos de base están dominados por empresas como OpenAI, Google Gemini, Mistral, Grok, Llama y Anthropic. Estos modelos (de código abierto o de código cerrado) se entrenan sobre un corpus gigantesco de datos (públicos o privados). Los modelos pueden utilizarse para la inferencia como SaaS (como ChatGPT), PaaS (como AWS Bedrock, las plataformas Azure/Google AI) o desplegarse en instancias privadas. Sólo estas empresas de modelos de base representan casi el 50% del negocio de chips de IA de Nvidia.

- Modelos personalizados de los que se pueden encontrar miles en un mercado como Hugging Face. Estos modelos se entrenan en conjuntos de datos especializados (públicos o privados) para casos de uso o verticales específicos. También pueden consumirse como servicios SaaS o PaaS, o desplegándolos en instancias privadas. Además, las empresas pueden optar por crear y desplegar sus propios modelos afinados en sus centros de datos privados, en su nube privada o en entornos híbridos (por ejemplo, H2O.ai). Los recientes informes trimestrales de Microsoft, por ejemplo, muestran que mientras que el crecimiento general de la nube pública sin tener en cuenta la AI PaaS es sólo modesto, la parte de más rápido crecimiento del negocio de la nube pública es la AI PaaS.

Casos prácticos de LLM/SLM:

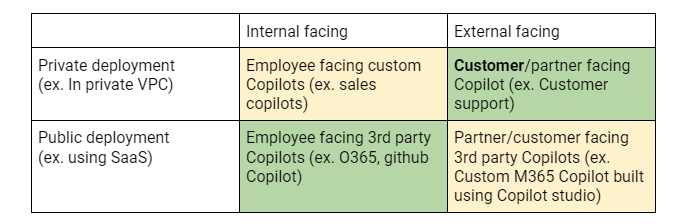

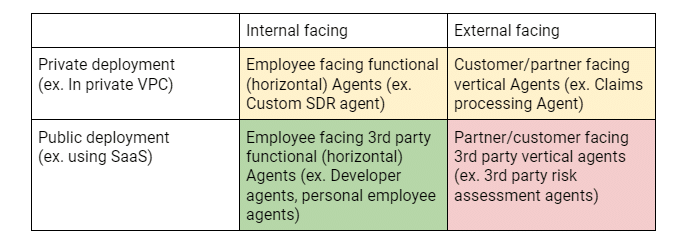

Un resumen de los casos de uso de los clientes en cada capa puede verse desde la perspectiva de dos dimensiones: El eje X que identifica si un esfuerzo/aplicación de IA está dirigido a empleados internos o a clientes/socios externos. El eje Y identifica si el despliegue de la aplicación de IA se realiza en una instancia privada (digamos en Google/MS AI o AWS Bedrock) o si se trata de un servicio SaaS de terceros (como ChatGPT). Esta matriz ayuda a aclarar los riesgos de seguridad, el movimiento del comprador/adoptante y los requisitos clave.

La matriz 2×2 anterior muestra los diferentes casos de uso que impulsan la adopción de LLM en las empresas y las prioridades de despliegue de los clientes. Las celdas verdes indican inversiones/POC actuales. Las celdas amarillas indican desarrollos activos y las rojas, posibles inversiones futuras.

Capa 2: Los copilotos de IA

Si el mindshare es la medida del éxito en la capa fundacional de la IA, los ingresos son sin duda la vara de medir en esta capa. Al igual que en el boom de Internet, los proveedores de infraestructura de Internet (piense en AT&T) fueron fundamentales pero no los mayores beneficiarios empresariales de la revolución de Internet. Fueron las aplicaciones que utilizaron esta infraestructura de internet para crear aplicaciones nuevas e interesantes, como Google, Uber y Meta, las mayores ganadoras. Del mismo modo, en la era de la IA, ya están surgiendo grandes aplicaciones de $$$ en forma de copilotos de IA: como Satya Nadela, el consejero delegado de Microsoft, proclamó en Ignite 2023 que ellos eran una empresa de copilotos, imaginando un futuro en el que todo y todos tendrán un copiloto. Los estudios ya han demostrado una ganancia potencial de más del 30% en la productividad de los desarrolladores, o de más del 50% en la productividad de la tramitación de siniestros de seguros. No es de extrañar que Nadela declarara recientemente que Copilot es el producto de la suite M365 de Microsoft que más rápido crece. Ya se ha convertido en un líder arrollador en despliegues empresariales de Copilot. Los datos recientes de Skyhigh lo confirman, ¡con un aumento de más del 5000% en el uso de M365 Copilot en los últimos 6 meses!

Y lo que es más importante, es la tecnología genAI dominante en uso en las grandes empresas, a pesar de que la penetración de M365 Copilot sólo alcanza el 1% del negocio de M365, lo que deja un enorme margen de crecimiento. El impacto en las empresas no debe subestimarse: la cantidad de datos empresariales que se indexan, así como los datos que se comparten con M365 Copilot, no tiene precedentes. Casi todas las empresas bloquean ChatGPT y casi todas permiten también O365 Copilot, que a su vez utiliza el servicio Azure AI (principalmente OpenAI). El precio por asiento del Copiloto de M365 se perfila como el modelo para que todos los proveedores de SaaS desplieguen sus propios copilotos, generando un lucrativo flujo de ingresos.

Casos de uso del copiloto:

La matriz 2×2 anterior muestra los diferentes casos de uso que impulsan la adopción de copilotos en las empresas y las prioridades de despliegue de los clientes. Las celdas verdes indican inversiones/POC actuales. Las celdas amarillas indican desarrollos activos y las rojas, posibles inversiones futuras.

Capa 3: Los autopilotos de la IA

Y luego está la capa de los pilotos automáticos de IA: sistemas agénticos que realizan tareas con poca o ninguna intervención humana. Esta promete ser la capa que romperá el negocio de SI/consultoría que ahora es manual, caro y es, según algunas estimaciones, casi 8-10 veces el tamaño del negocio de SaaS/software. Aunque incipientes, estos sistemas agénticos (sistemas diseñados para actuar como agentes autónomos) prometen sobresalir en el análisis de tareas, el desglose de tareas y la ejecución autónoma de tareas en respuesta a los objetivos fijados [o implícitos] por los usuarios. Esto puede eliminar potencialmente al humano en el bucle. Actualmente hay mucha financiación de capital riesgo dirigida a este espacio. Gran parte del 75% de las startups de la reciente cohorte de YC son startups de IA que caen en este estrato. Justo la semana pasada, Salesforce anunció su Agentforce para impulsar la productividad de los empleados y Microsoft presentó los Agentes Copilot dirigidos inicialmente a las pymes que pueden permitir la automatización de los procesos empresariales, así como la ampliación de su Copilot Studio para dar soporte a Agentes personalizados.

Existen agentes autónomos para un asistente personal (ex. Multion.ai), agentes de soporte (ex. Ada.cx, intercom.com), desarrolladores (ex. Cognition.ai (devin), Cursor.com, Replit.com), equipo de ventas (ex. Apollo.io, accountstory.com), operaciones de seguridad (ex. AirMDR.com, Prophetsecurity.ai, AgamottoSecurity.com, torq.io), investigador de UX (ex. Altis.io, Maze.co), diseñador de UX (ex. DesignPro.ai), integrador de sistemas (ex. TechStack.management), gestor de proyectos (ex. Clickup.com), empleados de back office financiero (ex. Prajna.ai), o incluso un empleado de IA universal (ex. ema.co). Algunos estudios indican que estos sistemas agénticos que automatizan acciones podrían dar lugar a 1,5T$ de gasto adicional en software, posicionando a esta nueva raza de empresas para ser la próxima vanguardia de las empresas de servicios como software que podrían dominar el panorama de las TI.

Casos de uso del piloto automático:

La matriz 2×2 anterior muestra los diferentes casos de uso que impulsan la adopción de Agentes en las empresas y las prioridades de despliegue de los clientes. Las celdas verdes indican inversiones/POC actuales. Las celdas amarillas indican desarrollos activos y las rojas, posibles inversiones futuras.

Necesidades y oportunidades de la seguridad de la IA

No es de extrañar que, desde la presentación de ChatGPT hace tan sólo 2 años, se haya generalizado una nueva jerga de seguridad, privacidad y gobernanza hasta ahora desconocida, como: ingeniería rápida, jailbreaking, alucinaciones, envenenamiento de datos, etc. La industria se ha apresurado a rodear con sus brazos estas nuevas cuestiones y ha dado lugar a algunas métricas utilizadas para medir la proclividad de varias LLM a mostrar estas características. El Open Worldwide Application Security Project (OWASP) ha realizado un buen trabajo al identificar los 10 principales riesgos de los LLM que son exhaustivos y se actualizan activamente. Además, Enkrypt AI ha hecho un buen trabajo creando y manteniendo una tabla de clasificación de seguridad de LLM exhaustiva que es una herramienta útil para comparar las puntuaciones de seguridad de los principales LLM en cuatro dimensiones de sesgo, toxicidad, fuga de la cárcel y malware. También se puede realizar el mismo análisis para los LLM personalizados a través de su red-teaming.

Sin embargo, dado el contexto completo de la pila de la IA, adoptar una visión estrecha de la seguridad de la IA es ingenuo. Cada capa requiere que se consideren cuestiones distintas para abordar los desafíos únicos impuestos por compradores potencialmente diferentes. Por ejemplo, el red-teaming para identificar problemas con los modelos que están desplegando los clientes es probable que interese al equipo de aplicaciones, mientras que la fuga de datos a través de copilotos o de los datos utilizados para afinar los modelos podría ser una preocupación de seguridad de la información o de CDO.

En los próximos blogs, profundizaré en los riesgos de seguridad y las soluciones propuestas en cada una de las tres capas descritas.

Otros blogs de esta serie:

Volver a Blogs