Risorse

Sicurezza AI: Esigenze e opportunità dei clienti

Di Sekhar Sarukkai - Cybersecurity@UC Berkeley

28 settembre 2024 6 Minuti di lettura

Tutti i segnali del settore puntano verso una crescita dilagante dell'innovazione e dell'adozione di strumenti e servizi di AI. Gli investimenti in startup di intelligenza artificiale (AI) sono saliti a 24 miliardi di dollari da aprile a giugno, più che raddoppiando rispetto al trimestre precedente, secondo i dati di Crunchbase. Il 75% dei fondatori dell'ultima coorte di Y Combinator sta lavorando su startup AI e quasi tutti i fornitori di tecnologia stanno eseguendo un rinnovamento della loro strategia per essere incentrati sull'AI.

In una recente indagine, PWC ha rilevato che oltre il 50% delle aziende ha già adottato l'AI e il 73% delle aziende statunitensi ha già adottato l'AI in almeno alcune aree delle proprie funzioni aziendali. Proprio questo mese, OpenAI ha anche annunciato il milionesimo posto in azienda, a meno di un anno dal rilascio del prodotto enterprise.

Con tutti questi investimenti e innovazioni, arriva anche l'aspetto negativo dei pericoli dell'IA e le prospettive sui maggiori problemi di sicurezza, protezione, privacy e governance che impediranno alle aziende di utilizzare l'IA in produzione. Questo blog, il primo di una serie, cattura la mia prospettiva sulle principali sfide di sicurezza che lo stack AI deve affrontare e che ho raccolto nel corso dell'ultimo anno.

Lo stack AI semplificato

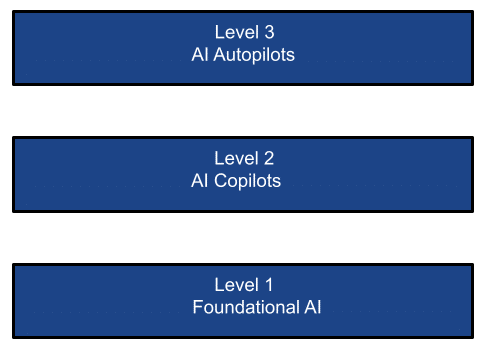

La proliferazione delle tecnologie AI può essere vista nei seguenti tre livelli:

LIVELLO 1: IA fondamentale

I modelli di fondazione sono una forma di intelligenza artificiale generativa. Generano output da richieste basate sul linguaggio umano. I modelli si basano su reti neurali complesse, tra cui reti generative avversarie, trasformatori e codificatori variazionali. Il ritmo dell'innovazione nell'Intelligenza Artificiale Fondamentale è stato mozzafiato con rilasci che hanno cambiato il gioco, più recentemente con il GPT-4o con il suo modello multimodale. Le grandi aziende hanno investito grandi somme di denaro a questo livello, scegliendo in sostanza i vincitori in questo livello di infrastruttura AI di base.

Ci sono due tipi di infrastrutture in questo livello:

- I modelli di fondazione sono dominati da aziende del calibro di OpenAI, Google Gemini, Mistral, Grok, Llama e Anthropic. Questi modelli (open-source o close-source) sono addestrati su un enorme corpus di dati (pubblici o privati). I modelli possono essere utilizzati per l'inferenza come SaaS (come ChatGPT), PaaS (come AWS Bedrock, piattaforme Azure/Google AI) o distribuiti in istanze private. Queste aziende di modelli di fondazione rappresentano da sole quasi il 50% del business dei chip AI di Nvidia.

- Modelli personalizzati, migliaia dei quali possono essere trovati in un mercato come Hugging Face. Questi modelli sono addestrati su set di dati specializzati (pubblici o privati) per casi d'uso o verticali mirati. Possono anche essere consumati come servizi SaaS o PaaS, o distribuendoli in istanze private. Inoltre, le aziende possono scegliere di creare e distribuire i propri modelli perfezionati nei loro data center privati, nel Cloud privato o in ambienti ibridi (es. H2O.ai). I recenti rapporti trimestrali di Microsoft, ad esempio, mostrano che mentre la crescita generale del cloud pubblico senza considerare l'AI PaaS è solo modesta, la parte del business del cloud pubblico che cresce più rapidamente è l'AI PaaS.

Casi d'uso LLM/SLM:

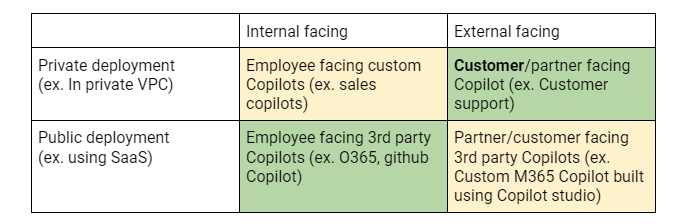

Un riepilogo dei casi d'uso dei clienti in ogni livello può essere visto dalla prospettiva di due dimensioni: L'asse X identifica se uno sforzo/applicazione di AI è rivolto ai dipendenti interni o ai clienti/partner esterni. L'asse Y identifica se la distribuzione dell'applicazione AI è in un'istanza privata (ad esempio su Google/MS AI o AWS Bedrock) o se si tratta di un servizio SaaS di terze parti (come ChatGPT). Questa matrice aiuta a chiarire i rischi per la sicurezza, il movimento acquirente/adottante e i requisiti chiave.

La matrice 2×2 di cui sopra mostra i diversi casi d'uso che guidano l'adozione degli LLM nelle aziende e le priorità di implementazione dei clienti. Le celle verdi indicano gli investimenti/POC attuali. Le celle gialle indicano sviluppi attivi e le celle rosse indicano potenziali investimenti futuri.

Livello 2: I copiloti AI

Se la mindshare è la misura del successo nel livello fondamentale dell'AI, le entrate sono senza dubbio il metro di misura in questo livello. Proprio come nel boom di Internet, i fornitori di infrastrutture Internet (pensiamo ad AT&T) sono stati fondamentali ma non i maggiori beneficiari commerciali della rivoluzione di Internet. Sono state le applicazioni che hanno utilizzato questa infrastruttura internet per creare applicazioni nuove e interessanti, come Google, Uber e Meta, ad essere le maggiori vincitrici. Allo stesso modo, nell'era dell'AI, stanno già emergendo grandi applicazioni di $$ sotto forma di co-piloti AI: come Satya Nadela, CEO di Microsoft, ha dichiarato a Ignite 2023 di essere un'azienda di co-piloti, immaginando un futuro in cui tutto e tutti avranno un co-pilota. Gli studi hanno dimostrato un potenziale guadagno del 30+% nella produttività degli sviluppatori, o un guadagno del 50+% nella produttività dell'elaborazione delle richieste assicurative. Non c'è da stupirsi che Nadela abbia recentemente dichiarato che Copilot è il prodotto della suite M365 di Microsoft con la crescita più rapida. È già diventato un leader assoluto nelle implementazioni aziendali di Copilot. I dati recenti di Skyhigh lo confermano con un aumento del 5000+% nell'uso di M365 Copilot negli ultimi 6 mesi!

E soprattutto è la tecnologia genAI dominante in uso nelle grandi aziende, anche se la penetrazione di M365 Copilot è solo dell'1% del business di M365 - lasciando un enorme spazio di crescita. L'impatto sulle aziende non deve essere sottovalutato: la quantità di dati aziendali indicizzati, così come i dati condivisi con M365 Copilot, è senza precedenti. Quasi tutte le aziende bloccano ChatGPT e quasi tutte consentono anche O365 Co-pilot, che a sua volta utilizza il servizio Azure AI (principalmente OpenAI). Il prezzo aggiuntivo per posto a sedere di M365 per il Copilot sta diventando il modello per tutti i fornitori SaaS per lanciare i propri copilot, generando un flusso di entrate redditizie.

Casi d'uso del copilota:

La matrice 2×2 qui sopra mostra i diversi casi d'uso che guidano l'adozione di Copilot nelle aziende e le priorità di implementazione dei clienti. Le celle verdi indicano gli investimenti/POC attuali. Le celle gialle indicano sviluppi attivi e le celle rosse indicano potenziali investimenti futuri.

Livello 3: i piloti automatici AI

E poi c'è il livello dei piloti automatici AI - sistemi agenziali che eseguono compiti con un intervento umano minimo o nullo. Questo promette di essere il livello che aprirà il settore SI/consulenza, che oggi è manuale, costoso e, secondo alcune stime, è quasi 8-10 volte più grande del settore SaaS/software. Anche se in fase iniziale, questi sistemi agenziali (sistemi progettati per agire come agenti autonomi) promettono di eccellere nell'analisi dei compiti, nella scomposizione dei compiti e nell'esecuzione autonoma dei compiti in risposta agli obiettivi stabiliti [o impliciti] dagli utenti. Questo può potenzialmente eliminare l'uomo nel ciclo. Ci sono molti finanziamenti VC attualmente rivolti a questo spazio. Il 75% delle startup della recente coorte YC sono startup AI che rientrano in questo livello. Proprio la scorsa settimana, Salesforce ha annunciato Agentforce per incrementare la produttività dei dipendenti e Microsoft ha presentato Copilot Agents, inizialmente rivolto alle PMI, che può consentire l'automazione dei processi aziendali, nonché l'estensione di Copilot Studio per supportare agenti personalizzati.

Esistono agenti autonomi per un assistente personale (es. Multion.ai), agenti di supporto (es. Ada.cx, intercom.com), sviluppatori (es. Cognition.ai (devin), Cursor.com, Replit.com), team di vendita (es. Apollo.io, accountstory.com), operazioni di sicurezza (es. AirMDR.com, Prophetsecurity.ai, AgamottoSecurity.com, torq.io), ricercatore UX (es. Altis.io, Maze.co), designer UX (es. DesignPro.ai), integratore di sistemi (es. TechStack.management), project manager (es. Clickup.com), dipendenti del back office finanziario (es. Prajna.ai), o persino un dipendente AI universale (es. ema.co). Alcuni studi indicano che questi sistemi agenziali che automatizzano le azioni potrebbero portare a 1,5T$ di spesa software aggiuntiva, posizionando questo nuovo genere di aziende come la prossima avanguardia di aziende di servizi come software che potrebbero dominare il panorama IT.

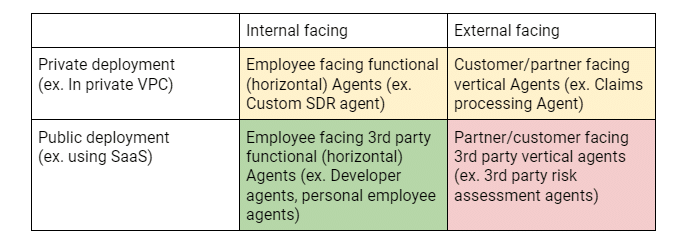

Casi d'uso del pilota automatico:

La matrice 2×2 qui sopra mostra i diversi casi d'uso che guidano l'adozione degli agenti nelle aziende e le priorità di implementazione dei clienti. Le celle verdi indicano gli investimenti/POC attuali. Le celle gialle indicano sviluppi attivi e le celle rosse indicano potenziali investimenti futuri.

Esigenze e opportunità della sicurezza AI

Non sorprende che, dopo la presentazione di ChatGPT appena 2 anni fa, sia diventato di uso comune un nuovo gergo di sicurezza, privacy e governance fino ad allora sconosciuto, come ad esempio: prompt engineering, jailbreaking, allucinazioni, avvelenamento dei dati, ecc. L'industria è stata rapida nell'avvolgere le sue braccia intorno a questi nuovi problemi e ha dato origine ad alcune metriche utilizzate per misurare la propensione di vari LLM a presentare queste caratteristiche. L'Open Worldwide Application Security Project (OWASP) ha fatto un buon lavoro nell'identificare i 10 principali rischi dei LLM, che sono completi e vengono aggiornati attivamente. Inoltre, Enkrypt AI ha fatto un buon lavoro nel creare e mantenere una classifica completa sulla sicurezza degli LLM, che è uno strumento utile per confrontare i punteggi di sicurezza dei principali LLM attraverso le quattro dimensioni di parzialità, tossicità, jailbreak e malware. La stessa analisi può essere effettuata anche per gli LLM personalizzati tramite il loro red-teaming.

Tuttavia, dato il contesto completo dello stack dell'AI, adottare una visione ristretta della sicurezza dell'AI è ingenuo. Ogni livello richiede di considerare questioni distinte per affrontare le sfide uniche imposte da acquirenti potenzialmente diversi. Ad esempio, il red-teaming per identificare i problemi con i modelli in fase di implementazione da parte dei clienti è probabilmente di interesse per il team applicativo, mentre la fuga di dati attraverso i co-piloti o i dati utilizzati per la messa a punto dei modelli potrebbe essere un problema di sicurezza delle informazioni o di CDO.

Nei prossimi blog, approfondirò i rischi per la sicurezza e le soluzioni proposte in ciascuno dei tre livelli descritti.

Altri blog in questa serie:

- Parte 1 - Sicurezza AI: Esigenze e opportunità dei clienti

- Parte 2 - AI fondamentale: un livello critico con sfide di sicurezza

- Parte 3 - Rischi e sfide della sicurezza con i copiloti AI

Contenuti correlati

Blog di tendenza

Attributi LLM che ogni CISO dovrebbe monitorare oggi

Sarang Warudkar 18 febbraio 2026

Dai requisiti DPDPA alla visibilità dei dati: l'imperativo DSPM

Niharika Ray e Sarang Warudkar 12 febbraio 2026

Skyhigh Security 2025: controllo più accurato, visibilità più chiara e azioni più rapide su dati, web e cloud

Thyaga Vasudevan 21 gennaio 2026

Il rischio nascosto della GenAI che potrebbe comportare costi significativi per la vostra azienda (e come risolverlo immediatamente)

Jesse Grindeland 18 dicembre 2025

Skyhigh Security : il 2026 sarà l'anno in cui l'intelligenza artificiale determinerà un nuovo modello di sicurezza aziendale.

Thyaga Vasudevan 12 dicembre 2025