Ressources

Sécurité de l'IA : Besoins des clients et opportunités

Par Sekhar Sarukkai - Cybersecurity@UC Berkeley

28 septembre 2024 6 Lecture minute

Tout indique que l'innovation et l'adoption d'outils et de services d'intelligence artificielle sont en plein essor. Selon les données de Crunchbase, les investissements dans les startups spécialisées dans l'intelligence artificielle (IA) ont atteint 24 milliards de dollars d'avril à juin, soit plus du double du trimestre précédent. 75 % des fondateurs de la dernière cohorte de Y Combinator travaillent sur des startups d'IA et presque tous les fournisseurs de technologie s'emploient à réorganiser leur stratégie pour qu'elle soit centrée sur l'IA.

Dans une étude récente, PWC a constaté que plus de 50 % des entreprises ont déjà adopté la genAI et que 73 % des entreprises américaines ont déjà adopté l'IA dans au moins certains domaines de leurs fonctions commerciales. Ce mois-ci, OpenAI a également annoncé son millionième siège d'entreprise, moins d'un an après le lancement de son produit pour les entreprises.

Avec tous ces investissements et cette innovation viennent les dangers de l'IA et les perspectives sur les plus grandes préoccupations en matière de sécurité, de sûreté, de confidentialité et de gouvernance qui empêcheront les entreprises d'utiliser l'IA en production. Ce blog, le premier d'une série, présente mon point de vue sur les principaux défis de sécurité auxquels est confrontée la pile d'IA, point de vue que j'ai recueilli au cours de l'année écoulée.

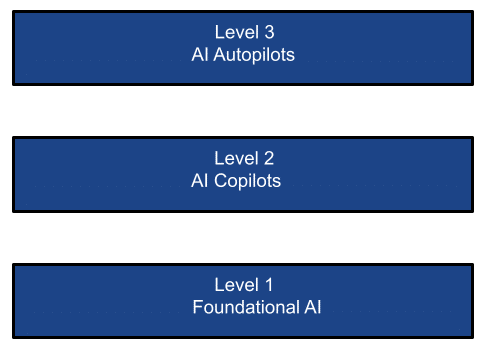

La pile d'IA simplifiée

La prolifération des technologies de l'IA peut être envisagée selon les trois niveaux suivants :

COUCHE 1 : Fondamentaux de l'IA

Les modèles de fondation sont une forme d'intelligence artificielle générative. Ils génèrent des résultats à partir d'invites basées sur le langage humain. Les modèles sont basés sur des réseaux neuronaux complexes, notamment des réseaux adversaires génératifs, des transformateurs et des encodeurs variationnels. Le rythme de l'innovation dans le domaine de l'IA fondamentale a été époustouflant, avec des versions qui changent la donne, dont la plus récente est le GPT-4o et son modèle multimodal. Les grandes entreprises ont investi beaucoup d'argent à ce niveau, choisissant par essence les gagnants de cette couche d'infrastructure de base de l'IA.

Cette couche comprend deux types d'infrastructures :

- Les modèles de fondation sont dominés par OpenAI, Google Gemini, Mistral, Grok, Llama et Anthropic. Ces modèles (open-source ou close-source) sont entraînés sur un énorme corpus de données (publiques ou privées). Les modèles peuvent être utilisés pour l'inférence en tant que SaaS (comme ChatGPT), PaaS (comme AWS Bedrock, Azure/Google AI platforms) ou déployés dans des instances privées. Ces entreprises de modèles de base représentent à elles seules près de 50 % des activités de Nvidia dans le domaine des puces d'IA.

- Des modèles personnalisés, dont des milliers peuvent être trouvés sur une place de marché telle que Hugging Face. Ces modèles sont entraînés sur des ensembles de données spécialisés (publics ou privés) pour des cas d'utilisation ciblés ou des secteurs verticaux. Ils peuvent également être consommés en tant que services SaaS ou PaaS, ou en les déployant dans des instances privées. En outre, les entreprises peuvent choisir de créer et de déployer leurs propres modèles affinés dans leurs centres de données privés, dans le Cloud privé ou dans des environnements hybrides (ex. H2O.ai). Les récents rapports trimestriels de Microsoft, par exemple, montrent que si la croissance générale du cloud public sans tenir compte de l'AI PaaS n'est que modeste, la partie de l'activité du cloud public qui connaît la croissance la plus rapide est l'AI PaaS.

Cas d'utilisation du LLM/SLM :

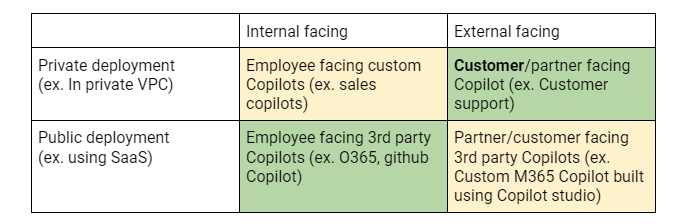

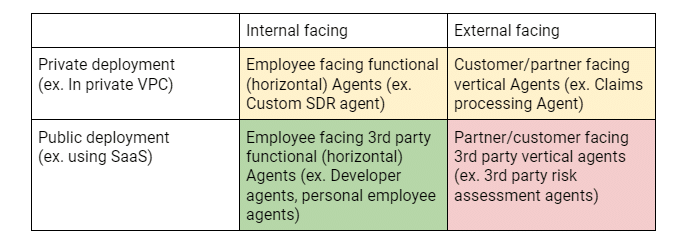

Un résumé des cas d'utilisation des clients dans chaque couche peut être vu du point de vue de deux dimensions : L'axe X qui identifie si un effort/une application d'IA est destiné(e) aux employés internes ou aux clients/partenaires externes. L'axe Y indique si le déploiement de l'application d'IA se fait dans une instance privée (par exemple sur Google/MS AI ou AWS Bedrock) ou s'il s'agit d'un service SaaS tiers (tel que ChatGPT). Cette matrice permet de clarifier les risques de sécurité, le mouvement des acheteurs/adoptants et les exigences clés.

La matrice 2×2 ci-dessus montre les différents cas d'utilisation qui conduisent à l'adoption des LLM dans les entreprises et les priorités de déploiement des clients. Les cellules vertes indiquent les investissements/POC actuels. Les cellules jaunes indiquent les développements actifs et les cellules rouges indiquent les investissements potentiels futurs.

Couche 2 : Les copilotes de l'IA

Si le partage de l'esprit est la mesure du succès au niveau de la couche fondamentale de l'IA, le chiffre d'affaires est sans aucun doute l'étalon de mesure de cette couche. Tout comme lors du boom de l'internet, les fournisseurs d'infrastructures internet (pensez à AT&T) ont été des bénéficiaires essentiels de la révolution de l'internet, mais pas les plus importants. Ce sont les applications qui ont utilisé cette infrastructure internet pour créer des applications nouvelles et intéressantes telles que Google, Uber et Meta qui ont été les plus grands gagnants. De même, à l'ère de l'IA, des applications à forte valeur ajoutée apparaissent déjà sous la forme de copilotes d'IA : Satya Nadela, PDG de Microsoft, a proclamé à Ignite 2023 que l'entreprise était une société de copilote, envisageant un avenir où tout et tout le monde aura un copilote. Des études ont montré un gain potentiel de plus de 30 % dans la productivité des développeurs, ou de plus de 50 % dans la productivité du traitement des demandes d'indemnisation des compagnies d'assurance. Il n'est pas étonnant que Nadela ait récemment déclaré que Copilot est le produit de la suite M365 de Microsoft qui connaît la plus forte croissance. Il est déjà devenu un leader incontesté dans les déploiements de co-pilotes d'entreprise. Les données récentes de Skyhigh le confirment avec une augmentation de plus de 5000% de l'utilisation de M365 Copilot au cours des 6 derniers mois !

Plus important encore, il s'agit de la technologie genAI dominante utilisée par les grandes entreprises, même si la pénétration de M365 Copilot ne représente que 1 % des activités de M365, ce qui laisse une énorme marge de croissance. L'impact sur les entreprises ne doit pas être sous-estimé - la quantité de données d'entreprise indexées, ainsi que les données partagées avec M365 Copilot sont sans précédent. Presque toutes les entreprises bloquent ChatGPT et presque toutes autorisent également O365 Co-pilot qui, à son tour, utilise le service Azure AI (principalement OpenAI). La tarification supplémentaire par siège de M365 pour le Copilot est en passe de devenir le modèle pour tous les fournisseurs de SaaS qui déploieront leurs propres copilotes, générant ainsi un flux de revenus lucratifs.

Cas d'utilisation du copilote :

La matrice 2×2 ci-dessus montre les différents cas d'utilisation qui conduisent à l'adoption des copilotes dans les entreprises et les priorités de déploiement des clients. Les cellules vertes indiquent les investissements/POC actuels. Les cellules jaunes indiquent les développements actifs et les cellules rouges indiquent les investissements potentiels futurs.

Couche 3 : Les pilotes automatiques de l'IA

Et puis il y a la couche des pilotes automatiques de l'IA - des systèmes agentiques qui exécutent des tâches avec peu ou pas d'intervention humaine. Cette couche promet d'être celle qui ouvrira le marché des services d'information et de conseil, qui est aujourd'hui manuel, coûteux et, selon certaines estimations, 8 à 10 fois plus important que le marché des logiciels SaaS. Bien que précoces, ces systèmes agentiques (systèmes conçus pour agir comme des agents autonomes) promettent d'exceller dans l'analyse et la décomposition des tâches, ainsi que dans l'exécution autonome des tâches en réponse aux objectifs fixés [ou sous-entendus] par les utilisateurs. Cela peut potentiellement éliminer l'humain dans la boucle. De nombreux fonds de capital-risque sont actuellement consacrés à cet espace. Une grande partie des 75 % de startups de la récente cohorte YC sont des startups d'IA qui se situent dans cette couche. La semaine dernière, Salesforce a annoncé son Agentforce pour stimuler la productivité des employés et Microsoft a présenté Copilot Agents, initialement destiné aux PME, qui peut permettre l'automatisation des processus d'entreprise, ainsi que l'extension de leur Copilot Studio pour prendre en charge des agents personnalisés.

Il existe des agents autonomes pour un assistant personnel (ex. Multion.ai), des agents de support (ex. Ada.cx, intercom.com), des développeurs (ex. Cognition.ai (devin), Cursor.com, Replit.com), une équipe de vente (ex. Apollo.io, accountstory.com), des opérations de sécurité (ex. AirMDR.com, Prophetsecurity.ai, AgamottoSecurity.com, torq.io), chercheur UX (ex. Altis.io, Maze.co), concepteur UX (ex. DesignPro.ai), intégrateur de systèmes (ex. TechStack.management), chef de projet (ex. Clickup.com), employés du back-office financier (ex. Prajna.ai), ou même employé de l'IA universelle (ex. ema.co). Certaines études indiquent que ces systèmes agentiques qui automatisent les actions pourraient entraîner des dépenses supplémentaires de 1,5 billion de dollars en logiciels, ce qui place ces entreprises d'un nouveau genre à l'avant-garde des sociétés de services en tant que logiciels qui pourraient dominer le paysage des technologies de l'information.

Cas d'utilisation du pilotage automatique :

La matrice 2×2 ci-dessus montre les différents cas d'utilisation qui conduisent à l'adoption d'agents dans les entreprises et les priorités de déploiement des clients. Les cellules vertes indiquent les investissements/POC actuels. Les cellules jaunes indiquent les développements actifs et les cellules rouges indiquent les investissements potentiels futurs.

Besoins et opportunités en matière de sécurité de l'IA

Il n'est pas surprenant que, depuis le dévoilement de ChatGPT il y a tout juste deux ans, un nouveau jargon jusqu'alors inconnu en matière de sécurité, de protection de la vie privée et de gouvernance soit devenu courant, comme : l'ingénierie prompte, le jailbreaking, les hallucinations, l'empoisonnement des données, etc. L'industrie s'est rapidement penchée sur ces nouvelles questions, ce qui a donné lieu à l'élaboration de mesures permettant d'évaluer la propension de divers LLM à présenter ces caractéristiques. L'Open Worldwide Application Security Project (OWASP) a fait du bon travail en identifiant les 10 principaux risques liés aux LLM, qui sont complets et activement mis à jour. En outre, Enkrypt AI a fait du bon travail en créant et en maintenant un classement complet de la sécurité des LLM, qui est un outil pratique pour comparer les scores de sécurité des principaux LLM sur quatre dimensions : partialité, toxicité, jailbreak et logiciels malveillants. La même analyse peut également être effectuée pour les LLM personnalisés via leur red-teaming.

Toutefois, compte tenu du contexte global de la pile d'IA, il est naïf d'adopter une vision étroite de la sécurité de l'IA. Chaque couche nécessite la prise en compte de questions distinctes afin de relever les défis uniques imposés par des acheteurs potentiellement différents. Par exemple, le red-teaming pour identifier les problèmes avec les modèles déployés par les clients est susceptible d'intéresser l'équipe d'application, tandis que la fuite de données via les co-pilotes ou les données utilisées pour affiner les modèles pourrait être une préoccupation de sécurité de l'information ou de CDO.

Dans les prochains blogs, j'approfondirai les risques de sécurité et les solutions proposées pour chacune des trois couches décrites.

Autres blogs dans cette série :

- Partie 1 - Sécurité de l'IA : Besoins des clients et opportunités

- Partie 2 - L'IA fondamentale : une couche critique avec des défis en matière de sécurité

- Partie 3 - Risques et défis en matière de sécurité avec les copilotes IA

Contenu connexe

Des exigences de la DPDPA à la visibilité des données : l'importance du DSPM

Blogs en vogue

Les attributs LLM que tout RSSI devrait surveiller actuellement

Sarang Warudkar 18 février 2026

Des exigences de la DPDPA à la visibilité des données : l'importance du DSPM

Niharika Ray et Sarang Warudkar 12 février 2026

Skyhigh Security 2025 : contrôle plus précis, visibilité plus claire et action plus rapide sur les données, le Web et le cloud

Thyaga Vasudevan 21 janvier 2026

Le risque caché de l'IA générique qui pourrait coûter des millions à votre entreprise (et comment y remédier dès aujourd'hui)

Jesse Grindeland 18 décembre 2025

Skyhigh Security : 2026 sera l'année où l'IA imposera un nouveau modèle pour la sécurité des entreprises

Thyaga Vasudevan 12 décembre 2025