Ressourcen

KI-Sicherheit: Kundenbedürfnisse und Chancen

Von Sekhar Sarukkai - Cybersecurity@UC Berkeley

September 28, 2024 6 Minute gelesen

Alle Anzeichen in der Branche deuten auf ein rasantes Wachstum bei der Innovation und Einführung von KI-Tools und -Dienstleistungen hin. Laut Daten von Crunchbase stiegen die Investitionen in Startups im Bereich der künstlichen Intelligenz (KI) von April bis Juni auf 24 Milliarden Dollar und haben sich damit gegenüber dem Vorquartal mehr als verdoppelt. 75 % der Gründer der jüngsten Y Combinator-Kohorte arbeiten an KI-Startups, und fast alle Technologieanbieter sind dabei, ihre Strategie zu überarbeiten, um sich auf KI zu konzentrieren.

In einer kürzlich durchgeführten Umfrage stellte PWC fest, dass mehr als 50 % der Unternehmen bereits genAI einsetzen und 73 % der US-Unternehmen zumindest in einigen Bereichen ihrer Geschäftsfunktionen bereits KI einsetzen. Erst diesen Monat meldete OpenAI außerdem den 1-millionsten Unternehmenssitz - weniger als ein Jahr nach der Veröffentlichung des Unternehmensprodukts.

Mit all diesen Investitionen und Innovationen kommen auch die Gefahren der KI und die Ansichten über die größten Sicherheits-, Schutz-, Datenschutz- und Governance-Probleme, die Unternehmen davon abhalten werden, KI in der Produktion einzusetzen. Dieser Blog, der erste einer Reihe, fasst meine Sicht der wichtigsten Sicherheitsherausforderungen für diesen KI-Stack zusammen, die ich im Laufe des letzten Jahres gesammelt habe.

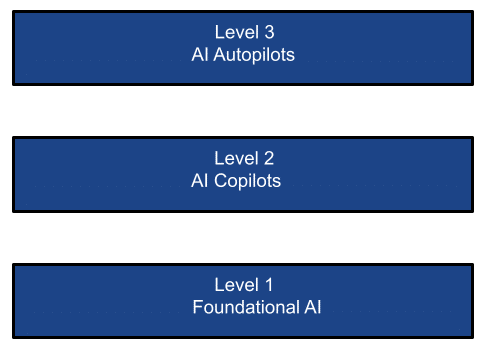

Der vereinfachte KI-Stapel

Die Verbreitung von KI-Technologien kann auf den folgenden drei Ebenen betrachtet werden:

LAYER 1: Grundlegende KI

Foundation-Modelle sind eine Form der generativen künstlichen Intelligenz. Sie generieren Ausgaben auf der Grundlage menschlicher Spracheingaben. Die Modelle basieren auf komplexen neuronalen Netzen, einschließlich generativer adversarischer Netze, Transformatoren und Variationskodierer. Das Innovationstempo im Bereich der künstlichen Intelligenz war atemberaubend, mit bahnbrechenden Neuerungen, zuletzt mit GPT-4o und seinem multimodalen Modell. Das große Geld hat viel Geld in diese Ebene gepumpt und im Wesentlichen die Gewinner in dieser zentralen KI-Infrastrukturebene ausgewählt.

Es gibt zwei Arten von Infrastruktur in dieser Schicht:

- Foundation-Modelle wie OpenAI, Google Gemini, Mistral, Grok, Llama und Anthropic dominieren. Diese Modelle (open-source oder close-source) werden auf einem riesigen Datenkorpus (öffentlich oder privat) trainiert. Die Modelle können als SaaS (z.B. ChatGPT), PaaS (z.B. AWS Bedrock, Azure/Google AI-Plattformen) oder in privaten Instanzen für die Inferenz genutzt werden. Allein diese Foundation Model-Unternehmen machen fast 50% des KI-Chip-Geschäfts von Nvidia aus.

- Benutzerdefinierte Modelle, von denen Sie Tausende auf einem Marktplatz wie Hugging Face finden können. Diese Modelle werden auf speziellen Datensätzen (öffentlich oder privat) für bestimmte Anwendungsfälle oder Branchen trainiert. Sie können auch als SaaS- oder PaaS-Services genutzt oder in privaten Instanzen eingesetzt werden. Darüber hinaus können Unternehmen ihre eigenen fein abgestimmten Modelle in ihren privaten Rechenzentren, in der privaten Cloud oder in hybriden Umgebungen (z.B. H2O.ai) erstellen und einsetzen. Aus den jüngsten Quartalsberichten von Microsoft geht beispielsweise hervor, dass das allgemeine Wachstum der Public Cloud ohne Berücksichtigung von KI-PaaS nur bescheiden ausfällt, der am schnellsten wachsende Teil des Public Cloud-Geschäfts aber KI-PaaS ist.

LLM/SLM Anwendungsfälle:

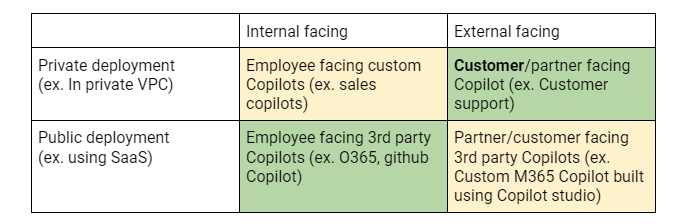

Eine Zusammenfassung der Kundenanwendungsfälle in jeder Ebene kann aus der Perspektive von zwei Dimensionen betrachtet werden: Die X-Achse gibt an, ob eine KI-Anwendung auf interne Mitarbeiter oder externe Kunden/Partner ausgerichtet ist. Die Y-Achse gibt an, ob die KI-Anwendung in einer privaten Instanz (z.B. auf Google/MS AI oder AWS Bedrock) oder als SaaS-Dienst eines Drittanbieters (wie ChatGPT) bereitgestellt wird. Diese Matrix hilft bei der Klärung von Sicherheitsrisiken, der Bewegung von Käufern/Adoptern und den wichtigsten Anforderungen.

Die obige 2×2-Matrix zeigt die verschiedenen Anwendungsfälle, die die Einführung von LLMs in Unternehmen vorantreiben, sowie die Prioritäten der Kunden beim Einsatz. Grüne Zellen zeigen aktuelle Investitionen/POCs an. Gelbe Zellen stehen für aktive Entwicklungen und rote Zellen für potenzielle zukünftige Investitionen.

Ebene 2: Die KI-Co-Piloten

Wenn Mindshare das Maß für den Erfolg auf der grundlegenden KI-Ebene ist, dann ist der Umsatz zweifellos der Maßstab auf dieser Ebene. Genau wie beim Internet-Boom waren die Anbieter von Internet-Infrastruktur (denken Sie an AT&T) entscheidend, aber nicht die größten Nutznießer der Internet-Revolution. Es waren die Anwendungen, die diese Internet-Infrastruktur nutzten, um neue und interessante Anwendungen wie Google, Uber und Meta zu entwickeln, die die größeren Gewinner waren. In ähnlicher Weise entstehen in der KI-Ära bereits große $$-Anwendungen in Form von KI-Co-Piloten: Satya Nadela, der CEO von Microsoft, erklärte auf der Ignite 2023, dass Microsoft ein Co-Pilot-Unternehmen sei und sich eine Zukunft vorstellt, in der alles und jeder einen Co-Piloten haben wird. Studien haben gezeigt, dass die Produktivität von Entwicklern um mehr als 30 % und die Produktivität bei der Bearbeitung von Versicherungsansprüchen bereits um mehr als 50 % gesteigert werden kann. Kein Wunder, dass Nadela kürzlich erklärte, Copilot sei das am schnellsten wachsende Produkt der Microsoft M365 Suite. Es hat sich bereits zu einem unangefochtenen Marktführer bei der Bereitstellung von Copilot in Unternehmen entwickelt. Die jüngsten Daten von Skyhigh bestätigen dies mit einem Anstieg der Nutzung von M365 Copilot um 5000+% in den letzten 6 Monaten!

Noch wichtiger ist, dass es sich um die dominierende genAI-Technologie handelt, die in großen Unternehmen eingesetzt wird, obwohl M365 Copilot nur 1 % des M365-Geschäfts ausmacht - das lässt noch viel Spielraum für Wachstum. Die Auswirkungen auf Unternehmen sollten nicht unterschätzt werden - die Menge an Unternehmensdaten, die indiziert werden, sowie die Daten, die mit M365 Copilot geteilt werden, sind beispiellos. Fast alle Unternehmen blockieren ChatGPT und fast alle erlauben auch O365 Co-pilot, der wiederum den Azure AI Service (hauptsächlich OpenAI) nutzt. Der M365 Zusatzpreis pro Sitzplatz für den Copilot entwickelt sich zu einem Modell für alle SaaS-Anbieter, die ihre eigenen Co-Piloten einführen und damit eine lukrative Einnahmequelle generieren wollen.

Co-Pilot Anwendungsfälle:

Die obige 2×2-Matrix zeigt die verschiedenen Anwendungsfälle, die den Einsatz von Copiloten in Unternehmen vorantreiben, und die Prioritäten der Kunden bei der Einführung. Grüne Zellen zeigen aktuelle Investitionen/POCs an. Gelbe Zellen stehen für aktive Entwicklungen und rote Zellen für potenzielle zukünftige Investitionen.

Ebene 3: Die KI-Autopiloten

Und dann gibt es noch die KI-Autopiloten-Ebene - agentengesteuerte Systeme, die Aufgaben mit wenig bis gar keinem menschlichen Eingriff ausführen. Dies verspricht die Ebene zu sein, die das SI-/Beratungsgeschäft aufbrechen wird, das heute manuell und teuer ist und nach einigen Schätzungen fast 8-10 Mal so groß ist wie das SaaS-/Softwaregeschäft. Diese agentenbasierten Systeme (Systeme, die als autonome Agenten agieren sollen) befinden sich zwar noch im Anfangsstadium, versprechen aber, sich bei der Aufgabenanalyse, der Aufschlüsselung von Aufgaben und der autonomen Ausführung von Aufgaben als Reaktion auf die von den Benutzern gesetzten [oder implizierten] Ziele auszuzeichnen. Dadurch kann der Mensch in der Schleife möglicherweise überflüssig werden. Derzeit gibt es viele VC-Finanzierungen, die auf diesen Bereich abzielen. Viele der 75% der Startups in der jüngsten YC-Kohorte sind KI-Startups, die in diese Schicht fallen. Erst letzte Woche kündigte Salesforce sein Agentforce an , um die Produktivität der Mitarbeiter zu steigern, und Microsoft stellte Copilot Agents vor, die sich zunächst an kleine und mittlere Unternehmen richten und die Automatisierung von Geschäftsprozessen ermöglichen, sowie eine Erweiterung des Copilot Studio, um benutzerdefinierte Agents zu unterstützen.

Es gibt autonome Agenten für einen persönlichen Assistenten (z.B. Multion.ai), Support-Agenten (z.B. Ada.cx, intercom.com), Entwickler (z.B. Cognition.ai (devin), Cursor.com, Replit.com), Vertriebsteam (z.B. Apollo.io, accountstory.com), Sicherheitsdienste (z.B. AirMDR.com, Prophetsecurity.ai, AgamottoSecurity.com, torq.io), UX-Forscher (z.B. Altis.io, Maze.co), UX-Designer (z.B. DesignPro.ai), Systemintegrator (z.B. TechStack.management), Projektmanager (z.B. Clickup.com), Mitarbeiter des Finanz-Backoffice (z.B. Prajna.ai) oder sogar ein universeller KI-Mitarbeiter (z.B. ema.co). Einige Studien deuten darauf hin, dass solche agentenbasierten Systeme, die Handlungen automatisieren, zu zusätzlichen Softwareausgaben in Höhe von 1,5 Billionen Dollar führen könnten, was diese neue Art von Unternehmen zur nächsten Vorhut von Service-als-Software-Unternehmen macht, die die IT-Landschaft dominieren könnten.

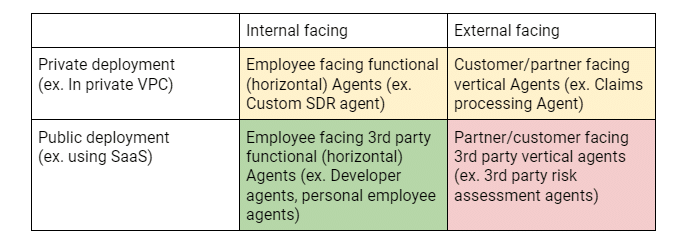

Autopilot Anwendungsfälle:

Die obige 2×2-Matrix zeigt die verschiedenen Anwendungsfälle, die die Einführung von Agenten in Unternehmen vorantreiben, sowie die Prioritäten der Kunden beim Einsatz. Grüne Zellen zeigen aktuelle Investitionen/POCs an. Gelbe Zellen stehen für aktive Entwicklungen und rote Zellen für potenzielle zukünftige Investitionen.

KI-Sicherheitsbedürfnisse und -chancen

Es überrascht nicht, dass seit der Enthüllung von ChatGPT vor gerade einmal 2 Jahren neue, bis dahin unbekannte Begriffe wie Prompt Engineering, Jailbreaking, Halluzinationen, Data Poisoning usw. zum Mainstream geworden sind. Die Branche hat sich schnell auf diese neuen Themen eingestellt und hat einige Messgrößen entwickelt, mit denen die Neigung verschiedener LLMs, diese Eigenschaften zu zeigen, gemessen werden kann. Das Open Worldwide Application Security Project (OWASP) hat gute Arbeit bei der Identifizierung der 10 größten LLM-Risiken geleistet, die umfassend sind und aktiv aktualisiert werden. Darüber hinaus hat Enkrypt AI gute Arbeit bei der Erstellung und Pflege einer umfassenden LLM-Sicherheitsrangliste geleistet, die ein praktisches Tool ist, um die Sicherheitswerte führender LLMs in den vier Dimensionen Verzerrung, Toxizität, Jailbreak und Malware zu vergleichen. Die gleiche Analyse kann auch für benutzerdefinierte LLMs über deren Red-Teaming durchgeführt werden.

Angesichts des gesamten Kontexts des KI-Stacks ist es jedoch naiv, die KI-Sicherheit aus einem engen Blickwinkel zu betrachten. Auf jeder Ebene müssen unterschiedliche Aspekte berücksichtigt werden, um die einzigartigen Herausforderungen zu bewältigen, die von potenziell unterschiedlichen Käufern auferlegt werden. So ist beispielsweise das Red-Teaming zur Identifizierung von Problemen mit Modellen, die von Kunden eingesetzt werden, wahrscheinlich für das Anwendungsteam von Interesse, während Datenlecks über Co-Piloten oder Daten, die zur Feinabstimmung von Modellen verwendet werden, ein Problem der Informationssicherheit oder des CDO darstellen könnten.

In den nächsten Blogs werde ich tiefer in die Sicherheitsrisiken und Lösungsvorschläge für jede der drei beschriebenen Schichten eintauchen.

Andere Blogs in dieser Serie:

- Teil 1 - KI-Sicherheit: Kundenbedürfnisse und Chancen

- Teil 2 - Grundlegende KI: Eine kritische Schicht mit Sicherheitsherausforderungen

- Teil 3 - Sicherheitsrisiken und Herausforderungen mit KI-Kopiloten

Verwandter Inhalt

Von den DPDPA-Anforderungen bis zur Datentransparenz: Die Notwendigkeit von DSPM

Laufende Blogs

LLM-Attribute, die jeder CISO heute im Blick behalten sollte

Sarang Warudkar 18. Februar 2026

Von den DPDPA-Anforderungen bis zur Datentransparenz: Die Notwendigkeit von DSPM

Niharika Ray und Sarang Warudkar 12. Februar 2026

Skyhigh Security 2025: Präzisere Kontrolle, klarere Transparenz und schnellere Maßnahmen für Daten, Web und Cloud

Thyaga Vasudevan 21. Januar 2026

Das versteckte Risiko von GenAI, das Ihr Unternehmen Millionen kosten könnte (und wie Sie es heute beheben können)

Jesse Grindeland 18. Dezember 2025

Skyhigh Security : 2026 ist das Jahr, in dem künstliche Intelligenz einen neuen Entwurf für die Unternehmenssicherheit vorantreibt.

Thyaga Vasudevan 12. Dezember 2025