ทรัพยากร

ข่าวกรองย่อย

บอตถูกจับ: ข้อมูลที่ถูกกล่าวหาว่ารั่วไหลจาก AI ChatBot

รายงานการรั่วไหลของข้อมูลจาก Chatbot ที่ขับเคลื่อนด้วย AI ยอดนิยมคุกคาม

โดย Rodman Ramezanian - Enterprise Cloud Security Advisor

24 กุมภาพันธ์ 2568 อ่าน 7 นาที

แชทบอทที่ขับเคลื่อนด้วย AI ได้ผสานรวมเข้ากับแทบทุกแง่มุมของชีวิตเราได้อย่างราบรื่น ไม่ว่าจะเป็นการตอบคำถามและช่วยเหลือฝ่ายบริการลูกค้า ไปจนถึงการจัดการงานส่วนตัวและการทำธุรกรรม ด้วยความสามารถในการโต้ตอบแบบทันทีและปรับแต่งได้ เราจึงสามารถแบ่งปันข้อมูลที่ละเอียดอ่อนได้อย่างอิสระโดยมักจะไม่ต้องคิดซ้ำสอง อย่างไรก็ตาม เมื่อบริการแชทบอทประสบปัญหาการรั่วไหลของข้อมูล ไม่เพียงแต่จะกระทบต่อความเป็นส่วนตัวของแต่ละบุคคลเท่านั้น แต่ยังส่งผลกระทบต่อความไว้วางใจที่ผู้ใช้มีต่อเทคโนโลยีเหล่านี้ด้วย ปริมาณมหาศาลของข้อมูลส่วนตัว การเงิน และการสนทนาที่แลกเปลี่ยนกับระบบ AI เหล่านี้หมายความว่าการละเมิดอาจส่งผลกระทบในวงกว้าง ส่งผลต่อทุกอย่างตั้งแต่ความปลอดภัยส่วนบุคคลไปจนถึงความน่าเชื่อถือของบริการ AI ที่เราเคยพึ่งพา

รายงานระบุว่าแฮกเกอร์อ้างว่าสามารถแทรกซึมเข้าไปใน OmniGPT ซึ่งเป็นแชทบอทและแพลตฟอร์มด้านการผลิตที่ใช้กันอย่างแพร่หลายในด้าน AI ตามข้อมูลที่โพสต์บน Breach Forums ที่มีชื่อเสียง การละเมิดดังกล่าวทำให้ข้อมูลส่วนตัวของผู้ใช้ 30,000 รายถูกเปิดเผย รวมถึงอีเมล หมายเลขโทรศัพท์ และบันทึกการสนทนามากกว่า 34 ล้านบรรทัด นอกจากการแชทของผู้ใช้แล้ว ข้อมูลที่เปิดเผยยังรวมถึงลิงก์ไปยังไฟล์ที่อัปโหลด ซึ่งบางไฟล์มีข้อมูลที่ละเอียดอ่อน เช่น ข้อมูลประจำตัว รายละเอียดการเรียกเก็บเงิน และคีย์ API

ความจริงแล้ว เป็นเรื่องยากที่จะไม่รู้สึกวิตกกังวลแม้แต่น้อยเมื่อบริการแชทบอท AI เผชิญกับการรั่วไหลของข้อมูล โดยเฉพาะอย่างยิ่งเมื่อพิจารณาว่าเครื่องมือเหล่านี้ได้รับความนิยมอย่างรวดเร็วเพียงใด เราพึ่งพาเครื่องมือเหล่านี้เพื่อความสามารถต่างๆ ตั้งแต่การเขียนเชิงสร้างสรรค์และการระดมความคิด ไปจนถึงการวิจัยและแม้แต่การทำให้ธุรกิจเป็นระบบอัตโนมัติ

ทําไมเหตุการณ์เหล่านี้จึงเกิดขึ้น?

ความสามารถในการเข้าถึงและความสะดวกสบายของแชทบอทที่ขับเคลื่อนด้วย AI และบริการด้านความคิดสร้างสรรค์ทำให้แชทบอทเหล่านี้กลายมาเป็นส่วนสำคัญในชีวิตประจำวันของเรา แต่สิ่งที่น่ากังวลที่สุดก็คือการละเมิดเกิดขึ้นที่แบ็กเอนด์ของบริการ ซึ่งหมายความว่าผู้ใช้หรือผู้บริโภคไม่สามารถทำอะไรได้เพื่อป้องกันสิ่งนี้

มีแนวโน้มทั่วไปที่จะใช้แชทบ็อต AI เป็นพื้นที่เก็บข้อมูลชั่วคราวสำหรับข้อมูลทุกประเภท อย่างไรก็ตาม ในความเป็นจริง แพลตฟอร์มเหล่านี้ทำงานเหมือน "กล่องดำ" ซึ่งผู้ใช้แทบจะไม่มีข้อมูลเชิงลึกว่าข้อมูลของตนได้รับการจัดการ จัดเก็บ หรือป้องกันอย่างไร การแยกออกจากกันระหว่างการรับรู้และความเป็นจริงอาจส่งผลร้ายแรงเมื่อข้อมูลที่ละเอียดอ่อน เช่น เอกสารที่อัปโหลด คีย์ API และรายละเอียดส่วนบุคคล รั่วไหลออกไป ดังที่เห็นในกรณีนี้

การฝึกอบรมความตระหนักด้านความปลอดภัยอย่างต่อเนื่องสำหรับผู้ใช้ก็มีความสำคัญไม่แพ้กัน หลายคนอาจยังไม่ทราบถึงความเสี่ยงที่เกี่ยวข้องกับการป้อนข้อมูลที่ละเอียดอ่อนลงในบริการแชทบอท AI หรือแพลตฟอร์มคลาวด์ การให้ความรู้แก่ผู้ใช้เกี่ยวกับการใช้ข้อมูลในทางที่ผิดและเน้นย้ำถึงความระมัดระวังเมื่อแบ่งปันข้อมูลส่วนบุคคลหรือข้อมูลลับอาจช่วยลดความเสี่ยงได้มาก

เสน่ห์ของบริการที่ทรงประสิทธิภาพและมักไม่เสียค่าใช้จ่ายซึ่งเสริมด้วย AI จะเติบโตขึ้นเรื่อยๆ ทำให้แนวทางการรักษาความปลอดภัยแบบ “ตีตัวตุ่น” แบบดั้งเดิมกลายเป็นเรื่องไร้ประโยชน์มากขึ้นเรื่อยๆ ด้วยบริการ AI ใหม่หลายร้อย (หรืออาจถึงหลายพัน) ที่เกิดขึ้นทุกสัปดาห์ ทีมงานด้านความปลอดภัยทางไซเบอร์จึงต้องทำงานหนักอยู่แล้วและไม่สามารถตามทันได้

“ช่วงนี้เรามีเวลาว่างเยอะมาก” – ไม่มีทีมงานด้านความปลอดภัยทางไซเบอร์คนใดเคยพูดแบบนี้มาก่อน!

แทนที่จะไล่ตามเครื่องมือ AI ทุกตัว ควรเน้นที่ความเสี่ยงพื้นฐานแทน ซึ่งหมายถึงการให้ความสำคัญกับการปกป้องข้อมูลที่ละเอียดอ่อน โดยไม่คำนึงถึงบริการที่แชร์ด้วย ไม่ว่าจะเป็นแพลตฟอร์ม AI ที่ถูกกฎหมายหรือทรัพยากร IT ที่เป็นเงา การจำกัดการโต้ตอบข้อมูลและการนำมาตรการรักษาความปลอดภัยที่แข็งแกร่งมาใช้จะพิสูจน์ได้ว่ามีประสิทธิภาพมากกว่าการพยายามควบคุมเครื่องมือ AI ที่ขยายตัวอย่างต่อเนื่อง เหตุการณ์ที่เกิดขึ้นล่าสุดแสดงให้เห็นว่าแม้แต่บริการที่ดูแข็งแกร่งก็อาจกลายเป็นเป้าหมายของผู้ก่อภัยคุกคามที่ซับซ้อนได้

สิ่งที่สามารถทําได้?

AI ถือเป็นการปฏิวัติวงการอุตสาหกรรมและชีวิตประจำวันอย่างไม่ต้องสงสัย อย่างไรก็ตาม หากมองในเชิงเทคนิคแล้ว บริการ AI โดยเฉพาะบริการที่เข้าถึงได้ผ่านเว็บและคลาวด์นั้นโดยพื้นฐานแล้วเป็นเพียงเว็บไซต์หรือแพลตฟอร์มคลาวด์ แม้ว่าเทคโนโลยีพื้นฐานของ AI จะทรงพลังและสร้างสรรค์อย่างน่าทึ่ง แต่หากมองในมุมมองด้านความปลอดภัยทางไซเบอร์แล้ว AI ถือเป็นอีกช่องทางหนึ่งที่อาจเกิดการรั่วไหลของข้อมูลและการเข้าถึงโดยไม่ได้รับอนุญาต สำหรับผู้เชี่ยวชาญด้านความปลอดภัยที่มีหน้าที่ปกป้องข้อมูลสำคัญขององค์กร เช่น บันทึกของพลเมือง ข้อมูลส่วนบุคคล และรหัสต้นฉบับ บริการ AI จะต้องได้รับการพิจารณาผ่านมุมมองของไอทีเงา

แม้ว่า AI จะขับเคลื่อนประสิทธิภาพและนวัตกรรม แต่ AI ยังสร้างความท้าทาย เช่น การละเมิดข้อมูล การละเมิดข้อกำหนด และการใช้ AI ในทางที่ผิด การนำ AI มาใช้อย่างรวดเร็ว มักจะแซงหน้าการกำกับดูแล ทำให้องค์กรเสี่ยงต่อความเสี่ยงด้านชื่อเสียง การเงิน และกฎหมาย หากไม่มีมาตรการรักษาความปลอดภัยที่เหมาะสม

ตามคำจำกัดความ Shadow IT หมายความถึงบริการใดๆ ที่ไม่ได้รับการอนุมัติหรืออนุญาตอย่างชัดเจนสำหรับการใช้งานขององค์กรและธุรกรรมข้อมูล เมื่อพิจารณาบริการ AI เป็น Shadow IT ความเสี่ยงที่เกี่ยวข้องจะชัดเจนขึ้น คุณจะยอมให้มีการป้อนข้อมูลลูกค้าที่ละเอียดอ่อนลงในเว็บไซต์ที่ไม่ได้รับอนุมัติหรือไม่ คุณจะยอมให้มีการอัปโหลดไฟล์แนบที่เป็นความลับไปยังบริการคลาวด์ที่ไม่รู้จักหรือไม่ คุณจะยอมให้พนักงานใช้แพลตฟอร์มที่โฮสต์ในเขตอำนาจศาลที่มีแนวทางปฏิบัติด้านการปกป้องข้อมูลที่น่าสงสัยหรือไม่ คำตอบสำหรับคำถามทั้งหมดเหล่านี้ควรเป็นคำตอบว่าไม่

การปฏิบัติต่อบริการ AI ในลักษณะเงาของ IT บังคับให้ต้องเปลี่ยนมุมมองอย่างจำเป็น แทนที่จะปล่อยให้ความสามารถของเทคโนโลยีมาทำให้สับสน องค์กรต่างๆ ต้องใช้มาตรฐานความปลอดภัยที่เข้มงวดเช่นเดียวกับที่ใช้กับบริการที่ไม่ได้รับอนุญาตอื่นๆ ซึ่งรวมถึงการจำกัดการโต้ตอบข้อมูล การจำกัดการเข้าถึง และการนำการตรวจสอบที่เข้มงวดมาใช้เพื่อป้องกันไม่ให้ข้อมูลที่ละเอียดอ่อนถูกเปิดเผยต่อความเสี่ยงโดยธรรมชาติที่เกี่ยวข้องกับแพลตฟอร์มภายนอกที่ไม่ได้รับการจัดการใดๆ โดยไม่คำนึงว่าข้อมูลนั้นจะดูสร้างสรรค์หรือมีประโยชน์เพียงใดก็ตาม

เราจำเป็นต้องขยายกฎการคุ้มครองข้อมูลปัจจุบันของเราให้ครอบคลุมถึงแอป AI ด้วย และในทางที่ดี เราต้องมีกฎชุดเดียวที่ใช้ได้กับทุกอย่าง ไม่ว่าจะเป็นแอปที่ได้รับอนุมัติ แอปที่ไม่ได้รับการอนุมัติ หรือแม้แต่แอปภายในของเราเองก็ตาม

ในฐานะผู้ปฏิบัติงานด้านความปลอดภัยเมื่อคุณระบุความเสี่ยงที่เกี่ยวข้องของบริการ / เอนทิตีที่กําหนดแล้วคุณจะต้องถามคําถามสามข้อ:

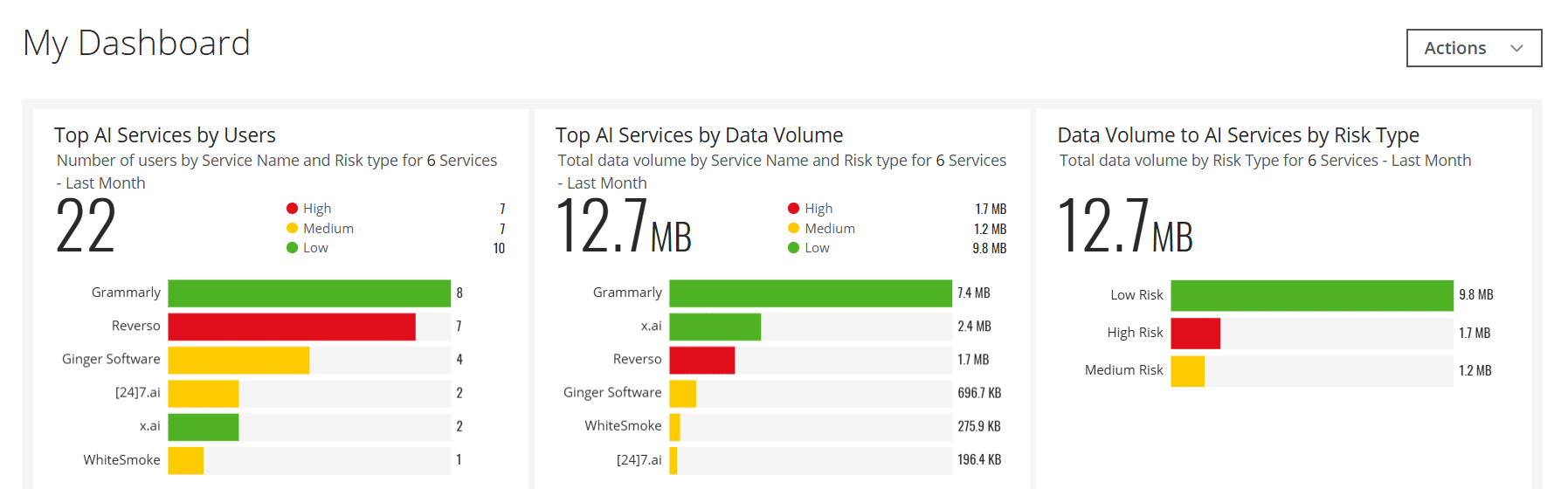

- มีผู้ใช้ของเราเรียกดู / ใช้สิ่งนี้หรือไม่? ถ้าเป็นเช่นนั้นกี่คน? และใครกันแน่?

- มีส่วนใดส่วนหนึ่งของโครงสร้างพื้นฐานเว็บและคลาวด์ของเราเข้าถึงบริการนี้หรือไม่

- และหากคําถามสองข้อแรกข้อใดข้อหนึ่งส่งผลให้ "ใช่" แสดงว่ามีการทําธุรกรรมข้อมูลระหว่างองค์กรของคุณกับบริการนั้นมากน้อยเพียงใด

ใช้ Skyhigh Security?

- สร้างการ์ดแดชบอร์ดแบบโต้ตอบสำหรับบริการ AI เพื่อช่วยให้ทีมงานรักษาความปลอดภัยของคุณมองเห็นข้อมูลแบบเรียลไทม์ที่สำคัญได้

- ตรวจจับและบล็อกการโอนข้อมูลผู้ใช้ไปยังบริการ AI เช่น ChatGPT และอื่นๆ อีกมากมายโดยใช้นโยบายในตัว

- สร้างระบบอัตโนมัติให้กับบริการเว็บและคลาวด์ AI ที่มีความเสี่ยง โดยให้เพิ่มลงในกลุ่มบริการที่กำหนดเอง ตามคุณลักษณะความเสี่ยงที่กำหนดเอง แทนที่จะใช้วิธีหมวดหมู่ = AI พื้นฐาน

- จัดการบริการ AI ที่ใช้ในสถานการณ์ภายในองค์กร ผ่านทาง Secure Web Gateway ในสถานที่เฉพาะของคุณ

- ใช้ประโยชน์จากความสามารถที่ขับเคลื่อนด้วยปัญญาประดิษฐ์ เพื่อจัดการกับกรณีการใช้งานที่หลากหลายที่เกี่ยวข้องกับการตรวจจับภัยคุกคาม การจัดการข้อมูล การตรวจจับผลบวกปลอม และอื่นๆ

- ใช้ข้อมูลเชิงลึกที่มากขึ้นเกี่ยวกับความเสี่ยงของ AI และเนื้อหาที่สร้างขึ้น โดยรวบรวมรายละเอียด Large Language Model (LLM) สำหรับหมวดหมู่ AI

ด้วยประสบการณ์ในอุตสาหกรรมความปลอดภัยทางไซเบอร์ที่ยาวนานกว่า 11 ปี Rodman Ramezanian เป็นที่ปรึกษาด้านความปลอดภัยบนคลาวด์ระดับองค์กร ซึ่งรับผิดชอบด้านการให้คําปรึกษาด้านเทคนิค Skyhigh Security. ในบทบาทนี้ Rodman มุ่งเน้นไปที่รัฐบาลกลางออสเตรเลียกลาโหมและองค์กรองค์กรเป็นหลัก

Rodman เชี่ยวชาญในด้าน Adversarial Threat Intelligence, Cyber Crime, Data Protection และ Cloud Security เขาเป็นผู้ประเมิน IRAP ที่ได้รับการรับรองจาก Australian Signals Directorate (ASD) ซึ่งปัจจุบันถือใบรับรอง CISSP, CCSP, CISA, CDPSE, Microsoft Azure และ MITRE ATT&CK CTI

ตรงไปตรงมา Rodman มีความหลงใหลอย่างแรงกล้าในการอธิบายเรื่องที่ซับซ้อนในแง่ง่ายๆ ช่วยให้คนทั่วไปและผู้เชี่ยวชาญด้านความปลอดภัยรายใหม่เข้าใจว่าอะไร ทําไม และอย่างไรของการรักษาความปลอดภัยทางไซเบอร์

ไฮไลท์การโจมตี

- แฮกเกอร์อ้างว่าสามารถเจาะระบบ OmniGPT ซึ่งเป็นบริการแชทบอทที่ขับเคลื่อนด้วย AI ยอดนิยมได้ และนำข้อมูลที่ขโมยมาไปขายบนเว็บมืด

- ข้อมูลที่ถูกขโมยไปรวมถึงที่อยู่อีเมลผู้ใช้ หมายเลขโทรศัพท์ คีย์ API และข้อมูลสำคัญอื่น ๆ มากกว่า 30,000 รายการ

- การละเมิดดังกล่าวเน้นย้ำถึงช่องโหว่ด้านความปลอดภัยในแพลตฟอร์ม AI โดยเฉพาะอย่างยิ่งเกี่ยวกับการจัดการและการปกป้องข้อมูลของผู้ใช้

- นอกจากนี้แฮกเกอร์ยังถูกกล่าวหาว่าได้รับข้อมูลการเรียกเก็บเงินและข้อมูลประจำตัว ซึ่งทำให้ผู้ใช้มีความเสี่ยงต่อการโจรกรรมข้อมูลส่วนบุคคลและการฉ้อโกงมากขึ้น

- การละเมิดดังกล่าวทำให้เกิดความกังวลเกี่ยวกับความปลอดภัยของบริการ AI บนคลาวด์และความสามารถในการปกป้องความเป็นส่วนตัวของผู้ใช้

- OmniGPT ยังไม่ได้ยืนยันการละเมิดหรือแสดงความคิดเห็นเกี่ยวกับรายละเอียด แต่เหตุการณ์นี้ดึงดูดความสนใจจากผู้เชี่ยวชาญด้านความปลอดภัยทางไซเบอร์อย่างมาก