リソース

インテリジェンス・ダイジェスト

ボット逮捕:AIチャットボットによるデータ流出疑惑

人気のAI搭載チャットボットからのデータ流出が報じられ、脅威となっている。

By Rodman Ramezanian - エンタープライズ・クラウド・セキュリティ・アドバイザー

2025年2月24日 7分で読む

AIを搭載したチャットボットは、質問への回答や顧客サービスの支援から、個人的なタスクの管理や取引に至るまで、私たちの生活のほぼすべての側面にシームレスに溶け込んでいる。即座にパーソナライズされた対話を提供するその能力により、私たちはしばしば何の気なしに、機密データを自由に共有している。しかし、チャットボットサービスがデータ漏えいを経験すると、個人のプライバシーが損なわれるだけでなく、ユーザーがこれらのテクノロジーに置いている信頼そのものを攻撃することになる。このようなAIシステムとやり取りされる個人情報、財務情報、会話データは膨大な量であるため、情報漏えいは個人のセキュリティから私たちが信頼するようになったAIサービスの信頼性まで、あらゆるものに影響を及ぼし、広範囲に及ぶ結果をもたらす可能性がある。

悪名高いBreach Forumsに投稿された情報によると、ハッカーが、広く利用されているAIチャットボットと生産性プラットフォームであるOmniGPTに侵入したと主張している。この侵入により、電子メール、電話番号、3,400万行以上の会話ログを含む3万人のユーザーの個人情報が流出したとされている。暴露されたデータには、ユーザーのチャットに加え、アップロードされたファイルへのリンクも含まれており、その中には認証情報、請求詳細、APIキーなどの機密情報が含まれている。

実のところ、AIチャットボット・サービスがデータ流出に直面した場合、少なくとも少しは警戒しないわけにはいかない。特に、こうしたツールが急速に普及していることを考えると、なおさらだ。私たちは、クリエイティブなライティングやブレインストーミングからリサーチ、さらにはビジネスの自動化まで、さまざまな機能のためにAIチャットボットに依存している。

なぜこのような事件が起こるのでしょうか?

AIを搭載したチャットボットやクリエイティビティ・サービスのアクセシビリティと利便性は、私たちの日常生活に不可欠なものとなっているが、ここで最も懸念されるのは、情報漏洩がサービスのバックエンドで起こったということだ。つまり、ユーザーや消費者がそれを防ぐためにできることは全くなかったということだ。

AIチャットボットを、あらゆる情報の気軽な保管場所として扱う一般的な傾向がある。 しかし実際には、これらのプラットフォームは「ブラックボックス」として動作しており、ユーザーは自分のデータがどのように扱われ、保存され、保護されているのか、事実上まったく把握できない。 このような認識と現実の断絶は、アップロードされた文書、APIキー、個人情報などの機密データが流出した場合、今回のケースのように壊滅的な結果をもたらす可能性がある。

同様に重要なのは、ユーザーに対する継続的なセキュリティ意識向上トレーニングだ。多くの人は、AIチャットボットサービスやクラウドプラットフォームに機密情報を入力することに関連するリスクをまだ十分に認識していないかもしれない。潜在的なデータの誤用についてユーザーを教育し、個人情報や機密データを共有する際の注意を強調することは、露出を減らす上で大きな効果がある。

強力で、多くの場合無料で、AIを強化したサービスの魅力は増大の一途をたどり、従来の「モグラたたき」的なセキュリティ・アプローチはますます無益になる。 毎週何百(何千とは言わないまでも)もの新しいAIサービスが登場する中、サイバーセキュリティ・チームはすでに圧倒されており、追いつくことは不可能だ。

「最近、暇を持て余している」-サイバーセキュリティ・チームは誰もそう言っていない!

あらゆるAIツールを追い求めるのではなく、根本的なリスクに焦点を移さなければならない。 これは、共有先のサービスにかかわらず、機密データの保護を優先することを意味する。 一見正当なAIプラットフォームであろうと、その他のシャドーITリソースであろうと、データのやり取りを制限し、強固なセキュリティ対策を実施することは、拡大し続けるAIツールを取り締まろうとするよりもはるかに効果的である。 最近の出来事が示すように、堅牢に見えるサービスでさえ、洗練された脅威行為者の標的になる可能性がある。

何ができるのか?

AIは紛れもなく革命的であり、産業や日常生活に数え切れないほどの変革をもたらす。 しかし、純粋に技術的な観点から見ると、AIサービス、特にウェブやクラウド経由でアクセスするサービスは、基本的にはウェブサイトやクラウドプラットフォームに過ぎない。 その基礎となる技術は極めて強力で革新的ではあるが、サイバーセキュリティの観点からは、データ漏洩や不正アクセスのもう一つの潜在的な経路となる。 市民記録、個人情報、ソースコードなどの機密性の高い組織データの保護を任務とするセキュリティ専門家にとって、AIサービスはシャドーITのレンズを通して見る必要がある。

AIは効率化とイノベーションを推進する一方で、データ漏洩やコンプライアンス違反、シャドーAIの利用といった課題も抱えている。AIの急速な導入はしばしばガバナンスを上回り、組織は適切なセキュリティ対策を講じることなく、風評、財務、法的リスクにさらされやすくなる。

シャドーITの定義によれば、企業の利用やデータ取引に対して明示的に認可または承認されていないサービスはすべて含まれる。 AIサービスをシャドーITとして考える場合、関連するリスクが明らかになる。 機密性の高い顧客データを未承認のウェブサイトに入力することを許可しますか? 機密の添付ファイルを未知のクラウド・サービスにアップロードすることを許可するだろうか? データ保護慣行が疑わしい司法管轄区でホストされているプラットフォームを従業員が使用することを容認するだろうか? これらの質問に対する答えは、すべて「ノー」であるべきだ。

AIサービスをシャドーITとして扱うには、必要な視点の転換を迫られる。 組織は、テクノロジーの能力に目を奪われるのではなく、他の不正なサービスと同じように厳格なセキュリティ基準を適用しなければならない。 これには、データのやり取りを制限し、アクセスを制限し、強固な監視を実施して、機密情報が管理されていない外部プラットフォームに関連する固有のリスクにさらされるのを防ぐことが含まれる。

そして理想的には、承認されたアプリ、承認されていないアプリ、社内のアプリに至るまで、すべてに通用する1つのルールが必要だ。

セキュリティの実務家として、あるサービス/エンティティの関連リスクを特定したら、最終的には3つの質問をしたいものです:

- 当社のユーザーの中で、これを閲覧・利用した人はいますか?もしそうなら、何人くらいですか?また、具体的には誰ですか?

- 当社のウェブやクラウドインフラの一部がこのサービスにアクセスしたのでしょうか?

- また、最初の2つの質問のいずれかが「はい」という結果になった場合、あなたの組織とそのサービスとの間で、どれくらいのデータがやり取りされたのでしょうか。

Skyhigh Security?

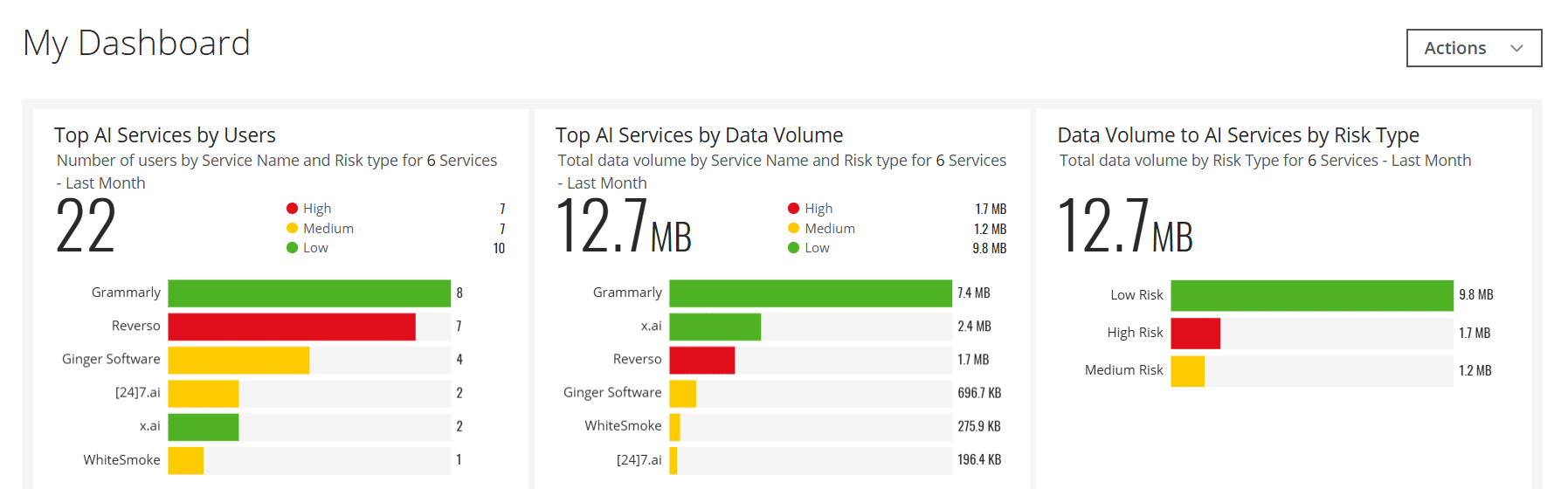

- AIサービスのインタラクティブなダッシュボードカードを作成するセキュリティチームの重要なリアルタイム可視化を支援します。

- AIサービスへのユーザーデータの転送を検出しブロックする内蔵ポリシーにより、ChatGPTやその他多くのAIサービスへのユーザーデータの転送をブロックします。

- リスクの高いAIウェブサービスやクラウドサービスを、基本的なカテゴリー=AI方式ではなく、カスタムのリスク属性に基づいて、カスタム・サービス・グループに自動入力する。基本的なカテゴリー=AI方式ではなく、カスタムのリスク属性に基づく

- オンプレミス・シナリオで使用されるAIサービスの管理オンプレミス専用のSecure Web Gateway経由

- 人工知能を活用した機能脅威検知、データ管理、誤検知など、さまざまなユースケースに対応

- AIのリスクと生成されたコンテンツに深い洞察を適用AIカテゴリの大規模言語モデル(LLM)の詳細をキャプチャすることで

サイバーセキュリティ業界で11年以上の豊富な経験を持つRodman Ramezanianは、エンタープライズ・クラウド・セキュリティ・アドバイザーとして、Skyhigh Security でテクニカル・アドバイザリー、イネーブルメント、ソリューション・デザイン、アーキテクチャを担当しています。この職務において、Rodmanは主にオーストラリア連邦政府、防衛、および企業組織を対象としている。

Rodmanは、敵対的脅威インテリジェンス、サイバー犯罪、データ保護、クラウドセキュリティの分野を専門としています。現在、CISSP、CCSP、CISA、CDPSE、Microsoft Azure、MITRE ATT&CK CTIの各認定を取得しています。

ロッドマンは、複雑な事柄をシンプルな言葉で表現することに強い情熱を持ち、一般の人々や新しいセキュリティ専門家がサイバーセキュリティの何を、なぜ、どのように理解できるように支援します。

アタックハイライト

- ハッカーは、人気のAI搭載チャットボットサービスであるOmniGPTに侵入し、盗んだデータをダークウェブに売りに出したと主張している。

- 盗まれたデータには、3万人以上のユーザーの電子メールアドレス、電話番号、APIキー、その他の機密情報が含まれている。

- 今回の情報漏洩は、特にユーザーデータの取り扱いと保護に関して、AIプラットフォームのセキュリティの脆弱性を浮き彫りにした。

- ハッカーはまた、課金情報や認証情報を入手し、ユーザーをなりすましや詐欺の危険にさらしたとされている。

- 今回の情報漏洩は、クラウドベースのAIサービスのセキュリティと、ユーザーのプライバシーを保護する能力について懸念を抱かせるものだ。

- OmniGPTはまだ情報漏洩を確認しておらず、詳細についてもコメントしていないが、この事件はサイバーセキュリティの専門家から大きな注目を集めている。