Risorse

DIGEST DELL'INTELLIGENCE

Bot beccato: presunta fuga di dati del chatbot AI

Le segnalazioni di fughe di dati da parte di un popolare chatbot alimentato dall'intelligenza artificiale minacciano

Di Rodman Ramezanian - Consulente per la sicurezza del cloud aziendale

24 febbraio 2025 7 minuti di lettura

I chatbot alimentati dall'AI si sono integrati perfettamente in quasi tutti gli aspetti della nostra vita, dalle risposte alle domande e all'assistenza ai clienti, alla gestione delle attività personali e alle transazioni. Grazie alla loro capacità di fornire interazioni istantanee e personalizzate, condividiamo liberamente i dati sensibili, spesso senza pensarci due volte. Tuttavia, quando un servizio di chatbot subisce una fuga di dati, non compromette solo la privacy individuale, ma colpisce la fiducia stessa che gli utenti hanno riposto in queste tecnologie. L'enorme volume di dati personali, finanziari e conversazionali scambiati con questi sistemi di intelligenza artificiale significa che una violazione potrebbe avere conseguenze di vasta portata, con ripercussioni su tutto, dalla sicurezza personale all'affidabilità dei servizi di intelligenza artificiale su cui abbiamo fatto affidamento.

Un hacker avrebbe dichiarato di essersi infiltrato in OmniGPT, una piattaforma di produttività e chatbot AI molto utilizzata, secondo le informazioni pubblicate sul noto Breach Forums. La violazione avrebbe esposto i dati personali di 30.000 utenti, tra cui e-mail, numeri di telefono e oltre 34 milioni di righe di registri di conversazione. Oltre alle chat degli utenti, i dati esposti includono anche link a file caricati, alcuni dei quali contengono informazioni sensibili come credenziali, dettagli di fatturazione e chiavi API.

A dire il vero, è difficile non essere almeno un po' allarmati da un servizio di chatbot AI che si trova ad affrontare una fuga di dati, soprattutto considerando la rapidità con cui questi strumenti sono diventati popolari. Ci affidiamo a loro per una serie di funzionalità, dalla scrittura creativa e dal brainstorming alla ricerca e persino all'automazione aziendale.

Perché si verificano questi incidenti?

L'accessibilità e la comodità dei chatbot e dei servizi di creatività basati sull'AI li hanno resi parte integrante della nostra vita quotidiana, ma la cosa più preoccupante è che la violazione è avvenuta nel back-end del servizio. Ciò significa che è del tutto estraneo a qualsiasi cosa che gli utenti o i consumatori avrebbero potuto fare per evitarla.

C'è una tendenza comune a trattare i chatbot AI come un deposito casuale di tutte le informazioni. In realtà, però, queste piattaforme funzionano come 'scatole nere', dove l'utente non ha praticamente alcuna visione di come i suoi dati vengono gestiti, archiviati o protetti. Questo scollamento tra percezione e realtà può avere conseguenze devastanti quando i dati sensibili, come i documenti caricati, le chiavi API e i dettagli personali, vengono divulgati, come si è visto in questo caso.

Altrettanto importante è la formazione continua degli utenti sulla sicurezza. Molte persone potrebbero ancora non essere pienamente consapevoli dei rischi associati all'inserimento di informazioni sensibili nei servizi di chatbot AI o nelle piattaforme cloud. Educare gli utenti sul potenziale uso improprio dei dati e sottolineare la cautela nel condividere dati personali o riservati può contribuire a ridurre l'esposizione.

Il fascino di servizi potenti, spesso gratuiti, arricchiti dall'AI continuerà a crescere, rendendo sempre più inutile il tradizionale approccio "whack-a-mole" alla sicurezza. Con centinaia (se non migliaia) di nuovi servizi di AI che emergono ogni settimana, i team di cybersecurity sono già sovraccarichi e non riescono a tenere il passo.

"Abbiamo avuto molto tempo libero ultimamente" - ha detto nessun team di cybersecurity, mai!

Invece di inseguire ogni singolo strumento di AI, l'attenzione deve spostarsi sui rischi sottostanti. Ciò significa dare priorità alla protezione dei dati sensibili, indipendentemente dal servizio con cui vengono condivisi. Che si tratti di una piattaforma AI apparentemente legittima o di qualsiasi altra risorsa IT ombra, limitare le interazioni con i dati e implementare solide misure di sicurezza si rivelerà molto più efficace che cercare di sorvegliare un panorama di strumenti AI in continua espansione. Come dimostrano gli eventi recenti, anche i servizi dall'aspetto solido possono diventare bersagli di sofisticati attori di minacce.

Cosa si può fare?

L'AI è innegabilmente rivoluzionaria e sta trasformando le industrie e la vita quotidiana in innumerevoli modi. Da un punto di vista puramente tecnico, tuttavia, i servizi di AI, in particolare quelli accessibili via web e cloud, sono fondamentalmente solo siti web o piattaforme cloud. Sebbene la loro tecnologia di base sia straordinariamente potente e innovativa, dal punto di vista della cybersicurezza, rappresentano un'altra potenziale via per la fuga di dati e l'accesso non autorizzato. Per i professionisti della sicurezza incaricati di proteggere i dati sensibili dell'organizzazione, come i registri dei cittadini, le PII e il codice sorgente, i servizi di AI devono essere visti attraverso la lente dello shadow IT.

E se da un lato l'AI guida l'efficienza e l'innovazione, dall'altro pone delle sfide come le violazioni dei dati, le violazioni della conformità e l'utilizzo dell'AI ombra. La rapida adozione dell'AI spesso supera la governance, lasciando le organizzazioni vulnerabili a rischi reputazionali, finanziari e legali senza adeguate misure di sicurezza.

Lo Shadow IT, per definizione, comprende qualsiasi servizio non esplicitamente sanzionato o autorizzato per l'uso aziendale e le transazioni di dati. Quando si considerano i servizi di AI come shadow IT, i rischi associati diventano chiari. Permetterebbe che i dati sensibili dei clienti vengano inseriti in un sito web non approvato? Permetterebbe di caricare allegati riservati su un servizio cloud sconosciuto? Permetterebbe ai dipendenti di utilizzare piattaforme ospitate in giurisdizioni con pratiche di protezione dei dati discutibili? La risposta a tutte queste domande dovrebbe essere un secco no.

Trattare i servizi di AI come shadow IT obbliga a un necessario cambio di prospettiva. Invece di lasciarsi abbagliare dalle capacità della tecnologia, le organizzazioni devono applicare gli stessi rigorosi standard di sicurezza che applicherebbero a qualsiasi altro servizio non autorizzato. Ciò include la restrizione delle interazioni con i dati, la limitazione dell'accesso e l'implementazione di un robusto monitoraggio per evitare che le informazioni sensibili siano esposte ai rischi intrinseci associati a qualsiasi piattaforma esterna non gestita, indipendentemente da quanto innovativa o utile possa apparire.

Dobbiamo assolutamente estendere le nostre attuali regole di protezione dei dati alle app di intelligenza artificiale e, idealmente, abbiamo bisogno di una serie di regole che funzionino per tutto: app approvate, app non approvate, persino quelle interne.

In qualità di professionista della sicurezza, una volta identificati i rischi associati a un determinato servizio/entità, in definitiva dovrebbe porsi tre domande:

- Qualcuno dei nostri utenti ha visitato/utilizzato questo sito? Se sì, quanti? E chi esattamente?

- Qualche parte della nostra infrastruttura web e cloud ha avuto accesso a questo servizio?

- E se una delle prime due domande dà come risultato un "sì", quanti dati sono stati scambiati tra la sua organizzazione e quel servizio?

Utilizza Skyhigh Security?

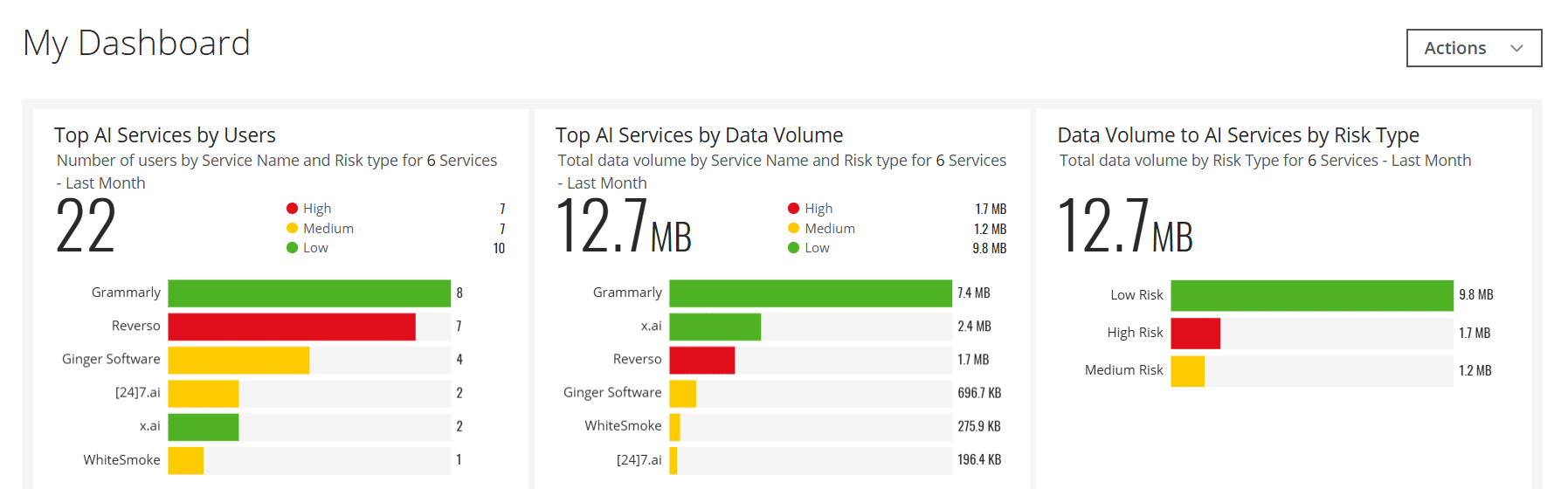

- Creare schede dashboard interattive per i servizi AI per aiutare i suoi team di sicurezza con una visibilità importante e in tempo reale.

- Rileva e blocca i trasferimenti dei dati degli utenti ai servizi di AI come ChatGPT e molti altri, utilizzando le politiche integrate.

- Automatizzare i servizi web e cloud AI a rischio per essere popolati in Gruppi di servizi personalizzati sulla base di attributi di rischio personalizzati, piuttosto che un metodo di base Categoria = AI

- Gestisce i Servizi AI utilizzati in scenari on-premise attraverso il suo Secure Web Gateway dedicato on-premise

- Sfrutta le capacità dell'Intelligenza Artificiale per affrontare una serie di casi d'uso relativi al rilevamento delle minacce, alla gestione dei dati, al rilevamento dei falsi positivi e altro ancora.

- Applicare approfondimenti sui rischi dell'AI e sui contenuti generati catturando i dettagli del Large Language Model (LLM) per le categorie AI

Con oltre 11 anni di vasta esperienza nel settore della cybersecurity, Rodman Ramezanian è un Enterprise Cloud Security Advisor, responsabile della consulenza tecnica, dell'abilitazione, della progettazione di soluzioni e dell'architettura presso Skyhigh Security. In questo ruolo, Rodman si concentra principalmente sulle organizzazioni del Governo Federale Australiano, della Difesa e delle imprese.

Rodman è specializzato nelle aree di Adversarial Threat Intelligence, Cyber Crime, Data Protection e Cloud Security. È un Valutatore IRAP approvato dall'Australian Signals Directorate (ASD) - attualmente in possesso delle certificazioni CISSP, CCSP, CISA, CDPSE, Microsoft Azure e MITRE ATT&CK CTI.

In tutta franchezza, Rodman ha una forte passione nell'articolare questioni complesse in termini semplici, aiutando la persona media e i nuovi professionisti della sicurezza a capire il cosa, il perché e il come della cybersecurity.

Punti salienti dell'attacco

- Un hacker sostiene di aver violato OmniGPT, un popolare servizio di chatbot con intelligenza artificiale, e di aver messo in vendita i dati rubati sul dark web.

- I dati rubati comprendono oltre 30.000 indirizzi e-mail di utenti, numeri di telefono, chiavi API e altre informazioni sensibili.

- La violazione evidenzia le vulnerabilità di sicurezza delle piattaforme di AI, soprattutto per quanto riguarda la gestione e la protezione dei dati degli utenti.

- L'hacker avrebbe anche ottenuto informazioni e credenziali di fatturazione, mettendo gli utenti a maggior rischio di furto d'identità e frode.

- La violazione solleva preoccupazioni sulla sicurezza dei servizi AI basati sul cloud e sulla loro capacità di proteggere la privacy degli utenti.

- OmniGPT non ha ancora confermato la violazione né commentato i dettagli, ma l'incidente ha attirato l'attenzione degli esperti di cybersicurezza.