Sumber daya

INTELIJEN MENCERNA

Bot Ketahuan: Dugaan Kebocoran Data AI ChatBot

Laporan kebocoran data dari Chatbot bertenaga AI yang populer mengancam

Oleh Rodman Ramezanian - Penasihat Keamanan Cloud Perusahaan

24 Februari 2025 7 Menit Dibaca

Chatbot yang didukung AI telah terintegrasi dengan mulus ke dalam hampir semua aspek kehidupan kita, mulai dari menjawab pertanyaan dan membantu layanan pelanggan hingga mengelola tugas-tugas pribadi dan melakukan transaksi. Dengan kemampuan mereka untuk menyediakan interaksi yang instan dan dipersonalisasi, kita dengan bebas membagikan data sensitif, sering kali tanpa berpikir panjang. Namun, ketika layanan chatbot mengalami kebocoran data, hal ini tidak hanya membahayakan privasi individu - tetapi juga menyerang kepercayaan yang telah diberikan oleh pengguna terhadap teknologi ini. Banyaknya volume data pribadi, keuangan, dan percakapan yang dipertukarkan dengan sistem AI ini berarti bahwa pelanggaran dapat menimbulkan konsekuensi yang luas, yang memengaruhi segala hal mulai dari keamanan pribadi hingga keandalan layanan AI yang selama ini kita andalkan.

Seorang peretas dilaporkan telah mengklaim telah menyusup ke OmniGPT, sebuah chatbot AI dan platform produktivitas yang banyak digunakan, menurut informasi yang diposting di Forum Pelanggaran yang terkenal kejam. Pelanggaran tersebut diduga mengekspos data pribadi 30.000 pengguna, termasuk email, nomor telepon, dan lebih dari 34 juta baris log percakapan. Selain obrolan pengguna, data yang terekspos juga mencakup tautan ke file yang diunggah, beberapa di antaranya berisi informasi sensitif seperti kredensial, detail penagihan, dan kunci API.

Sejujurnya, sulit untuk tidak merasa khawatir dengan layanan chatbot AI yang mengalami kebocoran data, terutama mengingat betapa cepatnya alat ini meroket popularitasnya. Kami mengandalkan mereka untuk berbagai kemampuan - mulai dari penulisan kreatif dan curah pendapat hingga penelitian dan bahkan otomatisasi bisnis.

Mengapa insiden-insiden ini terjadi?

Aksesibilitas dan kenyamanan dari chatbot bertenaga AI dan layanan kreativitas telah menjadikannya bagian integral dari kehidupan kita sehari-hari, tetapi yang paling memprihatinkan di sini adalah bahwa pembobolan tersebut terjadi di sisi belakang layanan. Artinya, hal ini sepenuhnya di luar kemampuan pengguna atau konsumen untuk mencegahnya.

Ada kecenderungan umum untuk memperlakukan chatbot AI sebagai tempat penyimpanan biasa untuk semua informasi. Namun pada kenyataannya, platform ini beroperasi sebagai 'kotak hitam', di mana pengguna hampir tidak memiliki wawasan tentang bagaimana data mereka ditangani, disimpan, atau dilindungi. Ketidaksesuaian antara persepsi dan kenyataan ini dapat menimbulkan konsekuensi yang sangat buruk ketika data sensitif, seperti dokumen yang diunggah, kunci API, dan detail pribadi, bocor, seperti yang terlihat dalam kasus ini.

Yang tidak kalah pentingnya adalah pelatihan kesadaran keamanan yang berkelanjutan bagi pengguna. Banyak orang mungkin masih belum sepenuhnya menyadari risiko yang terkait dengan memasukkan informasi sensitif ke dalam layanan chatbot AI atau platform cloud. Mengedukasi pengguna tentang potensi penyalahgunaan data dan menekankan kehati-hatian saat membagikan data pribadi atau rahasia dapat sangat membantu dalam mengurangi eksposur.

Daya tarik layanan yang kuat, sering kali gratis, dan diperkaya dengan AI akan terus berkembang, membuat pendekatan tradisional "memukul-mukul" terhadap keamanan menjadi semakin sia-sia. Dengan ratusan (atau bahkan ribuan) layanan AI baru yang muncul setiap minggunya, tim keamanan siber sudah kewalahan dan tidak mungkin bisa mengimbanginya.

"Kami memiliki begitu banyak waktu luang akhir-akhir ini" - tidak ada tim keamanan siber yang tidak mengatakannya!

Alih-alih mengejar setiap alat AI, fokusnya harus beralih ke risiko yang mendasarinya. Ini berarti memprioritaskan perlindungan data sensitif, apa pun layanan yang digunakan untuk berbagi data. Baik itu platform AI yang tampaknya sah atau sumber daya TI bayangan lainnya, membatasi interaksi data dan menerapkan langkah-langkah keamanan yang kuat akan terbukti jauh lebih efektif daripada mencoba mengawasi lanskap alat AI yang terus berkembang. Seperti yang ditunjukkan oleh peristiwa baru-baru ini, bahkan layanan yang terlihat kuat pun dapat menjadi target bagi pelaku ancaman yang canggih.

Apa yang bisa dilakukan?

AI tidak dapat disangkal lagi merupakan sesuatu yang revolusioner, yang mengubah industri dan kehidupan sehari-hari dengan berbagai cara. Namun, dari sudut pandang teknis murni, layanan AI, terutama yang diakses melalui web dan cloud, pada dasarnya hanyalah situs web atau platform cloud. Meskipun teknologi yang mendasarinya sangat kuat dan inovatif, dari perspektif keamanan siber, layanan ini merupakan jalan lain yang potensial untuk kebocoran data dan akses tidak sah. Bagi para profesional keamanan yang ditugaskan untuk melindungi data organisasi yang sensitif seperti catatan warga negara, PII, dan kode sumber, layanan AI harus dilihat melalui lensa bayangan TI.

Meskipun AI mendorong efisiensi dan inovasi, AI juga menimbulkan tantangan seperti pelanggaran data, pelanggaran kepatuhan, dan penggunaan AI bayangan. Adopsi AI yang cepat sering kali melampaui tata kelola, membuat organisasi rentan terhadap risiko reputasi, keuangan, dan hukum tanpa langkah-langkah keamanan yang tepat.

TI bayangan, menurut definisi, mencakup layanan apa pun yang tidak secara eksplisit disetujui atau disahkan untuk penggunaan perusahaan dan transaksi data. Ketika mempertimbangkan layanan AI sebagai TI bayangan, risiko yang terkait menjadi jelas. Apakah Anda mengizinkan data pelanggan yang sensitif dimasukkan ke dalam situs web yang tidak disetujui? Apakah Anda mengizinkan lampiran rahasia diunggah ke layanan cloud yang tidak dikenal? Apakah Anda mengizinkan karyawan menggunakan platform yang dihosting di yurisdiksi dengan praktik perlindungan data yang meragukan? Jawaban untuk semua pertanyaan ini seharusnya adalah tidak.

Memperlakukan layanan AI sebagai IT bayangan memaksa pergeseran perspektif yang diperlukan. Alih-alih terpesona oleh kemampuan teknologi, organisasi harus menerapkan standar keamanan ketat yang sama seperti yang mereka terapkan pada layanan lain yang tidak sah. Hal ini termasuk membatasi interaksi data, membatasi akses, dan menerapkan pemantauan yang kuat untuk mencegah informasi sensitif terpapar pada risiko yang melekat pada platform eksternal yang tidak terkelola, terlepas dari seberapa inovatif atau bermanfaatnya platform tersebut.

Kita benar-benar perlu memperluas aturan perlindungan data kita saat ini untuk mencakup aplikasi AI, dan idealnya, kita membutuhkan satu set aturan yang berfungsi untuk semuanya - aplikasi yang disetujui, aplikasi yang tidak disetujui, bahkan aplikasi internal kita sendiri.

Sebagai seorang praktisi keamanan, setelah Anda mengidentifikasi risiko yang terkait dengan layanan/entitas tertentu, pada akhirnya Anda pasti ingin mengajukan tiga pertanyaan:

- Apakah ada pengguna kami yang pernah menjelajahi/menggunakan situs ini? Jika ya, berapa banyak? Dan siapa saja?

- Apakah ada bagian dari infrastruktur web dan cloud kami yang mengakses layanan ini?

- Dan jika salah satu dari dua pertanyaan pertama menghasilkan jawaban "ya", berapa banyak data yang telah ditransaksikan antara organisasi Anda dan layanan tersebut?

Gunakan Skyhigh Security?

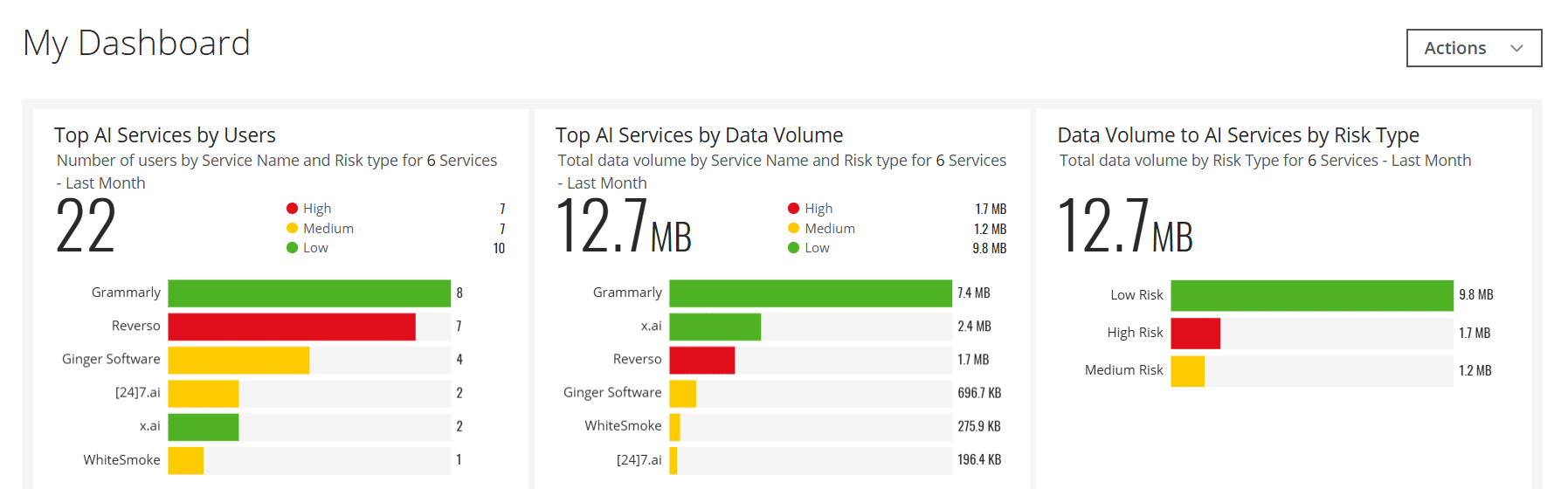

- Buat kartu dasbor interaktif untuk layanan AI untuk membantu tim keamanan Anda dengan visibilitas yang penting dan real-time

- Mendeteksi dan memblokir transfer data pengguna ke layanan AI seperti ChatGPT dan banyak lainnya yang menggunakan kebijakan bawaan

- Mengotomatiskan layanan web dan cloud AI yang berisiko untuk dimasukkan ke dalam Grup Layanan khusus berdasarkan atribut risiko khusus, daripada metode Kategori = AI dasar

- Mengelola Layanan AI yang digunakan dalam skenario di lokasi melalui Secure Web Gateway khusus di lokasi Anda

- Memanfaatkan kemampuan yang didukung oleh Kecerdasan Buatan untuk menangani berbagai kasus penggunaan yang terkait dengan deteksi ancaman, manajemen data, deteksi positif palsu, dan banyak lagi

- Menerapkan wawasan yang lebih dalam tentang risiko AI dan konten yang dihasilkan dengan menangkap detail Large Language Model (LLM) untuk kategori AI

Dengan pengalaman industri keamanan siber yang luas selama lebih dari 11 tahun, Rodman Ramezanian adalah Penasihat Keamanan Cloud Perusahaan, yang bertanggung jawab atas Penasihat Teknis, Pemberdayaan, Desain Solusi, dan Arsitektur di Skyhigh Security. Dalam perannya ini, Rodman terutama berfokus pada organisasi Pemerintah Federal Australia, Pertahanan, dan Perusahaan.

Rodman memiliki spesialisasi di bidang Intelijen Ancaman Musuh, Kejahatan Siber, Perlindungan Data, dan Keamanan Cloud. Dia adalah Penilai IRAP yang didukung oleh Australian Signals Directorate (ASD) - yang saat ini memegang sertifikasi CISSP, CCSP, CISA, CDPSE, Microsoft Azure, dan MITRE ATT&CK CTI.

Rodman memiliki hasrat yang kuat untuk mengartikulasikan hal-hal yang rumit dengan cara yang sederhana, membantu orang awam dan profesional keamanan baru untuk memahami apa, mengapa, dan bagaimana keamanan siber.

Sorotan Serangan

- Seorang peretas mengklaim telah membobol OmniGPT, sebuah layanan chatbot bertenaga AI yang populer, dan menjual data curiannya di dark web.

- Data yang dicuri termasuk lebih dari 30.000 alamat email pengguna, nomor telepon, kunci API, dan informasi sensitif lainnya.

- Pelanggaran ini menyoroti kerentanan keamanan pada platform AI, terutama terkait penanganan dan perlindungan data pengguna.

- Peretas juga diduga memperoleh informasi penagihan dan kredensial, sehingga menempatkan pengguna pada risiko yang lebih besar terhadap pencurian identitas dan penipuan.

- Pelanggaran ini menimbulkan kekhawatiran tentang keamanan layanan AI berbasis cloud dan kemampuannya untuk melindungi privasi pengguna.

- OmniGPT belum mengonfirmasi pelanggaran tersebut atau mengomentari detailnya, tetapi insiden ini telah menarik perhatian yang signifikan dari para ahli keamanan siber.