Ressources

BULLETIN D'INFORMATION

Bot Busted Up : La fuite de données présumée d'un chatbot d'IA

Des fuites de données provenant d'un chatbot populaire alimenté par l'IA menacent la sécurité des données.

Par Rodman Ramezanian - Conseiller en sécurité de l'informatique en nuage pour les entreprises

24 février 2025 7 Minute Read

Les chatbots alimentés par l'IA se sont intégrés de manière transparente dans presque tous les aspects de nos vies, qu'il s'agisse de répondre à des questions, d'aider le service client, de gérer des tâches personnelles ou d'effectuer des transactions. Grâce à leur capacité à fournir des interactions instantanées et personnalisées, nous partageons librement des données sensibles, souvent sans réfléchir. Cependant, lorsqu'un service de chatbot subit une fuite de données, cela ne compromet pas seulement la vie privée des individus - cela porte atteinte à la confiance même que les utilisateurs ont placée dans ces technologies. Le volume de données personnelles, financières et conversationnelles échangées avec ces systèmes d'IA signifie qu'une violation pourrait avoir des conséquences considérables, affectant tout, de la sécurité personnelle à la fiabilité des services d'IA sur lesquels nous avons appris à compter.

Un pirate informatique aurait affirmé avoir infiltré OmniGPT, une plateforme de productivité et de chatbot IA largement utilisée, selon des informations publiées sur les célèbres Breach Forums. La brèche aurait exposé les données personnelles de 30 000 utilisateurs, y compris des courriels, des numéros de téléphone et plus de 34 millions de lignes de conversation. Outre les conversations des utilisateurs, les données exposées comprennent également des liens vers des fichiers téléchargés, dont certains contiennent des informations sensibles telles que des informations d'identification, des détails de facturation et des clés API.

À vrai dire, il est difficile de ne pas être au moins un peu alarmé par un service de chatbot d'IA confronté à une fuite de données, surtout si l'on considère la rapidité avec laquelle ces outils ont gagné en popularité. Nous comptons sur eux pour toute une série de fonctions - de l'écriture créative et du brainstorming à la recherche et même à l'automatisation des activités.

Pourquoi ces incidents se produisent-ils ?

L'accessibilité et la commodité des chatbots et des services de créativité alimentés par l'IA en ont fait une partie intégrante de notre vie quotidienne, mais ce qui est le plus inquiétant ici, c'est que la brèche s'est produite dans le back-end du service. Cela signifie que les utilisateurs ou les consommateurs n'auraient rien pu faire pour l'empêcher.

On a souvent tendance à considérer les chatbots d'IA comme un dépôt occasionnel de toutes les informations. En réalité, ces plateformes fonctionnent comme des "boîtes noires", où l'utilisateur n'a pratiquement aucune idée de la manière dont ses données sont traitées, stockées ou protégées. Ce décalage entre la perception et la réalité peut avoir des conséquences dévastatrices lorsque des données sensibles, telles que des documents téléchargés, des clés d'API et des détails personnels, sont divulguées, comme on l'a vu dans ce cas.

La formation continue des utilisateurs en matière de sensibilisation à la sécurité est tout aussi importante. De nombreuses personnes ne sont peut-être pas encore pleinement conscientes des risques associés à la saisie d'informations sensibles dans les services de chatbot d'IA ou les plateformes en nuage. Sensibiliser les utilisateurs aux risques d'utilisation abusive des données et insister sur la prudence lors du partage de données personnelles ou confidentielles peut contribuer grandement à réduire l'exposition aux risques.

L'attrait des services puissants, souvent gratuits, enrichis par l'IA ne fera que croître, rendant de plus en plus futile l'approche traditionnelle de la sécurité, dite du "whack-a-mole". Avec des centaines (voire des milliers) de nouveaux services d'IA apparaissant chaque semaine, les équipes de cybersécurité sont déjà débordées et ne peuvent pas suivre le rythme.

"Nous avons eu tellement de temps libre ces derniers temps" - n'a jamais dit aucune équipe de cybersécurité !

Au lieu de courir après chaque outil d'IA, il faut se concentrer sur les risques sous-jacents. Cela signifie qu'il faut donner la priorité à la protection des données sensibles, quel que soit le service avec lequel elles sont partagées. Qu'il s'agisse d'une plateforme d'IA apparemment légitime ou de toute autre ressource informatique fantôme, limiter les interactions entre les données et mettre en œuvre des mesures de sécurité robustes s'avérera bien plus efficace que d'essayer de contrôler un paysage d'outils d'IA en constante expansion. Comme le montrent les événements récents, même les services d'apparence robuste peuvent devenir des cibles pour des acteurs sophistiqués de la menace.

Que peut-on faire ?

L'IA est indéniablement révolutionnaire, transformant les industries et la vie quotidienne d'innombrables façons. Toutefois, d'un point de vue purement technique, les services d'IA, en particulier ceux auxquels on accède via le web et le cloud, ne sont fondamentalement que des sites web ou des plateformes cloud. Bien que leur technologie sous-jacente soit remarquablement puissante et innovante, du point de vue de la cybersécurité, ils représentent une autre voie potentielle de fuite de données et d'accès non autorisé. Pour les professionnels de la sécurité chargés de protéger les données organisationnelles sensibles telles que les dossiers des citoyens, les informations confidentielles et le code source, les services d'IA doivent être considérés sous l'angle de l'informatique parallèle.

Et si l'IA favorise l'efficacité et l'innovation, elle pose également des défis tels que les violations de données, les violations de conformité et l'utilisation de l'IA dans l'ombre. L'adoption rapide de l'IA dépasse souvent la gouvernance, laissant les organisations vulnérables aux risques de réputation, financiers et juridiques en l'absence de mesures de sécurité appropriées.

Par définition, l'informatique fantôme englobe tout service qui n'est pas explicitement sanctionné ou autorisé pour l'utilisation de l'entreprise et les transactions de données. Lorsque l'on considère les services d'IA comme de l'informatique parallèle, les risques associés deviennent évidents. Autoriseriez-vous la saisie de données sensibles de clients sur un site web non approuvé ? Autoriseriez-vous le téléchargement de pièces jointes confidentielles sur un service cloud inconnu ? Accepteriez-vous que des employés utilisent des plateformes hébergées dans des juridictions aux pratiques douteuses en matière de protection des données ? La réponse à toutes ces questions devrait être un non catégorique.

Traiter les services d'IA comme de l'informatique fantôme oblige à un changement de perspective nécessaire. Au lieu de se laisser éblouir par les capacités de la technologie, les organisations doivent appliquer les mêmes normes de sécurité rigoureuses qu'à tout autre service non autorisé. Il s'agit notamment de restreindre les interactions entre les données, de limiter l'accès et de mettre en œuvre une surveillance solide pour éviter que les informations sensibles ne soient exposées aux risques inhérents associés à toute plateforme externe non gérée, quelle que soit l'innovation ou l'utilité qu'elle puisse paraître.

Nous devons absolument étendre nos règles actuelles de protection des données aux applications d'IA, et idéalement, nous avons besoin d'un ensemble de règles qui fonctionnent pour tout - les applications approuvées, les applications non approuvées, et même nos propres applications internes.

En tant que praticien de la sécurité, une fois que vous avez identifié les risques associés à un service/une entité donné(e), vous devriez en fin de compte vous poser trois questions :

- Certains de nos utilisateurs ont-ils consulté/utilisé ce site ? Si oui, combien ? Et qui exactement ?

- Une partie de notre infrastructure web et en nuage a-t-elle accédé à ce service ?

- Si vous répondez "oui" à l'une des deux premières questions, quelle quantité de données a été échangée entre votre organisation et ce service ?

Utilisez Skyhigh Security?

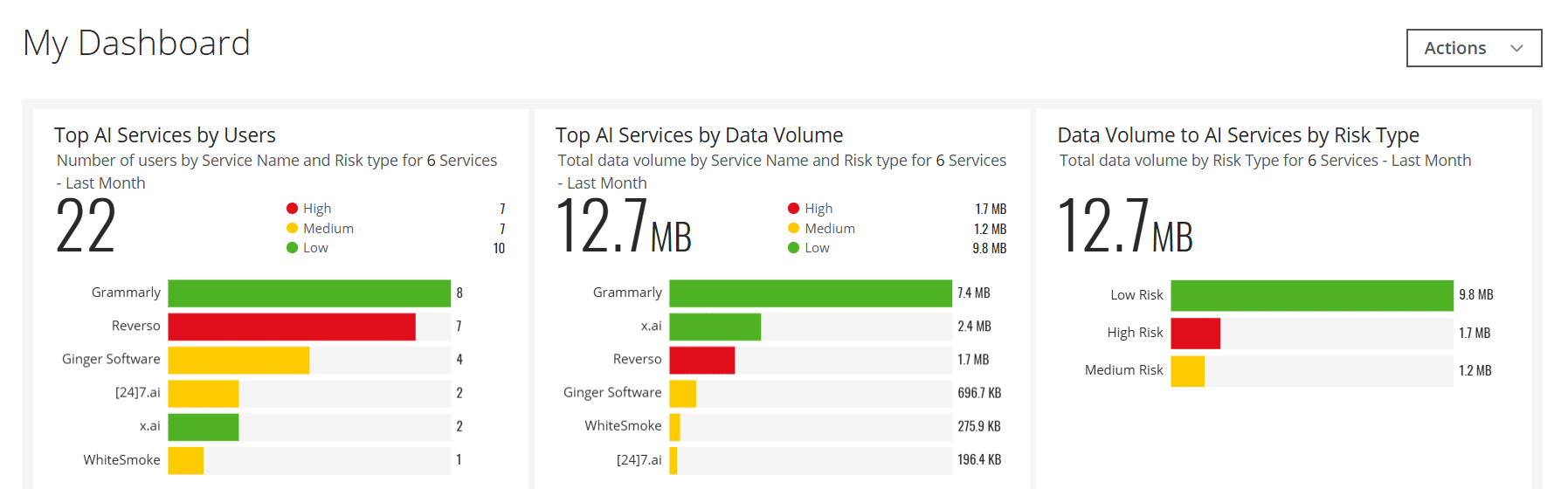

- Créez des tableaux de bord interactifs pour les services d'IA pour aider vos équipes de sécurité à avoir une visibilité importante et en temps réel.

- Détecter et bloquer les transferts de données utilisateur vers des services d'IA comme ChatGPT et bien d'autres, à l'aide de politiques intégrées.

- Automatiser les services web et cloud d'IA à risque pour qu'ils soient intégrés dans des groupes de services personnalisés sur la base d'attributs de risque personnalisés, plutôt que sur la base d'une méthode de base Catégorie = IA

- Gérer les services d'IA utilisés dans des scénarios sur site via votre Secure Web Gateway dédiée sur site

- Exploitez les capacités de l'intelligence artificielle pour répondre à une variété de cas d'utilisation liés à la détection des menaces, à la gestion des données, à la détection des faux positifs, etc.

- Obtenez des informations plus approfondies sur les risques liés à l'IA et le contenu généré en capturant les détails du modèle de langage large (LLM) pour les catégories d'IA

Avec plus de 11 ans d'expérience dans le secteur de la cybersécurité, Rodman Ramezanian est conseiller en sécurité Cloud pour les entreprises, responsable du conseil technique, de l'habilitation, de la conception de solutions et de l'architecture à l'adresse Skyhigh Security. Dans ce rôle, Rodman se concentre principalement sur le gouvernement fédéral australien, la défense et les organisations d'entreprise.

Rodman est spécialisé dans les domaines du renseignement sur les menaces adverses, de la cybercriminalité, de la protection des données et de la sécurité du cloud. Il est un évaluateur du PARI approuvé par l'Australian Signals Directorate (ASD) et détient actuellement les certifications CISSP, CCSP, CISA, CDPSE, Microsoft Azure et MITRE ATT&CK CTI.

En toute sincérité, M. Rodman a une grande passion pour la formulation de sujets complexes en termes simples, afin d'aider le commun des mortels et les nouveaux professionnels de la sécurité à comprendre le quoi, le pourquoi et le comment de la cybersécurité.

Points forts de l'attaque

- Un pirate informatique affirme s'être introduit dans OmniGPT, un service populaire de chatbot alimenté par l'IA, et avoir mis en vente les données volées sur le dark web.

- Les données volées comprennent plus de 30 000 adresses électroniques d'utilisateurs, des numéros de téléphone, des clés API et d'autres informations sensibles.

- Cette violation met en évidence les failles de sécurité des plateformes d'IA, notamment en ce qui concerne le traitement et la protection des données des utilisateurs.

- Le pirate aurait également obtenu des informations de facturation et des justificatifs d'identité, exposant ainsi les utilisateurs à un risque accru d'usurpation d'identité et de fraude.

- Cette violation soulève des inquiétudes quant à la sécurité des services d'intelligence artificielle basés sur l'informatique en nuage et à leur capacité à protéger la vie privée des utilisateurs.

- OmniGPT n'a pas encore confirmé la violation ni commenté les détails, mais l'incident a attiré l'attention des experts en cybersécurité.