Recursos

INTELLIGENCE DIGEST

Bot reventado: la supuesta filtración de datos de AI ChatBot

Los informes sobre filtraciones de datos de un popular chatbot impulsado por IA amenazan

Por Rodman Ramezanian - Asesor de seguridad de la nube empresarial

24 de febrero de 2025 7 Minute Read

Los chatbots impulsados por IA se han integrado perfectamente en casi todos los aspectos de nuestras vidas, desde responder preguntas y ayudar en la atención al cliente hasta gestionar tareas personales y realizar transacciones. Con su capacidad para proporcionar interacciones instantáneas y personalizadas, compartimos libremente datos sensibles, a menudo sin pensarlo dos veces. Sin embargo, cuando un servicio de chatbot experimenta una filtración de datos, no sólo compromete la privacidad individual, sino que golpea la propia confianza que los usuarios han depositado en estas tecnologías. El enorme volumen de datos personales, financieros y conversacionales que se intercambian con estos sistemas de IA significa que una filtración podría tener consecuencias de gran alcance, afectando a todo, desde la seguridad personal hasta la fiabilidad de los servicios de IA en los que hemos llegado a confiar.

Al parecer, un pirata informático ha afirmado haberse infiltrado en OmniGPT, una plataforma de productividad y chatbot de inteligencia artificial muy utilizada, según la información publicada en los conocidos Breach Forums. La brecha supuestamente expuso los datos personales de 30.000 usuarios, incluidos correos electrónicos, números de teléfono y más de 34 millones de líneas de registros de conversaciones. Además de los chats de los usuarios, los datos expuestos también incluyen enlaces a archivos cargados, algunos de los cuales contienen información sensible como credenciales, detalles de facturación y claves API.

A decir verdad, es difícil no alarmarse al menos un poco cuando un servicio de chatbot de IA se enfrenta a una filtración de datos, sobre todo teniendo en cuenta lo rápido que se ha disparado la popularidad de estas herramientas. Confiamos en ellos para una serie de capacidades, desde la escritura creativa y la lluvia de ideas hasta la investigación e incluso la automatización empresarial.

¿Por qué se producen estos incidentes?

La accesibilidad y la comodidad de los chatbots y los servicios de creatividad impulsados por IA los han convertido en una parte integral de nuestra vida cotidiana, pero lo más preocupante en este caso es que la brecha se produjo en el back-end del servicio. Esto significa que está totalmente fuera de cualquier cosa que los usuarios o consumidores pudieran haber hecho para evitarlo.

Existe una tendencia común a tratar a los chatbots de IA como un repositorio casual de toda y cualquier información. En realidad, sin embargo, estas plataformas funcionan como "cajas negras", en las que el usuario no tiene prácticamente ninguna idea de cómo se manejan, almacenan o protegen sus datos. Esta desconexión entre percepción y realidad puede tener consecuencias devastadoras cuando se filtran datos sensibles, como documentos cargados, claves API y detalles personales, como se ha visto en este caso.

Igualmente importante es la formación continua de los usuarios en materia de concienciación sobre la seguridad. Es posible que muchas personas aún no sean plenamente conscientes de los riesgos asociados a la introducción de información confidencial en los servicios de chatbot de IA o en las plataformas en la nube. Educar a los usuarios sobre el posible uso indebido de los datos y hacer hincapié en la precaución a la hora de compartir datos personales o confidenciales puede contribuir en gran medida a reducir la exposición.

El atractivo de los potentes servicios, a menudo gratuitos, enriquecidos con IA no hará más que crecer, haciendo cada vez más inútil un enfoque tradicional de la seguridad del tipo "whack-a-mole". Con cientos (si no, miles) de nuevos servicios de IA que surgen semanalmente, los equipos de ciberseguridad ya están desbordados y no pueden seguir el ritmo.

"Últimamente hemos tenido mucho tiempo libre" - ¡no lo ha dicho ningún equipo de ciberseguridad, nunca!

En lugar de perseguir todas y cada una de las herramientas de IA, la atención debe centrarse en los riesgos subyacentes. Esto significa dar prioridad a la protección de los datos sensibles, independientemente del servicio con el que se compartan. Tanto si se trata de una plataforma de IA aparentemente legítima como de cualquier otro recurso informático en la sombra, limitar las interacciones de los datos y aplicar medidas de seguridad sólidas resultará mucho más eficaz que tratar de vigilar un panorama cada vez más amplio de herramientas de IA. Como demuestran los recientes acontecimientos, incluso los servicios de apariencia robusta pueden convertirse en objetivos de sofisticados actores de amenazas.

¿Qué se puede hacer?

La IA es innegablemente revolucionaria y está transformando las industrias y la vida cotidiana de innumerables maneras. Sin embargo, desde un punto de vista puramente técnico, los servicios de IA, en particular aquellos a los que se accede a través de la web y la nube, son fundamentalmente sólo sitios web o plataformas en la nube. Aunque su tecnología subyacente es notablemente potente e innovadora, desde el punto de vista de la ciberseguridad, representan otra vía potencial para la fuga de datos y el acceso no autorizado. Para los profesionales de la seguridad encargados de proteger los datos sensibles de la organización, como los registros de los ciudadanos, la información de identificación personal y el código fuente, los servicios de IA deben verse a través de la lente de la TI en la sombra.

Y aunque la IA impulsa la eficiencia y la innovación, también plantea retos como las violaciones de datos, las infracciones de la normativa y el uso de la IA en la sombra. La rápida adopción de la IA a menudo supera a la gobernanza, dejando a las organizaciones vulnerables a riesgos de reputación, financieros y legales sin las medidas de seguridad adecuadas.

La TI en la sombra, por definición, engloba cualquier servicio no sancionado o autorizado explícitamente para el uso corporativo y las transacciones de datos. Al considerar los servicios de IA como TI en la sombra, los riesgos asociados quedan claros. ¿Permitiría que se introdujeran datos confidenciales de clientes en un sitio web no aprobado? ¿Permitiría que se subieran archivos adjuntos confidenciales a un servicio en la nube desconocido? ¿Aprobaría que los empleados utilizaran plataformas alojadas en jurisdicciones con prácticas de protección de datos cuestionables? La respuesta a todas estas preguntas debería ser un rotundo no.

Tratar los servicios de IA como TI en la sombra obliga a un necesario cambio de perspectiva. En lugar de dejarse deslumbrar por las capacidades de la tecnología, las organizaciones deben aplicar las mismas estrictas normas de seguridad que aplicarían a cualquier otro servicio no autorizado. Esto incluye restringir las interacciones de los datos, limitar el acceso e implementar una sólida supervisión para evitar que la información sensible quede expuesta a los riesgos inherentes asociados a cualquier plataforma externa no gestionada, independientemente de lo innovadora o útil que pueda parecer.

Necesitamos absolutamente ampliar nuestras normas actuales de protección de datos para cubrir las aplicaciones de IA, e idealmente, necesitamos un conjunto de normas que funcione para todo: aplicaciones aprobadas, aplicaciones no aprobadas, incluso nuestras propias aplicaciones internas.

Como profesional de la seguridad, una vez que haya identificado los riesgos asociados de un determinado servicio/entidad, en última instancia querrá hacerse tres preguntas:

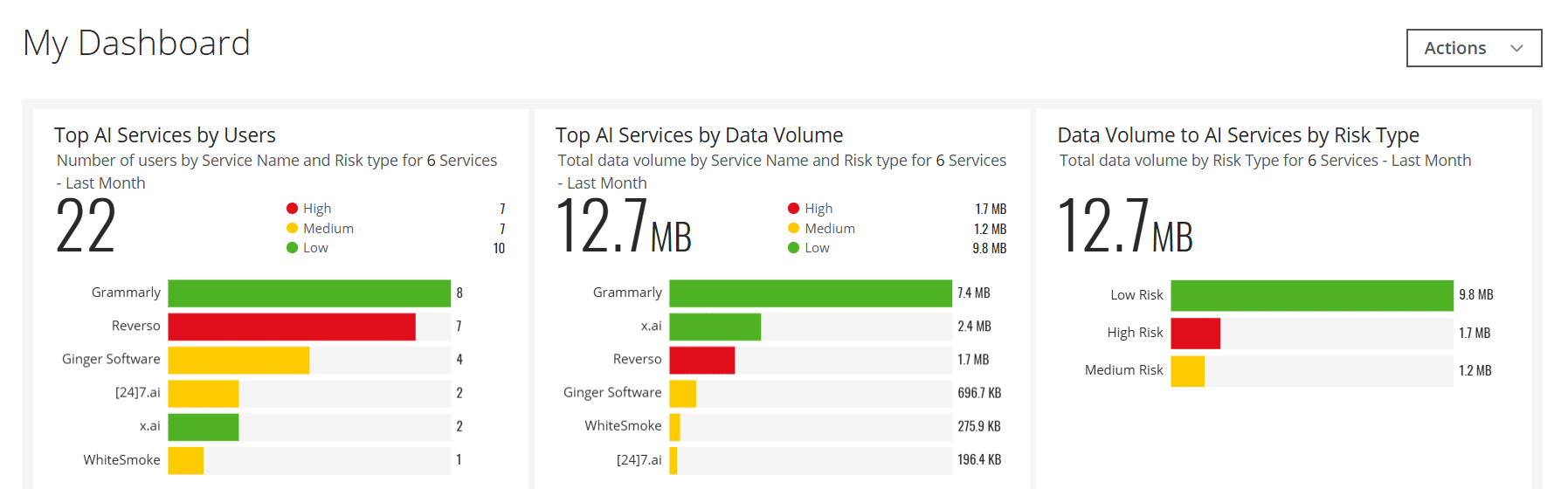

- ¿Alguno de nuestros usuarios ha navegado/utilizado esto? En caso afirmativo, ¿cuántos? ¿Y quién exactamente?

- ¿Alguna parte de nuestra infraestructura web y en la nube ha accedido a este servicio?

- Y si alguna de las dos primeras preguntas da como resultado un "sí", ¿cuántos datos se han transmitido entre su organización y ese servicio?

Utilice Skyhigh Security?

- Cree tarjetas de control interactivas para los servicios de IA para ayudar a sus equipos de seguridad con una visibilidad importante y en tiempo real

- Detectar y bloquear las transferencias de datos de los usuarios a servicios de IA como ChatGPT y muchos otros utilizando políticas incorporadas

- Automatice los servicios web y en la nube de IA de riesgo para que se incluyan en Grupos de servicios personalizados basados en atributos de riesgo personalizados, en lugar de un método básico de Categoría = IA

- Gestione los servicios de IA utilizados en escenarios locales a través de su Secure Web Gateway local dedicado

- Aproveche las capacidades impulsadas por la Inteligencia Artificial para abordar una variedad de casos de uso relacionados con la detección de amenazas, la gestión de datos, la detección de falsos positivos, etc.

- Aplique conocimientos más profundos sobre los riesgos de la IA y los contenidos generados mediante la captura de detalles del modelo de lenguaje amplio (LLM) para las categorías de IA

Con más de 11 años de amplia experiencia en el sector de la ciberseguridad, Rodman Ramezanian es asesor de seguridad en la nube para empresas, responsable de asesoramiento técnico, habilitación, diseño de soluciones y arquitectura en Skyhigh Security. En este puesto, Rodman se centra principalmente en organizaciones del Gobierno Federal Australiano, Defensa y Empresas.

Rodman está especializado en las áreas de Inteligencia de Amenazas Adversarias, Ciberdelincuencia, Protección de Datos y Seguridad en la Nube. Es evaluador IRAP avalado por la Dirección Australiana de Señales (ASD). Actualmente posee las certificaciones CISSP, CCSP, CISA, CDPSE, Microsoft Azure y MITRE ATT&CK CTI.

Con franqueza, Rodman siente una gran pasión por articular asuntos complejos en términos sencillos, ayudando al ciudadano de a pie y a los nuevos profesionales de la seguridad a entender el qué, el por qué y el cómo de la ciberseguridad.

Lo más destacado del ataque

- Un pirata informático afirma haber violado OmniGPT, un popular servicio de chatbot impulsado por IA, y puesto a la venta los datos robados en la web oscura.

- Los datos robados incluyen más de 30.000 direcciones de correo electrónico de usuarios, números de teléfono, claves API y otra información confidencial.

- La brecha pone de manifiesto las vulnerabilidades de seguridad de las plataformas de IA, especialmente en lo que respecta al manejo y la protección de los datos de los usuarios.

- Al parecer, el pirata informático también obtuvo información y credenciales de facturación, lo que expone a los usuarios a un mayor riesgo de robo de identidad y fraude.

- La brecha plantea preocupaciones sobre la seguridad de los servicios de IA basados en la nube y su capacidad para proteger la privacidad de los usuarios.

- OmniGPT aún no ha confirmado la brecha ni ha hecho comentarios sobre los detalles, pero el incidente ha atraído la atención de los expertos en ciberseguridad.