Ressourcen

NACHRICHTENÜBERSICHT

Bot hochgenommen: Angebliches Datenleck bei AI ChatBot

Berichte über Datenlecks bei einem beliebten KI-gesteuerten Chatbot bedrohen

Von Rodman Ramezanian - Berater für Cloud-Sicherheit für Unternehmen

Februar 24, 2025 7 Minuten gelesen

KI-gesteuerte Chatbots haben sich nahtlos in fast jeden Aspekt unseres Lebens integriert, von der Beantwortung von Fragen und der Unterstützung beim Kundenservice bis hin zur Verwaltung persönlicher Aufgaben und der Durchführung von Transaktionen. Dank ihrer Fähigkeit, sofortige, personalisierte Interaktionen zu ermöglichen, geben wir vertrauliche Daten frei heraus, oft ohne einen zweiten Gedanken. Wenn jedoch bei einem Chatbot-Dienst ein Datenleck auftritt, ist nicht nur die Privatsphäre des Einzelnen gefährdet, sondern auch das Vertrauen, das die Nutzer in diese Technologien gesetzt haben. Die schiere Menge an persönlichen, finanziellen und Gesprächsdaten, die mit diesen KI-Systemen ausgetauscht werden, bedeutet, dass ein Verstoß weitreichende Folgen haben könnte, die von der persönlichen Sicherheit bis hin zur Zuverlässigkeit der KI-Dienste reichen, auf die wir uns verlassen haben.

Ein Hacker hat Berichten zufolge behauptet, OmniGPT, eine weit verbreitete KI-Chatbot- und Produktivitätsplattform, infiltriert zu haben. Dies geht aus Informationen hervor, die in den berüchtigten Breach-Foren veröffentlicht wurden. Durch den Einbruch wurden angeblich die persönlichen Daten von 30.000 Nutzern offengelegt, darunter E-Mails, Telefonnummern und mehr als 34 Millionen Zeilen von Gesprächsprotokollen. Zusätzlich zu den Benutzer-Chats enthalten die aufgedeckten Daten auch Links zu hochgeladenen Dateien, von denen einige sensible Informationen wie Anmeldedaten, Rechnungsdetails und API-Schlüssel enthalten.

Um ehrlich zu sein, ist es schwer, nicht zumindest ein wenig beunruhigt zu sein, wenn ein KI-Chatbot-Dienst von einem Datenleck betroffen ist, vor allem, wenn man bedenkt, wie schnell diese Tools an Popularität gewonnen haben. Wir verlassen uns bei einer Reihe von Aufgaben auf sie - von kreativem Schreiben und Brainstorming bis hin zu Recherche und sogar Geschäftsautomatisierung.

Wie kommt es zu diesen Vorfällen?

Die Zugänglichkeit und die Bequemlichkeit von KI-gesteuerten Chatbots und Kreativitätsdiensten haben sie zu einem festen Bestandteil unseres Alltags gemacht, aber am besorgniserregendsten ist, dass der Einbruch im Backend des Dienstes stattfand. Das bedeutet, dass die Benutzer oder Verbraucher nichts hätten tun können, um dies zu verhindern.

Es gibt eine weit verbreitete Tendenz, KI-Chatbots als zwanglosen Aufbewahrungsort für alle Informationen zu betrachten. In Wirklichkeit arbeiten diese Plattformen jedoch als "Blackboxen", bei denen der Benutzer praktisch keinen Einblick in die Handhabung, Speicherung und den Schutz seiner Daten hat. Diese Diskrepanz zwischen Wahrnehmung und Realität kann verheerende Folgen haben, wenn sensible Daten wie hochgeladene Dokumente, API-Schlüssel und persönliche Details nach außen dringen, wie in diesem Fall geschehen.

Ebenso wichtig ist eine kontinuierliche Schulung des Sicherheitsbewusstseins der Nutzer. Viele Menschen sind sich der Risiken, die mit der Eingabe sensibler Daten in KI-Chatbot-Dienste oder Cloud-Plattformen verbunden sind, möglicherweise immer noch nicht ganz bewusst. Die Aufklärung der Nutzer über den möglichen Datenmissbrauch und die Betonung der Vorsicht bei der Weitergabe persönlicher oder vertraulicher Daten kann viel dazu beitragen, das Risiko zu verringern.

Die Verlockung leistungsfähiger, oft kostenloser, mit KI angereicherter Dienste wird weiter zunehmen, so dass ein traditioneller "Whack-a-Mole"-Ansatz für die Sicherheit immer aussichtsloser wird. Angesichts hunderter (wenn nicht tausender) neuer KI-Dienste, die wöchentlich auf den Markt kommen, sind die Cybersecurity-Teams bereits jetzt überfordert und können unmöglich Schritt halten.

"Wir hatten in letzter Zeit so viel Freizeit" - das hat kein Cybersecurity-Team jemals gesagt!

Anstatt jedem einzelnen KI-Tool hinterherzulaufen, muss der Fokus auf die zugrunde liegenden Risiken gelegt werden. Das bedeutet, dass der Schutz sensibler Daten Vorrang haben muss, unabhängig von dem Dienst, mit dem sie geteilt werden. Unabhängig davon, ob es sich um eine scheinbar legitime KI-Plattform oder eine andere Schatten-IT-Ressource handelt, erweisen sich die Begrenzung der Dateninteraktionen und die Implementierung robuster Sicherheitsmaßnahmen als weitaus effektiver als der Versuch, eine immer größer werdende Landschaft von KI-Tools zu überwachen. Wie die jüngsten Ereignisse zeigen, können selbst robust aussehende Dienste zur Zielscheibe für raffinierte Bedrohungsakteure werden.

Was kann man tun?

KI ist unbestreitbar revolutionär und verändert die Industrie und das tägliche Leben auf unzählige Arten. Aus rein technischer Sicht sind KI-Dienste, insbesondere solche, auf die über das Internet und die Cloud zugegriffen wird, jedoch im Grunde nur Websites oder Cloud-Plattformen. Die ihnen zugrunde liegende Technologie ist zwar bemerkenswert leistungsfähig und innovativ, aber aus Sicht der Cybersicherheit stellen sie eine weitere potenzielle Möglichkeit für Datenlecks und unbefugten Zugriff dar. Für Sicherheitsexperten, die mit dem Schutz sensibler Unternehmensdaten wie Bürgerdaten, personenbezogene Daten und Quellcode betraut sind, müssen KI-Dienste durch die Brille der Schatten-IT betrachtet werden.

Und während KI Effizienz und Innovation vorantreibt, birgt sie auch Herausforderungen wie Datenschutzverletzungen, Compliance-Verstöße und die Nutzung von Schatten-KI. Die rasche Einführung von KI überholt oft die Governance, so dass Unternehmen ohne angemessene Sicherheitsmaßnahmen anfällig für Reputations-, finanzielle und rechtliche Risiken sind.

Schatten-IT umfasst per Definition jeden Dienst, der nicht ausdrücklich für die Nutzung im Unternehmen und für Datentransaktionen genehmigt oder autorisiert ist. Wenn Sie KI-Dienste als Schatten-IT betrachten, werden die damit verbundenen Risiken deutlich. Würden Sie zulassen, dass sensible Kundendaten auf einer nicht genehmigten Website eingegeben werden? Würden Sie zulassen, dass vertrauliche Anhänge auf einen unbekannten Cloud-Dienst hochgeladen werden? Würden Sie dulden, dass Mitarbeiter Plattformen nutzen, die in Ländern mit fragwürdigen Datenschutzpraktiken gehostet werden? Die Antwort auf all diese Fragen sollte ein klares Nein sein.

Die Behandlung von KI-Diensten als Schatten-IT erzwingt einen notwendigen Perspektivenwechsel. Anstatt sich von den Fähigkeiten der Technologie blenden zu lassen, müssen Unternehmen dieselben strengen Sicherheitsstandards anwenden, die sie auch bei jedem anderen nicht autorisierten Dienst anwenden würden. Dazu gehören die Einschränkung von Dateninteraktionen, die Begrenzung des Zugriffs und die Implementierung einer robusten Überwachung, um zu verhindern, dass sensible Informationen den inhärenten Risiken ausgesetzt werden, die mit jeder nicht verwalteten, externen Plattform verbunden sind, unabhängig davon, wie innovativ oder hilfreich sie auch erscheinen mag.

Wir müssen unsere derzeitigen Datenschutzregeln unbedingt auf KI-Apps ausdehnen, und idealerweise brauchen wir ein Regelwerk, das für alles gilt - für zugelassene Apps, nicht zugelassene Apps und sogar für unsere eigenen internen Apps.

Wenn Sie als Sicherheitsexperte die mit einem bestimmten Dienst/einer bestimmten Einrichtung verbundenen Risiken identifiziert haben, sollten Sie sich letztlich drei Fragen stellen:

- Hat einer unserer Benutzer diese Seite aufgerufen/genutzt? Wenn ja, wie viele? Und wer genau?

- Hat ein Teil unserer Web- und Cloud-Infrastruktur auf diesen Dienst zugegriffen?

- Und wenn eine der ersten beiden Fragen mit "Ja" beantwortet wird, wie viele Daten wurden zwischen Ihrem Unternehmen und diesem Dienst ausgetauscht?

Verwenden Sie Skyhigh Security?

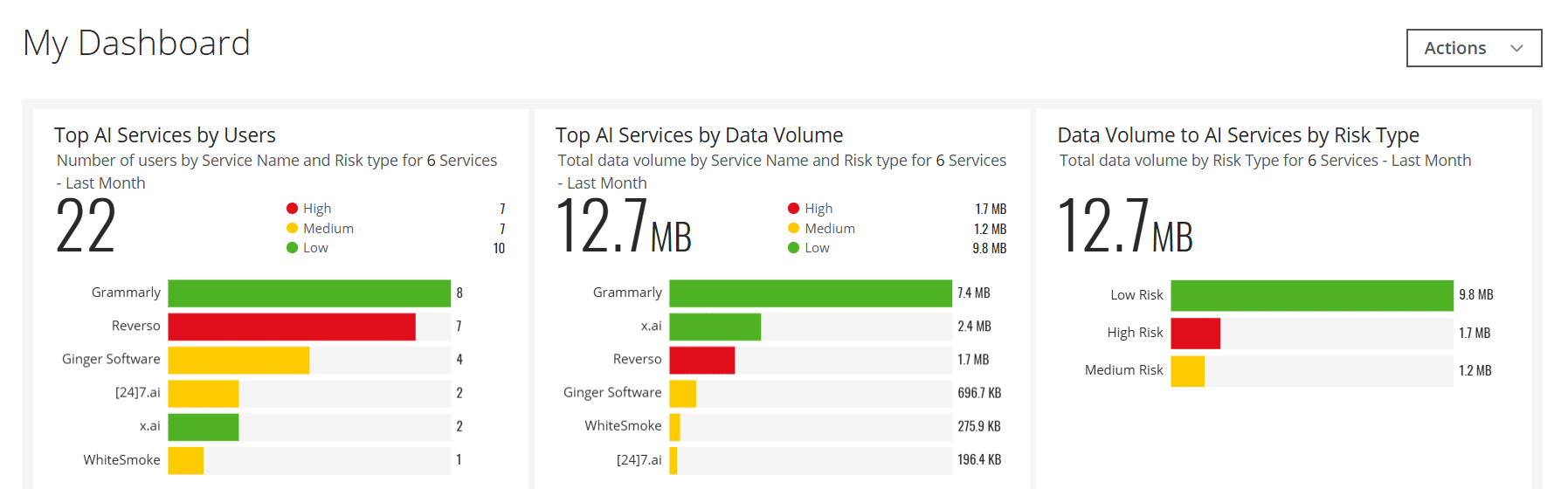

- Erstellen Sie interaktive Dashboard-Karten für KI-Dienste zur Unterstützung Ihrer Sicherheitsteams mit wichtigen Echtzeitinformationen

- Erkennen und blockieren Sie die Übertragung von Benutzerdaten an KI-Dienste wie ChatGPT und viele andere mithilfe integrierter Richtlinien

- Automatisieren Sie risikobehaftete KI-Web- und Cloud-Dienste, die in benutzerdefinierte Servicegruppen eingeordnet werden. basierend auf benutzerdefinierten Risikoattributen, anstatt einer einfachen Kategorie = AI-Methode

- Verwalten Sie AI-Dienste, die in On-Premise-Szenarien verwendet werden über Ihr spezielles Secure Web Gateway vor Ort

- Nutzen Sie die Möglichkeiten der Künstlichen Intelligenz um eine Vielzahl von Anwendungsfällen im Zusammenhang mit der Erkennung von Bedrohungen, der Datenverwaltung, der Erkennung von Fehlalarmen und mehr zu lösen

- Gewinnen Sie tiefere Einblicke in KI-Risiken und generierte Inhalte durch die Erfassung von Details des Large Language Model (LLM) für KI-Kategorien

Rodman Ramezanian verfügt über mehr als 11 Jahre Erfahrung in der Cybersicherheitsbranche und ist als Enterprise Cloud Security Advisor verantwortlich für technische Beratung, Enablement, Lösungsdesign und Architektur bei Skyhigh Security. In dieser Funktion konzentriert sich Rodman Ramezanian hauptsächlich auf die australische Bundesregierung, das Verteidigungsministerium und Unternehmen.

Rodman ist spezialisiert auf die Bereiche Adversarial Threat Intelligence, Cyberkriminalität, Datenschutz und Cloud-Sicherheit. Er ist ein vom Australian Signals Directorate (ASD) anerkannter IRAP-Assessor und besitzt derzeit die Zertifizierungen CISSP, CCSP, CISA, CDPSE, Microsoft Azure und MITRE ATT&CK CTI.

Rodman hat eine ausgeprägte Leidenschaft dafür, komplexe Sachverhalte in einfachen Worten zu formulieren und so dem Durchschnittsbürger und neuen Sicherheitsexperten zu helfen, das Was, Warum und Wie der Cybersicherheit zu verstehen.

Höhepunkte des Angriffs

- Ein Hacker behauptet, in OmniGPT, einen beliebten KI-gesteuerten Chatbot-Dienst, eingedrungen zu sein und die gestohlenen Daten im Dark Web zum Verkauf angeboten zu haben.

- Zu den gestohlenen Daten gehören über 30.000 E-Mail-Adressen von Benutzern, Telefonnummern, API-Schlüssel und andere sensible Informationen.

- Der Verstoß wirft ein Schlaglicht auf die Sicherheitslücken in KI-Plattformen, insbesondere im Hinblick auf den Umgang mit und den Schutz von Nutzerdaten.

- Der Hacker erlangte angeblich auch Rechnungsdaten und Zugangsdaten, wodurch die Benutzer einem größeren Risiko von Identitätsdiebstahl und Betrug ausgesetzt waren.

- Die Sicherheitsverletzung gibt Anlass zur Sorge über die Sicherheit von Cloud-basierten KI-Diensten und deren Fähigkeit, die Privatsphäre der Nutzer zu schützen.

- OmniGPT hat den Einbruch noch nicht bestätigt oder sich zu den Details geäußert, aber der Vorfall hat die Aufmerksamkeit von Cybersicherheitsexperten auf sich gezogen.